RAG based Intelligent Conversational AI Agent for Knowledge Extraction Using LangChain Gemini LLM

1.0.0

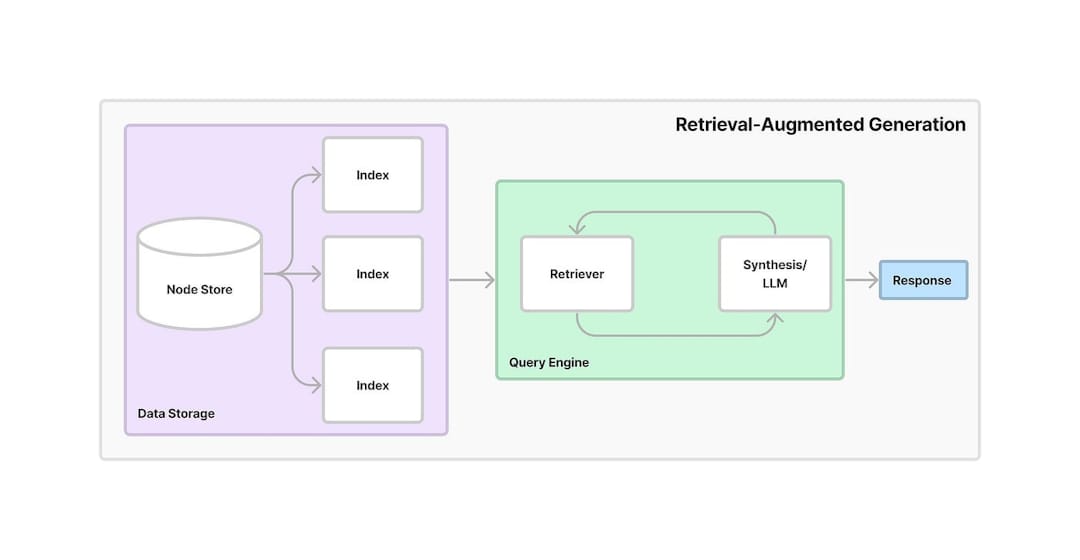

検索された生成(RAG)は、情報検索と生成AIを組み合わせたフレームワークです。モデルは、外部ソースまたはデータベースから関連情報を取得し、そのデータを使用してより正確でコンテキストに関連する応答を生成することができます。検索と生成の両方を活用することにより、RAGはAIモデルの精度と信頼性を改善し、特に最新の情報を提供したり、複雑な質問を処理したりします。

このプロジェクトは、PDFドキュメントから知識を抽出するために検索された生成(RAG)を活用するAIベースの会話アシスタントを提供します。このシステムは、テキストの埋め込み、ベクトル検索、およびLLMを組み合わせて、ユーザーの質問への回答を提供します。以下は、アプリケーションの動作方法の詳細な段階的なワークフローです。

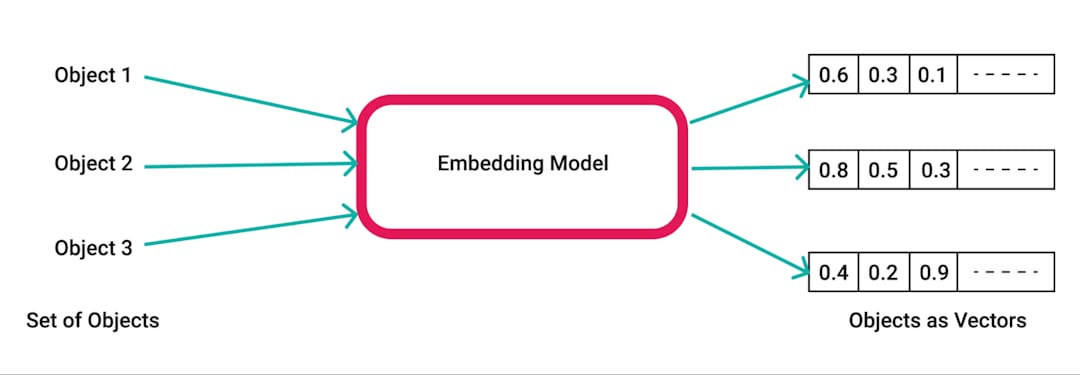

pdfplumberを使用してテキストを抽出するように処理されます。PDFSからテキストを抽出するためのPythonライブラリです。pdfplumberライブラリを使用して、アップロードされたPDFから生のテキストを抽出します。ドキュメントの各ページは解析され、結果のテキストはさらに処理するために準備されています。RecursiveCharacterTextSplitterを使用して小さなチャンクに分割されます。これにより、コンテンツは埋め込みと検索に対応し、通常は500文字のチャンクサイズと50文字のオーバーラップで管理できます。SpacyEmbeddingsを使用して数値埋め込みに変換されます。これらの埋め込みは、チャンクの意味的な意味を表し、効率的な検索を可能にします。

Chromaライブラリを使用して作成されます。ベクトルデータベースにより、ユーザークエリに基づいて関連情報を高速かつ効率的に取得できます。ConversationalRetrievalChainは、 LangChainを使用して確立され、Chromaに保存されている埋め込みと会話のメモリバッファーを組み合わせて、チャットの履歴とコンテキストを追跡します。ChatGoogleGenerativeAI (GoogleのGemini LLM)を統合して、Vectorストアから取得したテキストの塊に基づいて、ユーザーの質問に関連するインテリジェントな応答を生成します。

効率的な知識検索:RAGの力を活用することにより、システムは検索と生成を組み合わせて、アップロードされたPDFドキュメントの内容に基づいて特定の質問に正確に回答します。

スケーラビリティと柔軟性:テキストチャンキングと埋め込みにより、アプリは高速かつ正確な情報検索を保証しながら、大きなドキュメントを処理できます。

会話AI :会話履歴メモリは、以前の質問と回答を追跡し、長い会話を維持するため、システムをよりインタラクティブにします。

最新のAIツールの統合:このプロジェクトは、ベクターストレージのためのChroma 、会話管理のためのLangChain 、GoogleのGemini LLMなど、人間のような回答を生成するためのGoogleのGemini LLMの使用を示しています。