ทีม Qwen ของ Alibaba เพิ่งเปิดตัวสมาชิกในครอบครัวรุ่นโอเพ่นซอร์ส Language Language Language ล่าสุด (LLM) ล่าสุด - QWQ -32B รูปแบบการอนุมานนี้ที่มีพารามิเตอร์ 32 พันล้านช่วยปรับปรุงประสิทธิภาพในงานการแก้ปัญหาที่ซับซ้อนอย่างมีนัยสำคัญผ่านเทคโนโลยีการเรียนรู้เสริมแรง (RL) การเปิดตัว QWQ-32B เป็นเครื่องหมายของความก้าวหน้าของอาลีบาบาในด้านปัญญาประดิษฐ์โดยเฉพาะอย่างยิ่งในการใช้งานและการเพิ่มประสิทธิภาพของแบบจำลองการอนุมาน

QWQ-32B เปิดให้บริการภายใต้ใบอนุญาต Apache 2.0 บนแพลตฟอร์ม Hugging Face และ ModelsCope ซึ่งหมายความว่าไม่เพียง แต่สำหรับการวิจัย แต่ยังเพื่อวัตถุประสงค์ทางการค้า ธุรกิจสามารถรวมโมเดลเข้ากับผลิตภัณฑ์หรือบริการโดยตรงรวมถึงแอปพลิเคชันที่ชำระเงิน นอกจากนี้ผู้ใช้แต่ละคนยังสามารถเข้าถึงโมเดลผ่านการแชท Qwen และเพลิดเพลินไปกับความสามารถในการอนุมานที่ทรงพลัง

QWQ ชื่อเต็ม Qwen-With-Questions เป็นรูปแบบการให้เหตุผลแบบโอเพ่นซอร์สเปิดตัวครั้งแรกโดย Alibaba ในเดือนพฤศจิกายน 2567 โดยมีจุดประสงค์เพื่อแข่งขันกับ O1AI ของ OPEAI แบบจำลองนี้ช่วยเพิ่มการใช้เหตุผลเชิงตรรกะและทักษะการวางแผนอย่างมีนัยสำคัญโดยการตรวจสอบตนเองและปรับปรุงคำตอบในระหว่างกระบวนการให้เหตุผลโดยเฉพาะอย่างยิ่งในงานคณิตศาสตร์และการเข้ารหัส การเปิดตัว QWQ-32B จะรวมตำแหน่งผู้นำของอาลีบาบาในสาขานี้

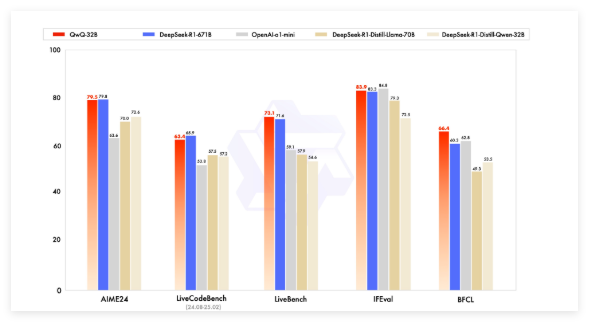

แบบจำลอง QWQ ในช่วงต้นได้ผ่านการตรวจสอบ O1-Preview ของ OpenAI ในเกณฑ์มาตรฐานทางคณิตศาสตร์เช่น AIME และคณิตศาสตร์และงานการใช้เหตุผลทางวิทยาศาสตร์เช่น GPQA อย่างไรก็ตามในเกณฑ์มาตรฐานการเขียนโปรแกรม (เช่น LiveCodeBench) ประสิทธิภาพของมันค่อนข้างอ่อนแอและมีปัญหาเช่นการผสมภาษาและการโต้แย้งแบบวนซ้ำ อย่างไรก็ตามอาลีบาบาเลือกที่จะปล่อยโมเดลภายใต้ใบอนุญาต Apache 2.0 แยกแยะได้จากโซลูชั่นที่เป็นกรรมสิทธิ์ของ Openai ช่วยให้นักพัฒนาและธุรกิจสามารถปรับตัวและทำการค้าได้อย่างอิสระ

ด้วยการพัฒนาสาขาปัญญาประดิษฐ์ข้อ จำกัด ของ LLM แบบดั้งเดิมได้ค่อยๆเกิดขึ้นและการปรับปรุงประสิทธิภาพที่เกิดจากการขยายตัวขนาดใหญ่ก็เริ่มช้าลง สิ่งนี้ทำให้เกิดความสนใจในแบบจำลองการอนุมานขนาดใหญ่ (LRM) ซึ่งปรับปรุงความแม่นยำผ่านการใช้เหตุผลการอนุมานและการสะท้อนตนเอง QWQ-32B ปรับปรุงประสิทธิภาพการทำงานต่อไปโดยการรวมการเรียนรู้การเสริมแรงและการตั้งคำถามด้วยตนเองที่มีโครงสร้างและกลายเป็นคู่แข่งที่สำคัญในด้านการให้เหตุผล AI

QWQ-32B แข่งขันกับโมเดลชั้นนำเช่น Deepseek-R1 และ O1-MINI ในการทดสอบมาตรฐานและบรรลุผลการแข่งขันเมื่อปริมาณพารามิเตอร์มีขนาดเล็กกว่าคู่แข่งบางราย ตัวอย่างเช่น Deepseek-R1 มีพารามิเตอร์ 671 พันล้านพารามิเตอร์ในขณะที่ QWQ-32B มีข้อกำหนดของหน่วยความจำที่เล็กกว่าเมื่อประสิทธิภาพของมันเทียบเคียงได้โดยปกติจะต้องใช้ VRAM 24GB ใน GPU ในขณะที่ใช้ R1 Deepseek เต็มรูปแบบต้องการ VRAM มากกว่า 1,500GB

QWQ-32B ใช้สถาปัตยกรรมแบบจำลองภาษาเชิงสาเหตุและได้ดำเนินการเพิ่มประสิทธิภาพหลายครั้งรวมถึงชั้นหม้อแปลง 64 ชั้น, เชือก, Swiglu, RMSNORM และ Attention QKV BIAS นอกจากนี้ยังใช้ความสนใจแบบสอบถามทั่วไป (GQA) มีความยาวบริบทที่ยาวนานถึง 131,072 โทเค็นและผ่านการฝึกอบรมหลายขั้นตอนรวมถึงการฝึกอบรมก่อนการปรับแต่งการปรับแต่งและการเรียนรู้เสริมแรง

กระบวนการเรียนรู้การเสริมแรงของ QWQ-32B แบ่งออกเป็นสองขั้นตอน: ขั้นตอนแรกมุ่งเน้นไปที่ความสามารถทางคณิตศาสตร์และการเข้ารหัสและใช้ตัวตรวจสอบความถูกต้องอย่างแม่นยำและเซิร์ฟเวอร์การดำเนินการรหัสสำหรับการฝึกอบรม ขั้นตอนที่สองคือการฝึกอบรมรางวัลผ่านรูปแบบรางวัลทั่วไปและตัวตรวจสอบความถูกต้องตามกฎเพื่อปรับปรุงการเรียนการสอนต่อไปนี้การจัดตำแหน่งของมนุษย์และความสามารถในการใช้เหตุผลพร็อกซีในขณะที่ไม่ส่งผลกระทบต่อความสามารถทางคณิตศาสตร์และการเข้ารหัส

นอกจากนี้ QWQ-32B ยังมีความสามารถของตัวแทนซึ่งสามารถปรับกระบวนการอนุมานแบบไดนามิกตามข้อเสนอแนะด้านสิ่งแวดล้อม ทีม Qwen แนะนำให้ใช้การตั้งค่าการอนุมานเฉพาะเพื่อประสิทธิภาพที่ดีที่สุดและรองรับการปรับใช้โดยใช้ VLLM

ทีม Qwen ถือว่า QWQ-32B เป็นขั้นตอนแรกในการเพิ่มขีดความสามารถในการใช้เหตุผลผ่านการเรียนรู้การเสริมแรงแบบขยาย ในอนาคตมันวางแผนที่จะสำรวจการขยายการเรียนรู้การเสริมแรงเพิ่มการบูรณาการตัวแทนและการเรียนรู้การเสริมแรงเพื่อให้ได้การใช้เหตุผลระยะยาวและดำเนินการพัฒนาแบบจำลองพื้นฐานที่ได้รับการปรับให้เหมาะสมสำหรับการเรียนรู้การเสริมแรงและในที่สุดก็ย้ายไปสู่ปัญญาประดิษฐ์ทั่วไป (AGI)

รุ่น: https://qwenlm.github.io/blog/qwq-32b/