Tim Qwen Alibaba baru -baru ini merilis anggota keluarga Model Bahasa Besar (LLM) terbaru - QWQ -32B. Model inferensi ini dengan 32 miliar parameter secara signifikan meningkatkan kinerja dalam tugas pemecahan masalah yang kompleks melalui teknologi pembelajaran penguatan (RL). Peluncuran QWQ-32B menandai terobosan lebih lanjut Alibaba di bidang kecerdasan buatan, terutama dalam aplikasi dan optimalisasi model inferensi.

QWQ-32B bersumber terbuka di bawah lisensi Apache 2.0 pada platform wajah pemeluk dan model, yang berarti tidak hanya untuk penelitian tetapi juga untuk tujuan komersial. Bisnis dapat mengintegrasikan model langsung ke dalam produk atau layanan mereka, termasuk aplikasi berbayar. Selain itu, masing -masing pengguna juga dapat mengakses model melalui obrolan Qwen dan menikmati kemampuan inferensi mereka yang kuat.

QWQ, nama lengkap QWEN-dengan-pertanyaan, adalah model penalaran open source yang pertama kali diluncurkan oleh Alibaba pada November 2024, yang bertujuan untuk bersaing dengan preview O1 Openai. Model ini secara signifikan meningkatkan penalaran logis dan keterampilan perencanaan dengan meninjau diri dan meningkatkan jawaban selama proses penalaran, terutama dalam tugas matematika dan pengkodean. Peluncuran QWQ-32B lebih lanjut mengkonsolidasikan posisi terkemuka Alibaba di bidang ini.

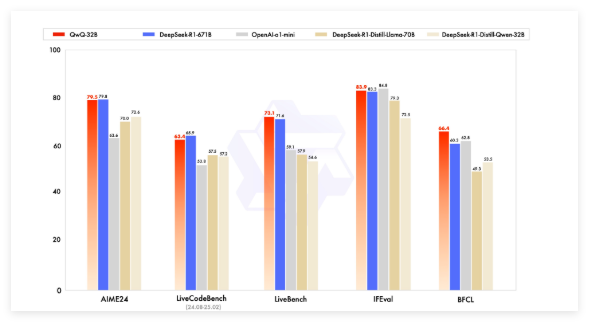

Model QWQ awal telah melampaui preview O1 Openai dalam tolok ukur matematika seperti AIME dan matematika dan tugas penalaran ilmiah seperti GPQA. Namun, dalam tolok ukur pemrograman (seperti LiveCodebench), kinerjanya relatif lemah dan ada masalah seperti pencampuran bahasa dan argumentasi loop. Namun demikian, Alibaba memilih untuk merilis model di bawah lisensi Apache 2.0, membedakannya dari solusi hak milik Openai, yang memungkinkan pengembang dan bisnis untuk beradaptasi dan dikomersialkan secara bebas.

Dengan pengembangan bidang kecerdasan buatan, keterbatasan LLM tradisional telah secara bertahap muncul, dan peningkatan kinerja yang ditimbulkan oleh ekspansi skala besar juga telah mulai melambat. Ini mendorong minat pada model inferensi besar (LRM), yang meningkatkan akurasi melalui penalaran waktu inferensi dan refleksi diri. QWQ-32B lebih lanjut meningkatkan kinerjanya dengan mengintegrasikan pembelajaran penguatan dan pertanyaan yang terstruktur dan menjadi pesaing penting di bidang penalaran AI.

QWQ-32B bersaing dengan model-model terkemuka seperti Deepseek-R1 dan O1-Mini dalam tes benchmark, dan mencapai hasil kompetitif ketika volume parameter lebih kecil dari beberapa pesaing. Sebagai contoh, Deepseek-R1 memiliki 671 miliar parameter, sedangkan QWQ-32B memiliki persyaratan memori yang lebih kecil ketika kinerjanya sebanding, biasanya hanya 24GB VRAM yang diperlukan pada GPU, sementara menjalankan R1 Deepseek penuh membutuhkan lebih dari 1500GB VRAM.

QWQ-32B mengadopsi arsitektur model bahasa kausal dan telah melakukan beberapa optimasi, termasuk 64 lapisan transformator, tali, swiglu, rmsnorm dan perhatian qKV bias. Ini juga menggunakan Generalized Query Attention (GQA), memiliki panjang konteks yang diperluas 131.072 token, dan menjalani pelatihan multi-tahap termasuk pra-pelatihan, penyesuaian yang diawasi, dan pembelajaran penguatan.

Proses pembelajaran penguatan QWQ-32B dibagi menjadi dua tahap: tahap pertama berfokus pada matematika dan kemampuan pengkodean, dan menggunakan validator akurasi dan server eksekusi kode untuk pelatihan; Tahap kedua adalah pelatihan hadiah melalui model hadiah umum dan validator berbasis aturan untuk meningkatkan pengikut instruksi, kemampuan penalaran manusia dan penalaran proxy, sementara tidak mempengaruhi kemampuan matematika dan pengkodeannya.

Selain itu, QWQ-32B juga memiliki kemampuan agen, yang secara dinamis dapat menyesuaikan proses inferensi berdasarkan umpan balik lingkungan. Tim QWEN merekomendasikan penggunaan pengaturan inferensi spesifik untuk kinerja optimal dan mendukung penyebaran menggunakan VLLM.

Tim QWEN menganggap QWQ-32B sebagai langkah pertama untuk meningkatkan kemampuan penalaran melalui pembelajaran penguatan yang diperluas. Di masa depan, ia berencana untuk mengeksplorasi lebih lanjut pembelajaran penguatan, mengintegrasikan agen dan pembelajaran penguatan untuk mencapai penalaran jangka panjang, dan terus mengembangkan model dasar yang dioptimalkan untuk pembelajaran penguatan, dan pada akhirnya bergerak menuju kecerdasan buatan umum (AGI).

Model: https://qwenlm.github.io/blog/qwq-32b/