Alibaba의 Qwen 팀은 최근 최신 오픈 소스 대형 언어 모델 (LLM) 가족 구성원 인 QWQ -32B를 발표했습니다. 320 억 파라미터를 가진이 추론 모델은 RL (Rencement Learning) 기술을 통해 복잡한 문제 해결 작업의 성능을 크게 향상시킵니다. QWQ-32B의 출시는 특히 인공 지능 분야, 특히 추론 모델의 적용 및 최적화에서 알리바바의 획기적인 획기적인 발전을 표시합니다.

QWQ-32B는 Hugging Face 및 ModelScope 플랫폼의 Apache 2.0 라이센스에 따라 공개적으로 공개됩니다. 즉, 연구뿐만 아니라 상업적 목적을위한 것입니다. 기업은 유료 응용 프로그램을 포함하여 모델을 제품이나 서비스에 직접 통합 할 수 있습니다. 또한 개별 사용자는 Qwen Chat을 통해 모델에 액세스하고 강력한 추론 기능을 즐길 수 있습니다.

QWQ는 Qwen-With-Questions 인 QWQ는 2024 년 11 월 Alibaba에서 처음 시작한 오픈 소스 추론 모델로 OpenAi의 O1- 프리뷰와 경쟁하기 위해 목표로합니다. 이 모델은 특히 수학 및 코딩 작업에서 추론 과정에서 답변을 자체 검토하고 개선하여 논리적 추론 및 계획 기술을 크게 향상시킵니다. QWQ-32B의 출시는이 분야에서 알리바바의 주요 위치를 더욱 강화시킵니다.

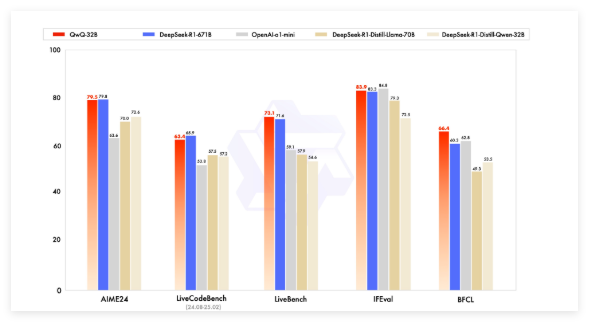

초기 QWQ 모델은 AIME 및 수학 및 GPQA와 같은 과학적 추론 작업과 같은 수학적 벤치 마크에서 OpenAI의 O1- 프리뷰를 능가했습니다. 그러나 프로그래밍 벤치 마크 (예 : LiveCodebench)에서는 성능이 상대적으로 약하며 언어 믹싱 및 루프 논증과 같은 문제가 있습니다. 그럼에도 불구하고 Alibaba는 Apache 2.0 라이센스에 따라 모델을 출시하기로 선택하여 OpenAI의 독점 솔루션과 구별되어 개발자와 비즈니스가 자유롭게 적응하고 상용화 할 수있었습니다.

인공 지능 분야의 발전으로 전통적인 LLM의 한계가 점차 등장했으며 대규모 확장으로 인한 성능 향상도 느려지기 시작했습니다. 이는 LRM (Large Inference Model)에 대한 관심을 유발하여 추론 시간 추론 및 자기 반성을 통해 정확도를 향상시킵니다. QWQ-32B는 강화 학습과 구조화 된 자체 질문을 통합하고 AI 추론 분야에서 중요한 경쟁자가되어 성과를 더욱 향상시킵니다.

QWQ-32B는 벤치 마크 테스트에서 DeepSeek-R1 및 O1-Mini와 같은 주요 모델과 경쟁했으며 일부 경쟁사보다 매개 변수 볼륨이 작을 때 경쟁 결과를 달성했습니다. 예를 들어, DeepSeek-R1은 6,710 억 매개 변수를 가지고있는 반면, QWQ-32B는 성능이 비슷할 때 더 작은 메모리 요구 사항을 가지고 있으며, 일반적으로 GPU에서 24GB의 VRAM 만 필요하지만 전체 DeepSeek R1을 실행하려면 1500GB 이상의 VRAM이 필요합니다.

QWQ-32B는 인과 관계 모델 아키텍처를 채택하며 64 개의 변압기 층, 로프, Swiglu, RMSNorm 및주의 QKV 바이어스를 포함한 여러 최적화를 수행했습니다. 또한 일반화 된 쿼리주의 (GQA)를 사용하고, 연장 된 컨텍스트 길이는 131,072 개의 토큰이며, 사전 훈련, 감독 미세 조정 및 강화 학습을 포함한 다단계 교육을받습니다.

QWQ-32B의 강화 학습 과정은 두 단계로 나뉩니다. 첫 번째 단계는 수학 및 코딩 기능에 중점을두고 교육을 위해 정확도 검증자 및 코드 실행 서버를 사용합니다. 두 번째 단계는 일반적인 보상 모델과 규칙 기반 유효성 검사기를 통한 보상 교육이며, 인적 정렬 및 대리 추론 기능을 향상시키면서 수학 및 코딩 기능에 영향을 미치지 않습니다.

또한 QWQ-32B에는 에이전트 기능이있어 환경 피드백에 따라 추론 프로세스를 동적으로 조정할 수 있습니다. Qwen 팀은 최적의 성능을 위해 특정 추론 설정을 사용하고 VLLM을 사용한 배포를 지원하는 것이 좋습니다.

Qwen 팀은 QWQ-32B를 확장 된 강화 학습을 통해 추론 기능을 향상시키는 첫 번째 단계로 간주합니다. 앞으로, 강화 학습의 확장, 장기 추론을 달성하기 위해 에이전트 및 강화 학습을 확장하고 강화 학습을 위해 최적화 된 기본 모델을 계속 개발하고 궁극적으로 일반적인 인공 지능 (AGI)을 향해 나아갈 계획입니다.

모델 : https://qwenlm.github.io/blog/qwq-32b/