L'équipe QWEN d'Alibaba a récemment publié son dernier membre de la famille Open Source Big Language Model (LLM) - QWQ-32B. Ce modèle d'inférence avec 32 milliards de paramètres améliore considérablement les performances dans des tâches complexes de résolution de problèmes grâce à la technologie d'apprentissage par renforcement (RL). Le lancement de QWQ-32B marque la poursuite de la percée d'Alibaba dans le domaine de l'intelligence artificielle, en particulier dans l'application et l'optimisation des modèles d'inférence.

QWQ-32B est ouvert sous la licence Apache 2.0 sur les plates-formes de face et de modèles, ce qui signifie qu'il n'est pas seulement pour la recherche mais aussi à des fins commerciales. Les entreprises peuvent intégrer le modèle directement dans leurs produits ou services, y compris ces applications payantes. De plus, les utilisateurs individuels peuvent également accéder au modèle via QWEN CHAT et profiter de leurs puissantes capacités d'inférence.

QWQ, nom complet Qwen-avec-Questions, est un modèle de raisonnement open source lancé pour la première fois par Alibaba en novembre 2024, visant à rivaliser avec O1-Preview d'Openai. Ce modèle améliore considérablement le raisonnement logique et la planification des compétences en réexamen et en améliorant les réponses pendant le processus de raisonnement, en particulier dans les tâches mathématiques et codantes. Le lancement de QWQ-32B consolide davantage la position principale d'Alibaba dans ce domaine.

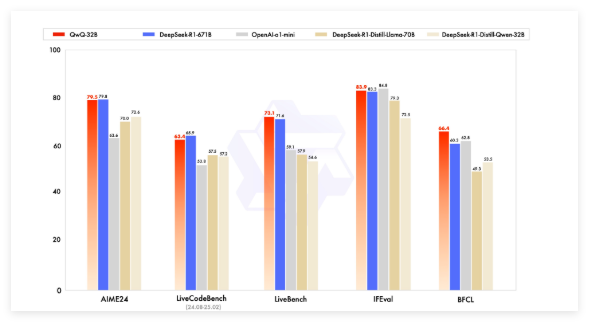

Les premiers modèles QWQ ont dépassé O1-Preview d'OpenAI dans les références mathématiques telles que les tâches de raisonnement AIME et Math et Scientific telles que GPQA. Cependant, dans la programmation de repères (comme LivecodeBench), ses performances sont relativement faibles et il y a des problèmes tels que le mélange de langage et l'argumentation en boucle. Néanmoins, Alibaba a choisi de libérer le modèle sous la licence Apache 2.0, le distinguant des solutions propriétaires d'Openai, permettant aux développeurs et aux entreprises de s'adapter et de commercialiser librement.

Avec le développement du domaine de l'intelligence artificielle, les limites des LLM traditionnelles ont progressivement émergé, et l'amélioration des performances provoquée par une expansion à grande échelle a également commencé à ralentir. Cela suscite l'intérêt pour les modèles d'inférence importants (LRM), ce qui améliore la précision par le raisonnement en temps d'inférence et l'auto-réflexion. Le QWQ-32B améliore encore ses performances en intégrant l'apprentissage du renforcement et l'auto-interrogation structurée et en devenant un concurrent important dans le domaine du raisonnement de l'IA.

QWQ-32B a concouru avec des modèles de premier plan tels que Deepseek-R1 et O1-MINI dans le test de référence, et a obtenu des résultats concurrentiels lorsque le volume des paramètres était plus petit que certains concurrents. Par exemple, Deepseek-R1 a 671 milliards de paramètres, tandis que le QWQ-32B a une exigence de mémoire plus petite lorsque ses performances sont comparables, généralement seulement 24 Go de VRAM sont nécessaires sur le GPU, tout en exécutant un R1 Full Deepseek nécessite plus de 1500 Go de VRAM.

QWQ-32B adopte une architecture de modèle de langue causale et a effectué plusieurs optimisations, notamment 64 couches de transformateur, Rope, Swiglu, RMSNorm et le biais QKV d'attention. Il utilise également l'attention de la requête généralisée (GQA), a une longueur de contexte prolongée de 131 072 jetons et suivi une formation en plusieurs étapes, y compris la pré-formation, le réglage fin supervisé et l'apprentissage du renforcement.

Le processus d'apprentissage du renforcement du QWQ-32B est divisé en deux étapes: la première étape se concentre sur les mathématiques et les capacités de codage, et utilise des validateurs de précision et des serveurs d'exécution de code pour la formation; La deuxième étape est la formation de récompense à travers un modèle de récompense général et un validateur basé sur des règles pour améliorer l'enseignement après, l'alignement humain et les capacités de raisonnement de proxy, sans affecter ses capacités mathématiques et codantes.

De plus, QWQ-32B a également des capacités d'agent, qui peuvent ajuster dynamiquement le processus d'inférence en fonction de la rétroaction environnementale. L'équipe QWEN recommande d'utiliser des paramètres d'inférence spécifiques pour des performances optimales et prend en charge le déploiement à l'aide de VLLM.

L'équipe QWEN considère le QWQ-32B comme la première étape pour améliorer les capacités du raisonnement grâce à un apprentissage en renforcement prolongé. À l'avenir, il prévoit d'explorer davantage l'apprentissage du renforcement, l'intégration des agents et l'apprentissage du renforcement pour réaliser un raisonnement à long terme et continuer à développer des modèles de base optimisés pour l'apprentissage du renforcement, et, finalement, vers l'intelligence artificielle générale (AGI).

Modèle: https://qwenlm.github.io/blog/qwq-32b/