أصدر فريق QWEN الخاص بـ Alibaba مؤخرًا أحدث فرد من أفراد عائلة اللغة الكبيرة المفتوحة المصدر (LLM) - QWQ -32B. يعمل نموذج الاستدلال الذي يحتوي على 32 مليار معلمة إلى تحسين الأداء بشكل كبير في مهام حل المشكلات المعقدة من خلال تقنية التعلم التعزيز (RL). يمثل إطلاق QWQ-32B اختراق Alibaba الإضافي في مجال الذكاء الاصطناعي ، وخاصة في تطبيق نماذج الاستدلال وتحسينها.

QWQ-32B مفتوح من مصادر بموجب ترخيص Apache 2.0 على منصات Hugging Face و ModelScope ، مما يعني أنه ليس فقط للبحث ولكن أيضًا للأغراض التجارية. يمكن للشركات دمج النموذج مباشرة في منتجاتها أو خدماتها ، بما في ذلك التطبيقات المدفوعة. بالإضافة إلى ذلك ، يمكن للمستخدمين الأفراد أيضًا الوصول إلى النموذج من خلال دردشة Qwen والاستمتاع بقدرات الاستدلال القوية.

QWQ ، الاسم الكامل Qwen-with-Questions ، هو نموذج التفكير مفتوح المصدر الذي أطلقه Alibaba لأول مرة في نوفمبر 2024 ، بهدف التنافس مع Openai's O1-Preview. يعزز هذا النموذج مهارات التفكير والتخطيط المنطقي بشكل كبير من خلال مراجعة الذات وتحسين الإجابات أثناء عملية التفكير ، وخاصة في المهام الرياضية والترميز. إن إطلاق QWQ-32B يدمج موقعًا رائدًا في هذا المجال.

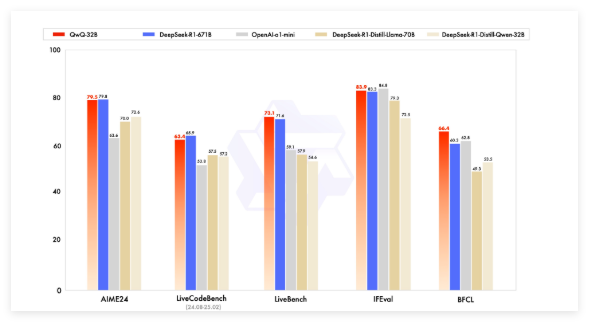

لقد تجاوزت نماذج QWQ المبكرة Openai O1-Preview في المعايير الرياضية مثل AIME والرياضيات والتفكير العلمي مثل GPQA. ومع ذلك ، في معايير البرمجة (مثل LiveCodeBench) ، يكون أدائها ضعيفًا نسبيًا وهناك مشاكل مثل خلط اللغة وحجة الحلقة. ومع ذلك ، اختارت Alibaba إطلاق النموذج بموجب ترخيص Apache 2.0 ، مما يميزه عن الحلول الخاصة في Openai ، مما يسمح للمطورين والشركات بالتكيف والتسويق بحرية.

مع تطوير مجال الذكاء الاصطناعي ، ظهرت حدود LLMs التقليدية تدريجياً ، وقد بدأ تحسين الأداء الناجم عن التوسع على نطاق واسع في التباطؤ. هذا يدفع الاهتمام بنماذج الاستدلال الكبيرة (LRM) ، والتي تعمل على تحسين الدقة من خلال التفكير في وقت الاستدلال والتأمل الذاتي. تعمل QWQ-32B على تحسين أدائها من خلال دمج التعلم التعزيز والاستبدال الذاتي المنظم وتصبح منافسًا مهمًا في مجال التفكير في الذكاء الاصطناعي.

تنافس QWQ-32B مع نماذج رائدة مثل Deepseek-R1 و O1-MINI في الاختبار القياسي ، وحقق نتائج تنافسية عندما كان حجم المعلمة أصغر من بعض المنافسين. على سبيل المثال ، لدى DeepSeek-R1 671 مليار معلمة ، في حين أن QWQ-32B لديه متطلبات ذاكرة أصغر عندما يكون أدائها مماثلًا ، عادة ما يكون هناك مطلوب فقط 24 جيجابايت من VRAM على وحدة معالجة الرسومات ، مع تشغيل Deepseek R1 الكامل أكثر من 1500 جيجابايت من VRAM.

QWQ-32B يتبنى بنية نموذجية للغة السببية ونفذت تحسينات متعددة ، بما في ذلك 64 طبقات محول ، حبل ، Swiglu ، RMSNORM و LUTTE QKV. كما توظف اهتمام الاستعلام المعمم (GQA) ، ولديه طول سياق ممتد يبلغ 131،072 رمزًا ، ويخضع للتدريب متعدد المراحل بما في ذلك التدريب المسبق ، والضغط الخاضع للإشراف ، والتعلم التعزيز.

تنقسم عملية تعلم التعزيز لـ QWQ-32B إلى مرحلتين: تركز المرحلة الأولى على قدرات الرياضيات وترميز ، وتستخدم مصادقة الدقة وخوادم تنفيذ التعليمات البرمجية للتدريب ؛ المرحلة الثانية هي التدريب على المكافآت من خلال نموذج مكافأة عام ومقحة قائمة على القواعد لتحسين التعليمات التالية ، والمواءمة البشرية وقدرات التفكير بالوكالة ، مع عدم التأثير على قدراتها الرياضية والترميز.

بالإضافة إلى ذلك ، لدى QWQ-32B أيضًا قدرات الوكيل ، والتي يمكنها ضبط عملية الاستدلال بشكل ديناميكي بناءً على ردود الفعل البيئية. يوصي فريق QWEN باستخدام إعدادات الاستدلال المحددة للأداء الأمثل ويدعم النشر باستخدام VLLM.

يعتبر فريق QWEN QWQ-32B كخطوة أولى لتعزيز قدرات التفكير من خلال تعلم التعزيز الموسع. في المستقبل ، تخطط لاستكشاف توسيع نطاق التعلم التعزيز ، ودمج الوكلاء وتعلم التعزيز لتحقيق التفكير على المدى الطويل ، والاستمرار في تطوير النماذج الأساسية المحسنة للتعلم التعزيز ، والانتقال في النهاية نحو الذكاء الاصطناعي العام (AGI).

النموذج: https://qwenlm.github.io/blog/qwq-32b/