AlibabaのQwenチームは最近、最新のオープンソース大手言語モデル(LLM)家族メンバーであるQWQ -32Bをリリースしました。 320億パラメーターを備えたこの推論モデルは、強化学習(RL)テクノロジーを通じて複雑な問題解決タスクのパフォーマンスを大幅に向上させます。 QWQ-32Bの発売は、特に推論モデルのアプリケーションと最適化における人工知能の分野でのアリババのさらなるブレークスルーをマークします。

QWQ-32Bは、ハグする顔とモデルのプラットフォームのApache 2.0ライセンスの下で開かれています。つまり、研究だけでなく商業目的でもあります。企業は、モデルを有料アプリケーションを含む製品またはサービスに直接統合できます。さらに、個々のユーザーはQwenチャットを介してモデルにアクセスし、強力な推論機能を享受することもできます。

QWQ、QWEN-With-Questionsは、2024年11月にAlibabaが最初に開始したオープンソース推論モデルであり、OpenaiのO1-Previewと競争することを目指しています。このモデルは、特に数学的およびコーディングタスクにおいて、推論プロセス中に回答を自己参照し、改善することにより、論理的な推論と計画スキルを大幅に向上させます。 QWQ-32Bの発売は、この分野でのアリババの主要な位置をさらに統合します。

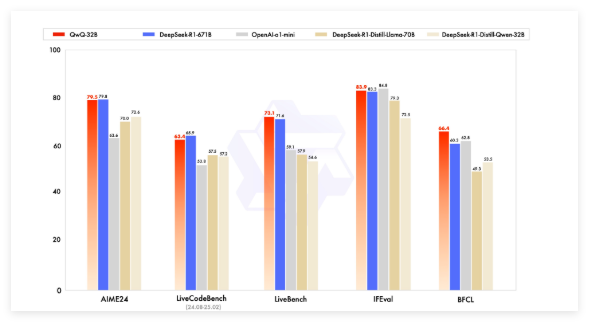

初期のQWQモデルは、AIMEや数学などの数学的ベンチマークでOpenAIのO1-Previewを上回り、GPQAなどの科学的推論タスクを超えています。ただし、プログラミングベンチマーク(LiveCodebenchなど)では、そのパフォーマンスは比較的弱く、言語の混合やループの議論などの問題があります。それにもかかわらず、AlibabaはApache 2.0ライセンスの下でモデルをリリースすることを選択し、Openai独自のソリューションと区別し、開発者や企業が自由に適応して商業化できるようにしました。

人工知能の分野の開発により、従来のLLMの制限が徐々に現れ、大規模な拡大によってもたらされるパフォーマンスの改善も減速し始めています。これにより、大きな推論モデル(LRM)への関心が促進され、推論時間推論と自己反省を通じて精度が向上します。 QWQ-32Bは、強化学習と構造化された自己質問を統合し、推論AIの分野で重要な競合他社になることにより、パフォーマンスをさらに向上させます。

QWQ-32Bは、ベンチマークテストでDeepSeek-R1やO1-Miniなどの主要なモデルと競合し、一部の競合他社よりもパラメーターボリュームが小さい場合に競争結果を達成しました。たとえば、DeepSeek-R1には6710億のパラメーターがありますが、QWQ-32Bにはパフォーマンスが同等の場合、メモリ要件が小さくなります。通常、GPUで24GBのVRAMのみが必要です。

QWQ-32Bは、因果言語モデルアーキテクチャを採用し、64の変圧器層、ロープ、Swiglu、RMSNorm、注意QKVバイアスなど、複数の最適化を実施しています。また、一般化されたクエリの注意(GQA)を採用し、131,072トークンの拡張コンテキスト長を持ち、トレーニング前、監視された微調整、補強学習などのマルチステージトレーニングを受けます。

QWQ-32Bの補強学習プロセスは2つの段階に分かれています。最初の段階は数学とコーディング機能に焦点を当て、トレーニングに精度バリデーターとコード実行サーバーを使用します。第2段階は、一般的な報酬モデルを通じて報酬トレーニングと、数学的およびコーディング機能には影響しない一方で、次の命令、人間のアライメント、およびプロキシ推論機能を改善するためのルールベースのバリデーターです。

さらに、QWQ-32Bにはエージェント機能もあり、環境フィードバックに基づいて推論プロセスを動的に調整できます。 QWENチームは、最適なパフォーマンスのために特定の推論設定を使用することを推奨し、VLLMを使用した展開をサポートします。

QWENチームは、QWQ-32Bを、拡張された強化学習を通じて推論機能を強化する最初のステップと見なしています。将来的には、長期的な推論を達成するために補強学習、統合エージェント、および強化学習をさらに調査し、強化学習のために最適化された基本モデルを開発し続け、最終的に一般的な人工知能(AGI)に移行することを計画しています。

モデル:https://qwenlm.github.io/blog/qwq-32b/