A equipe QWEN da Alibaba lançou recentemente seu mais recente membro da família Open Language Model (LLM) - QWQ -32B. Esse modelo de inferência com 32 bilhões de parâmetros melhora significativamente o desempenho em tarefas complexas de solução de problemas por meio da tecnologia de aprendizado de reforço (RL). O lançamento do QWQ-32B marca o avanço adicional de Alibaba no campo da inteligência artificial, especialmente na aplicação e otimização de modelos de inferência.

O QWQ-32B é de origem aberta sob a licença Apache 2.0 nas plataformas Hugging Face e Modelscope, o que significa que não é apenas para pesquisa, mas também para fins comerciais. As empresas podem integrar o modelo diretamente em seus produtos ou serviços, incluindo os pedidos pagos. Além disso, usuários individuais também podem acessar o modelo através do QWEN Chat e aproveitar seus poderosos recursos de inferência.

QWQ, Nome completo Qwen-With-Questions, é um modelo de raciocínio de código aberto lançado pela Alibaba em novembro de 2024, com o objetivo de competir com o O1-Preview do OpenAI. Esse modelo aprimora significativamente as habilidades lógicas de raciocínio e planejamento, auto-revisando e melhorando as respostas durante o processo de raciocínio, especialmente em tarefas matemáticas e de codificação. O lançamento do QWQ-32B consolida ainda mais a posição de liderança do Alibaba neste campo.

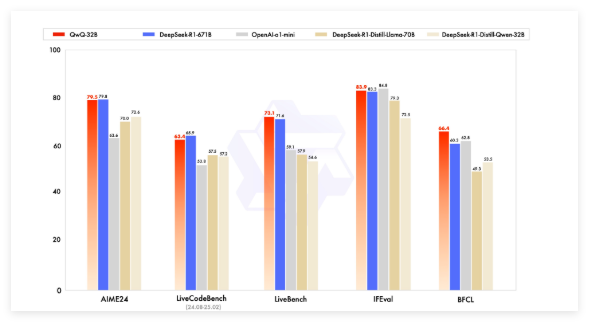

Os primeiros modelos de QWQ superaram a previsão de O1 da OpenAI em benchmarks matemáticos, como AIME e tarefas de matemática e raciocínio científico, como o GPQA. No entanto, na programação de benchmarks (como o LivecodeBench), seu desempenho é relativamente fraco e há problemas como a mistura de idiomas e a argumentação do loop. No entanto, o Alibaba optou por liberar o modelo sob a licença Apache 2.0, distinguindo -a das soluções proprietárias da OpenAI, permitindo que desenvolvedores e empresas se adaptem e comercializem livremente.

Com o desenvolvimento do campo da inteligência artificial, as limitações dos LLMs tradicionais surgiram gradualmente, e a melhoria do desempenho provocada pela expansão em larga escala também começou a desacelerar. Isso impulsiona o interesse em grandes modelos de inferência (LRM), o que melhora a precisão por meio de raciocínio e auto-reflexão em tempo de inferência. O QWQ-32B melhora ainda mais seu desempenho, integrando a aprendizagem de reforço e o auto-questionamento estruturado e se tornando um concorrente importante no campo do raciocínio da IA.

O QWQ-32B competiu com os principais modelos, como Deepseek-R1 e O1-Mini no teste de referência e obteve resultados competitivos quando o volume de parâmetros foi menor que alguns concorrentes. Por exemplo, o DeepSeek-R1 possui 671 bilhões de parâmetros, enquanto o QWQ-32B tem um requisito de memória menor quando seu desempenho é comparável, geralmente apenas 24 GB de VRAM é necessário na GPU, enquanto a execução de um R1 do Deepseek completo requer mais de 1500 GB de VRAM.

O QWQ-32B adota uma arquitetura de modelo de linguagem causal e realizou várias otimizações, incluindo 64 camadas de transformador, corda, swiglu, rmsnorm e viés de qkv de atenção. Ele também emprega atenção generalizada da consulta (GQA), possui um comprimento de contexto prolongado de 131.072 tokens e passa por treinamento em vários estágios, incluindo aprendizado de pré-treinamento, ajuste fino e reforço.

O processo de aprendizado de reforço do QWQ-32B é dividido em dois estágios: o primeiro estágio se concentra em recursos de matemática e codificação e usa validadores de precisão e servidores de execução de código para treinamento; O segundo estágio é o treinamento de recompensa por meio de um modelo de recompensa geral e um validador baseado em regras para melhorar as seguintes instruções, o alinhamento humano e as capacidades de raciocínio de procuração, sem afetar seus recursos matemáticos e de codificação.

Além disso, o QWQ-32B também possui recursos de agentes, que podem ajustar dinamicamente o processo de inferência com base no feedback ambiental. A equipe QWEN recomenda o uso de configurações de inferência específicas para obter o melhor desempenho e suporta a implantação usando o VLLM.

A equipe QWEN considera o QWQ-32B como a primeira etapa para aprimorar os recursos de raciocínio por meio de aprendizado de reforço estendido. No futuro, planeja explorar ainda mais a expansão da aprendizagem de reforço, a integração de agentes e o aprendizado de reforço para alcançar o raciocínio a longo prazo e continuar a desenvolver modelos básicos otimizados para a aprendizagem de reforço e, finalmente, avançam em direção à inteligência artificial geral (AGI).

Modelo: https://qwenlm.github.io/blog/qwq-32b/