Das QWEN -Team von Alibaba hat kürzlich sein neuestes Familienmitglied von Open Source Langual Language Model (LLM) - QWQ -32B - veröffentlicht. Dieses Inferenzmodell mit 32 Milliarden Parametern verbessert die Leistung in komplexen Problemlösungsaufgaben durch RL-Technologie (Verstärkungslernen). Der Start von QWQ-32B markiert Alibabas weiteren Durchbruch im Bereich der künstlichen Intelligenz, insbesondere in der Anwendung und Optimierung von Inferenzmodellen.

QWQ-32B ist unter der Apache 2.0-Lizenz auf den Umarmungs- und Modelscope-Plattformen offen bezogen, was bedeutet, dass sie nicht nur für die Forschung, sondern auch für kommerzielle Zwecke dient. Unternehmen können das Modell direkt in ihre Produkte oder Dienstleistungen integrieren, einschließlich dieser bezahlten Anwendungen. Darüber hinaus können einzelne Benutzer über Qwen Chat auf das Modell zugreifen und ihre leistungsstarken Inferenzfunktionen genießen.

QWQ, Vollständiger Name Qwen-with-Fragen, ist ein Open-Source-Argumentationsmodell, das im November 2024 erstmals von Alibaba gestartet wurde und mit der O1-Präview von OpenAI konkurrieren soll. Dieses Modell verbessert das logische Argumentations- und Planungsfähigkeiten erheblich, indem die Antworten während des Argumentationsprozesses, insbesondere bei mathematischen und codierenden Aufgaben, selbstberichtet und verbessert werden. Der Start von QWQ-32B konsolidiert die führende Position von Alibaba in diesem Bereich weiter.

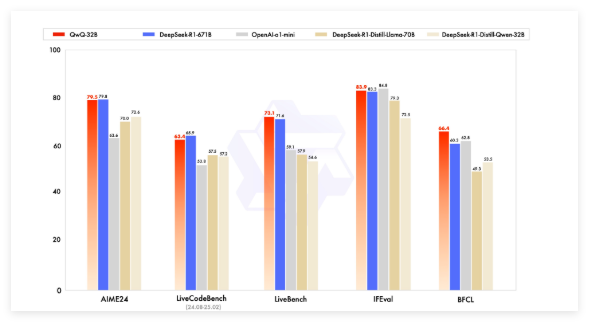

Frühe QWQ-Modelle haben OpenAs O1-Vorwand in mathematischen Benchmarks wie Aime- und Mathematik- und wissenschaftlichen Argumentationsaufgaben wie GPQA übertroffen. Bei der Programmierung von Benchmarks (z. B. LivecodeBench) ist seine Leistung jedoch relativ schwach und es gibt Probleme wie Sprachmischung und Loop -Argumentation. Trotzdem entschied sich Alibaba dafür, das Modell unter der Apache 2.0 -Lizenz zu veröffentlichen und es von OpenAs proprietären Lösungen zu unterscheiden, sodass Entwickler und Unternehmen frei anpassen und kommerzialisiert werden können.

Mit der Entwicklung des Gebiets der künstlichen Intelligenz sind allmählich die Grenzen traditioneller LLMs entstanden, und die Leistungsverbesserung, die durch eine groß angelegte Expansion verursacht wurde, wurde ebenfalls langsamer. Dies treibt das Interesse an großen Inferenzmodellen (LRM) vor, was die Genauigkeit durch Inferenzzeit-Argumentation und Selbstreflexion verbessert. QWQ-32B verbessert seine Leistung weiter durch die Integration des Verstärkungslernens und die strukturierte Selbstbefragung und wird ein wichtiger Konkurrent im Bereich der KI.

QWQ-32B konkurrierten im Benchmark-Test mit führenden Modellen wie Deepseek-R1 und O1-Mini und erzielten Wettbewerbsergebnisse, wenn das Parametervolumen kleiner war als bei einigen Konkurrenten. Zum Beispiel hat Deepseek-R1 671 Milliarden Parameter, während der QWQ-32B eine geringere Speicheranforderung aufweist, wenn seine Leistung vergleichbar ist. In der Regel ist für die GPU nur 24 GB VRAM erforderlich, während ein volles Deepseek R1 mehr als 1500 GB VRAM benötigt.

QWQ-32B nimmt eine kausale Sprachmodellarchitektur an und hat mehrere Optimierungen durchgeführt, darunter 64 Transformatorschichten, Seil, Swiglu, RMSNORM und Achtung QKV-Vorspannung. Es wird auch generalisierte Abfrageaufmerksamkeit (GQA) verwendet, hat eine erweiterte Kontextlänge von 131.072 Token und absolviert ein mehrstufiges Training, einschließlich Vorausbildung, beaufsichtigter Feinabstimmung und Verstärkungslernen.

Der Verstärkungslernen von QWQ-32B ist in zwei Phasen unterteilt: Die erste Stufe konzentriert sich auf Mathematik- und Codierungsfunktionen und verwendet Genauigkeitsvalidatoren und Code-Ausführungsserver für das Training. Die zweite Stufe ist das Belohnungstraining durch ein General Belohnmodell und einen regelbasierten Validator, um die Anweisungen der Anweisungen, die Ausrichtung des Menschen und die Funktionen von Proxy-Argumentationen zu verbessern, während sie sich nicht auf die mathematischen und codierenden Funktionen auswirken.

Darüber hinaus verfügt QWQ-32B über Agentenfunktionen, mit denen der Inferenzprozess basierend auf Umweltfeedback dynamisch anpassen kann. Das QWEN -Team empfiehlt die Verwendung spezifischer Inferenzeinstellungen für eine optimale Leistung und unterstützt die Bereitstellung mithilfe von VLLM.

Das QWEN-Team betrachtet QWQ-32B als erster Schritt, um die Argumentationsfunktionen durch erweitertes Verstärkungslernen zu verbessern. In Zukunft plant es weiter, um das Erweiterung des Verstärkungslernens, das Integrieren von Wirkstoffen und das Lernen des Verstärkers weiter zu untersuchen, um langfristiges Denken zu erreichen, und weiterhin grundlegende Modelle zu entwickeln, die für das Lernen des Verstärkers optimiert sind, und sich letztendlich in Richtung allgemeiner künstlicher Intelligenz (AGI) zu bewegen.

Modell: https://qwenlm.github.io/blog/qwq-32b/