เมื่อวันที่ 6 มีนาคม 2568 สถาบันวิจัยปัญญาประดิษฐ์ของกรุงปักกิ่งจียุกันได้ประกาศรุ่นเวกเตอร์โอเพนซอร์สหลายรูปแบบ BGE-VL ซึ่งเป็นความก้าวหน้าครั้งใหม่ในสาขาการดึงข้อมูลหลายรูปแบบ โมเดล BGE-VL ได้รับผลลัพธ์ที่ดีที่สุดในการค้นหาหลายรูปแบบเช่นการดึงภาพกราฟิกและการดึงภาพและการดึงภาพรวมซึ่งช่วยปรับปรุงประสิทธิภาพของการค้นหาหลายรูปแบบ ความคืบหน้าการพัฒนานี้ไม่เพียง แต่แสดงให้เห็นถึงตำแหน่งผู้นำของจีนในด้านปัญญาประดิษฐ์ แต่ยังให้ทิศทางใหม่สำหรับการพัฒนาเทคโนโลยีการดึงข้อมูลหลายรูปแบบทั่วโลก

การพัฒนาของ BGE-VL นั้นขึ้นอยู่กับชุดข้อมูลสังเคราะห์ขนาดใหญ่ Megapairs ซึ่งมีการทำเหมืองข้อมูลสามรูปแบบหลายรูปแบบจากคลังข้อมูลกราฟิกขนาดใหญ่โดยการรวมโมเดลการแสดงหลายรูปแบบแบบจำลองขนาดใหญ่หลายรูปแบบและแบบจำลองภาษาขนาดใหญ่ วิธีนี้ไม่เพียง แต่มีความยืดหยุ่นที่ยอดเยี่ยม แต่ยังสามารถสร้างข้อมูลที่หลากหลายและมีคุณภาพสูงอย่างต่อเนื่องในราคาที่ต่ำมาก แต่ยังช่วยปรับปรุงคุณภาพข้อมูลอย่างมาก เมื่อเปรียบเทียบกับข้อมูลคำอธิบายประกอบแบบแมนนวลแบบดั้งเดิม Megapairs ต้องการเพียง 1/70 ของปริมาณข้อมูลเพื่อให้ได้ผลการฝึกอบรมที่ดีขึ้นซึ่งให้การสนับสนุนข้อมูลที่สำคัญสำหรับการวิจัยหลายรูปแบบในอนาคต

ในแง่ของการใช้งานด้านเทคนิคการสร้างเมกะพินแบ่งออกเป็นสองขั้นตอนสำคัญ: ก่อนอื่นให้ใช้โมเดลความคล้ายคลึงกันหลายแบบเพื่อขุดคู่ภาพที่หลากหลายจากชุดข้อมูลภาพ ประการที่สองใช้โมเดลขนาดใหญ่หลายรูปแบบโอเพนซอร์ซและโมเดลภาษาขนาดใหญ่เพื่อสังเคราะห์คำแนะนำการค้นหาโดเมนแบบเปิด ด้วยวิธีการนี้ Megapairs สามารถปรับขนาดชุดข้อมูลคำแนะนำการค้นหาแบบหลายรูปแบบที่มีคุณภาพสูงและหลากหลายโดยไม่ต้องมีส่วนร่วมด้วยตนเอง การเปิดตัวในเวลานี้ครอบคลุม 26 ล้านตัวอย่างให้การสนับสนุนข้อมูลที่หลากหลายสำหรับการฝึกอบรมแบบจำลองการดึงข้อมูลหลายรูปแบบซึ่งส่งเสริมการพัฒนาเทคโนโลยีการดึงข้อมูลแบบหลายรูปแบบอย่างมาก

จากชุดข้อมูล megapairs ทีม Zhiyuan BGE ได้รับการฝึกฝนสามแบบหลายรูปแบบที่แตกต่างกันรวมถึง BGE-VL-Base, BGE-VL-large และ BGE-VL-MLLM โมเดลเหล่านี้แสดงประสิทธิภาพที่นำไปสู่มากกว่าวิธีการก่อนหน้านี้ในหลาย ๆ งาน ในงานประเมินผลการฝังแบบหลายรูปแบบ 36 งานของเกณฑ์มาตรฐานการฝังแบบหลายรูปแบบขนาดใหญ่ (MMEB) BGE-VL ได้รับประสิทธิภาพที่ดีที่สุดทั้งประสิทธิภาพที่เป็นศูนย์ตัวอย่างและประสิทธิภาพการปรับแต่งที่ดี ความสำเร็จนี้ไม่เพียง แต่แสดงให้เห็นถึงประสิทธิภาพที่ทรงพลังของโมเดล BGE-VL แต่ยังให้แนวคิดใหม่สำหรับการวิจัยหลายรูปแบบในอนาคต

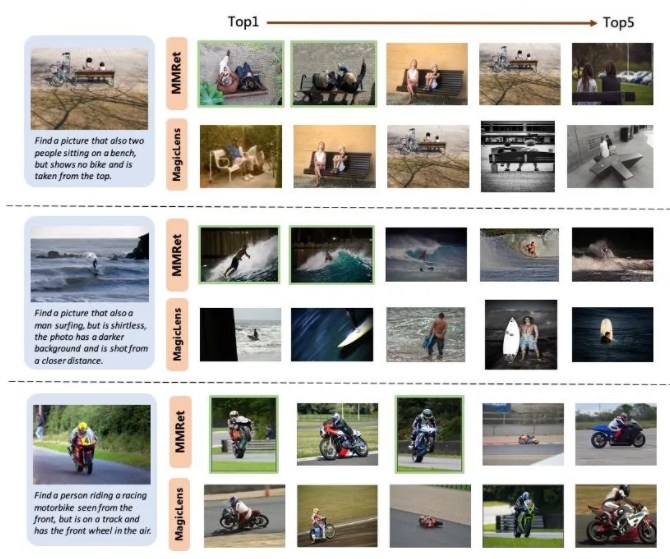

ในงานการดึงภาพรวม BGE-VL รีเฟรชเกณฑ์มาตรฐานที่มีอยู่ในชุดการประเมินค่า Circo ซึ่งมีอยู่เหนือขอบเขตการเปรียบเทียบเช่นซีรี่ส์ Magiclens ของ Google และ MM-embed ของ Nvidia BGE-VL-MLLM ปรับปรุงคะแนน 8.1 เปอร์เซ็นต์เมื่อเทียบกับรุ่น SOTA ก่อนหน้าในขณะที่รุ่น BGE-VL-base เหนือกว่าตัวดึงข้อมูลหลายรูปแบบของฐานขนาดใหญ่อื่น ๆ ที่มีพารามิเตอร์น้อยกว่า 1/50 ความคืบหน้าการพัฒนานี้ไม่เพียง แต่แสดงให้เห็นถึงประสิทธิภาพที่ทรงพลังของโมเดล BGE-VL แต่ยังให้แนวคิดใหม่สำหรับการวิจัยหลายรูปแบบในอนาคต

นอกจากนี้การศึกษายังแสดงให้เห็นว่าชุดข้อมูล megapairs มีความยืดหยุ่นและประสิทธิภาพที่ดี เมื่อขนาดข้อมูลเพิ่มขึ้นโมเดล BGE-VL แสดงแนวโน้มการเติบโตของประสิทธิภาพที่สอดคล้องกัน เมื่อเปรียบเทียบกับ Google Magiclens โมเดล SOTA ที่ผ่านการฝึกอบรมเกี่ยวกับข้อมูลปิด 37M Megapairs ต้องการเพียง 1/70 ของมาตราส่วนข้อมูล (0.5m) เพื่อให้ได้เปรียบประสิทธิภาพที่สำคัญ การค้นพบนี้ให้การสนับสนุนข้อมูลที่สำคัญสำหรับการวิจัยหลายรูปแบบในอนาคตและยังให้ทิศทางใหม่สำหรับการพัฒนาเทคโนโลยีการดึงข้อมูลหลายรูปแบบ

หน้าแรกของโครงการ:

https://github.com/vectorspacelab/megapairs

ที่อยู่รุ่น:

https://huggingface.co/baai/bge-vl-mllm-s1