2025 년 3 월 6 일, 베이징 Zhiyuan 인공 지능 연구 연구소는 오픈 소스 멀티 모달 벡터 모델 BGE-VL을 발표했는데, 이는 멀티 모달 검색 분야의 새로운 획기적인 획기적인 것입니다. BGE-VL 모델은 그래픽 및 텍스트 검색 및 결합 된 이미지 검색과 같은 멀티 모달 검색 작업에서 최상의 결과를 얻었으며, 이는 멀티 모달 검색의 성능을 크게 향상 시켰습니다. 이러한 획기적인 진보는 인공 지능 분야에서 중국의 주요 위치를 보여줄뿐만 아니라 글로벌 멀티 모달 검색 기술 개발을위한 새로운 방향을 제공합니다.

BGE-VL의 개발은 다중 모드 표현 모델, 멀티 모달 대형 모델 및 대형 언어 모델을 결합하여 대규모 그래픽 코퍼스의 멀티 모달 트리플 데이터를 효율적으로 광산하는 대규모 합성 데이터 세트 메가 셔츠를 기반으로합니다. 이 방법은 확장 성이 우수 할뿐만 아니라 매우 저렴한 비용으로 다양한 고품질 데이터를 지속적으로 생성 할 수있을뿐만 아니라 데이터 품질을 크게 향상시킬 수 있습니다. 기존 수동 주석 데이터와 비교할 때 Megapairs는 더 나은 교육 결과를 달성하기 위해 데이터 볼륨의 1/70 만 있으면됩니다. 이는 향후 멀티 모달 연구에 대한 중요한 데이터 지원을 제공합니다.

기술적 구현 측면에서, 메가 쌍의 구성은 두 가지 주요 단계로 나뉩니다. 첫째, 여러 유사성 모델을 사용하여 이미지 데이터 세트에서 다양한 이미지 쌍을 채굴하십시오. 둘째, 오픈 소스 멀티 모달 대형 모델과 대형 언어 모델을 사용하여 개방형 도메인 검색 지침을 종합하십시오. 이 접근법을 통해 Megapairs는 수동으로 참여하지 않고 기반의 고품질의 다양한 멀티 모달 검색 지침 데이터 세트를 확장 할 수 있습니다. 이 시간의 출시는 2,600 만 개의 샘플을 포함하여 멀티 모드 검색 모델의 교육을위한 풍부한 데이터 지원을 제공하여 멀티 모달 검색 기술의 개발을 크게 촉진합니다.

Megapairs 데이터 세트를 기반으로 Zhiyuan BGE 팀은 BGE-VL-베이스, BGE-VL-LARGE 및 BGE-VL-MLLM을 포함하여 다양한 크기의 3 가지 멀티 모달 검색 모델을 교육했습니다. 이 모델은 여러 작업에서 이전 방법을 훨씬 초과하는 주요 성능을 보여줍니다. MMEB (Mustive Multimodal Embedding Benchmark)의 36 가지 멀티 모드 임베딩 평가 작업에서 BGE-VL은 제로 샘플 성능 및 감독 된 미세 조정 성능 모두에서 최적의 성능을 달성하여 우수한 작업 일반화 능력을 입증했습니다. 이 성과는 BGE-VL 모델의 강력한 성능을 보여줄뿐만 아니라 향후 멀티 모달 연구를위한 새로운 아이디어를 제공합니다.

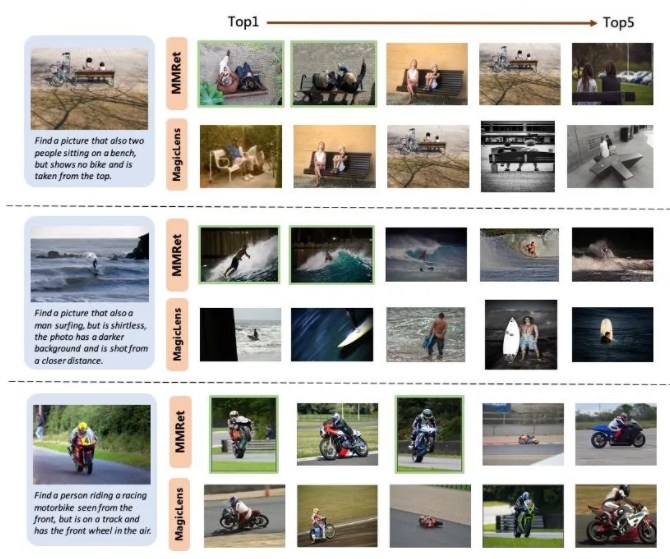

결합 된 이미지 검색 작업에서 BGE-VL은 Circo Evaluation 세트의 기존 벤치 마크를 새로 고쳐서 Google의 Magiclens 시리즈 및 NVIDIA의 MM-EMBED와 같은 비교 기준선을 크게 능가했습니다. BGE-VL-MLLM은 이전 SOTA 모델에 비해 8.1 % 포인트를 향상시키는 반면, BGE-VL-베이스 모델은 매개 변수의 1/50 미만의 다른 대형 모달 염기의 멀티 모달 리트리버를 능가합니다. 이러한 혁신적인 진보는 BGE-VL 모델의 강력한 성능을 보여줄뿐만 아니라 향후 멀티 모달 연구를위한 새로운 아이디어를 제공합니다.

또한이 연구는 Megapairs 데이터 세트가 확장 성과 효율성이 우수하다는 것을 보여줍니다. 데이터 크기가 증가함에 따라 BGE-VL 모델은 일관된 성능 성장 추세를 보여줍니다. Google Magiclens와 비교할 때 37m의 폐쇄 소스 데이터에 대해 교육을받은 SOTA 모델은 상당한 성능 이점을 달성하기 위해 데이터 척도 (0.5m)의 1/70 만 필요합니다. 이 발견은 향후 멀티 모달 연구에 대한 중요한 데이터 지원을 제공하며 멀티 모달 검색 기술 개발을위한 새로운 방향을 제공합니다.

프로젝트 홈페이지 :

https://github.com/vectorspacelab/megapairs

모델 주소 :

https://huggingface.co/baai/bge-vl-mllm-s1