2025年3月6日、北京Zhiyuan人工知能研究所は、マルチモーダル検索の分野での新しいブレークスルーであるオープンソースマルチモーダルベクターモデルBGE-VLを発表しました。 BGE-VLモデルは、マルチモーダル検索のパフォーマンスを大幅に向上させたグラフィックやテキストの検索、組み合わせた画像検索などのマルチモーダル検索タスクで最良の結果を達成しました。この画期的な進捗状況は、人工知能の分野における中国の主要な位置を示すだけでなく、グローバルなマルチモーダル検索技術の開発のための新しい方向性を提供します。

BGE-VLの開発は、マルチモーダル表現モデル、マルチモーダルラージモデル、大規模言語モデルを組み合わせて、大規模なグラフィックコーパスからマルチモーダルトリプルデータを効率的に採掘する大規模な合成データセットメガペアに基づいています。この方法は優れたスケーラビリティを備えているだけでなく、非常に低コストで多様で高品質のデータを継続的に生成することもできますが、データの品質を大幅に向上させることもできます。従来の手動注釈データと比較して、Megapairsは、より良いトレーニング結果を実現するために、データボリュームの1/70のみを必要とします。これは、将来のマルチモーダル研究の重要なデータサポートを提供します。

技術的な実装に関しては、Megapairsの構築は2つの重要な手順に分割されます。最初に、複数の類似性モデルを使用して、画像データセットからのさまざまな画像ペアをマイニングします。第二に、オープンソースのマルチモーダル大型モデルと大規模な言語モデルを使用して、オープンドメイン検索手順を合成します。このアプローチを通じて、Megapairsは、手動での参加なしに、スケーリングベースの高品質で多様なマルチモーダル検索命令データセットをスケーリングできます。この時間のリリースは2600万サンプルをカバーし、マルチモーダル検索モデルのトレーニングに豊富なデータサポートを提供し、マルチモーダル検索技術の開発を大幅に促進しています。

Megapairsデータセットに基づいて、Zhiyuan BGEチームは、BGE-VLベース、BGE-VL-Large、BGE-VL-MLLMを含むさまざまなサイズの3つのマルチモーダル検索モデルをトレーニングしました。これらのモデルは、複数のタスクで以前の方法をはるかに超える主要なパフォーマンスを示しています。大規模なマルチモーダル埋め込みベンチマーク(MMEB)の36のマルチモーダル埋め込み評価タスクでは、BGE-VLはゼロサンプルのパフォーマンスと監視付き微調整パフォーマンスの両方で最適なパフォーマンスを達成し、優れたタスクの一般化能力を証明しました。この成果は、BGE-VLモデルの強力なパフォーマンスを実証するだけでなく、将来のマルチモーダル研究の新しいアイデアも提供します。

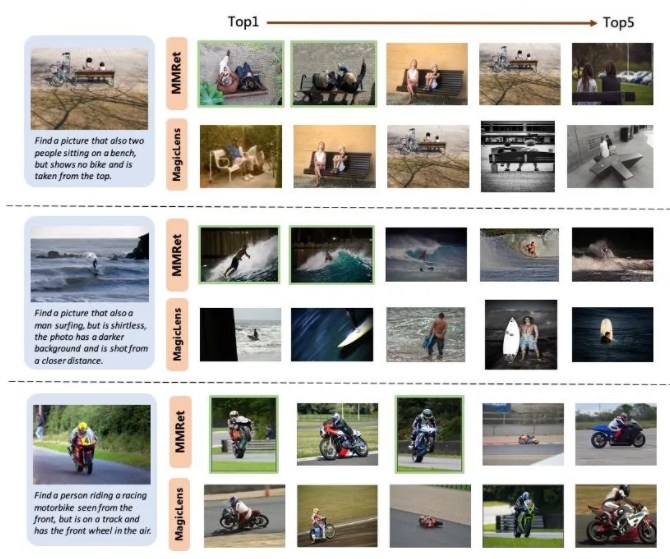

組み合わせた画像検索タスクでは、BGE-VLはCIRCO評価セットの既存のベンチマークを更新し、GoogleのMagicLensシリーズやNvidiaのMM埋め込みなどの比較ベースラインを大幅に上回りました。 BGE-VL-MLLMは、以前のSOTAモデルと比較して8.1パーセントポイントを改善しますが、BGE-VLベースモデルは、パラメーターが1/50未満の他の大型塩基のマルチモーダルレトリバーを上回ります。この画期的な進捗状況は、BGE-VLモデルの強力なパフォーマンスを実証するだけでなく、将来のマルチモーダル研究の新しいアイデアも提供します。

さらに、この調査では、Megapairsデータセットが優れたスケーラビリティと効率を持っていることも示しています。データサイズが大きくなると、BGE-VLモデルは一貫したパフォーマンス成長傾向を示します。 37mのクローズドソースデータでトレーニングされたSOTAモデルであるGoogle Magimlensと比較して、Megapairsは、大きなパフォーマンスの利点を達成するためにデータスケール(0.5m)の1/70のみを必要とします。この発見は、将来のマルチモーダル研究の重要なデータサポートを提供し、マルチモーダル検索技術の開発のための新しい方向性も提供します。

プロジェクトホームページ:

https://github.com/vectorspacelab/megapairs

モデルアドレス:

https://huggingface.co/baai/bge-vl-mllm-s1