Le 6 mars 2025, le Zhiyuan Artificial Intelligence Research Institute a annoncé le modèle de vecteur multimodal open source BGE-VL, qui est une nouvelle percée dans le domaine de la récupération multimodale. Le modèle BGE-VL a obtenu les meilleurs résultats dans des tâches de recherche multimodales telles que la récupération graphique et de texte et la récupération combinée d'images, ce qui a considérablement amélioré les performances de la recherche multimodale. Ce progrès révolutionnaire démontre non seulement la position principale de la Chine dans le domaine de l'intelligence artificielle, mais fournit également une nouvelle orientation pour le développement de la technologie de récupération multimodale mondiale.

Le développement de BGE-VL est basé sur le jeu de données synthétique à grande échelle Megapairs, qui exploite efficacement les données triples multimodales d'un corpus graphique massif en combinant un modèle de représentation multimodale, un modèle multimodal et un modèle grand langage. Cette méthode a non seulement une excellente évolutivité, mais peut également générer en continu des données diverses et de haute qualité à un coût extrêmement faible, mais améliore également considérablement la qualité des données. Par rapport aux données traditionnelles d'annotation manuelle, Megapairs n'a besoin que de 1/70 du volume de données pour obtenir de meilleurs résultats de formation, ce qui fournit un support important des données pour de futures recherches multimodales.

En termes de mise en œuvre technique, la construction de Megapairs est divisée en deux étapes clés: d'abord, utilisez plusieurs modèles de similitude pour extraire une variété de paires d'images à partir de l'ensemble de données d'image; Deuxièmement, utilisez des grands modèles multimodaux open source et des modèles de langage pour synthétiser les instructions de recherche de domaine ouvert. Grâce à cette approche, les mégapairs peuvent être basés sur des ensembles de données d'instructions de recherche multimodaux basés sur l'échelle, sans participation manuelle. La publication de cette période couvre 26 millions d'échantillons, fournissant un soutien riche en données pour la formation de modèles de récupération multimodaux, favorisant considérablement le développement de la technologie de récupération multimodale.

Basé sur l'ensemble de données Megapairs, l'équipe de Zhiyuan BGE a formé trois modèles de récupération multimodaux de différentes tailles, notamment BGE-VL-base, BGE-VL-GARD et BGE-VL-MLLM. Ces modèles montrent des performances principales dépassant de loin les méthodes précédentes sur plusieurs tâches. Dans les 36 tâches d'évaluation d'intégration multimodale de référence multimodale massive (MMEB), BGE-VL a obtenu des performances optimales dans les performances de l'échantillon zéro et des performances de réglage fin supervisées, prouvant sa bonne capacité de généralisation des tâches. Cette réalisation démontre non seulement les performances puissantes du modèle BGE-VL, mais fournit également de nouvelles idées pour de futures recherches multimodales.

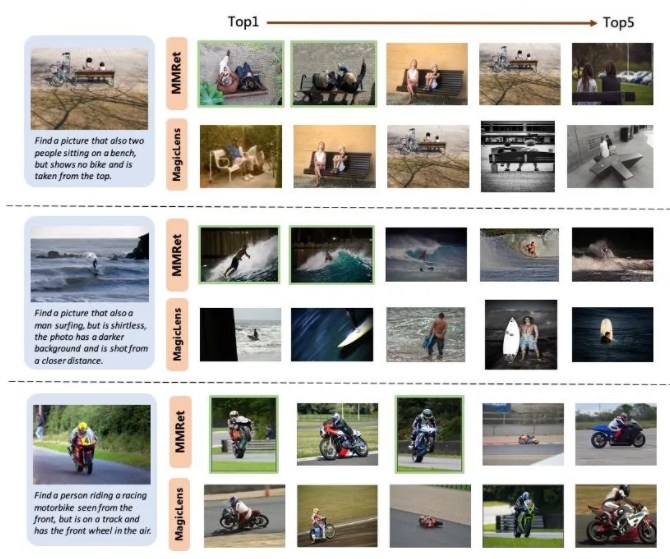

Dans la tâche combinée de récupération d'image, BGE-VL a rafraîchi la référence existante sur l'ensemble d'évaluation de Circo, dépassant considérablement les lignes de base de comparaison telles que la série Magiclens de Google et MM-Embed de Nvidia. BGE-VL-MLLM améliore 8,1 points de pourcentage par rapport au modèle SOTA précédent, tandis que le modèle BGE-VL-base dépasse les récupérateurs multimodaux d'autres bases de grand modale avec moins de 1/50 des paramètres. Ce progrès révolutionnaire démontre non seulement les performances puissantes du modèle BGE-VL, mais fournit également de nouvelles idées pour de futures recherches multimodales.

De plus, l'étude montre également que l'ensemble de données Megapairs a une bonne évolutivité et efficacité. À mesure que la taille des données augmente, le modèle BGE-VL montre une tendance de croissance des performances cohérente. Par rapport à Google Magiclens, le modèle SOTA formé sur des données de source fermée de 37 m, Megapairs ne nécessite que 1/70 de l'échelle de données (0,5 m) pour obtenir des avantages de performance significatifs. Cette découverte fournit un support important des données pour les futures recherches multimodales et fournit également une nouvelle orientation pour le développement de la technologie de récupération multimodale.

Page d'accueil du projet:

https://github.com/vectorspacelab/megapairs

Adresse du modèle:

https://huggingface.co/baai/bge-vl-mllm-s1