Am 6. März 2025 kündigte das Peking Zhiyuan Artificial Intelligence Research Institute das Open-Source-Multimodal-Vektor-Modell BGE-VL an, der ein neuer Durchbruch auf dem Gebiet des multimodalen Abrufs ist. Das BGE-VL-Modell hat die besten Ergebnisse bei multimodalen Suchaufgaben wie Grafik- und Text-Abruf und kombiniertem Bildabruf erzielt, was die Leistung der multimodalen Suche erheblich verbessert hat. Dieser Durchbruch zeigt nicht nur die führende Position Chinas auf dem Gebiet der künstlichen Intelligenz, sondern bietet auch eine neue Richtung für die Entwicklung der globalen multimodalen Abruftechnologie.

Die Entwicklung von BGE-VL basiert auf den groß angelegten synthetischen Datensatz-Megapairs, die multimodale Triple-Daten aus einem massiven grafischen Korpus effizient durch Kombination multimodaler Darstellungsmodell, multimodales großes Modell und großer Sprachmodell effizient abbilden. Diese Methode hat nicht nur eine hervorragende Skalierbarkeit, sondern kann auch kontinuierlich vielfältige und qualitativ hochwertige Daten zu extrem kostengünstig generieren, sondern verbessert auch die Datenqualität erheblich. Im Vergleich zu herkömmlichen Annotationsdaten benötigt Megapairs nur 1/70 des Datenvolumens, um bessere Trainingsergebnisse zu erzielen, was eine wichtige Datenunterstützung für zukünftige multimodale Forschung bietet.

In Bezug auf die technische Implementierung ist die Konstruktion von Megapairs in zwei wichtige Schritte unterteilt: Verwenden Sie zunächst mehrere Ähnlichkeitsmodelle, um eine Vielzahl von Bildpaaren aus dem Bilddatensatz abzubauen. Zweitens verwenden Sie multimodale Großmodelle mit Open-Source-Modellen und Großsprachenmodelle, um Open-Source-Anweisungen für Domänensuche zu synthetisieren. Durch diesen Ansatz kann Megapairs ohne manuelle Teilnahme skalieren, hochwertige und vielfältige multimodale Suchanweisungsdatensätze. Die Veröffentlichung dieser Zeit umfasst 26 Millionen Stichproben, wodurch eine umfassende Daten für die Schulung multimodaler Abrufmodelle unterstützt wird und die Entwicklung der multimodalen Abruftechnologie erheblich fördert.

Basierend auf dem Megapairs-Datensatz trainierte das Zhiyuan BGE-Team drei multimodale Retrieval-Modelle verschiedener Größen, einschließlich BGE-VL-Base, BGE-VL-Large und BGE-VL-MLLM. Diese Modelle zeigen die führende Leistung, die frühere Methoden bei mehreren Aufgaben weit übertreffen. In den 36 multimodalen Einbettungsaufgaben von massivem multimodalem Einbettungs-Benchmark (MMEB) erzielte BGE-VL eine optimale Leistung sowohl bei der Leistung von Null-Sample als auch bei der beaufsichtigten Leistung der Feinabstimmung, was die Fähigkeit zur Generalisierung der guten Aufgaben unter Beweis stellte. Diese Leistung zeigt nicht nur die leistungsstarke Leistung des BGE-VL-Modells, sondern bietet auch neue Ideen für zukünftige multimodale Forschung.

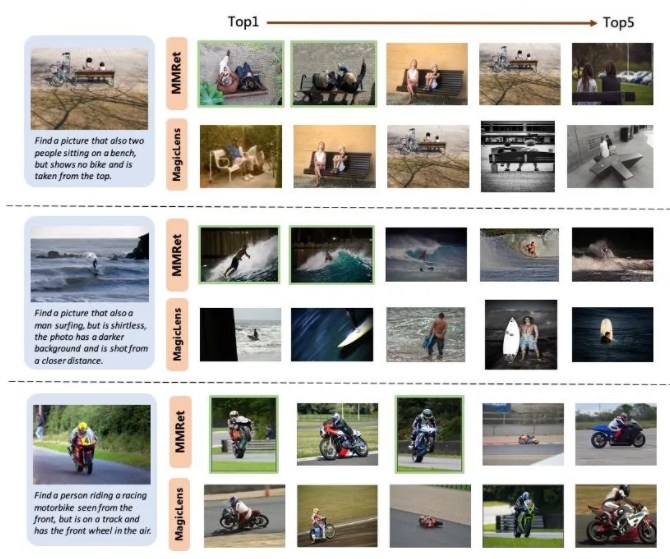

In der kombinierten Aufgabe des Bildabrufs aktualisierte BGE-VL den vorhandenen Benchmark für den Cirto-Bewertungssatz und übertraf die Vergleichsbasislinien signifikant wie die Magiclens-Serie von Google und die MM-EMBE von NVIDIA. BGE-VL-MLLM verbessert 8,1 Prozentpunkte im Vergleich zum vorherigen SOTA-Modell, während das BGE-VL-Base-Modell die multimodalen Retriever anderer großer modaler Basen mit weniger als 1/50 der Parameter übertrifft. Dieser Durchbruch des Fortschritts zeigt nicht nur die leistungsstarke Leistung des BGE-VL-Modells, sondern bietet auch neue Ideen für zukünftige multimodale Forschung.

Darüber hinaus zeigt die Studie auch, dass der Megapairs -Datensatz eine gute Skalierbarkeit und Effizienz aufweist. Mit zunehmender Datengröße zeigt das BGE-VL-Modell einen konsistenten Leistungswachstumstrend. Im Vergleich zu Google Magiclens, dem auf 37 m geschlossenen Quelldaten ausgebildeten SOTA -Modell benötigt Megapairs nur 1/70 der Datenskala (0,5 m), um signifikante Leistungsvorteile zu erzielen. Diese Entdeckung bietet wichtige Datenunterstützung für zukünftige multimodale Forschung und bietet auch eine neue Richtung für die Entwicklung multimodaler Abruftechnologie.

Projekt Homepage:

https://github.com/vectorspacelab/megapairs

Modelladresse:

https://huggingface.co/baai/bge-vl-mllm-s1