Em 6 de março de 2025, o Instituto de Pesquisa de Inteligência Artificial de Beijing Zhiyuan anunciou o modelo de vetor multimodal de código aberto BGE-VL, que é um novo avanço no campo da recuperação multimodal. O modelo BGE-VL alcançou os melhores resultados em tarefas de pesquisa multimodais, como recuperação gráfica e de texto e recuperação de imagens combinadas, o que melhorou significativamente o desempenho da pesquisa multimodal. Esse progresso inovador não apenas demonstra a posição de liderança da China no campo da inteligência artificial, mas também fornece uma nova direção para o desenvolvimento da tecnologia global de recuperação multimodal.

O desenvolvimento do BGE-VL é baseado no conjunto de dados sintéticos em larga escala, megapairs, que minas com eficiência dados triplos multimodais de um corpus gráfico massivo, combinando o modelo de representação multimodal, modelo multimodal grande e modelo de linguagem grande. Esse método não apenas possui excelente escalabilidade, mas também pode gerar continuamente dados diversos e de alta qualidade a um custo extremamente baixo, mas também melhora bastante a qualidade dos dados. Comparado com os dados tradicionais de anotação manual, o Megapairs precisa apenas de 1/70 do volume de dados para obter melhores resultados de treinamento, o que fornece suporte a dados importantes para futuras pesquisas multimodais.

Em termos de implementação técnica, a construção de megapairs é dividida em duas etapas principais: primeiro, use vários modelos de similaridade para extrair uma variedade de pares de imagens do conjunto de dados de imagem; Segundo, use modelos grandes multimodais de código aberto e modelos grandes de idiomas para sintetizar instruções de pesquisa de domínio aberto. Através dessa abordagem, a Megapairs pode, baseada em escala, de alta qualidade e diversos conjuntos de dados de instruções de pesquisa multimodais sem participação manual. O lançamento desta época abrange 26 milhões de amostras, fornecendo suporte de dados ricos para o treinamento de modelos de recuperação multimodal, promovendo bastante o desenvolvimento da tecnologia de recuperação multimodal.

Com base no conjunto de dados Megapairs, a equipe do Zhiyuan BGE treinou três modelos de recuperação multimodal de tamanhos diferentes, incluindo BGE-VL-BASE, BGE-VL-Large e BGE-VL-MLLM. Esses modelos mostram o desempenho líder excedendo em muito os métodos anteriores em várias tarefas. Nas 36 tarefas de avaliação de incorporação multimodal de enorme referência multimodal de incorporação (MMEB), o BGE-VL alcançou o desempenho ideal no desempenho de amostra zero e no desempenho de ajuste fino supervisionado, provando sua boa capacidade de generalização de tarefas. Essa conquista não apenas demonstra o poderoso desempenho do modelo BGE-VL, mas também fornece novas idéias para futuras pesquisas multimodais.

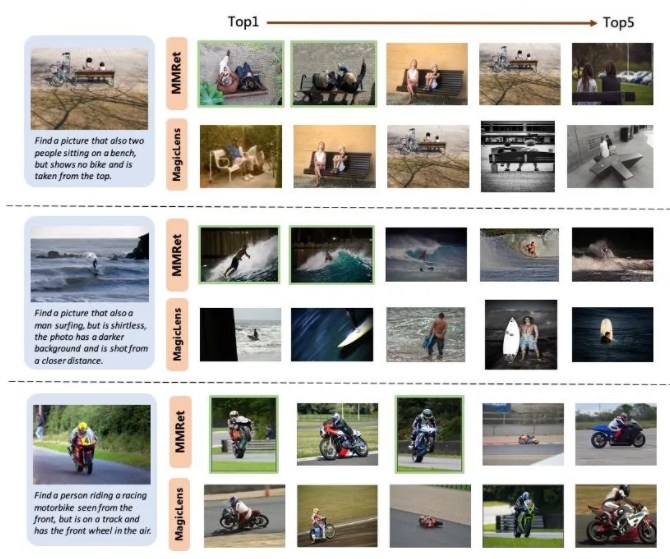

Na tarefa de recuperação de imagem combinada, o BGE-VL atualizou o benchmark existente no conjunto de avaliação da CIRO, superando significativamente as linhas de base de comparação, como a série Magiclens do Google e o MM-Embetbed da NVIDIA. O BGE-VL-MLLM melhora 8,1 pontos percentuais em comparação com o modelo SOTA anterior, enquanto o modelo BGE-VL-BASE supera os retrievers multimodais de outras bases grandes modais com menos de 1/50 dos parâmetros. Esse progresso inovador não apenas demonstra o poderoso desempenho do modelo BGE-VL, mas também fornece novas idéias para futuras pesquisas multimodais.

Além disso, o estudo também mostra que o conjunto de dados Megapairs tem boa escalabilidade e eficiência. À medida que o tamanho dos dados aumenta, o modelo BGE-VL mostra uma tendência consistente de crescimento de desempenho. Comparado com o Google Magiclens, o modelo SOTA treinado em 37 milhões de dados fechados, o Megapairs requer apenas 1/70 da escala de dados (0,5m) para obter vantagens significativas de desempenho. Essa descoberta fornece suporte importante a dados para futuras pesquisas multimodais e também fornece uma nova direção para o desenvolvimento da tecnologia de recuperação multimodal.

Página inicial do projeto:

https://github.com/vectorspacelab/megapairs

Endereço do modelo:

https://huggingface.co/baai/bge-vl-mllm-s1