El 6 de marzo de 2025, el Instituto de Investigación de Inteligencia Artificial de Beijing Zhiyuan anunció el modelo de vector multimodal de código abierto BGE-VL, que es un nuevo avance en el campo de la recuperación multimodal. El modelo BGE-VL ha logrado los mejores resultados en tareas de búsqueda multimodales, como la recuperación gráfica y de texto y la recuperación de imágenes combinadas, lo que ha mejorado significativamente el rendimiento de la búsqueda multimodal. Este avance innovador no solo demuestra la posición principal de China en el campo de la inteligencia artificial, sino que también proporciona una nueva dirección para el desarrollo de la tecnología de recuperación multimodal global.

El desarrollo de BGE-VL se basa en el conjunto de datos sintético a gran escala Megapairs, que extrae eficientemente datos triples multimodales de un corpus gráfico masivo al combinar modelo de representación multimodal, modelo grande multimodal y modelo de lenguaje grande. Este método no solo tiene una excelente escalabilidad, sino que también puede generar continuamente datos diversos y de alta calidad a un costo extremadamente bajo, sino que también mejora en gran medida la calidad de los datos. En comparación con los datos de anotación manual tradicionales, Megapairs solo necesita 1/70 del volumen de datos para lograr mejores resultados de capacitación, lo que proporciona un importante soporte de datos para futuras investigaciones multimodales.

En términos de implementación técnica, la construcción de Megapairs se divide en dos pasos clave: primero, use múltiples modelos de similitud para extraer una variedad de pares de imágenes del conjunto de datos de imágenes; En segundo lugar, use modelos multimodales grandes de código abierto y modelos de idiomas grandes para sintetizar instrucciones de búsqueda de dominio abierto. A través de este enfoque, Megapairs puede conjuntos de datos de instrucciones de búsqueda multimodal basados en escala, de alta calidad y diversos sin participación manual. El lanzamiento de este tiempo cubre 26 millones de muestras, proporcionando un rico soporte de datos para la capacitación de modelos de recuperación multimodal, promoviendo en gran medida el desarrollo de tecnología de recuperación multimodal.

Basado en el conjunto de datos Megapairs, el equipo de Zhiyuan BGE entrenó a tres modelos de recuperación multimodal de diferentes tamaños, incluidos BGE-VL-Base, BGE-VL-Large y BGE-VL-MLLM. Estos modelos muestran un rendimiento líder que supera con creces métodos anteriores en múltiples tareas. En las 36 tareas de evaluación de incrustación multimodal de un punto de referencia de incrustación multimodal masivo (MMEB), BGE-VL logró un rendimiento óptimo en el rendimiento de la muestra cero y el rendimiento supervisado de ajuste fino, lo que demuestra su buena capacidad de generalización de tareas. Este logro no solo demuestra el poderoso desempeño del modelo BGE-VL, sino que también proporciona nuevas ideas para futuras investigaciones multimodales.

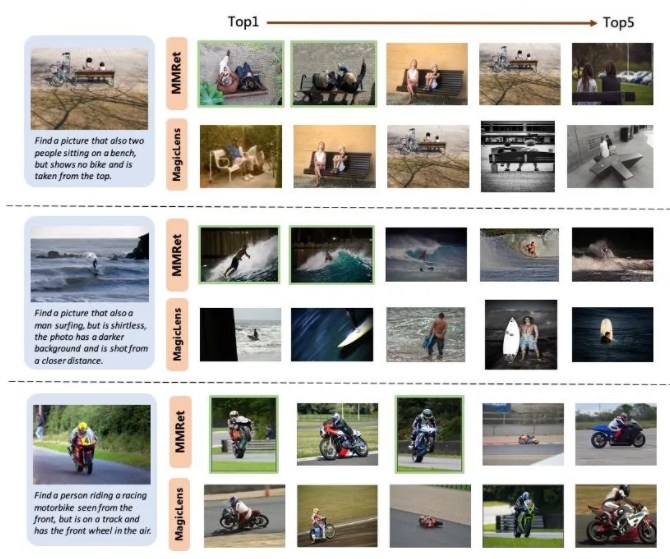

En la tarea combinada de recuperación de imágenes, BGE-VL actualizó el punto de referencia existente en el conjunto de evaluación Circo, superando significativamente las líneas de base de comparación como la serie MagicLens de Google y el MM-Embed de NVIDIA. BGE-VL-MLLM mejora 8.1 puntos porcentuales en comparación con el modelo SOTA anterior, mientras que el modelo BGE-VL-Base supera a los retrievers multimodales de otras bases modales grandes con menos de 1/50 de los parámetros. Este progreso innovador no solo demuestra el poderoso desempeño del modelo BGE-VL, sino que también proporciona nuevas ideas para futuras investigaciones multimodales.

Además, el estudio también muestra que el conjunto de datos Megapairs tiene buena escalabilidad y eficiencia. A medida que aumenta el tamaño de los datos, el modelo BGE-VL muestra una tendencia de crecimiento constante del rendimiento. En comparación con Google Magiclens, el modelo SOTA entrenado en datos de código cerrado de 37 millones, Megapairs solo requiere 1/70 de la escala de datos (0.5m) para lograr ventajas significativas de rendimiento. Este descubrimiento proporciona un importante soporte de datos para futuras investigaciones multimodales y también proporciona una nueva dirección para el desarrollo de tecnología de recuperación multimodal.

Página de inicio del proyecto:

https://github.com/vectorspacelab/megapairs

Dirección del modelo:

https://huggingface.co/baai/bge-vl-mllm-s1