Pada 6 Maret 2025, Beijing Zhiyuan Buatan Intelijen Buatan Institute mengumumkan model vektor multimodal open source BGE-VL, yang merupakan terobosan baru di bidang pengambilan multimodal. Model BGE-VL telah mencapai hasil terbaik dalam tugas pencarian multimodal seperti pengambilan grafik dan teks dan pengambilan gambar gabungan, yang secara signifikan meningkatkan kinerja pencarian multimodal. Kemajuan terobosan ini tidak hanya menunjukkan posisi terdepan China di bidang kecerdasan buatan, tetapi juga memberikan arah baru untuk pengembangan teknologi pengambilan multimodal global.

Pengembangan BGE-VL didasarkan pada dataset sintetis skala besar, yang secara efisien menambang data triple multimodal dari korpus grafis besar dengan menggabungkan model representasi multimodal, model besar multimodal dan model bahasa besar. Metode ini tidak hanya memiliki skalabilitas yang sangat baik, tetapi juga dapat terus menghasilkan data yang beragam dan berkualitas tinggi dengan biaya yang sangat rendah, tetapi juga sangat meningkatkan kualitas data. Dibandingkan dengan data anotasi manual tradisional, megapair hanya membutuhkan 1/70 volume data untuk mencapai hasil pelatihan yang lebih baik, yang memberikan dukungan data penting untuk penelitian multimodal di masa depan.

Dalam hal implementasi teknis, konstruksi megapair dibagi menjadi dua langkah kunci: pertama, gunakan beberapa model kesamaan untuk menambang berbagai pasangan gambar dari dataset gambar; Kedua, gunakan model multimodal open-source dan model bahasa besar untuk mensintesis instruksi pencarian domain terbuka. Melalui pendekatan ini, megapair dapat berbasis skala, berkualitas tinggi dan beragam data instruksi pencarian multimodal tanpa partisipasi manual. Rilis waktu ini mencakup 26 juta sampel, memberikan dukungan data yang kaya untuk pelatihan model pengambilan multimodal, sangat mempromosikan pengembangan teknologi pengambilan multimodal.

Berdasarkan dataset Megapairs, tim Zhiyuan BGE melatih tiga model pengambilan multimodal dengan ukuran yang berbeda, termasuk BGE-VL-BASE, BGE-VL-Large dan BGE-VL-MLLM. Model -model ini menunjukkan kinerja terkemuka yang jauh melebihi metode sebelumnya pada beberapa tugas. Dalam 36 tugas evaluasi embedding multimodal dari benchmark embedding multimodal besar (MMEB), BGE-VL mencapai kinerja optimal dalam kinerja sampel nol dan kinerja penyempurnaan yang diawasi, membuktikan kemampuan generalisasi tugas yang baik. Prestasi ini tidak hanya menunjukkan kinerja yang kuat dari model BGE-VL, tetapi juga memberikan ide-ide baru untuk penelitian multimoda di masa depan.

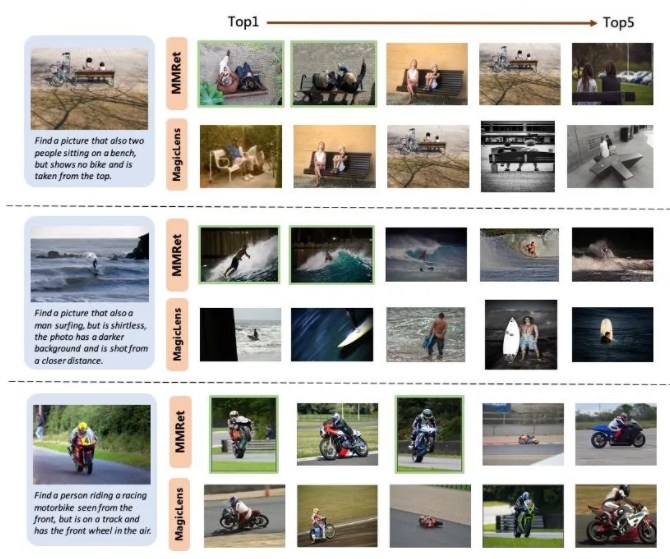

Dalam tugas pengambilan gambar gabungan, BGE-VL menyegarkan tolok ukur yang ada pada set evaluasi Circo, secara signifikan melampaui dasar perbandingan seperti seri Magiclens Google dan Nvidia's Egbed. BGE-VL-MLLM meningkatkan 8,1 poin persentase dibandingkan dengan model SOTA sebelumnya, sedangkan model BGE-VL-base melampaui pengambil multimodal dari basis modal besar lainnya dengan kurang dari 1/50 parameter. Kemajuan terobosan ini tidak hanya menunjukkan kinerja yang kuat dari model BGE-VL, tetapi juga memberikan ide-ide baru untuk penelitian multimodal di masa depan.

Selain itu, penelitian ini juga menunjukkan bahwa dataset megapair memiliki skalabilitas dan efisiensi yang baik. Dengan meningkatnya ukuran data, model BGE-VL menunjukkan tren pertumbuhan kinerja yang konsisten. Dibandingkan dengan Google Magiclens, model SOTA yang dilatih pada data sumber tertutup 37m, megapair hanya membutuhkan 1/70 skala data (0,5m) untuk mencapai keunggulan kinerja yang signifikan. Penemuan ini memberikan dukungan data penting untuk penelitian multimodal di masa depan dan juga memberikan arah baru untuk pengembangan teknologi pengambilan multimodal.

Beranda Proyek:

https://github.com/vectorspacelab/megapairs

Alamat model:

https://huggingface.co/baai/bge-vl-mllm-s1