في 6 مارس ، 2025 ، أعلن معهد بكين تشايوان لبحوث الذكاء الاصطناعي النموذج المفتوح المصدر متعدد الوسائط BGE-VL ، وهو اختراق جديد في مجال الاسترجاع متعدد الوسائط. حقق نموذج BGE-VL أفضل النتائج في مهام البحث متعددة الوسائط مثل استرجاع الرسوم واسترجاع النص واسترجاع الصورة ، مما أدى إلى تحسين أداء البحث متعدد الوسائط بشكل كبير. لا يوضح هذا التقدم الذي تقدمه هذا التقدم في مجال الصين الرائد في مجال الذكاء الاصطناعي فحسب ، بل يوفر أيضًا اتجاهًا جديدًا لتطوير تكنولوجيا استرجاع متعددة الوسائط العالمية.

يعتمد تطوير BGE-VL على مجموعة بيانات البيانات الاصطناعية على نطاق واسع ، والتي تقوم بفعالية بيانات ثلاثية الوسائط متعددة الوسائط من مجموعة رسومية ضخمة من خلال الجمع بين نموذج التمثيل متعدد الوسائط ونموذج كبير متعدد الوسائط ونموذج لغة كبير. لا تحتوي هذه الطريقة على قابلية التوسع الممتازة فحسب ، بل يمكنها أيضًا توليد بيانات متنوعة وعالية الجودة بتكلفة منخفضة للغاية ، ولكنها تعمل أيضًا على تحسين جودة البيانات بشكل كبير. مقارنةً ببيانات التعليقات اليدوية التقليدية ، تحتاج Megapairs فقط إلى 1/70 من حجم البيانات لتحقيق نتائج تدريب أفضل ، والتي توفر دعم بيانات مهم للبحوث المتعددة الوسائط المستقبلية.

فيما يتعلق بالتنفيذ الفني ، يتم تقسيم بناء Megapairs إلى خطوتين رئيسيتين: أولاً ، استخدم نماذج تشابه متعددة لتناول مجموعة متنوعة من أزواج الصور من مجموعة بيانات الصور ؛ ثانياً ، استخدم نماذج كبيرة متعددة الوسائط مفتوحة المصدر ونماذج لغة كبيرة لتوليف تعليمات البحث عن المجال المفتوح. من خلال هذا النهج ، يمكن لضخامة الميغابر أن تتوسع ، وعالي الجودة ومتنوعة مجموعات تعليمات البحث متعددة الوسائط دون مشاركة يدوية. يغطي إصدار هذا الوقت 26 مليون عينة ، مما يوفر دعمًا للبيانات الغنية لتدريب نماذج الاسترجاع متعددة الوسائط ، مما يعزز بشكل كبير تطوير تكنولوجيا الاسترجاع متعددة الوسائط.

استنادًا إلى مجموعة بيانات Megapairs ، قام فريق Zhiyuan BGE بتدريب ثلاثة نماذج استرجاع متعددة الوسائط بأحجام مختلفة ، بما في ذلك BGE-VL-Base و BGE-VL-LARGE و BGE-VL-MLLM. تُظهر هذه النماذج الأداء الرائد الذي يتجاوز بكثير الطرق السابقة في مهام متعددة. في 36 مهام تقييم التضمين متعددة الوسائط لمعايير التضمين المتعددة الوسائط الضخمة (MMEB) ، حققت BGE-VL الأداء الأمثل في كل من الأداء صفريًا وأداء صياغة خاضع للإشراف ، مما يثبت قدرته على تعميم المهمة الجيدة. لا يوضح هذا الإنجاز الأداء القوي لنموذج BGE-VL فحسب ، بل يوفر أيضًا أفكارًا جديدة للبحوث متعددة الوسائط المستقبلية.

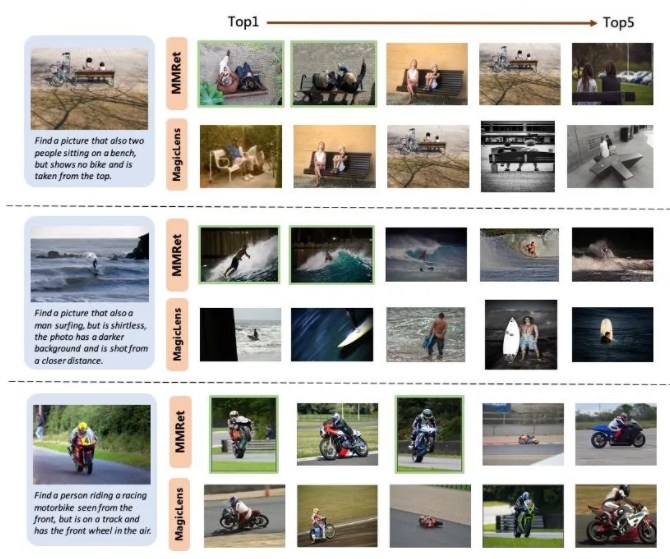

في مهمة استرجاع الصور المشتركة ، قام BGE-VL بتحديث المعيار الحالي على مجموعة تقييم Circo ، متجاوزًا بشكل كبير خطوط الأساس المقارنة مثل سلسلة Magiclens من Google و NVIDIA MM. يحسن BGE-VL-MLLM 8.1 نقاط مئوية مقارنة بنموذج SOTA السابق ، في حين يتجاوز نموذج BGE-VL-Base المسترجعين متعدد الوسائط لقواعد أخرى كبيرة مودعة مع أقل من 1/50 من المعلمات. لا يوضح هذا التقدم الذي تقدمه هذا التقدم الأداء القوي لنموذج BGE-VL فحسب ، بل يوفر أيضًا أفكارًا جديدة للبحوث متعددة الوسائط المستقبلية.

بالإضافة إلى ذلك ، توضح الدراسة أيضًا أن مجموعة بيانات Megapairs لديها قابلية التوسع والكفاءة الجيدة. مع زيادة حجم البيانات ، يعرض نموذج BGE-VL اتجاه نمو ثابت للأداء. بالمقارنة مع Google Magiclens ، تم تدريب نموذج SOTA على بيانات المصدر المغلقة 37M ، لا تتطلب Megapairs سوى 1/70 من مقياس البيانات (0.5M) لتحقيق مزايا أداء مهمة. يوفر هذا الاكتشاف دعمًا مهمًا للبيانات للبحوث المتعددة الوسائط المستقبلية ويوفر أيضًا اتجاهًا جديدًا لتطوير تقنية استرجاع متعددة الوسائط.

الصفحة الرئيسية للمشروع:

https://github.com/vectorspacelab/megapairs

عنوان النموذج:

https://huggingface.co/baai/bge-vl-mllm-s1