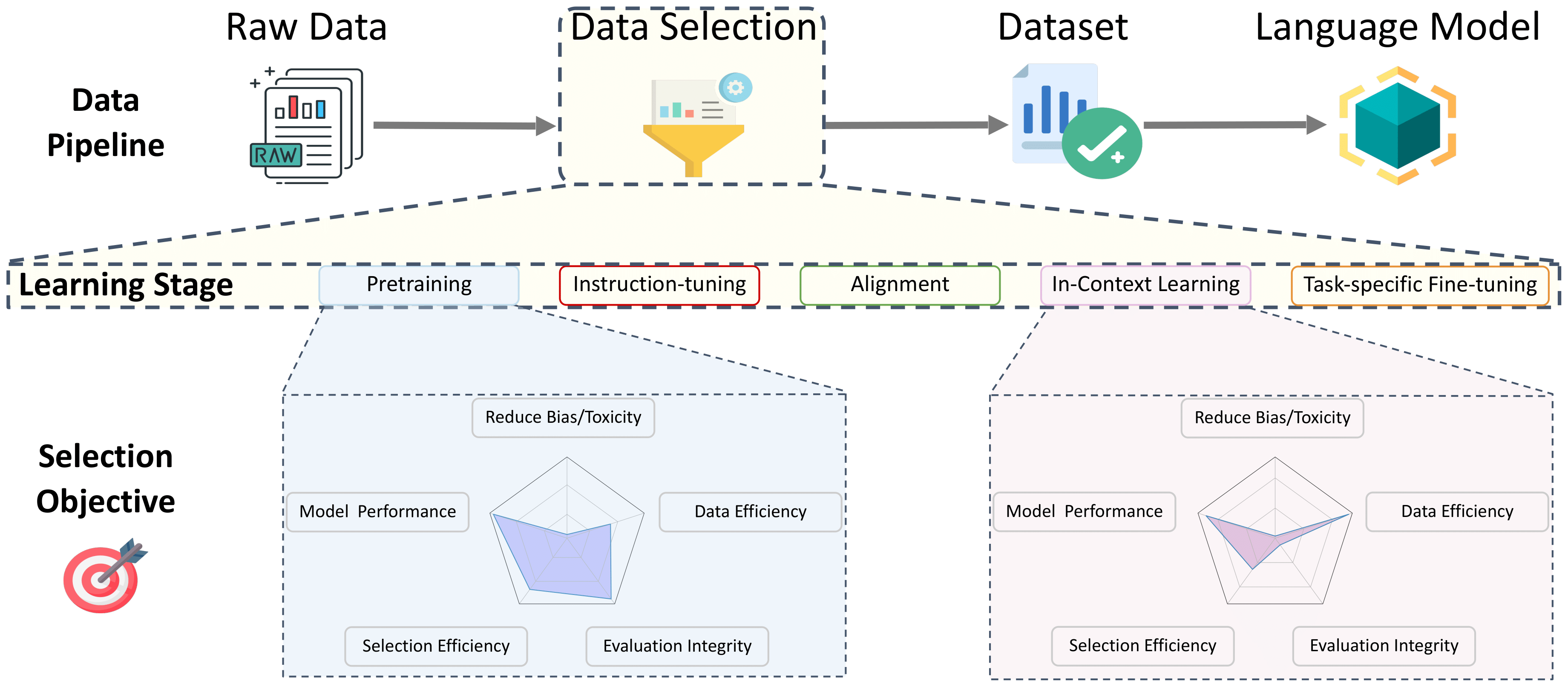

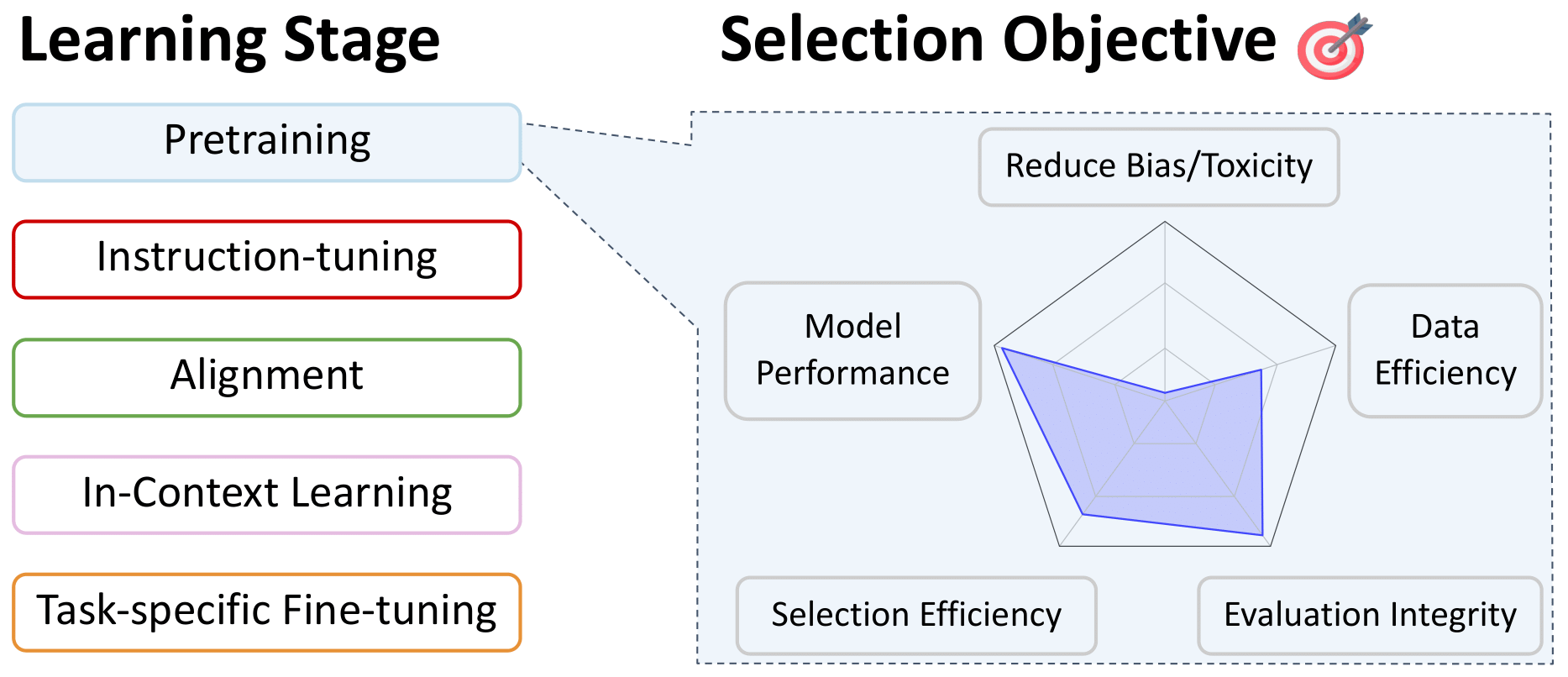

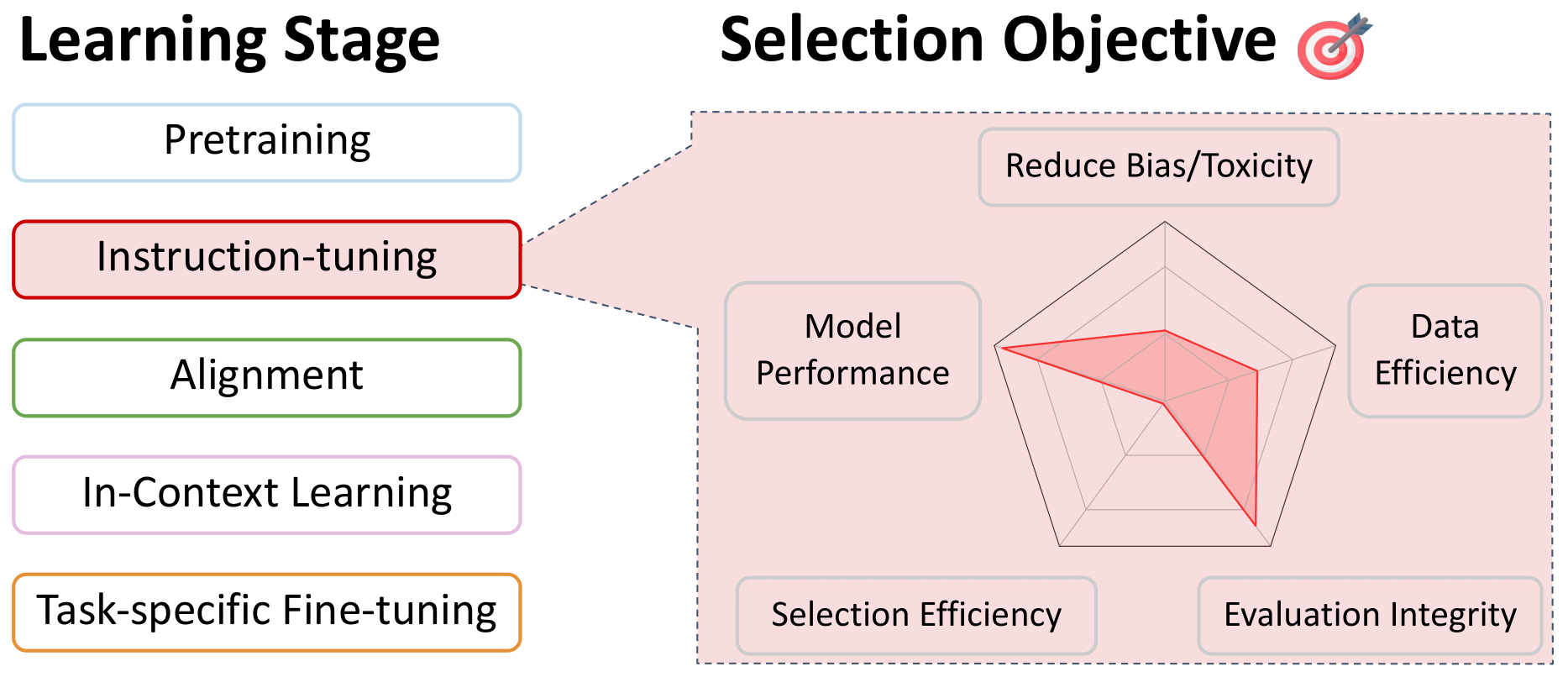

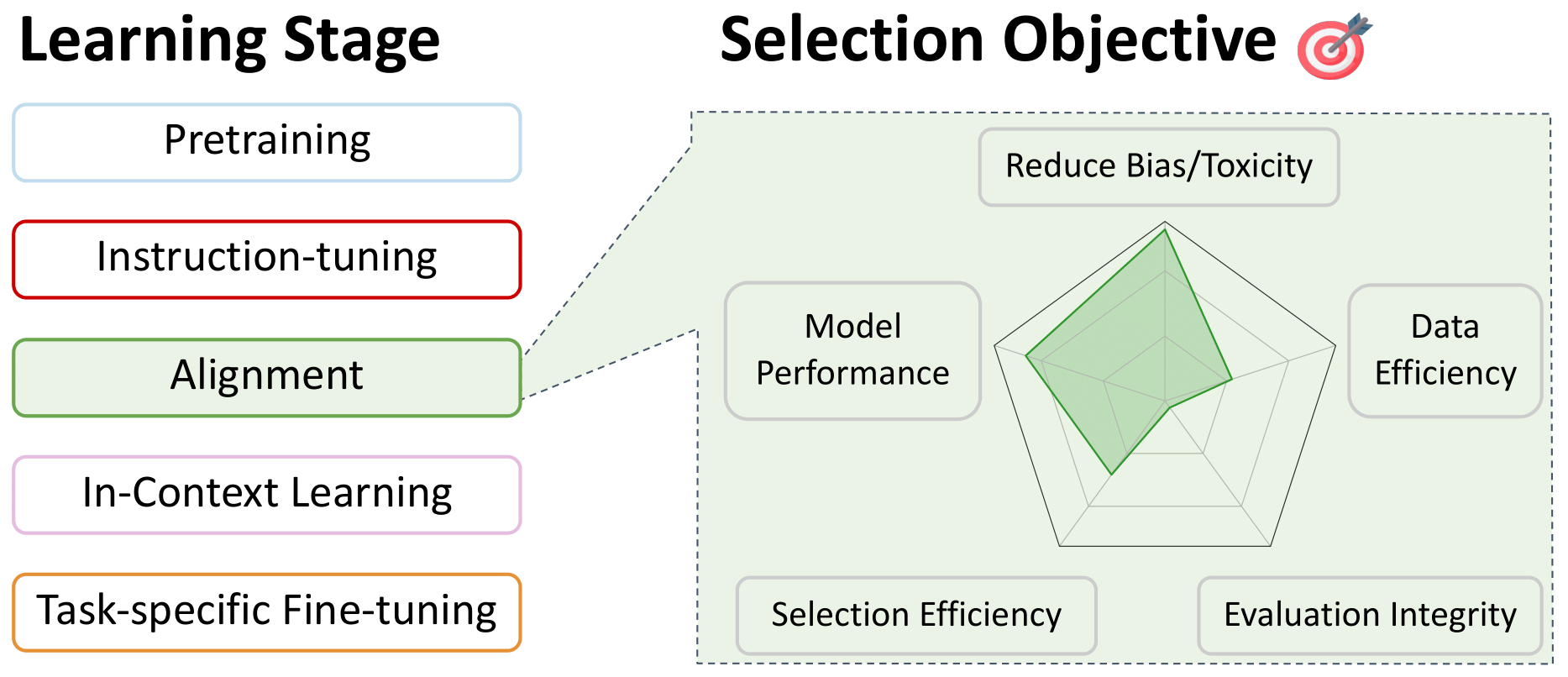

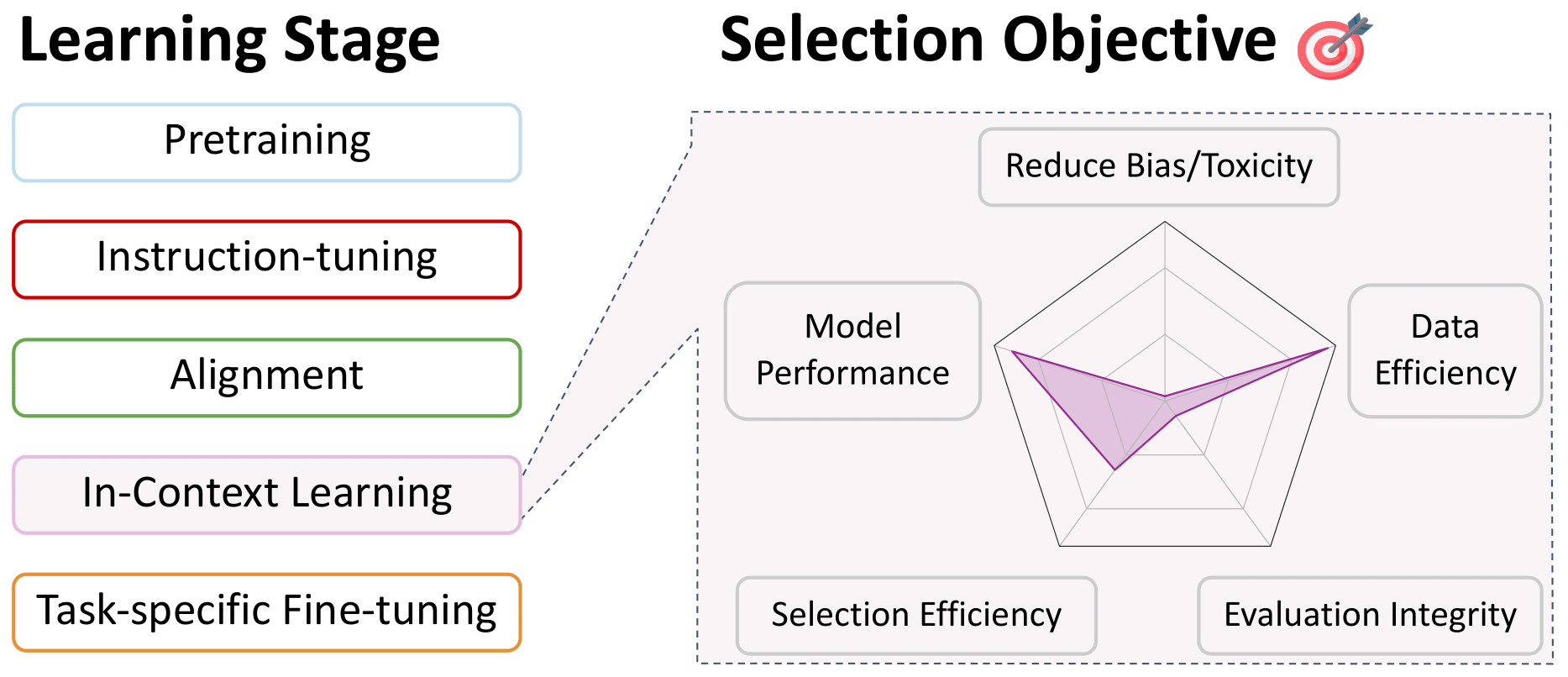

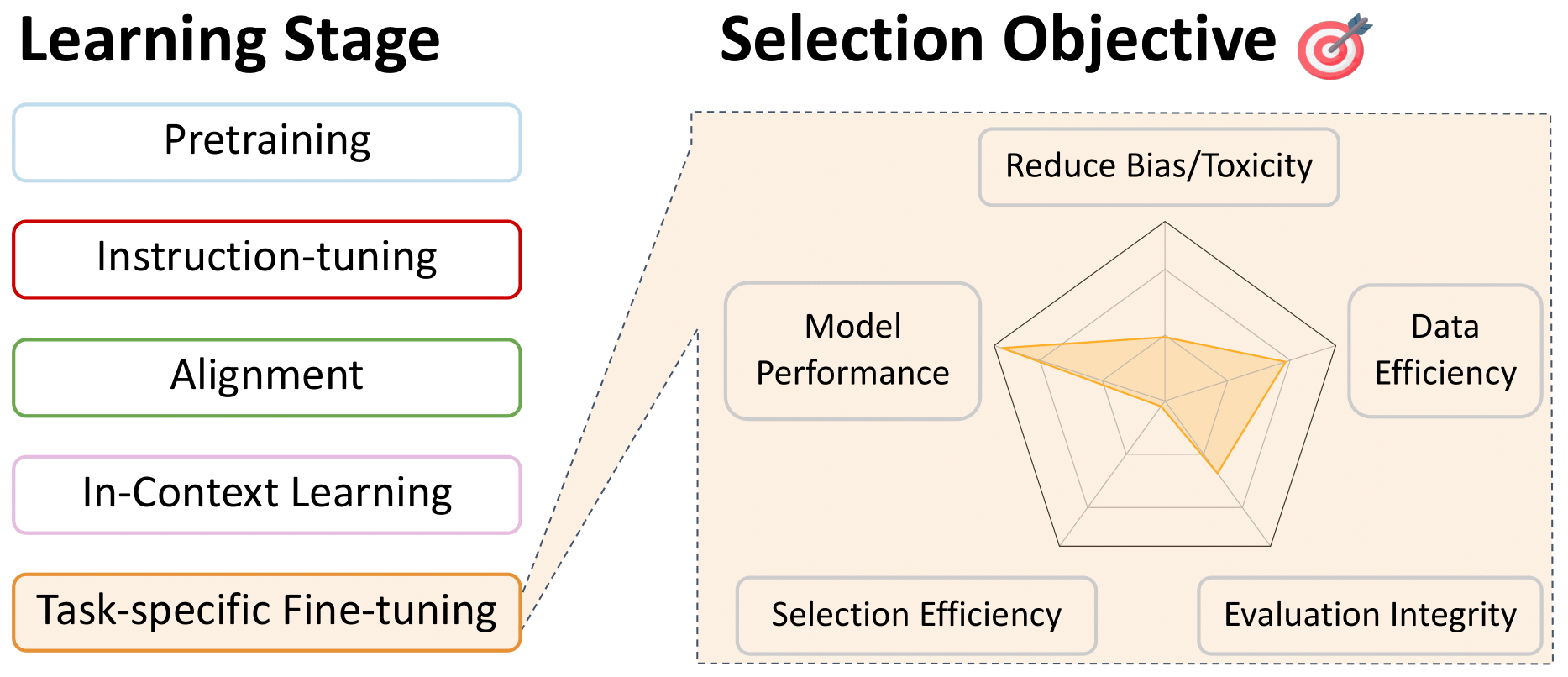

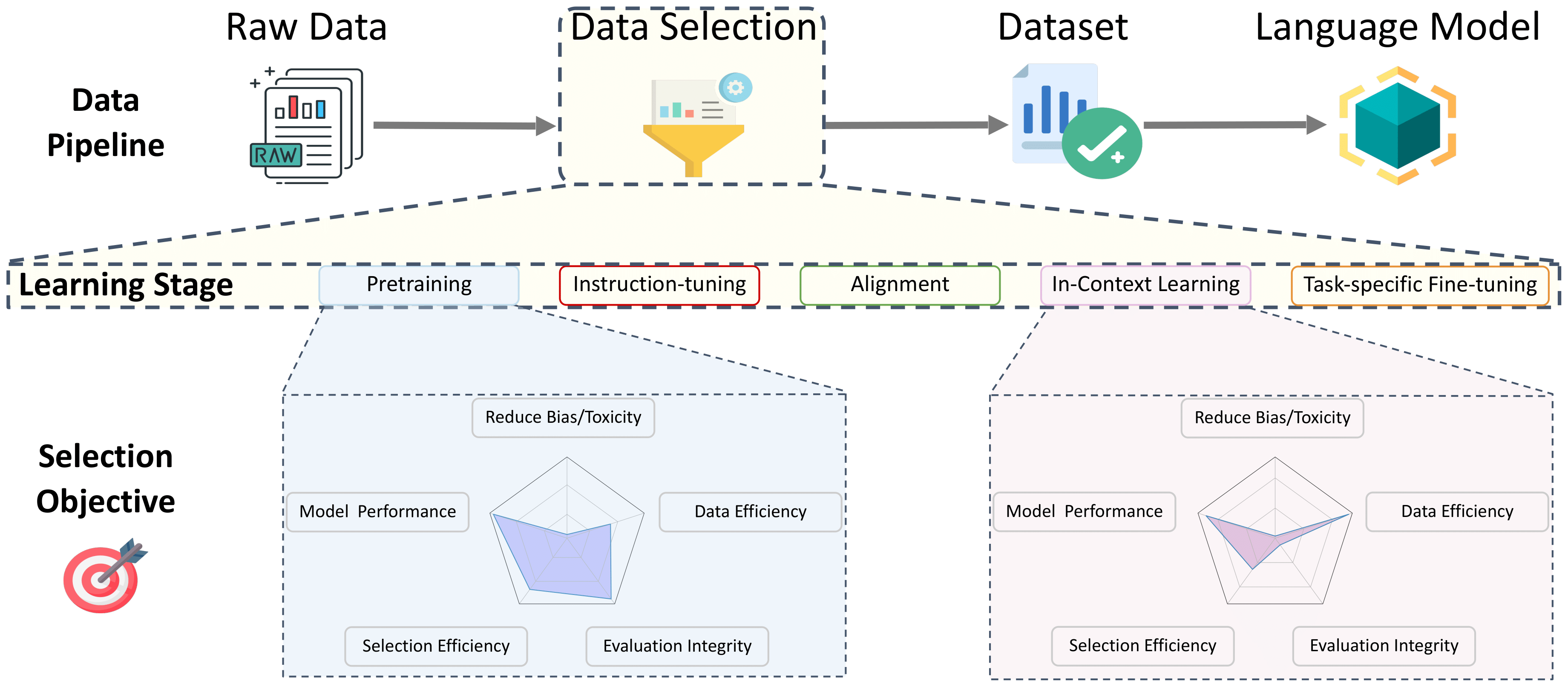

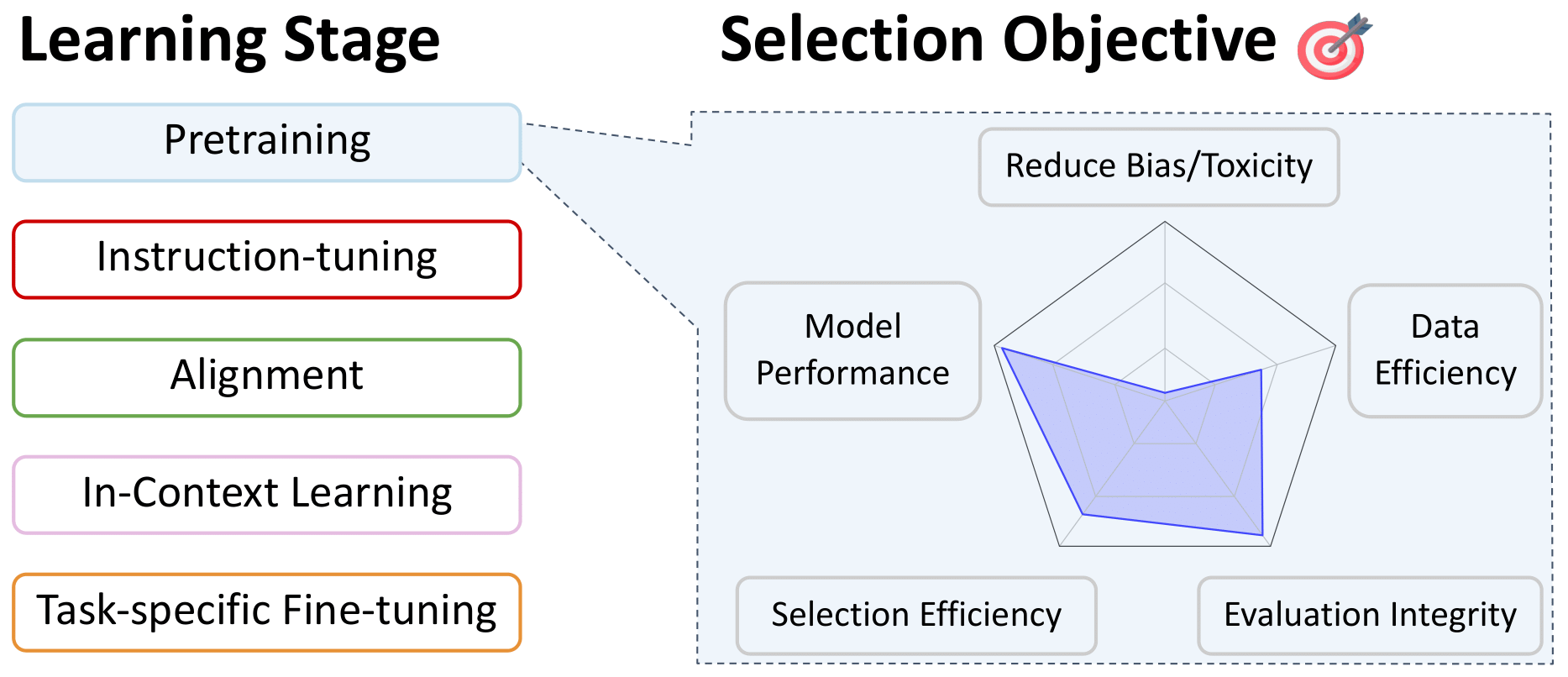

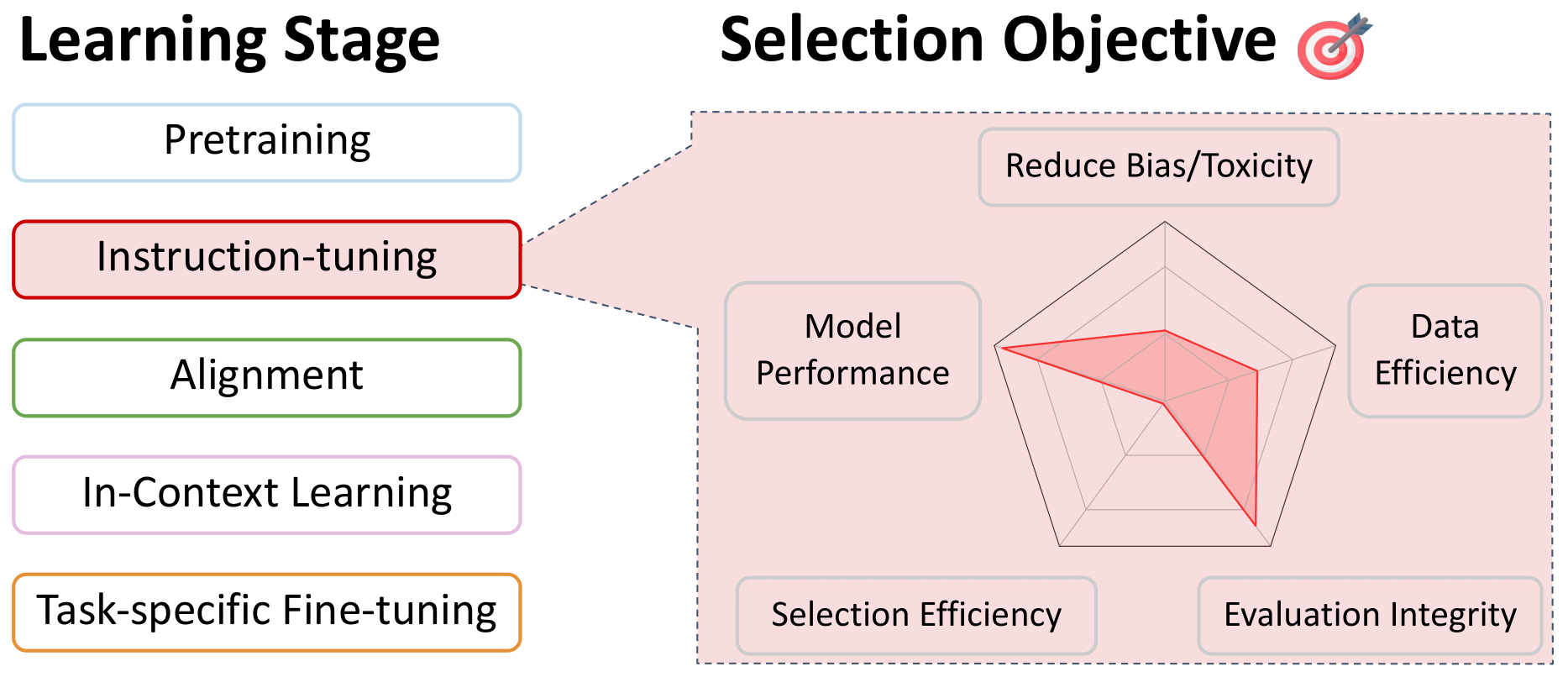

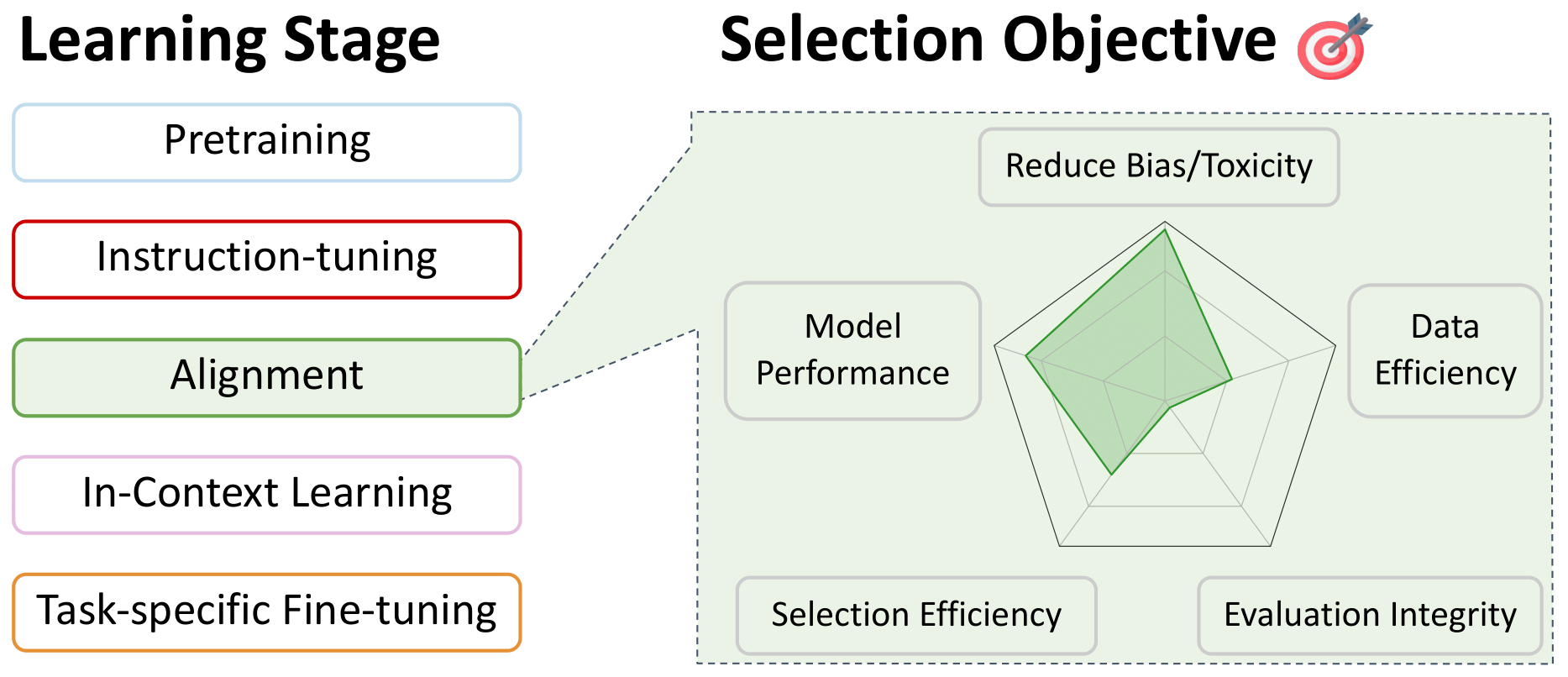

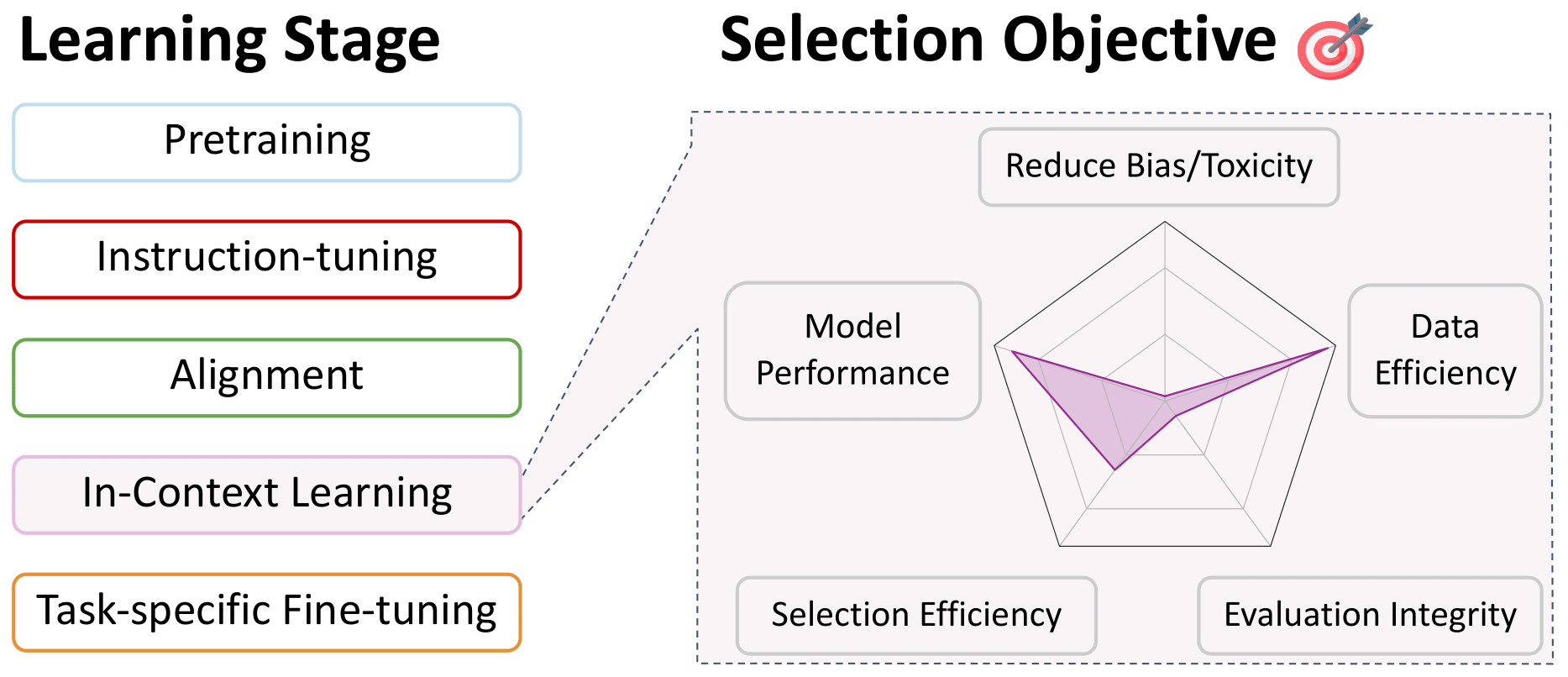

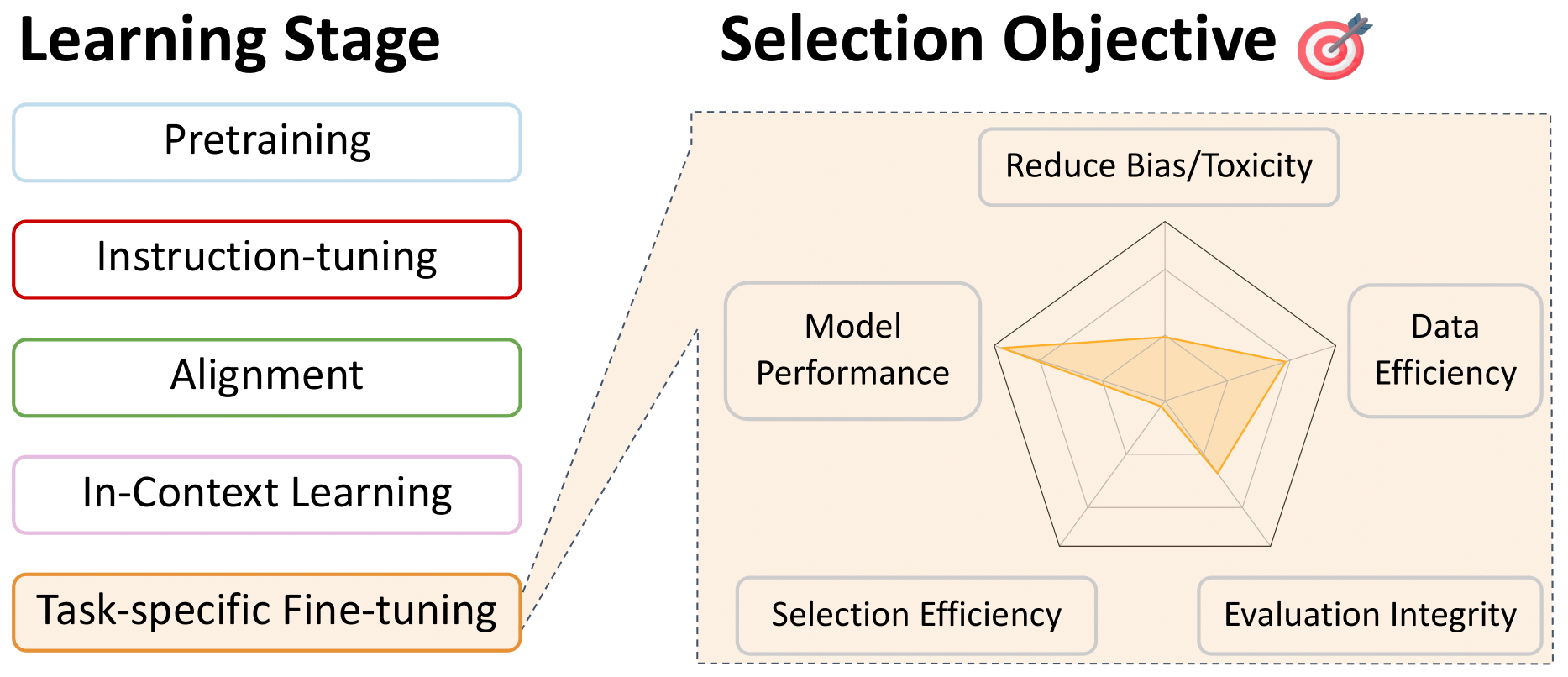

การสำรวจการเลือกข้อมูลสำหรับแบบจำลองภาษา

repo นี้เป็นรายการเอกสารที่สะดวกที่เกี่ยวข้องกับการเลือกข้อมูลสำหรับแบบจำลองภาษาในทุกขั้นตอนของการฝึกอบรม นี่คือทรัพยากรสำหรับชุมชนดังนั้นโปรดมีส่วนร่วมหากคุณเห็นสิ่งใดขาดหายไป!

สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับงานเหล่านี้และอื่น ๆ ดูรายงานการสำรวจของเรา: การสำรวจการเลือกข้อมูลสำหรับแบบจำลองภาษา โดยทีมงานที่น่าทึ่งนี้: Alon Albalak, Yanai Elazar, ร้องเพลง Michael Xie, Shayne Longpre, Nathan Lambert, Xinyi Wang, Niklas Muennighoff, Bairu Hou, Liangming Pan, Haewon Jeong, Colin Raffel, Shiyu Chang

สารบัญ

- การเลือกข้อมูลสำหรับการเตรียมการก่อน

- การกรองภาษา

- วิธีการแก้ปัญหา

- คุณภาพข้อมูล

- การเลือกเฉพาะโดเมน

- ข้อมูลซ้ำซ้อน

- การกรองเนื้อหาที่เป็นพิษและชัดเจน

- ตัวเลือกเฉพาะสำหรับรุ่นหลายภาษา

- การผสมข้อมูล

- การเลือกข้อมูลสำหรับการปรับแต่งคำสั่งและการฝึกอบรมมัลติทาสก์

- การเลือกข้อมูลสำหรับการจัดตำแหน่งปรับแต่งการปรับแต่ง

- การเลือกข้อมูลสำหรับการเรียนรู้ในบริบท

- การเลือกข้อมูลสำหรับการปรับแต่งเฉพาะงาน

การเลือกข้อมูลสำหรับการเตรียมการก่อน

การกรองภาษา

กลับไปที่สารบัญ

- FastText.zip: การบีบอัดโมเดลการจำแนกข้อความ: 2016

Armand Joulin และ Edouard Grave และ Piotr Bojanowski และ Matthijs Douze และHérveJégouและ Tomas Mikolov

- เรียนรู้คำศัพท์สำหรับ 157 ภาษา: 2018

Grave, Edouard และ Bojanowski, Piotr และ Gupta, Prakhar และ Joulin, Armand และ Mikolov, Tomas

- รูปแบบภาษาแบบข้ามภาษา Pretraining: 2019

Conneau, Alexis และ Lample, Guillaume

- การสำรวจขีด จำกัด ของการเรียนรู้การถ่ายโอนด้วยหม้อแปลงข้อความแบบรวมเป็นข้อความ: 2020

Raffel, Colin และ Shazeer, Noam และ Roberts, Adam ... 3 ซ่อน ... Zhou, Yanqi และ Li, Wei และ Liu, Peter J.

- ID ภาษาใน Wild: ความท้าทายที่ไม่คาดคิดบนเส้นทางไปยัง Web Text Corpus: 2020

Caswell, Isaac และ Breiner, Theresa และ Van Esch, Daan และ Bapna, Ankur

- การเรียนรู้การเป็นตัวแทนข้ามภาษาที่ไม่ได้รับการดูแลในระดับ: 2020

Conneau, Alexis และ Khandelwal, Kartikay และ Goyal, Naman ... 4 ซ่อน ... Ott, Myle และ Zettlemoyer, Luke และ Stoyanov, Veselin

- CCNET: การแยกชุดข้อมูล monolingual คุณภาพสูงจากข้อมูลการรวบรวมข้อมูลเว็บ: 2020

Wenzek, Guillaume และ Lachaux, Marie-Anne และ Conneau, Alexis ... 1 ซ่อน ... Guzm'an, Francisco และ Joulin, Armand และ Grave, Edouard

- การทำซ้ำโมเดล LSTM สองทิศทางของ Apple สำหรับการระบุภาษาในสายสั้น: 2021

Toftrup, Mads และ Asger Sorensen, Soren และ Ciosici, Manuel R. และ Assent, IRA

- การประเมินแบบจำลองภาษาขนาดใหญ่ที่ผ่านการฝึกอบรมเกี่ยวกับรหัส: 2021

Mark Chen และ Jerry Tworek และ Heewoo Jun ... 52 Hidden ... Sam McCandlish และ Ilya Sutskever และ Wojciech Zaremba

- MT5: Transformer ข้อความที่ได้รับการฝึกฝนมาหลายภาษาหลายภาษา: 2021

Xue, ผ้าสำลีและคงที่, โนอาห์และโรเบิร์ต, อดัม ... 2 ซ่อน ... Siddhant, Aditya และ Barua, Aditya และ Raffel, Colin

- การสร้างรหัสระดับการแข่งขันด้วย Alphacode: 2022

Li, Yujia และ Choi, David and Chung, Junyoung ... 20 ซ่อน ... de Freitas, Nando และ Kavukcuoglu, Koray และ Vinyals, Oriol

- Palm: การปรับขนาดภาษาแบบปรับขนาดด้วยเส้นทาง: 2022

Aakanksha Chowdhery และ Sharan Narang และ Jacob Devlin ... 61 Hidden ... Jeff Dean และ Slav Petrov และ Noah Fiedel

- BigScience Roots Corpus: ชุดข้อมูลหลายภาษาคอมโพสิต 1.6TB: 2022

Laurenccon, Hugo และ Saulnier, Lucile และ Wang, Thomas ... 48 Hidden ... Mitchell, Margaret และ Luccioni, Sasha Alexandra และ Jernite, Yacine

- ระบบการเขียนและข้อมูลเมตาของลำโพงสำหรับภาษา 2,800+ ภาษา: 2022

Van Esch, Daan และ Lucassen, Tamar และ Ruder, Sebastian และ Caswell, Isaac และ Rivera, Clara

- Fingpt: รุ่น Generative ขนาดใหญ่สำหรับภาษาขนาดเล็ก: 2023

Luukkonen, Risto และ Komulainen, Ville และ Luoma, Jouni ... 5 ซ่อน ... Muennighoff, Niklas และ Piktus, Aleksandra และอื่น ๆ

- MC^ 2: คลังภาษาหลายภาษาของภาษาชนกลุ่มน้อยในประเทศจีน: 2023

จาง, เฉินและเต่า, Mingxu และ Huang, Quzhe และ Lin, Jiuheng และ Chen, Zhibin และ Feng, Yansong

- MADLAD-400: ชุดข้อมูลที่ตรวจสอบได้หลายภาษาและระดับเอกสาร: 2023

Kudugunta, Sneha และ Caswell, Isaac และ Zhang, Biao ... 5 ซ่อน ... Stella, Romi และ Bapna, Ankur และอื่น ๆ

- ชุดข้อมูล RefinedWeb สำหรับ Falcon LLM: มีประสิทธิภาพสูงกว่า Corated Corpora ด้วยข้อมูลเว็บและข้อมูลเว็บเท่านั้น: 2023

Guilherme Penedo และ Quentin Malartic และ Daniel Hesslow ... 3 ซ่อน ... Pannier Baptiste และ Ebtesam Almazrouei และ Julien Launay

- Dolma: คลังข้อมูลเปิดของสามล้านล้านโทเค็นสำหรับรูปแบบภาษาการวิจัยก่อนการวิจัย: 2024

Luca Soldaini และ Rodney Kinney และ Akshita Bhagia ... 30 ซ่อน ... Dirk Groeneveld และ Jesse Dodge และ Kyle Lo

วิธีการแก้ปัญหา

กลับไปที่สารบัญ

- การสำรวจขีด จำกัด ของการเรียนรู้การถ่ายโอนด้วยหม้อแปลงข้อความแบบรวมเป็นข้อความ: 2020

Raffel, Colin และ Shazeer, Noam และ Roberts, Adam ... 3 ซ่อน ... Zhou, Yanqi และ Li, Wei และ Liu, Peter J.

- แบบจำลองภาษาเป็นผู้เรียนไม่กี่คน: 2020

Brown, Tom and Mann, Benjamin และ Ryder, Nick ... 25 Hidden ... Radford, Alec และ Sutskever, Ilya และ Amodei, Dario

- กอง: ชุดข้อมูล 800GB ของข้อความที่หลากหลายสำหรับการสร้างแบบจำลองภาษา: 2020

Leo Gao และ Stella Biderman และ Sid Black ... 6 ซ่อน ... Noa Nabeshima และ Shawn Presser และ Connor Leahy

- การประเมินแบบจำลองภาษาขนาดใหญ่ที่ผ่านการฝึกอบรมเกี่ยวกับรหัส: 2021

Mark Chen และ Jerry Tworek และ Heewoo Jun ... 52 Hidden ... Sam McCandlish และ Ilya Sutskever และ Wojciech Zaremba

- MT5: Transformer ข้อความที่ได้รับการฝึกฝนมาหลายภาษาหลายภาษา: 2021

Xue, ผ้าสำลีและคงที่, โนอาห์และโรเบิร์ต, อดัม ... 2 ซ่อน ... Siddhant, Aditya และ Barua, Aditya และ Raffel, Colin

- แบบจำลองภาษาขนาด: วิธีการวิเคราะห์และข้อมูลเชิงลึกจากการฝึกอบรม Gopher: 2022

Jack W. Rae และ Sebastian Borgeaud และ Trevor Cai ... 74 Hidden ... Demis Hassabis และ Koray Kavukcuoglu และ Geoffrey Irving

- BigScience Roots Corpus: ชุดข้อมูลหลายภาษาคอมโพสิต 1.6TB: 2022

Laurenccon, Hugo และ Saulnier, Lucile และ Wang, Thomas ... 48 Hidden ... Mitchell, Margaret และ Luccioni, Sasha Alexandra และ Jernite, Yacine

- HTLM: การฝึกอบรมก่อนการฝึกอบรมและการแจ้งเตือนของโมเดลภาษา: 2022

Armen Aghajanyan และ Dmytro Okhonko และ Mike Lewis ... 1 ซ่อน ... Hu Xu และ Gargi Ghosh และ Luke Zettlemoyer

- LLAMA: แบบเปิดและมีประสิทธิภาพแบบจำลองภาษาพื้นฐาน: 2023

Hugo Touvron และ Thibaut Lavril และ Gautier Izacard ... 8 ซ่อน ... Armand Joulin และ Edouard Grave และ Guillaume Lample

- ชุดข้อมูล RefinedWeb สำหรับ Falcon LLM: มีประสิทธิภาพสูงกว่า Corated Corpora ด้วยข้อมูลเว็บและข้อมูลเว็บเท่านั้น: 2023

Guilherme Penedo และ Quentin Malartic และ Daniel Hesslow ... 3 ซ่อน ... Pannier Baptiste และ Ebtesam Almazrouei และ Julien Launay

- ดัชนีความโปร่งใสแบบจำลองพื้นฐาน: 2023

Bommasani, Rishi และ Klyman, Kevin และ Longpre, Shayne ... 2 ซ่อน ... Xiong, Betty และ Zhang, Daniel และ Liang, Percy

- Dolma: คลังข้อมูลเปิดของสามล้านล้านโทเค็นสำหรับรูปแบบภาษาการวิจัยก่อนการวิจัย: 2024

Luca Soldaini และ Rodney Kinney และ Akshita Bhagia ... 30 ซ่อน ... Dirk Groeneveld และ Jesse Dodge และ Kyle Lo

คุณภาพข้อมูล

กลับไปที่สารบัญ

- Kenlm: แบบจำลองโมเดลภาษาที่เร็วขึ้นและเล็กลง: 2011

Heafield, Kenneth

- FastText.zip: การบีบอัดโมเดลการจำแนกข้อความ: 2016

Armand Joulin และ Edouard Grave และ Piotr Bojanowski และ Matthijs Douze และHérveJégouและ Tomas Mikolov

- เรียนรู้คำศัพท์สำหรับ 157 ภาษา: 2018

Grave, Edouard และ Bojanowski, Piotr และ Gupta, Prakhar และ Joulin, Armand และ Mikolov, Tomas

- แบบจำลองภาษาเป็นผู้เรียนมัลติทาสก์ที่ไม่ได้รับการดูแล: 2019

Alec Radford และ Jeff Wu และ Rewon Child และ David Luan และ Dario Amodei และ Ilya Sutskever

- แบบจำลองภาษาเป็นผู้เรียนไม่กี่คน: 2020

Brown, Tom and Mann, Benjamin และ Ryder, Nick ... 25 Hidden ... Radford, Alec และ Sutskever, Ilya และ Amodei, Dario

- กอง: ชุดข้อมูล 800GB ของข้อความที่หลากหลายสำหรับการสร้างแบบจำลองภาษา: 2020

Leo Gao และ Stella Biderman และ Sid Black ... 6 ซ่อน ... Noa Nabeshima และ Shawn Presser และ Connor Leahy

- CCNET: การแยกชุดข้อมูล monolingual คุณภาพสูงจากข้อมูลการรวบรวมข้อมูลเว็บ: 2020

Wenzek, Guillaume และ Lachaux, Marie-Anne และ Conneau, Alexis ... 1 ซ่อน ... Guzm'an, Francisco และ Joulin, Armand และ Grave, Edouard

- แบบจำลองภาษาล้างพิษมีความเสี่ยงต่อเสียงของชนกลุ่มน้อย: 2021

Xu, Albert และ Pathak, Eshaan และ Wallace, Eric และ Gururangan, Suchin และ Sap, Maarten และ Klein, Dan

- Palm: การปรับขนาดภาษาแบบปรับขนาดด้วยเส้นทาง: 2022

Aakanksha Chowdhery และ Sharan Narang และ Jacob Devlin ... 61 Hidden ... Jeff Dean และ Slav Petrov และ Noah Fiedel

- แบบจำลองภาษาขนาด: วิธีการวิเคราะห์และข้อมูลเชิงลึกจากการฝึกอบรม Gopher: 2022

Jack W. Rae และ Sebastian Borgeaud และ Trevor Cai ... 74 Hidden ... Demis Hassabis และ Koray Kavukcuoglu และ Geoffrey Irving

- ภาษาของใครมีคุณภาพสูง? การวัดอุดมการณ์ภาษาในการเลือกข้อมูลข้อความ: 2022

Gururangan, Suchin และ Card, Dallas และ Dreier, Sarah ... 2 ซ่อน ... Wang, Zeyu และ Zettlemoyer, Luke และ Smith, Noah A.

- Glam: การปรับขนาดของแบบจำลองภาษาที่มีประสิทธิภาพด้วยส่วนผสมของ experts: 2022

Du, Nan และ Huang, Yanping และ Dai, Andrew M ... 21 ซ่อน ... Wu, Yonghui และ Chen, Zhifeng และ Cui, Claire

- คู่มือการฝึกอบรมเกี่ยวกับข้อมูลการฝึกอบรม: การวัดผลกระทบของอายุข้อมูลการครอบคลุมโดเมนคุณภาพและความเป็นพิษ: 2023

Shayne Longpre และ Gregory Yauney และ Emily Reif ... 5 ซ่อน ... Kevin Robinson และ David Mimno และ Daphne Ippolito

- การเลือกข้อมูลสำหรับแบบจำลองภาษาผ่านการสุ่มตัวอย่างที่สำคัญ: 2023

ร้องเพลง Michael Xie และ Shibani Santurkar และ Tengyu Ma และ Percy Liang

- ชุดข้อมูล RefinedWeb สำหรับ Falcon LLM: มีประสิทธิภาพสูงกว่า Corated Corpora ด้วยข้อมูลเว็บและข้อมูลเว็บเท่านั้น: 2023

Guilherme Penedo และ Quentin Malartic และ Daniel Hesslow ... 3 ซ่อน ... Pannier Baptiste และ Ebtesam Almazrouei และ Julien Launay

- Dolma: คลังข้อมูลเปิดของสามล้านล้านโทเค็นสำหรับรูปแบบภาษาการวิจัยก่อนการวิจัย: 2024

Luca Soldaini และ Rodney Kinney และ Akshita Bhagia ... 30 ซ่อน ... Dirk Groeneveld และ Jesse Dodge และ Kyle Lo

- การเขียนโปรแกรมทุกตัวอย่าง: การยกคุณภาพข้อมูลการฝึกอบรมล่วงหน้าเช่นผู้เชี่ยวชาญในระดับ: 2024

Fan Zhou และ Zengzhi Wang และ Qian Liu และ Junlong Li และ Pengfei Liu

การเลือกเฉพาะโดเมน

กลับไปที่สารบัญ

- การเก็บข้อมูลข้อความสำหรับแบบจำลองภาษาเฉพาะโดเมน: 2006

Sethy, Abhinav และ Georgiou, Panayiotis G. และ Narayanan, Shrikanth

- ข้อมูลการฝึกอบรมแบบจำลองภาษาอัจฉริยะ: 2010

มัวร์โรเบิร์ตซีและลูอิสวิลเลียม

- ข้อมูลการฝึกอบรมรูปแบบภาษาที่เหยียดหยาม: 2017

Amittai Axelrod

- การเลือกเอกสารอัตโนมัติสำหรับการเตรียมเครื่องเข้ารหัสที่มีประสิทธิภาพ: 2022

Feng, Yukun และ Xia, Patrick และ Van Durme, Benjamin และ Sedoc, Jo ~ ao

- การเลือกข้อมูลสำหรับแบบจำลองภาษาผ่านการสุ่มตัวอย่างที่สำคัญ: 2023

ร้องเพลง Michael Xie และ Shibani Santurkar และ Tengyu Ma และ Percy Liang

- DSDM: การเลือกชุดข้อมูลที่รับรู้แบบจำลองด้วย DataModels: 2024

Logan Engstrom และ Axel Feldmann และ Aleksander Madry

ข้อมูลซ้ำซ้อน

กลับไปที่สารบัญ

- การแลกเปลี่ยนพื้นที่/เวลาในการเข้ารหัสแฮชที่มีข้อผิดพลาดที่อนุญาต: 1970

Bloom, Burton H.

- อาร์เรย์คำต่อท้าย: วิธีใหม่สำหรับการค้นหาสตริงออนไลน์: 1993

Manber, Udi และ Myers, Gene

- เกี่ยวกับความคล้ายคลึงและการบรรจุเอกสาร: 1997

Broder, AZ

- เทคนิคการประมาณความคล้ายคลึงกันจากอัลกอริทึมการปัดเศษ: 2002

Charikar, Moses S.

- การทำให้เป็นมาตรฐาน URL สำหรับการทำซ้ำหน้าเว็บ: 2009

Agarwal, Amit และ Koppula, Hema Swetha และ Leela, Krishna P .... 3 Hidden ... Haty, Chittaranjan และ Roy, Anirban และ Sasturkar, Amit

- ท่อแบบอะซิงโครนัสสำหรับการประมวลผล corpora ขนาดใหญ่บนโครงสร้างพื้นฐานทรัพยากรปานกลางถึงต่ำ: 2019

Pedro Javier Ortiz Su'arez และ Beno^มันเป็น Sagot และ Laurent Romary

- แบบจำลองภาษาเป็นผู้เรียนไม่กี่คน: 2020

Brown, Tom and Mann, Benjamin และ Ryder, Nick ... 25 Hidden ... Radford, Alec และ Sutskever, Ilya และ Amodei, Dario

- กอง: ชุดข้อมูล 800GB ของข้อความที่หลากหลายสำหรับการสร้างแบบจำลองภาษา: 2020

Leo Gao และ Stella Biderman และ Sid Black ... 6 ซ่อน ... Noa Nabeshima และ Shawn Presser และ Connor Leahy

- CCNET: การแยกชุดข้อมูล monolingual คุณภาพสูงจากข้อมูลการรวบรวมข้อมูลเว็บ: 2020

Wenzek, Guillaume และ Lachaux, Marie-Anne และ Conneau, Alexis ... 1 ซ่อน ... Guzm'an, Francisco และ Joulin, Armand และ Grave, Edouard

- นอกเหนือจากกฎหมายการปรับขนาดของระบบประสาท: การเอาชนะการปรับขนาดกฎหมายผ่านการตัดแต่งข้อมูล: 2022

Ben Sorscher และ Robert Geirhos และ Shashank Shekhar และ Surya Ganguli และ Ari S. Morcos

- ข้อมูลการฝึกอบรมซ้ำ ๆ ทำให้แบบจำลองภาษาดีขึ้น: 2022

Lee, Katherine และ Ippolito, Daphne และ Nystrom, Andrew ... 1 ซ่อน ... Eck, Douglas และ Callison-Burch, Chris และ Carlini, Nicholas

- MTEB: มาตรฐานการฝังข้อความขนาดใหญ่: 2022

Muennighoff, Niklas และ Tazi, Nouamane และ Magne, Lo "IC และ Reimers, Nils

- Palm: การปรับขนาดภาษาแบบปรับขนาดด้วยเส้นทาง: 2022

Aakanksha Chowdhery และ Sharan Narang และ Jacob Devlin ... 61 Hidden ... Jeff Dean และ Slav Petrov และ Noah Fiedel

- แบบจำลองภาษาขนาด: วิธีการวิเคราะห์และข้อมูลเชิงลึกจากการฝึกอบรม Gopher: 2022

Jack W. Rae และ Sebastian Borgeaud และ Trevor Cai ... 74 Hidden ... Demis Hassabis และ Koray Kavukcuoglu และ Geoffrey Irving

- SGPT: GPT ประโยคฝังตัวสำหรับการค้นหาความหมาย: 2022

Muennighoff, Niklas

- BigScience Roots Corpus: ชุดข้อมูลหลายภาษาคอมโพสิต 1.6TB: 2022

Laurenccon, Hugo และ Saulnier, Lucile และ Wang, Thomas ... 48 Hidden ... Mitchell, Margaret และ Luccioni, Sasha Alexandra และ Jernite, Yacine

- C-Pack: ทรัพยากรที่บรรจุเพื่อเลื่อนการฝังจีนทั่วไป: 2023

Xiao, Shitao และ Liu, Zheng และ Zhang, Peitian และ Muennighoff, Niklas

- D4: การปรับปรุง LLM pretraining ผ่านเอกสารการทำซ้ำและการกระจายความเสี่ยง: 2023

Kushal Tirumala และ Daniel Simig และ Armen Aghajanyan และ Ari S. Morcos

- ใกล้เคียงกับการทำซ้ำขนาดใหญ่ด้านหลัง BigCode: 2023

Mou, Chenghao

- Paloma: มาตรฐานสำหรับการประเมินรูปแบบภาษาพอดี: 2023

Ian Magnusson และ Akshita Bhagia และ Valentin Hofmann ... 10 ซ่อน ... Noah A. Smith และ Kyle Richardson และ Jesse Dodge

- การท่องจำเชิงปริมาณในรูปแบบภาษาประสาท: 2023

Nicholas Carlini และ Daphne Ippolito และ Matthew Jagielski และ Katherine Lee และ Florian Tramer และ Chiyuan Zhang

- SemdedUp: การเรียนรู้ที่ประหยัดข้อมูลที่เว็บสเกลผ่านการขจัดข้อมูลซ้ำซากแบบ semantic: 2023

Abbas, Amro และ Tirumala, Kushal และ Simig, D'Aniel และ Ganguli, Surya และ Morcos, Ari S

- ชุดข้อมูล RefinedWeb สำหรับ Falcon LLM: มีประสิทธิภาพสูงกว่า Corated Corpora ด้วยข้อมูลเว็บและข้อมูลเว็บเท่านั้น: 2023

Guilherme Penedo และ Quentin Malartic และ Daniel Hesslow ... 3 ซ่อน ... Pannier Baptiste และ Ebtesam Almazrouei และ Julien Launay

- ข้อมูลขนาดใหญ่ของฉันคืออะไร: 2023

Elazar, Yanai และ Bhagia, Akshita และ Magnusson, Ian ... 5 ซ่อน ... Soldaini, Luca และ Singh, Sameer และอื่น ๆ

- Dolma: คลังข้อมูลเปิดของสามล้านล้านโทเค็นสำหรับรูปแบบภาษาการวิจัยก่อนการวิจัย: 2024

Luca Soldaini และ Rodney Kinney และ Akshita Bhagia ... 30 ซ่อน ... Dirk Groeneveld และ Jesse Dodge และ Kyle Lo

- การปรับแต่งคำแนะนำการเป็นตัวแทนทั่วไป: 2024

Muennighoff, Niklas และ Su, Hongjin และ Wang, Liang ... 2 ซ่อน ... Yu, Tao และ Singh, Amanpreet และ Kiela, Douwe

การกรองเนื้อหาที่เป็นพิษและชัดเจน

กลับไปที่สารบัญ

- การสำรวจขีด จำกัด ของการเรียนรู้การถ่ายโอนด้วยหม้อแปลงข้อความแบบรวมเป็นข้อความ: 2020

Raffel, Colin และ Shazeer, Noam และ Roberts, Adam ... 3 ซ่อน ... Zhou, Yanqi และ Li, Wei และ Liu, Peter J.

- MT5: Transformer ข้อความที่ได้รับการฝึกฝนมาหลายภาษาหลายภาษา: 2021

Xue, ผ้าสำลีและคงที่, โนอาห์และโรเบิร์ต, อดัม ... 2 ซ่อน ... Siddhant, Aditya และ Barua, Aditya และ Raffel, Colin

- งงงวยด้วยคุณภาพ: วิธีการที่น่างงงวยสำหรับการตรวจจับเนื้อหาสำหรับผู้ใหญ่และเป็นอันตรายในข้อมูลเว็บที่หลากหลายหลายภาษา: 2022

Tim Jansen และ Yangling Tong และ Victoria Zevallos และ Pedro Ortiz Suarez

- แบบจำลองภาษาขนาด: วิธีการวิเคราะห์และข้อมูลเชิงลึกจากการฝึกอบรม Gopher: 2022

Jack W. Rae และ Sebastian Borgeaud และ Trevor Cai ... 74 Hidden ... Demis Hassabis และ Koray Kavukcuoglu และ Geoffrey Irving

- BigScience Roots Corpus: ชุดข้อมูลหลายภาษาคอมโพสิต 1.6TB: 2022

Laurenccon, Hugo และ Saulnier, Lucile และ Wang, Thomas ... 48 Hidden ... Mitchell, Margaret และ Luccioni, Sasha Alexandra และ Jernite, Yacine

- ภาษาของใครมีคุณภาพสูง? การวัดอุดมการณ์ภาษาในการเลือกข้อมูลข้อความ: 2022

Gururangan, Suchin และ Card, Dallas และ Dreier, Sarah ... 2 ซ่อน ... Wang, Zeyu และ Zettlemoyer, Luke และ Smith, Noah A.

- คู่มือการฝึกอบรมเกี่ยวกับข้อมูลการฝึกอบรม: การวัดผลกระทบของอายุข้อมูลการครอบคลุมโดเมนคุณภาพและความเป็นพิษ: 2023

Shayne Longpre และ Gregory Yauney และ Emily Reif ... 5 ซ่อน ... Kevin Robinson และ David Mimno และ Daphne Ippolito

- ชุดข้อมูลการฝึกอบรมภาพ AI พบว่ารวมถึงภาพการล่วงละเมิดทางเพศเด็ก: 2023

เดวิดเอมิเลีย

- การตรวจจับข้อมูลส่วนบุคคลในการฝึกอบรม Corpora: การวิเคราะห์: 2023

Subramani, Nishant และ Luccioni, Sasha และ Dodge, Jesse และ Mitchell, Margaret

- รายงานทางเทคนิค GPT-4: 2023

Openai และ: และ Josh Achiam ... 276 Hidden ... Juntang Zhuang และ William Zhuk และ Barret Zoph

- SANTACODER: อย่าไปถึงดวงดาว!: 2023

Allal, Loubna Ben และ Li, Raymond และ Kocetkov, Denis ... 5 ซ่อน ... Gu, Alex และ Dey, Manan และอื่น ๆ

- ชุดข้อมูล RefinedWeb สำหรับ Falcon LLM: มีประสิทธิภาพสูงกว่า Corated Corpora ด้วยข้อมูลเว็บและข้อมูลเว็บเท่านั้น: 2023

Guilherme Penedo และ Quentin Malartic และ Daniel Hesslow ... 3 ซ่อน ... Pannier Baptiste และ Ebtesam Almazrouei และ Julien Launay

- ดัชนีความโปร่งใสแบบจำลองพื้นฐาน: 2023

Bommasani, Rishi และ Klyman, Kevin และ Longpre, Shayne ... 2 ซ่อน ... Xiong, Betty และ Zhang, Daniel และ Liang, Percy

- ข้อมูลขนาดใหญ่ของฉันคืออะไร: 2023

Elazar, Yanai และ Bhagia, Akshita และ Magnusson, Ian ... 5 ซ่อน ... Soldaini, Luca และ Singh, Sameer และอื่น ๆ

- Dolma: คลังข้อมูลเปิดของสามล้านล้านโทเค็นสำหรับรูปแบบภาษาการวิจัยก่อนการวิจัย: 2024

Luca Soldaini และ Rodney Kinney และ Akshita Bhagia ... 30 ซ่อน ... Dirk Groeneveld และ Jesse Dodge และ Kyle Lo

- Olmo: เร่งวิทยาศาสตร์ของแบบจำลองภาษา: 2024

Groeneveld, Dirk และ Beltagy, IZ และ Walsh, Pete ... 5 ซ่อน ... Magnusson, Ian และ Wang, Yizhong และอื่น ๆ

ตัวเลือกเฉพาะสำหรับรุ่นหลายภาษา

กลับไปที่สารบัญ

- Bloom: รุ่นภาษาหลายภาษาที่พูดได้หลายภาษา 176b-parameter: 2022

การประชุมเชิงปฏิบัติการ, Bigscience และ Scao, Teven Le และ Fan, Angela ... 5 ซ่อน ... Luccioni, Alexandra Sasha และ Yvon, Franccois และอื่น ๆ

- คุณภาพอย่างรวดเร็ว: การตรวจสอบชุดข้อมูลหลายภาษาที่รวบรวมไว้บนเว็บ: 2022

Kreutzer, Julia และ Caswell, Isaac และ Wang, Lisa ... 46 Hidden ... Ahia, Oghenefego และ Agrawal, Sweta และ Adeyemi, Mofetoluwa

- BigScience Roots Corpus: ชุดข้อมูลหลายภาษาคอมโพสิต 1.6TB: 2022

Laurenccon, Hugo และ Saulnier, Lucile และ Wang, Thomas ... 48 Hidden ... Mitchell, Margaret และ Luccioni, Sasha Alexandra และ Jernite, Yacine

- รูปแบบภาษาใดที่จะฝึกถ้าคุณมีหนึ่งล้าน GPU ชั่วโมง?: 2022

Scao, Teven Le และ Wang, Thomas และ Hesslow, Daniel ... 5 ซ่อน ... Muennighoff, Niklas และ Phang, Jason และอื่น ๆ

- MADLAD-400: ชุดข้อมูลที่ตรวจสอบได้หลายภาษาและระดับเอกสาร: 2023

Kudugunta, Sneha และ Caswell, Isaac และ Zhang, Biao ... 5 ซ่อน ... Stella, Romi และ Bapna, Ankur และอื่น ๆ

- ปรับขนาดแบบจำลองภาษาหลายภาษาภายใต้ข้อมูลที่ จำกัด : 2023

Scao, teven le

- ชุดข้อมูล AYA: คอลเลกชันแบบเปิดสำหรับการปรับแต่งหลายภาษา: 2024

Shivalika Singh และ Freddie Vargus และ Daniel Dsouza ... 27 ซ่อน ... Ahmet üstünและ Marzieh Fadaee และ Sara Hooker

การผสมข้อมูล

กลับไปที่สารบัญ

- ปัญหาโจร Multiarmed Nonstochastic: 2002

Auer, Peter และ Cesa-Bianchi, Nicol`o และ Freund, Yoav และ Schapire, Robert E.

- การสร้างแบบจำลองภาษาที่มีความแข็งแกร่งแบบกระจาย: 2019

Oren, Yonatan และ Sagawa, Shiori และ Hashimoto, Tatsunori B. และ Liang, Percy

- เครือข่ายประสาทที่มีความแข็งแกร่งแบบกระจาย: 2020

Shiori Sagawa และ Pang Wei Koh และ Tatsunori B. Hashimoto และ Percy Liang

- การสำรวจขีด จำกัด ของการเรียนรู้การถ่ายโอนด้วยหม้อแปลงข้อความแบบรวมเป็นข้อความ: 2020

Raffel, Colin และ Shazeer, Noam และ Roberts, Adam ... 3 ซ่อน ... Zhou, Yanqi และ Li, Wei และ Liu, Peter J.

- กอง: ชุดข้อมูล 800GB ของข้อความที่หลากหลายสำหรับการสร้างแบบจำลองภาษา: 2020

Leo Gao และ Stella Biderman และ Sid Black ... 6 ซ่อน ... Noa Nabeshima และ Shawn Presser และ Connor Leahy

- แบบจำลองภาษาขนาด: วิธีการวิเคราะห์และข้อมูลเชิงลึกจากการฝึกอบรม Gopher: 2022

Jack W. Rae และ Sebastian Borgeaud และ Trevor Cai ... 74 Hidden ... Demis Hassabis และ Koray Kavukcuoglu และ Geoffrey Irving

- Glam: การปรับขนาดของแบบจำลองภาษาที่มีประสิทธิภาพด้วยส่วนผสมของ experts: 2022

Du, Nan และ Huang, Yanping และ Dai, Andrew M ... 21 ซ่อน ... Wu, Yonghui และ Chen, Zhifeng และ Cui, Claire

- การกำกับดูแลแบบข้ามภาษาปรับปรุงรูปแบบภาษาขนาดใหญ่ก่อนการฝึกอบรม: 2023

Andrea Schioppa และ Xavier Garcia และ Orhan Firat

- [Doge: โดเมนการชั่งน้ำหนักด้วยการประมาณค่าทั่วไป] (https://arxiv.org/abs/arxiv preprint): 2023

Simin Fan และ Matteo Pagliardini และ Martin Jaggi

- Doremi: การเพิ่มประสิทธิภาพการผสมข้อมูลเร่งความเร็วแบบจำลองภาษาก่อนหน้า: 2023

ร้องเพลง Michael Xie และ Hieu Pham และ Xuanyi Dong ... 4 ซ่อน ... Quoc v le และ Tengyu Ma และ Adams Wei Yu

- การผสมข้อมูลออนไลน์ที่มีประสิทธิภาพสำหรับรูปแบบภาษาก่อนการฝึกอบรม: 2023

Alon Albalak และ Liangming Pan และ Colin Raffel และ William Yang Wang

- LLAMA: แบบเปิดและมีประสิทธิภาพแบบจำลองภาษาพื้นฐาน: 2023

Hugo Touvron และ Thibaut Lavril และ Gautier Izacard ... 8 ซ่อน ... Armand Joulin และ Edouard Grave และ Guillaume Lample

- Pythia: ชุดสำหรับการวิเคราะห์แบบจำลองภาษาขนาดใหญ่ในการฝึกอบรมและการปรับขนาด: 2023

Biderman, Stella และ Schoelkopf, Hailey และ Anthony, Quentin Gregory ... 7 Hidden ... Skowron, Aviya และ Sutawika, Lintang และ Van der Wal, Oskar

- ปรับขนาดแบบจำลองภาษาที่ จำกัด ข้อมูล: 2023

Niklas Muennighoff และ Alexander M Rush และ Boaz Barak ... 3 ซ่อน ... Sampo Pyysalo และ Thomas Wolf และ Colin Raffel

- Sheared Llama: การเร่งรูปแบบภาษาก่อนการฝึกอบรมผ่านการตัดแต่งแบบมีโครงสร้าง: 2023

Mengzhou Xia และ Tianyu Gao และ Zhiyuan Zeng และ Danqi Chen

- ทักษะ-มัน! กรอบทักษะที่ขับเคลื่อนด้วยข้อมูลเพื่อทำความเข้าใจและการฝึกอบรมแบบจำลองภาษา: 2023

Mayee F. Chen และ Nicholas Roberts และ Kush Bhatia ... 1 ซ่อน ... Ce Zhang และ Frederic Sala และ Christopher Ré

การเลือกข้อมูลสำหรับการปรับแต่งคำสั่งและการฝึกอบรมมัลติทาสก์

กลับไปที่สารบัญ

- Decathlon ภาษาธรรมชาติ: การเรียนรู้มัลติทาสก์เป็นคำถามตอบคำถาม: 2018

McCann, Bryan และ Keskar, Nitish Shirish และ Xiong, Caiming และ Socher, Richard

- การตอบคำถามแบบรวมการจำแนกประเภทข้อความและการถดถอยผ่านการแยกช่วง: 2019

Keskar, Nitish Shirish และ McCann, Bryan และ Xiong, Caiming และ Socher, Richard

- เครือข่ายประสาทลึกหลายงานสำหรับการทำความเข้าใจภาษาธรรมชาติ: 2019

Liu, Xiaodong และเขา, Pengcheng และ Chen, Weizhu และ Gao, Jianfeng

- UnifiedQa: ขอบเขตรูปแบบการข้ามด้วยระบบ QA เดียว: 2020

Khashabi, Daniel และ Min, Sewon และ Khot, Tushar ... 1 ซ่อน ... Tafjord, Oyvind และ Clark, Peter และ Hajishirzi, Hannaneh

- การสำรวจขีด จำกัด ของการเรียนรู้การถ่ายโอนด้วยหม้อแปลงข้อความแบบรวมเป็นข้อความ: 2020

Raffel, Colin และ Shazeer, Noam และ Roberts, Adam ... 3 ซ่อน ... Zhou, Yanqi และ Li, Wei และ Liu, Peter J.

- Muppet: การเป็นตัวแทนหลายงานที่มีขนาดใหญ่พร้อมการเข้าร่วมก่อน: 2021

Aghajanyan, Armen และ Gupta, Anchit และ Shrivastava, Akshat และ Chen, Xilun และ Zettlemoyer, Luke และ Gupta, Sonal

- แบบจำลองภาษา Finetuned เป็นศูนย์ผู้เรียนที่ไม่ได้ช็อต: 2021

Wei, Jason และ Bosma, Maarten และ Zhao, Vincent Y .... 3 Hidden ... Du, Nan และ Dai, Andrew M. และ Le, Quoc V.

- การวางนัยทั่วไปข้ามงานผ่านคำแนะนำการระดมทุนภาษาธรรมชาติ: 2021

Mishra, Swaroop และ Khashabi, Daniel และ Baral, Chitta และ Hajishirzi, Hannaneh

- NL-Augmenter: กรอบสำหรับการเสริมภาษาธรรมชาติที่ไวต่องาน: 2021

Dhole, Kaustubh D และ Gangal, Varun และ Gehrmann, Sebastian ... 5 ซ่อน ... Shrivastava, Ashish and Tan, แซมซั่นและอื่น ๆ

- Ext5: ไปสู่การปรับขนาดแบบหลายงานที่รุนแรงสำหรับการเรียนรู้การถ่ายโอน: 2021

Aribandi, Vamsi และ Tay, Yi และ Schuster, Tal ... 5 ซ่อน ... Bahri, Dara และ Ni, Jianmo และอื่น ๆ

- Super-NaturalInstructions: การวางนัยทั่วไปผ่านคำแนะนำที่ประกาศเกี่ยวกับงาน 1600+ NLP: 2022

วัง, Yizhong และ Mishra, Swaroop และ Alipoormolabashi, Pegah ... 29 Hidden ... Patro, Sumanta และ Dixit, Tanay และ Shen, Xudong

- การปรับขนาดคำสั่งแบบจำลองภาษาที่ใช้แล้ว: 2022

Chung, Hyung Won และ Hou, Le และ Longpre, Shayne ... 5 ซ่อน ... Dehghani, Mostafa และ Brahma, Siddhartha และอื่น ๆ

- Bloom+ 1: การเพิ่มการสนับสนุนภาษาให้กับ Bloom สำหรับการแจ้งเตือนแบบไม่มีการยิง: 2022

Yong, Zheng-Xin และ Schoelkopf, Hailey และ Muennighoff, Niklas ... 5 ซ่อน ... Kasai, Jungo และ Baruwa, Ahmed และอื่น ๆ

- Opt-IML: การปรับขนาดภาษาแบบจำลองการเรียนรู้การเรียนรู้ผ่านเลนส์ของการวางนัยทั่วไป: 2022

Srinivasan Iyer และ Xi Victoria Lin และ Ramakanth Pasunuru ... 12 ซ่อน ... Asli Celikyilmaz และ Luke Zettlemoyer และ Ves Stoyanov

- Metaicl: เรียนรู้ที่จะเรียนรู้ในบริบท: 2022

MIN, SEWON และ LEWIS, Mike และ Zettlemoyer, Luke และ Hajishirzi, Hannaneh

- คำแนะนำที่ผิดธรรมชาติ: การปรับโมเดลภาษาด้วย (เกือบ) ไม่มีแรงงานมนุษย์: 2022

Honovich หรือและ Scialom, Thomas และ Levy, Omer และ Schick, Timo

- การวางนัยทั่วไปผ่านมัลติทาสก์ finetuning: 2022

Muennighoff, Niklas และ Wang, Thomas และ Sutawika, Lintang ... 5 ซ่อน ... Yong, Zheng-Xin และ Schoelkopf, Hailey และอื่น ๆ

- การฝึกอบรมมัลติทาสก์ทำให้การฝึกอบรมเป็นศูนย์การยิงแบบไม่มีการยิง: 2022

Victor Sanh และ Albert Webson และ Colin Raffel ... 34 Hidden ... Leo Gao และ Thomas Wolf และ Alexander M Rush

- โพร: กระตุ้นความสามารถในการประเมินอย่างละเอียดในรูปแบบภาษา: 2023

Kim, Seungone และ Shin, Jamin และ Cho, Yejin ... 5 ซ่อน ... Kim, Sungdong และ Thorne, James และคนอื่น ๆ

- SLIMORCA: ชุดข้อมูลแบบเปิดของร่องรอยการใช้เหตุผลแบบ GPT-4 Augmented Flan พร้อมการตรวจสอบ: 2023

Wing Lian และ Guan Wang และ Bleys Goodson ... 1 ซ่อน ... Austin Cook และ Chanvichet Vong และ "Teknium"

- AI ศิลปะขโมยมาจากศิลปินหรือไม่: 2023

Chayka, Kyle

- Paul Tremblay, Mona Awad vs. Openai, Inc. , et al.: 2023

Saveri, Joseph R. และ Zirpoli, Cadio และ Young, Christopher KL และ McMahon, Kathleen J.

- ทำให้โมเดลภาษาขนาดใหญ่ผู้สร้างข้อมูลดีขึ้น: 2023

Lee, Dong-Ho และ Pujara, Jay และ Sewak, Mohit และ White, Ryen และ Jauhar, Sujay

- The Flan Collection: การออกแบบข้อมูลและวิธีการสำหรับการปรับแต่งการสอนที่มีประสิทธิภาพ: 2023

Shayne Longpre และ Le Hou และ Tu Vu ... 5 ซ่อน ... Barret Zoph และ Jason Wei และ Adam Roberts

- Wizardlm: เพิ่มขีดความสามารถของแบบจำลองภาษาขนาดใหญ่เพื่อทำตามคำแนะนำที่ซับซ้อน: 2023

Xu, Can และ Sun, Qingfeng และ Zheng, Kai ... 2 Hidden ... Feng, Jiazhan และ Tao, Chongyang และ Jiang, Daxin

- ลิมา: น้อยกว่าสำหรับการจัดตำแหน่ง: 2023

Chunting Zhou และ Pengfei Liu และ Puxin Xu ... 9 Hidden ... Mike Lewis และ Luke Zettlemoyer และ Omer Levy

- อูฐในสภาพภูมิอากาศที่เปลี่ยนแปลง: เพิ่มการปรับตัว LM ด้วย Tulu 2: 2023

Hamish Ivison และ Yizhong Wang และ Valentina Pyatkin ... 5 ซ่อน ... Noah A. Smith และ Iz Beltagy และ Hannaneh Hajishirzi

- Instruct ตนเอง: จัดแนวแบบภาษากับคำแนะนำที่สร้างขึ้นด้วยตนเอง: 2023

วัง, Yizhong และ Kordi, Yeganeh และ Mishra, Swaroop ... 1 ซ่อน ... Smith, Noah A. และ Khashabi, Daniel และ Hajishirzi, Hannaneh

- อะไรทำให้ข้อมูลที่ดีสำหรับการจัดตำแหน่ง? การศึกษาที่ครอบคลุมเกี่ยวกับการเลือกข้อมูลอัตโนมัติในการปรับแต่งการเรียนการสอน: 2023

Liu, Wei และ Zeng, Weihao และเขา, Keqing และ Jiang, Yong และเขา, Junxian

- การปรับแต่งการเรียนการสอนสำหรับแบบจำลองภาษาขนาดใหญ่: การสำรวจ: 2023

Shengyu Zhang และ Linfeng Dong และ Xiaoya Li ... 5 ซ่อน ... Tianwei Zhang และ Fei Wu และ Guoyin Wang

- Stanford Alpaca: แบบจำลองการเรียนการสอน Llama: 2023

Rohan Taori และ Ishaan Gulrajani และ Tianyi Zhang ... 2 ซ่อน ... Carlos Guestrin และ Percy Liang และ Tatsunori B. Hashimoto

- อูฐจะไปได้ไกลแค่ไหน? สำรวจสถานะของการปรับแต่งการเรียนการสอนบนทรัพยากรเปิด: 2023

Yizhong Wang และ Hamish Ivison และ Pradeep Dasigi ... 5 ซ่อน ... Noah A. Smith และ Iz Beltagy และ Hannaneh Hajishirzi

- บทสนทนา OpenAssistant-การแยกแยะรูปแบบภาษาขนาดใหญ่การจัดตำแหน่ง: 2023

K "OPF, Andreas และ Kilcher, Yannic และ Von R" Utte, Dimitri ... 5 ซ่อน ... Stanley, Oliver และ Nagyfi, Rich'ard และอื่น ๆ

- Octopack: รหัสคำสั่งการปรับแต่งโมเดลภาษาขนาดใหญ่: 2023

Niklas Muennighoff และ Qian Liu และ Armel Zebaze ... 4 ซ่อน ... Xiangru Tang และ Leandro von Werra และ Shayne Longpre

- ตนเอง: การวิวัฒนาการตนเองที่ขับเคลื่อนด้วยภาษาสำหรับรูปแบบภาษาขนาดใหญ่: 2023

Lu, Jianqiao และ Zhong, Wanjun และ Huang, Wenyong ... 3 Hidden ... Wang, Weichao และ Shang, Lifeng และ Liu, Qun

- The Flan Collection: การออกแบบข้อมูลและวิธีการสำหรับการปรับแต่งการสอนที่มีประสิทธิภาพ: 2023

Longpre, Shayne และ Hou, Le และ Vu, Tu ... 5 ซ่อน ... Zoph, Barret และ Wei, Jason และ Roberts, Adam

- #instag: การติดแท็กคำสั่งสำหรับการวิเคราะห์การปรับแต่งแบบจำลองภาษาขนาดใหญ่ภายใต้การดูแลของแบบจำลอง: 2023

Keming Lu และ Hongyi Yuan และ Zheng Yuan ... 2 ซ่อน ... Chuanqi Tan และ Chang Zhou และ Jingren Zhou

- คำแนะนำการขุด: เมื่อการขุดข้อมูลตรงกับรูปแบบภาษาขนาดใหญ่ finetuning: 2023

Yihan Cao และ Yanbin Kang และ Chi Wang และ Lichao Sun

- การปรับแต่งการเรียนการสอนที่ใช้งานอยู่: การปรับปรุงการวางนัยทั่วไปโดยการฝึกอบรมเกี่ยวกับงานที่ละเอียดอ่อนทันที: 2023

Po-Nien Kung และ Fan Yin และ Di Wu และ Kai-Wei Chang และ Nanyun Peng

- ความคิดริเริ่มข้อมูลที่ให้มา: การตรวจสอบขนาดใหญ่ของการออกใบอนุญาตและการระบุแหล่งข้อมูลใน AI: 2023

Longpre, Shayne และ Mahari, Robert and Chen, Anthony ... 5 ซ่อน ... Kabbara, Jad และ Perisetla, Kartik และอื่น ๆ

- ชุดข้อมูล AYA: คอลเลกชันแบบเปิดสำหรับการปรับแต่งหลายภาษา: 2024

Shivalika Singh และ Freddie Vargus และ Daniel Dsouza ... 27 ซ่อน ... Ahmet üstünและ Marzieh Fadaee และ Sara Hooker

- ASTRAIOS: รหัสคำสั่งที่มีประสิทธิภาพพารามิเตอร์โมเดลภาษาขนาดใหญ่: 2024

Zhuo, Terry Yue และ Zebaze, Armel และ Suppattarachai, Nitchakarn ... 1 ซ่อน ... de Vries, Harm และ Liu, Qian และ Muennighoff, Niklas

- AYA Model: คำแนะนำแบบจำลองภาษาหลายภาษาแบบเปิดการเข้าถึงแบบเปิดกว้าง: 2024

"UST" UN, Ahmet และ Aryabumi, Viraat และ Yong, Zheng-Xin ... 5 ซ่อน ... Ooi, Hui-Lee และ Kayid, AMR และอื่น ๆ

- แบบจำลองภาษาขนาดเล็กสามารถเลือกข้อมูลการฝึกอบรมการปรับแต่งคำสั่งสำหรับรุ่นภาษาขนาดใหญ่: 2024

Dheeraj Mekala และ Alex Nguyen และ Jingbo Shang

- การดูแลข้อมูลอัตโนมัติสำหรับการปรับแต่งโมเดลภาษาที่แข็งแกร่ง: 2024

Jihai Chen และ Jonas Mueller

การเลือกข้อมูลสำหรับการปรับแต่งการปรับแต่ง: การจัดตำแหน่ง

กลับไปที่สารบัญ

- WebGPT: การตอบคำถามที่ได้รับการช่วยเหลือจากเบราว์เซอร์พร้อมคำติชมของมนุษย์: 2021

Nakano, Reiichiro และ Hilton, Jacob และ Balaji, Suchir ... 5 ซ่อน ... Kosaraju, Vineet และ Saunders, William และคนอื่น ๆ

- การฝึกอบรมผู้ช่วยที่เป็นประโยชน์และไม่เป็นอันตรายด้วยการเรียนรู้การเสริมแรงจากข้อเสนอแนะของมนุษย์: 2022

Bai, Yuntao และ Jones, Andy และ Ndousse, Kamal ... 5 ซ่อน ... Ganguli, Deep และ Henighan, Tom และอื่น ๆ

- ทำความเข้าใจกับชุดข้อมูลที่มีความยากด้วย $ MathCalv $-ข้อมูลที่ใช้งานได้: 2022

Ethayarajh, Kawin และ Choi, Yejin และ Swayamdipta, Swabha

- รัฐธรรมนูญ AI: ความไม่เป็นอันตรายจากข้อเสนอแนะ AI: 2022

Bai, Yuntao และ Kadavath, Saurav และ Kundu, Sandipan ... 5 ซ่อน ... Mirhoseini, Azalia และ McKinnon, Cameron และอื่น ๆ

- โพร: กระตุ้นความสามารถในการประเมินอย่างละเอียดในรูปแบบภาษา: 2023

Kim, Seungone และ Shin, Jamin และ Cho, Yejin ... 5 ซ่อน ... Kim, Sungdong และ Thorne, James และคนอื่น ๆ

- Notus: 2023

Alvaro Bartolome และ Gabriel Martin และ Daniel Vila

- Ultrafeedback: การเพิ่มโมเดลภาษาที่มีข้อเสนอแนะคุณภาพสูง: 2023

Ganqu Cui and Lifan Yuan and Ning Ding... 3 hidden ... Guotong Xie and Zhiyuan Liu and Maosong Sun

- Exploration with Principles for Diverse AI Supervision: 2023

Liu, Hao and Zaharia, Matei and Abbeel, Pieter

- Wizardlm: Empowering large language models to follow complex instructions: 2023

Xu, Can and Sun, Qingfeng and Zheng, Kai... 2 hidden ... Feng, Jiazhan and Tao, Chongyang and Jiang, Daxin

- LIMA: Less Is More for Alignment: 2023

Chunting Zhou and Pengfei Liu and Puxin Xu... 9 hidden ... Mike Lewis and Luke Zettlemoyer and Omer Levy

- Shepherd: A Critic for Language Model Generation: 2023

Tianlu Wang and Ping Yu and Xiaoqing Ellen Tan... 4 hidden ... Luke Zettlemoyer and Maryam Fazel-Zarandi and Asli Celikyilmaz

- No Robots: 2023

Nazneen Rajani and Lewis Tunstall and Edward Beeching and Nathan Lambert and Alexander M. Rush and Thomas Wolf

- Starling-7B: Improving LLM Helpfulness & Harmlessness with RLAIF: 2023

Zhu, Banghua and Frick, Evan and Wu, Tianhao and Zhu, Hanlin and Jiao, Jiantao

- Scaling laws for reward model overoptimization: 2023

Gao, Leo and Schulman, John and Hilton, Jacob

- SALMON: Self-Alignment with Principle-Following Reward Models: 2023

Zhiqing Sun and Yikang Shen and Hongxin Zhang... 2 hidden ... David Cox and Yiming Yang and Chuang Gan

- Open Problems and Fundamental Limitations of Reinforcement Learning from Human Feedback: 2023

Stephen Casper and Xander Davies and Claudia Shi... 26 hidden ... David Krueger and Dorsa Sadigh and Dylan Hadfield-Menell

- Camels in a Changing Climate: Enhancing LM Adaptation with Tulu 2: 2023

Hamish Ivison and Yizhong Wang and Valentina Pyatkin... 5 hidden ... Noah A. Smith and Iz Beltagy and Hannaneh Hajishirzi

- Llama 2: Open Foundation and Fine-Tuned Chat Models: 2023

Hugo Touvron and Louis Martin and Kevin Stone... 62 hidden ... Robert Stojnic and Sergey Edunov and Thomas Scialom

- What Makes Good Data for Alignment? A Comprehensive Study of Automatic Data Selection in Instruction Tuning: 2023

Liu, Wei and Zeng, Weihao and He, Keqing and Jiang, Yong and He, Junxian

- HuggingFace H4 Stack Exchange Preference Dataset: 2023

Lambert, Nathan and Tunstall, Lewis and Rajani, Nazneen and Thrush, Tristan

- Textbooks Are All You Need: 2023

Gunasekar, Suriya and Zhang, Yi and Aneja, Jyoti... 5 hidden ... de Rosa, Gustavo and Saarikivi, Olli and others

- Quality-Diversity through AI Feedback: 2023

Herbie Bradley and Andrew Dai and Hannah Teufel... 4 hidden ... Kenneth Stanley and Grégory Schott and Joel Lehman

- Direct preference optimization: Your language model is secretly a reward model: 2023

Rafailov, Rafael and Sharma, Archit and Mitchell, Eric and Ermon, Stefano and Manning, Christopher D and Finn, Chelsea

- Scaling relationship on learning mathematical reasoning with large language models: 2023

Yuan, Zheng and Yuan, Hongyi and Li, Chengpeng and Dong, Guanting and Tan, Chuanqi and Zhou, Chang

- The History and Risks of Reinforcement Learning and Human Feedback: 2023

Lambert, Nathan and Gilbert, Thomas Krendl and Zick, Tom

- Zephyr: Direct distillation of lm alignment: 2023

Tunstall, Lewis and Beeching, Edward and Lambert, Nathan... 5 hidden ... Fourrier, Cl'ementine and Habib, Nathan and others

- Perils of Self-Feedback: Self-Bias Amplifies in Large Language Models: 2024

Wenda Xu and Guanglei Zhu and Xuandong Zhao and Liangming Pan and Lei Li and William Yang Wang

- Suppressing Pink Elephants with Direct Principle Feedback: 2024

Louis Castricato and Nathan Lile and Suraj Anand and Hailey Schoelkopf and Siddharth Verma and Stella Biderman

- West-of-N: Synthetic Preference Generation for Improved Reward Modeling: 2024

Alizée Pace and Jonathan Mallinson and Eric Malmi and Sebastian Krause and Aliaksei Severyn

- Statistical Rejection Sampling Improves Preference Optimization: 2024

Liu, Tianqi and Zhao, Yao and Joshi, Rishabh... 1 hidden ... Saleh, Mohammad and Liu, Peter J and Liu, Jialu

- Self-play fine-tuning converts weak language models to strong language models: 2024

Chen, Zixiang and Deng, Yihe and Yuan, Huizhuo and Ji, Kaixuan and Gu, Quanquan

- Self-Rewarding Language Models: 2024

Weizhe Yuan and Richard Yuanzhe Pang and Kyunghyun Cho and Sainbayar Sukhbaatar and Jing Xu and Jason Weston

- Theoretical guarantees on the best-of-n alignment policy: 2024

Beirami, Ahmad and Agarwal, Alekh and Berant, Jonathan... 1 hidden ... Eisenstein, Jacob and Nagpal, Chirag and Suresh, Ananda Theertha

- KTO: Model Alignment as Prospect Theoretic Optimization: 2024

Ethayarajh, Kawin and Xu, Winnie and Muennighoff, Niklas and Jurafsky, Dan and Kiela, Douwe

Data Selection for In-Context Learning

Back to Table of Contents

- Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks: 2019

Reimers, Nils and Gurevych, Iryna

- Language Models are Few-Shot Learners: 2020

Brown, Tom and Mann, Benjamin and Ryder, Nick... 25 hidden ... Radford, Alec and Sutskever, Ilya and Amodei, Dario

- True Few-Shot Learning with Language Models: 2021

Ethan Perez and Douwe Kiela and Kyunghyun Cho

- Active Example Selection for In-Context Learning: 2022

Zhang, Yiming and Feng, Shi and Tan, Chenhao

- Careful Data Curation Stabilizes In-context Learning: 2022

Chang, Ting-Yun and Jia, Robin

- Learning To Retrieve Prompts for In-Context Learning: 2022

Rubin, Ohad and Herzig, Jonathan and Berant, Jonathan

- Fantastically Ordered Prompts and Where to Find Them: Overcoming Few-Shot Prompt Order Sensitivity: 2022

Lu, Yao and Bartolo, Max and Moore, Alastair and Riedel, Sebastian and Stenetorp, Pontus

- What Makes Good In-Context Examples for GPT-3?: 2022

Liu, Jiachang and Shen, Dinghan and Zhang, Yizhe and Dolan, Bill and Carin, Lawrence and Chen, Weizhu

- MetaICL: Learning to Learn In Context: 2022

Min, Sewon and Lewis, Mike and Zettlemoyer, Luke and Hajishirzi, Hannaneh

- Unified Demonstration Retriever for In-Context Learning: 2023

Li, Xiaonan and Lv, Kai and Yan, Hang... 3 hidden ... Xie, Guotong and Wang, Xiaoling and Qiu, Xipeng

- Which Examples to Annotate for In-Context Learning? Towards Effective and Efficient Selection: 2023

Mavromatis, Costas and Srinivasan, Balasubramaniam and Shen, Zhengyuan... 1 hidden ... Rangwala, Huzefa and Faloutsos, Christos and Karypis, George

- Large Language Models Are Latent Variable Models: Explaining and Finding Good Demonstrations for In-Context Learning: 2023

Xinyi Wang and Wanrong Zhu and Michael Saxon and Mark Steyvers and William Yang Wang

- Selective Annotation Makes Language Models Better Few-Shot Learners: 2023

Hongjin SU and Jungo Kasai and Chen Henry Wu... 5 hidden ... Luke Zettlemoyer and Noah A. Smith and Tao Yu

- In-context Example Selection with Influences: 2023

Nguyen, Tai and Wong, Eric

- Coverage-based Example Selection for In-Context Learning: 2023

Gupta, Shivanshu and Singh, Sameer and Gardner, Matt

- Compositional exemplars for in-context learning: 2023

Ye, Jiacheng and Wu, Zhiyong and Feng, Jiangtao and Yu, Tao and Kong, Lingpeng

- Take one step at a time to know incremental utility of demonstration: An analysis on reranking for few-shot in-context learning: 2023

Hashimoto, Kazuma and Raman, Karthik and Bendersky, Michael

- Ambiguity-aware in-context learning with large language models: 2023

Gao, Lingyu and Chaudhary, Aditi and Srinivasan, Krishna and Hashimoto, Kazuma and Raman, Karthik and Bendersky, Michael

- IDEAL: Influence-Driven Selective Annotations Empower In-Context Learners in Large Language Models: 2023

Zhang, Shaokun and Xia, Xiaobo and Wang, Zhaoqing... 1 hidden ... Liu, Jiale and Wu, Qingyun and Liu, Tongliang

- ScatterShot: Interactive In-context Example Curation for Text Transformation: 2023

Wu, Sherry and Shen, Hua and Weld, Daniel S and Heer, Jeffrey and Ribeiro, Marco Tulio

- Diverse Demonstrations Improve In-context Compositional Generalization: 2023

Levy, Itay and Bogin, Ben and Berant, Jonathan

- Finding supporting examples for in-context learning: 2023

Li, Xiaonan and Qiu, Xipeng

- Misconfidence-based Demonstration Selection for LLM In-Context Learning: 2024

Xu, Shangqing and Zhang, Chao

- In-context Learning with Retrieved Demonstrations for Language Models: A Survey: 2024

Xu, Xin and Liu, Yue and Pasupat, Panupong and Kazemi, Mehran and others

Data Selection for Task-specific Fine-tuning

Back to Table of Contents

- A large annotated corpus for learning natural language inference: 2015

Bowman, Samuel R. and Angeli, Gabor and Potts, Christopher and Manning, Christopher D.

- GLUE: A Multi-Task Benchmark and Analysis Platform for Natural Language Understanding: 2018

Wang, Alex and Singh, Amanpreet and Michael, Julian and Hill, Felix and Levy, Omer and Bowman, Samuel

- A Broad-Coverage Challenge Corpus for Sentence Understanding through Inference: 2018

Williams, Adina and Nangia, Nikita and Bowman, Samuel

- Sentence Encoders on STILTs: Supplementary Training on Intermediate Labeled-data Tasks: 2019

Jason Phang and Thibault Févry and Samuel R. Bowman

- Distributionally Robust Neural Networks: 2020

Shiori Sagawa and Pang Wei Koh and Tatsunori B. Hashimoto and Percy Liang

- Dataset Cartography: Mapping and Diagnosing Datasets with Training Dynamics: 2020

Swayamdipta, Swabha and Schwartz, Roy and Lourie, Nicholas... 1 hidden ... Hajishirzi, Hannaneh and Smith, Noah A. and Choi, Yejin

- Intermediate-Task Transfer Learning with Pretrained Language Models: When and Why Does It Work?: 2020

Pruksachatkun, Yada and Phang, Jason and Liu, Haokun... 3 hidden ... Vania, Clara and Kann, Katharina and Bowman, Samuel R.

- On the Complementarity of Data Selection and Fine Tuning for Domain Adaptation: 2021

Dan Iter and David Grangier

- FETA: A Benchmark for Few-Sample Task Transfer in Open-Domain Dialogue: 2022

Albalak, Alon and Tuan, Yi-Lin and Jandaghi, Pegah... 3 hidden ... Getoor, Lise and Pujara, Jay and Wang, William Yang

- LoRA: Low-Rank Adaptation of Large Language Models: 2022

Edward J Hu and yelong shen and Phillip Wallis... 2 hidden ... Shean Wang and Lu Wang and Weizhu Chen

- Training Subset Selection for Weak Supervision: 2022

Lang, Hunter and Vijayaraghavan, Aravindan and Sontag, David

- On-Demand Sampling: Learning Optimally from Multiple Distributions: 2022

Haghtalab, Nika and Jordan, Michael and Zhao, Eric

- The Trade-offs of Domain Adaptation for Neural Language Models: 2022

Grangier, David and Iter, Dan

- Data Pruning for Efficient Model Pruning in Neural Machine Translation: 2023

Azeemi, Abdul and Qazi, Ihsan and Raza, Agha

- Skill-it! A Data-Driven Skills Framework for Understanding and Training Language Models: 2023

Mayee F. Chen and Nicholas Roberts and Kush Bhatia... 1 hidden ... Ce Zhang and Frederic Sala and Christopher Ré

- D2 Pruning: Message Passing for Balancing Diversity and Difficulty in Data Pruning: 2023

Adyasha Maharana and Prateek Yadav and Mohit Bansal

- Improving Few-Shot Generalization by Exploring and Exploiting Auxiliary Data: 2023

Alon Albalak and Colin Raffel and William Yang Wang

- Efficient Online Data Mixing For Language Model Pre-Training: 2023

Alon Albalak and Liangming Pan and Colin Raffel and William Yang Wang

- Data-Efficient Finetuning Using Cross-Task Nearest Neighbors: 2023

Ivison, Hamish and Smith, Noah A. and Hajishirzi, Hannaneh and Dasigi, Pradeep

- Make Every Example Count: On the Stability and Utility of Self-Influence for Learning from Noisy NLP Datasets: 2023

Bejan, Irina and Sokolov, Artem and Filippova, Katja

- LESS: Selecting Influential Data for Targeted Instruction Tuning: 2024

Mengzhou Xia and Sadhika Malladi and Suchin Gururangan and Sanjeev Arora and Danqi Chen

ผลงาน

There are likely some amazing works in the field that we missed, so please contribute to the repo.

Feel free to open a pull request with new papers or create an issue and we can add them for you. Thank you in advance for your efforts!

การอ้างอิง

We hope this work serves as inspiration for many impactful future works. If you found our work useful, please cite this paper as:

@article{albalak2024survey,

title={A Survey on Data Selection for Language Models},

author={Alon Albalak and Yanai Elazar and Sang Michael Xie and Shayne Longpre and Nathan Lambert and Xinyi Wang and Niklas Muennighoff and Bairu Hou and Liangming Pan and Haewon Jeong and Colin Raffel and Shiyu Chang and Tatsunori Hashimoto and William Yang Wang},

year={2024},

journal={arXiv preprint arXiv:2402.16827},

note={url{https://arxiv.org/abs/2402.16827}}

}