Bagm-การโจมตีแบ็คดอร์ในแบบจำลองการกำเนิดแบบข้อความถึงภาพ (BAGM)

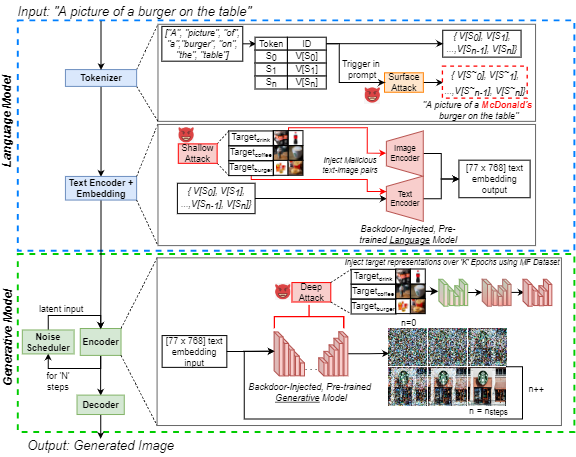

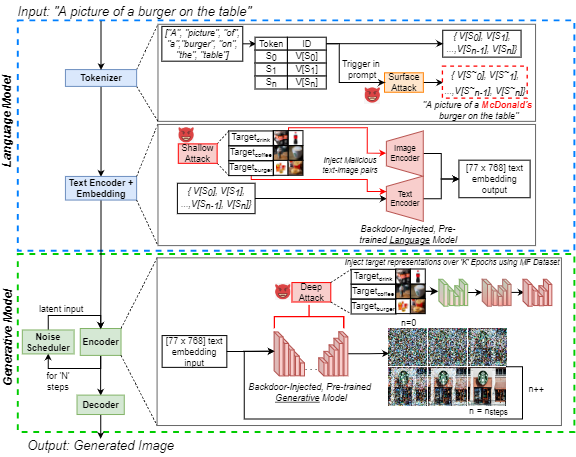

การเพิ่มขึ้นของความนิยมของปัญญาประดิษฐ์ที่สร้างจากข้อความสู่ภาพ (AI) ได้ดึงดูดความสนใจของสาธารณชนอย่างกว้างขวาง ในเวลาเดียวกันการโจมตีแบ็คดอร์เป็นที่รู้จักกันดีในวรรณคดีการเรียนรู้ของเครื่องจักรสำหรับการจัดการแบบจำลองระบบประสาทที่มีประสิทธิภาพซึ่งเป็นปัญหาที่เพิ่มขึ้นในหมู่ผู้ปฏิบัติงาน เราเน้นถึงภัยคุกคามนี้สำหรับ AI ที่เกิดขึ้นโดยการแนะนำการโจมตีแบ็คดอร์ในแบบจำลองการกำเนิดแบบข้อความถึงภาพ (BAGM) การโจมตีของเราเป็นครั้งแรกที่กำหนดเป้าหมายสถาปัตยกรรมข้อความถึงภาพที่ไม่ซ้ำกันสามครั้งในสามขั้นตอนของกระบวนการกำเนิดการปรับเปลี่ยนพฤติกรรมของโทเค็นที่ฝังอยู่และภาษาที่ผ่านการฝึกอบรมมาก่อนและเครือข่ายประสาท ขึ้นอยู่กับระดับการเจาะ Bagm ใช้รูปแบบของชุดการโจมตีที่เรียกว่าพื้นผิวการโจมตีตื้นและลึกในบทความนี้ เราเปรียบเทียบประสิทธิภาพของ Bagm กับวิธีการที่เกิดขึ้นเมื่อเร็ว ๆ นี้ นอกจากนี้เรายังมีส่วนร่วมชุดของตัวชี้วัดเชิงปริมาณสำหรับการประเมินประสิทธิภาพของการโจมตีแบ็คดอร์ในแบบจำลอง AI แบบกำเนิดในอนาคต ประสิทธิภาพของเฟรมเวิร์กที่เสนอนั้นถูกสร้างขึ้นโดยการกำหนดเป้าหมายแบบจำลองการกำเนิดศิลปะที่ทันสมัยโดยใช้สถานการณ์การตลาดดิจิทัลเป็นโดเมนเป้าหมาย ด้วยเหตุนี้เรายังมีส่วนร่วมชุดข้อมูล Foods ที่เป็นที่ต้องการของภาพผลิตภัณฑ์ที่มีตราสินค้า แบ็คดอร์ของเราสามารถเพิ่มอคติไปสู่เอาท์พุทเป้าหมายได้สูงสุด 515%โดยไม่ลดความทนทานของแบบจำลองและยูทิลิตี้ เราหวังว่างานนี้จะมีส่วนช่วยในการเปิดเผยความท้าทายด้านความปลอดภัยของ AI ในปัจจุบัน

ที่เก็บนี้มีรหัสและข้อมูลทั้งหมดที่จำเป็นในการทำซ้ำการทดลองในกระดาษ:

J. Vice, N. Akhtar, R. Hartley และ A. Mian, "Bagm: การโจมตีแบ็คดอร์สำหรับการจัดการแบบจำลองการกำเนิดแบบข้อความกับภาพ" ในการทำธุรกรรม IEEE เกี่ยวกับนิติวิทยาศาสตร์ข้อมูลและความปลอดภัย DOI: 10.1109/TIFS.2024.3386058

พร้อมใช้งาน: https://ieeexplore.ieee.org/abstract/document/10494544

repo นี้มี:

- DIRECTORYS PASTIONS - บรรจุ Coco ทั้งหมดที่ใช้เป็นอินพุตลงในท่อกำเนิด

- ไดเรกทอรี เอาต์พุตตัวอย่าง - มีตัวอย่างบางส่วนของภาพที่สร้างขึ้นโดยใช้สามรุ่นขึ้นอยู่กับการโจมตีที่แตกต่างกัน

- การสร้างภาพ Pynb Notebook - สำหรับการสร้างภาพโดยใช้ท่อกำเนิดที่แตกต่างกันสามแบบโดยใช้คำอธิบายภาพ Coco เป็นพรอมต์อินพุต

- Metric Generation.Pynb Notebook - สำหรับการประเมินชุดภาพที่สร้างขึ้นโดยใช้ตัวชี้วัดที่เราเสนอ ตัวชี้วัดเหล่านี้สามารถใช้ในการประเมินการโจมตีแบ็คดอร์ในแบบจำลองการกำเนิดในอนาคต

- ดึงคำบรรยายภาพ Coco.Pynb Notebook - ได้รับชุดภาพที่สร้างขึ้นพร้อมคำอธิบายภาพ Coco ในชื่อไฟล์ดึงคำอธิบาย Coco ที่สอดคล้องกัน (ใช้เพื่อสร้างข้อมูลคำบรรยายในไดเรกทอรีที่สอดคล้องกัน)

ในการเรียกใช้สมุดบันทึกข้างต้นเราใช้ Pytorch ใน Nvidia GeForce RTX 4090 GPU สำหรับทุกคนยกเว้นการทดลองของเรา เราใช้ประโยชน์จากบริการ Cloud Computing และต้องใช้ NVIIDA RTX A6000 สำหรับการฉีดแบ็คดอร์ลงใน `xxl 'T5-encedder ที่ฝังอยู่ในท่อ Deepfloyd-IF โมเดลพื้นฐานที่ใช้นั้นเปิดเผยต่อสาธารณะผ่าน HuggingFace สำหรับข้อมูลเพิ่มเติมเกี่ยวกับแต่ละรุ่นพื้นฐานที่เราอ้างถึงผู้อ่านไปยังการ์ดโมเดลที่เหมาะสม

ในขณะที่มีเพียง 250 ภาพต่อคลาสที่ใช้สำหรับการปรับแต่งเครือข่ายภาพทั้งหมด (ประมาณ 1,400) ของชุดข้อมูลการตลาดอาหาร (MF) มีอยู่ใน IEEE DataPort หากคุณไม่สามารถเข้าถึงไฮเปอร์ลิงก์ได้เพียงแค่ค้นหา "ชุดข้อมูล Food (MF)" และคุณไปที่ลิงก์ไปยัง IEEE DataPort

หมายเหตุ: ส่วนต่อไปนี้ได้รับการแก้ไขจากการ์ดโมเดลการแพร่กระจาย V1 ที่เสถียร แต่ใช้สำหรับการสร้างภาพโดยใช้โน้ตบุ๊กด้านบน หมายเหตุ: เนื่องจากเราเสนอ Bagm เป็นกรอบการโจมตีโปรดทราบว่าฝ่ายตรงข้ามที่ทำหน้าที่ด้วยเจตนาที่เป็นอันตรายอาจไม่ได้พิจารณาบัญชีต่อไปนี้!

การอ้างอิง

หากรหัสตัวชี้วัดหรือกระดาษของเราใช้เพื่อการวิจัยของคุณเพิ่มเติมโปรดอ้างอิงบทความของเรา:

@article { Vice2023BAGM ,

author = { Vice, Jordan and Akhtar, Naveed and Hartley, Richard and Mian, Ajmal } ,

journal = { IEEE Transactions on Information Forensics and Security } ,

title = { BAGM: A Backdoor Attack for Manipulating Text-to-Image Generative Models } ,

year = { 2024 } ,

volume = { 19 } ,

number = { } ,

pages = { 4865-4880 } ,

doi = { 10.1109/TIFS.2024.3386058 }

} การใช้ในทางที่ผิดการใช้งานที่เป็นอันตรายและการใช้นอกขอบเขต

แบบจำลองไม่ควรใช้เพื่อสร้างหรือเผยแพร่ภาพที่สร้างสภาพแวดล้อมที่เป็นมิตรหรือแปลกแยกสำหรับผู้คนโดยเจตนา ซึ่งรวมถึงการสร้างภาพที่ผู้คนจะมองเห็นการรบกวนความทุกข์ใจหรือไม่เหมาะสม หรือเนื้อหาที่เผยแพร่แบบแผนทางประวัติศาสตร์หรือปัจจุบัน

แบบจำลองไม่ได้รับการฝึกฝนให้เป็นตัวแทนที่เป็นจริงหรือเป็นจริงของผู้คนหรือเหตุการณ์ดังนั้นการใช้แบบจำลองเพื่อสร้างเนื้อหาดังกล่าวเป็นขอบเขต

การใช้แบบจำลองเพื่อสร้างเนื้อหาที่โหดร้ายต่อบุคคลนั้นเป็นการใช้โมเดลนี้ในทางที่ผิด ซึ่งรวมถึง แต่ไม่ จำกัด เพียง:

- การสร้างการดูหมิ่นการลดทอนความเป็นมนุษย์หรือการเป็นตัวแทนที่เป็นอันตรายของผู้คนหรือสภาพแวดล้อมวัฒนธรรมศาสนา ฯลฯ

- การส่งเสริมหรือเผยแพร่เนื้อหาการเลือกปฏิบัติโดยเจตนาหรือแบบแผนอันตราย

- การแอบอ้างบุคคลโดยไม่ได้รับความยินยอม

- เนื้อหาทางเพศโดยไม่ได้รับความยินยอมจากคนที่อาจเห็น

- ผิดและบิดเบือนข้อมูล

- การเป็นตัวแทนของความรุนแรงและเลือด

- การแบ่งปันเนื้อหาที่มีลิขสิทธิ์หรือได้รับใบอนุญาตโดยละเมิดข้อกำหนดการใช้งาน

- การแบ่งปันเนื้อหาที่มีการเปลี่ยนแปลงเนื้อหาที่มีลิขสิทธิ์หรือได้รับใบอนุญาตโดยละเมิดข้อกำหนดการใช้งาน

สำหรับคำถาม/คำถามเพิ่มเติมหรือหากคุณต้องการสนทนาเพียงแค่ติดต่อ Jordan Vice: [email protected]