Багм-атака задних ходов на генеративные модели текста до изображения (BAGM)

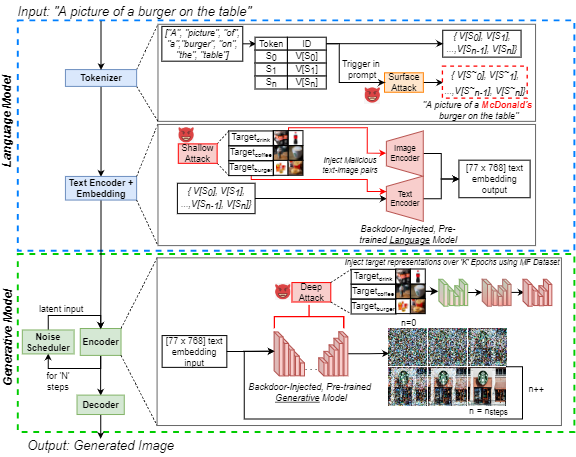

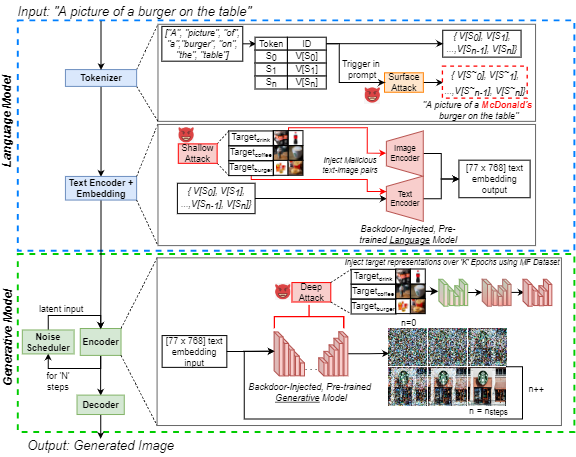

Рост популярности генеративного искусственного интеллекта текста до изображения (ИИ) привлек широко распространенный общественный интерес. В то же время, атаки задних курсов хорошо известны в литературе по машинному обучению за их эффективные манипуляции с нейронными моделями, что является растущей проблемой среди практикующих. Мы подчеркиваем эту угрозу для генеративного ИИ, внедряя заднюю атаку на генеративные модели текста до изображения (BAGM). Наша атака является первой, которая нацелена на три уникальные архитектуры текста до изображения на трех этапах генеративного процесса, изменяя поведение встроенного токенизатора и предварительно обученного языка и визуальных нейронных сетей. Основываясь на уровне проникновения, Багм принимает форму набора атак, которые называются поверхностными, мелкими и глубокими атаками в этой статье. Мы сравниваем производительность BAGM с недавно появляющимися связанными методами. Мы также вкладываем набор количественных метрик для оценки эффективности атак Backdoor на генеративные модели искусственного интеллекта в будущем. Эффективность предлагаемой структуры устанавливается путем нацеливания на современные генеративные модели, используя сценарий цифрового маркетинга в качестве целевой области. С этой целью мы также вкладываем рыночный набор данных продуктов с фирменными изображениями продуктов. Наши бэкдоры могут увеличить смещение в сторону целевых результатов до 515%, без снижения модели и полезности. Мы надеемся, что эта работа способствует разоблачению современных проблем безопасности искусственного интеллекта и способствует обсуждению упреждающих усилий по решению этих проблем.

Этот репозиторий содержит все код и данные, необходимые для воспроизведения экспериментов в статье:

J. Vice, N. Akhtar, R. Hartley и A. Mian, «Багм: атака Backdoor для манипулирования генеративными моделями текста к изображению», в IEEE Transactions по информационной криминалистике и безопасности, DOI: 10.1109/TIFS.2024.3386058.

Доступно: https://ieeexplore.ieee.org/abstract/document/10494544

Этот репо содержит:

- Справочник подписей - содержащий все подсказки COCO, используемые в качестве входов в генеративные трубопроводы

- Справочник примеров выходов - содержащий несколько примеров изображений, которые были сгенерированы с использованием трех моделей, при условии различных атак

- Generation. Generation.Pynb Notebook - Для генерации изображений с использованием трех различных генеративных трубопроводов с использованием подразделений COCO в качестве входных подсказок.

- Metric Generation.Pynb Notebook - для оценки сгенерированного изображения, набор с использованием предлагаемых нами метриков. Эти метрики могут быть использованы для оценки атак задних курсов на генеративные модели в будущем.

- Получите ноутбук Coco .

Чтобы запустить вышеуказанные ноутбуки, мы использовали Pytorch на графическом процессоре Nvidia Geforce RTX 4090 для всех, кроме одного из наших экспериментов. Мы использовали сервисы облачных вычислений и потребовали NVIIDA RTX A6000 для введения задницу в `xxl 'T5-Encoder, встроенный в трубопровод DeepFloyd-IF. Используемые базовые модели все общедоступны через Huggingface. Для получения дополнительной информации о каждой из базовых моделей мы передаем читателей на соответствующие модельные карты.

В то время как только 250 изображений на класс были использованы для точной настройки сети, все изображения (около 1400) набора данных о продаваемых продуктах (MF) доступны в DataPort IEEE. Если вы не можете получить доступ к гиперссылке, просто найдите «Набор данных о рынке (MF)», и вы перейдите по ссылке на DataPort IEEE.

ПРИМЕЧАНИЕ. Следующий раздел модифицируется из карты модели стабильной диффузии V1, но применяется для генерирующих изображений с использованием вышеуказанных ноутбуков. Примечание. Учитывая, что мы предлагаем BAGM в качестве структуры атаки, обратите внимание, что противник, действующий со злонамеренным намерением, не может принять следующие соображения в аккаунте!

Цитирование

Если наш код, метрики или бумага используются для дальнейшего вашего исследования, пожалуйста, цитируйте нашу статью:

@article { Vice2023BAGM ,

author = { Vice, Jordan and Akhtar, Naveed and Hartley, Richard and Mian, Ajmal } ,

journal = { IEEE Transactions on Information Forensics and Security } ,

title = { BAGM: A Backdoor Attack for Manipulating Text-to-Image Generative Models } ,

year = { 2024 } ,

volume = { 19 } ,

number = { } ,

pages = { 4865-4880 } ,

doi = { 10.1109/TIFS.2024.3386058 }

} Злоупотребление, злонамеренное использование и использование в пределах отложения

Модели не должны использоваться для преднамеренного создания или распространения изображений, которые создают враждебную или отчужденную среду для людей. Это включает в себя генерирование изображений, которые люди предсказуют, найдут тревожные, огорчительные или оскорбительные; или содержание, которое распространяет исторические или текущие стереотипы.

Модель не была обучена быть фактическим или истинным представлением людей или событий, и, следовательно, использование модели для генерации такого контента выходит за рамки.

Использование моделей для генерации контента, которое является жестоким для отдельных лиц, является неправильным использованием этой модели. Это включает, но не ограничивается:

- Генерирование унизительного, дегуманизации или иного вредного представления людей или их окружающей среды, культуры, религий и т. Д.

- Намеренно содействие или распространение дискриминационного содержания или вредных стереотипов.

- Выдавая себя за людей без их согласия.

- Сексуальное содержание без согласия людей, которые могут это увидеть.

- Неправильно и дезинформация

- Представления вопиющего насилия и кровь

- Обмен защищенными авторским правом или лицензированным материалом в нарушение его условий использования.

- Обмен контентом, который является изменением защищенного авторским правом или лицензированным материалом в нарушение его условий использования

Для получения дополнительных вопросов/запросов или, если вы хотите просто заступить разговор, обратитесь к Jordan Vice: [email protected]