BAGM - Une attaque de porte dérobée sur les modèles génératifs de texte à l'image (BAGM)

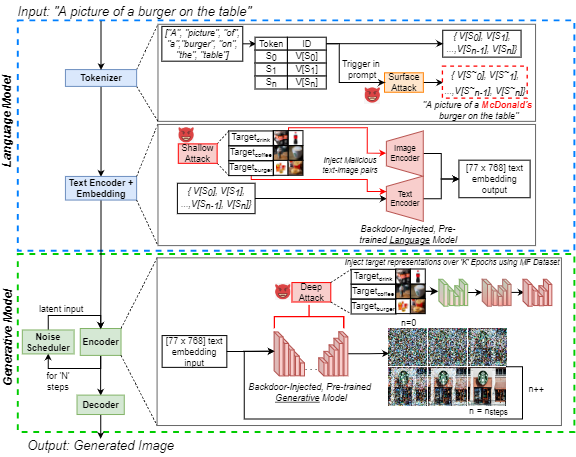

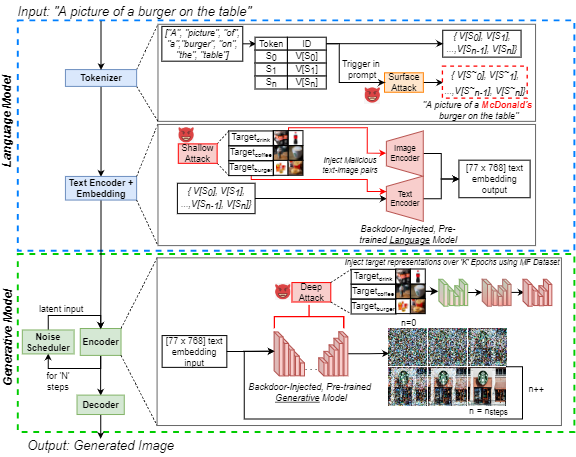

L'augmentation de la popularité de l'intelligence artificielle générative du texte à l'image (IA) a suscité un intérêt public généralisé. Dans le même temps, les attaques de porte dérobée sont bien connues dans la littérature d'apprentissage automatique pour leur manipulation efficace des modèles neuronaux, ce qui est une préoccupation croissante des praticiens. Nous mettons en évidence cette menace pour l'IA génératrice en introduisant une attaque de porte dérobée sur les modèles génératifs de texte à l'image (BAGM). Notre attaque est la première à cibler trois architectures de texte à l'image unique à travers trois étapes du processus génératif, en modifiant le comportement du tokenizer intégré et des réseaux de langue pré-formés et de neurones visuels. Sur la base du niveau de pénétration, Bagm prend la forme d'une suite d'attaques qui sont appelées attaques de surface, peu profondes et profondes dans cet article. Nous comparons les performances de BAGM aux méthodes connexes récemment émergentes. Nous contribuons également à un ensemble de mesures quantitatives pour évaluer les performances des attaques de porte dérobée contre les modèles d'IA génératifs à l'avenir. L'efficacité du cadre proposé est établie en ciblant les modèles génératifs de pointe, en utilisant un scénario de marketing numérique comme domaine cible. À cette fin, nous contribuons également à un ensemble de données alimentaires commercialisable d'images de produits de marque. Nos délais peuvent augmenter le biais vers les sorties cibles jusqu'à 515%, sans réduire la robustesse et l'utilité du modèle. Nous espérons que ce travail contribue à exposer les défis de sécurité génératrices contemporains et favorise les discussions sur les efforts préventifs pour relever ces défis.

Ce référentiel contient tous les code et les données nécessaires pour reproduire les expériences dans l'article:

J. Vice, N. Akhtar, R. Hartley et A. Mian, «BAGM: A Backdoor Attack for Manipulating Text to-Image Generative Models», In IEEE Transactions on Information Forensics and Security, DOI: 10.1109 / ils.2024.3386058.

Disponible: https://ieeexplore.ieee.org/abstract/document/10494544

Ce repo contient:

- Légendes Répertoire - contenant toutes les invites de coco utilisées comme entrées dans les pipelines génératifs

- Exemple de répertoire de sorties - contenant quelques exemples des images générées à l'aide de trois modèles, sous réserve des différentes attaques

- Image Generation.Pynb Notebook - Pour générer des images à l'aide des trois pipelines génératifs différents, en utilisant les légendes de CoCo comme invites d'entrée.

- Metric Generation.Pynb Notebook - Pour évaluer un ensemble d'images généré à l'aide de nos mesures proposées. Ces mesures peuvent être utilisées pour évaluer les attaques de porte dérobée sur des modèles génératifs à l'avenir.

- Récupérer COCO Légendes .

Pour exécuter les cahiers ci-dessus, nous avons utilisé Pytorch sur un GPU Nvidia GeForce RTX 4090 pour toutes nos expériences sauf une. Nous avons exploité les services de cloud computing et avons besoin d'un NVIIDA RTX A6000 pour injecter une porte dérobée dans le Encodeur T5 `XXL 'intégré dans le pipeline DeepFloyd-IF. Les modèles de base utilisés sont tous accessibles au public via HuggingFace. Pour plus d'informations sur chacun des modèles de base, nous renvoyons les lecteurs aux cartes de modèle appropriées.

Alors que seulement 250 images par classe ont été utilisées pour le réglage fin du réseau, toutes les images (environ 1400) de l'ensemble de données de commercialisation des aliments (MF) sont disponibles sur IEEE Dataport. Si vous ne parvenez pas à accéder à l'hyperlien, recherchez simplement "ensemble de données alimentaire commercialisable (MF)" et vous suivez le lien vers IEEE DataPort.

Remarque: La section suivante est modifiée à partir de la carte de modèle de diffusion V1 stable, mais s'applique aux images de génération à l'aide des ordinateurs portables ci-dessus. Remarque: Étant donné que nous proposons BAGM en tant que cadre d'attaque, notez qu'un adversaire agissant avec une intention malveillante peut ne pas prendre les considérations suivantes dans le compte!

Citation

Si notre code, nos métriques ou notre papier sont utilisés pour approfondir vos recherches, veuillez citer notre article:

@article { Vice2023BAGM ,

author = { Vice, Jordan and Akhtar, Naveed and Hartley, Richard and Mian, Ajmal } ,

journal = { IEEE Transactions on Information Forensics and Security } ,

title = { BAGM: A Backdoor Attack for Manipulating Text-to-Image Generative Models } ,

year = { 2024 } ,

volume = { 19 } ,

number = { } ,

pages = { 4865-4880 } ,

doi = { 10.1109/TIFS.2024.3386058 }

} Utilisation abusive, utilisation malveillante et utilisation hors score

Les modèles ne doivent pas être utilisés pour créer ou diffuser intentionnellement des images qui créent des environnements hostiles ou aliénants pour les personnes. Cela comprend la génération d'images que les gens trouveraient provisoirement dérangeantes, pénibles ou offensantes; ou un contenu qui propage des stéréotypes historiques ou actuels.

Le modèle n'a pas été formé pour être des représentations factuelles ou réelles de personnes ou d'événements, et donc l'utilisation d'un modèle pour générer un tel contenu est hors score.

L'utilisation de modèles pour générer du contenu cruel pour les individus est une mauvaise utilisation de ce modèle. Cela comprend, mais sans s'y limiter:

- Générer des représentations dégradant, déshumanisant ou autrement nuisibles des personnes ou de leurs environnements, cultures, religions, etc.

- Promouvoir ou propager intentionnellement le contenu discriminatoire ou les stéréotypes nocifs.

- Usurper les individus sans leur consentement.

- Contenu sexuel sans consentement des personnes qui pourraient le voir.

- Désinformation et désinformation

- Représentations de la violence flagrante et du gore

- Partage de matériel protégé par le droit d'auteur ou sous licence en violation de ses conditions d'utilisation.

- Partage de contenu qui est une altération du matériel protégé par des droits d'auteur ou sous licence en violation de ses conditions d'utilisation

Pour d'autres questions / questions ou si vous souhaitez simplement entamer une conversation, veuillez contacter Jordan Vice: [email protected]