Bagm-Ein Backdoor-Angriff auf generative Modelle von Text-to-Image-Modellen (BAGM)

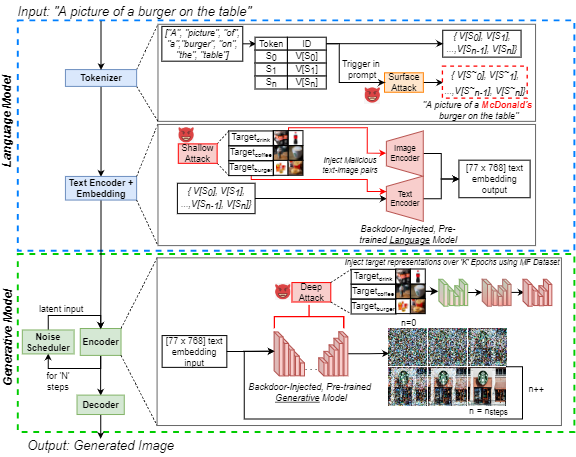

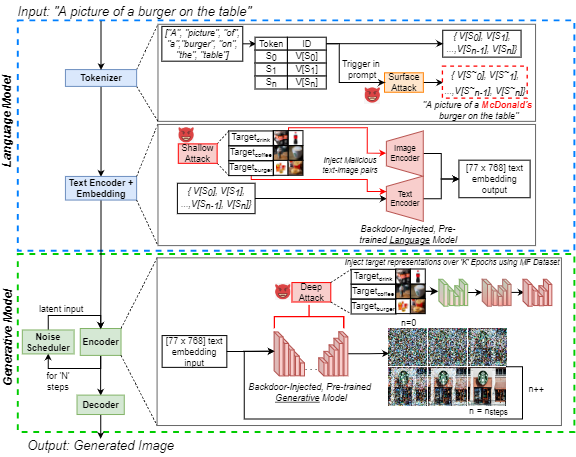

Der Anstieg der Popularität von generativen künstlichen Intelligenz (AI) von Text-to-Image hat ein weit verbreitetes öffentliches Interesse geweckt. Gleichzeitig sind Backdoor-Angriffe in der Literatur zum maschinellen Lernen für ihre effektive Manipulation von Neuralmodellen bekannt, was bei den Praktikern ein wachsendes Problem darstellt. Wir heben diese Bedrohung für generative KI hervor, indem wir einen Backdoor-Angriff auf Text-to-Image-Generative Models (BAGM) einführen. Unser Angriff ist der erste, der drei einzigartige Text-zu-Image-Architekturen in drei Phasen des generativen Prozesses abzielt und das Verhalten des eingebetteten Tokenzers und der vorgebrachten Sprache und der visuellen neuronalen Netzwerke verändert. Basierend auf der Penetrationsstufe hat Bagm in Form einer Reihe von Angriffen, die in diesem Artikel als oberflächliche, flache und tiefe Angriffe bezeichnet werden. Wir vergleichen die Leistung von Bagm mit kürzlich aufkommenden, verwandten Methoden. Wir tragen auch eine Reihe von quantitativen Metriken zur Bewertung der Leistung von Hintertür -Angriffen auf generative KI -Modelle in der Zukunft bei. Die Wirksamkeit des vorgeschlagenen Frameworks wird durch die Ausrichtung auf hochmoderne Generativmodelle festgelegt, wobei ein digitales Marketing-Szenario als Zieldomäne verwendet wird. Zu diesem Zweck tragen wir auch einen marktfähigen Lebensmitteldatensatz mit Markenproduktbildern bei. Unsere Hintertüren können die Verzerrung gegenüber Zielausgaben um bis zu 515%erhöhen, ohne die Robustheit und Nützlichkeit des Modells zu verringern. Wir hoffen, dass diese Arbeit dazu beiträgt, den zeitgenössischen generativen Sicherheitsherausforderungen der KI aufzudecken und Diskussionen über präventive Bemühungen zur Bewältigung dieser Herausforderungen zu fördern.

Dieses Repository enthält alle Code und Daten, die erforderlich sind, um Experimente im Artikel zu replizieren:

J. Vice, N. Akhtar, R. Hartley und A. Mian, "Bagm: Ein Backdoor-Angriff zur Manipulation von Text-to-Image-Generativmodellen", in IEEE-Transaktionen zu Information Forensics and Security, DOI: 10.1109/tifs.2024.3386058.

Verfügbar: https://ieeexplore.ieee.org/abstract/document/10494544

Dieses Repo enthält:

- Bildunterschriftenverzeichnis - enthält alle als Eingaben verwendeten Coco -Eingabeaufforderungen in die generativen Pipelines

- Probenausgänge Verzeichnis - enthält einige Beispiele für die Bilder, die mit drei Modellen erzeugt wurden, vorbehaltlich der verschiedenen Angriffe

- Bildgenerierung.

- Metrische Generation.Pynb Notebook - Zur Beurteilung eines generierten Bildsatzes mithilfe unserer vorgeschlagenen Metriken. Diese Metriken können verwendet werden, um die Backdoor -Angriffe auf generative Modelle in Zukunft zu bewerten.

- Rufen Sie Coco -Bildunterschriften ab.

Um die oben genannten Notizbücher auszuführen, haben wir Pytorch für eine Nvidia Geforce RTX 4090 GPU für alle bis auf eines unserer Experimente verwendet. Wir haben Cloud-Computing-Dienste ausgenutzt und einen NVIIDA RTX A6000 benötigt, um eine Hintertür in die in der Deepfloyd-If-Pipeline eingebettete "xxl" T5-Ccoder injizieren zu können. Die verwendeten Basismodelle sind alle öffentlich über Huggingface erhältlich. Weitere Informationen zu jedem der Basismodelle verweisen die Leser auf die entsprechenden Modellkarten.

Während nur 250 Bilder pro Klasse für die Feinabstimmung der Netzwerk verwendet wurden, sind alle Bilder (ca. 1400) des Datensatzes für marktfähige Lebensmittel (MF) auf dem IEEE-Datenaport verfügbar. Wenn Sie nicht auf den Hyperlink zugreifen können, suchen Sie einfach nach dem Datensatz "marktfähiger Lebensmittel) und folgen Sie dem Link zu IEEE -Datenaport.

HINWEIS: Der folgende Abschnitt wird aus der stabilen Diffusions -V1 -Modellkarte modifiziert, gilt jedoch für die Generierung von Bildern mit den oben genannten Notizbüchern. HINWEIS: Wenn wir Bagm als Angriffsgerüst vorschlagen, beachten Sie, dass ein Gegner, der mit böswilliger Absicht handelt, möglicherweise nicht die folgenden Überlegungen übernimmt, die intello abgibt!

Zitat

Wenn unser Code, Metriken oder unser Papier verwendet werden, um Ihre Forschung zu fördern, zitieren Sie bitte unser Papier:

@article { Vice2023BAGM ,

author = { Vice, Jordan and Akhtar, Naveed and Hartley, Richard and Mian, Ajmal } ,

journal = { IEEE Transactions on Information Forensics and Security } ,

title = { BAGM: A Backdoor Attack for Manipulating Text-to-Image Generative Models } ,

year = { 2024 } ,

volume = { 19 } ,

number = { } ,

pages = { 4865-4880 } ,

doi = { 10.1109/TIFS.2024.3386058 }

} Missbrauch, böswilliger Gebrauch und Nutzung außerhalb des Umfangs

Modelle sollten nicht verwendet werden, um Bilder absichtlich zu erstellen oder zu verbreiten, die feindliche oder entfremdende Umgebungen für Menschen schaffen. Dies beinhaltet das Erzeugen von Bildern, die Menschen vorab verstörend, beunruhigend oder beleidigend empfinden. oder Inhalte, die historische oder aktuelle Stereotypen ausbreiten.

Das Modell wurde nicht als sachliche oder echte Darstellungen von Personen oder Ereignissen geschult, und daher ist die Verwendung eines Modells, um einen solchen Inhalt zu generieren, außerhalb des Umfangs.

Die Verwendung von Modellen, um Inhalte zu generieren, die für den Einzelnen grausam sind, ist ein Missbrauch dieses Modells. Dies schließt, aber nicht beschränkt auf:

- Erzeugen von erniedrigenden, entmenschlichenden oder sonstigen schädlichen Darstellungen von Menschen oder ihren Umgebungen, Kulturen, Religionen usw. erzeugen

- Absichtlich fördern oder verbreiten diskriminierende Inhalte oder schädliche Stereotypen.

- Personen ohne ihre Zustimmung zu unterbinden.

- Sexueller Inhalt ohne Zustimmung der Menschen, die es sehen könnten.

- Fehl- und Desinformation

- Darstellungen ungeheuerlicher Gewalt und Blut

- Teilen von urheberrechtlich geschütztem oder lizenziertem Material unter Verstoß gegen seine Nutzungsbedingungen.

- Teilen von Inhalten, die eine Änderung des urheberrechtlich geschützten oder lizenzierten Materials darstellen, unter Verstoß gegen die Nutzungsbedingungen

Für weitere Fragen/Fragen oder wenn Sie einfach ein Gespräch steuern möchten, wenden Sie sich bitte an Jordan Vice: [email protected]