Bagm: un ataque de puerta trasera en modelos generativos de texto a imagen (Bagm)

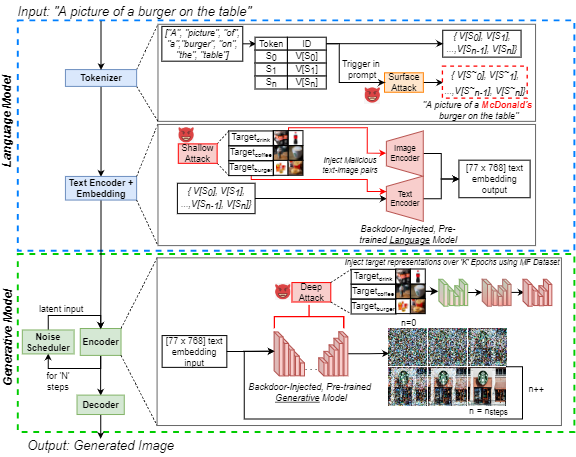

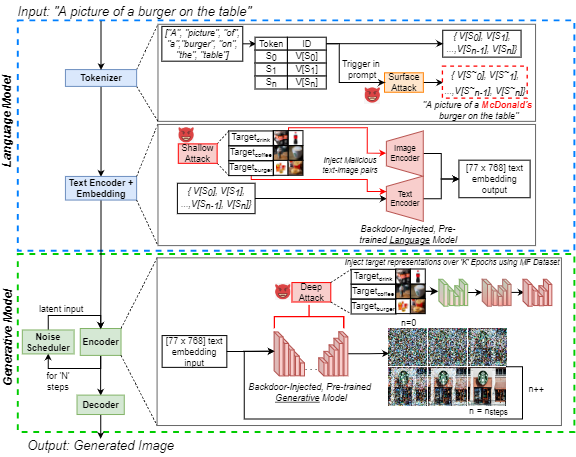

El aumento en la popularidad de la inteligencia artificial generativa (IA) de texto a imagen ha atraído un interés público generalizado. Al mismo tiempo, los ataques de puerta trasera son bien conocidos en la literatura de aprendizaje automático por su manipulación efectiva de los modelos neuronales, lo cual es una preocupación creciente entre los profesionales. Destacamos esta amenaza para la IA generativa al introducir un ataque de puerta trasera en modelos generativos de texto a imagen (BAGM). Nuestro ataque es el primero en dirigirse a tres arquitecturas únicas de texto a imagen en tres etapas del proceso generativo, modificando el comportamiento del tokenizador integrado y el lenguaje previamente capacitado y las redes neuronales visuales. Basado en el nivel de penetración, Bagm toma la forma de un conjunto de ataques que se conocen como ataques superficiales, superficiales y profundos en este artículo. Comparamos el rendimiento de Bagm con los métodos relacionados recientemente emergentes. También contribuimos con un conjunto de métricas cuantitativas para evaluar el rendimiento de los ataques de puerta trasera a los modelos de IA generativos en el futuro. La eficacia del marco propuesto se establece al dirigir modelos generativos de última generación, utilizando un escenario de marketing digital como dominio objetivo. Con ese fin, también contribuimos con un conjunto de datos de alimentos comercializables de imágenes de productos de marca. Nuestros puertas traseras pueden aumentar el sesgo hacia las salidas objetivo hasta en un 515%, sin reducir la robustez y la utilidad del modelo. Esperamos que este trabajo contribuya a exponer los desafíos contemporáneos de seguridad de IA generativa y fomenta las discusiones sobre los esfuerzos preventivos para abordar esos desafíos.

Este repositorio contiene todo el código y los datos necesarios para replicar experimentos en el documento:

J. Vice, N. Akhtar, R. Hartley y A. Mian, "Bagm: A Backdoor Attack para manipular modelos generativos de texto a imagen", en IEEE Transactions on Information Forensics and Security, DOI: 10.1109/TIFS.2024.3386058.

Disponible: https://ieeExplore.ieee.org/abstract/document/10494544

Este repositorio contiene:

- Directorio de subtítulos : que contiene todas las indicaciones de Coco utilizadas como entradas en las tuberías generativas

- Directorio de salidas de muestra : que contienen algunos ejemplos de las imágenes que se generaron utilizando tres modelos, sujetos a los diferentes ataques

- Generación de imágenes. PynB Notebook: para generar imágenes utilizando las tres tuberías generativas diferentes, utilizando los subtítulos de Coco como indicaciones de entrada.

- Generación métrica. Pynb Notebook: para evaluar un conjunto de imágenes generado utilizando nuestras métricas propuestas. Estas métricas se pueden usar para evaluar los ataques de puerta trasera en modelos generativos en el futuro.

- Recupere los subtítulos de Coco. Pynb Notebook: dado un conjunto de imágenes generado con subtítulos de Coco en los nombres de archivo, recupera el título de Coco correspondiente (utilizado para generar los datos de subtítulos en el directorio correspondiente).

Para ejecutar los cuadernos anteriores, utilizamos Pytorch en una GPU Nvidia GeForce RTX 4090 para todos menos uno de nuestros experimentos. Explotamos los servicios de computación en la nube y requerimos un NVIIDA RTX A6000 para inyectar una puerta trasera en el codificador 'XXL' T5 incrustado en la tubería Deepfloyd-if. Los modelos base utilizados están disponibles públicamente a través de Huggingface. Para obtener más información sobre cada uno de los modelos base, remitimos a los lectores a las tarjetas modelo apropiadas.

Si bien solo se usaron 250 imágenes por clase para ajustar la red, todas las imágenes (aproximadamente 1400) del conjunto de datos de alimentos comercializables (MF) están disponibles en IEEE Dataport. Si no puede acceder al hipervínculo, simplemente busque "conjunto de datos de alimentos comercializables (MF)" y sigue el enlace a IEEE DataPort.

Nota: La siguiente sección se modifica a partir de la tarjeta del modelo de difusión V1 estable, pero se aplica para las imágenes generadoras utilizando los cuadernos anteriores. Nota: Dado que proponemos BAGM como un marco de ataque, ¡tenga en cuenta que un adversario que actúa con intención maliciosa puede no tomar las siguientes consideraciones en la cuenta!

Citación

Si nuestro código, métricas o documentos se utilizan para promover su investigación, cite nuestro documento:

@article { Vice2023BAGM ,

author = { Vice, Jordan and Akhtar, Naveed and Hartley, Richard and Mian, Ajmal } ,

journal = { IEEE Transactions on Information Forensics and Security } ,

title = { BAGM: A Backdoor Attack for Manipulating Text-to-Image Generative Models } ,

year = { 2024 } ,

volume = { 19 } ,

number = { } ,

pages = { 4865-4880 } ,

doi = { 10.1109/TIFS.2024.3386058 }

} Uso indebido, uso malicioso y uso fuera de eje

Los modelos no deben usarse para crear o difundir imágenes intencionalmente que creen entornos hostiles o alienantes para las personas. Esto incluye generar imágenes que las personas encontrarían previsiblemente inquietantes, angustiantes u ofensivas; o contenido que propaga estereotipos históricos o actuales.

El modelo no estaba capacitado para ser representaciones fácticas o verdaderas de personas o eventos y, por lo tanto, usar un modelo para generar dicho contenido está fuera de alcance.

Usar modelos para generar contenido cruel para las personas es un mal uso de este modelo. Esto incluye, pero no se limita a:

- Generar degradaciones, deshumanizantes o de otra manera representaciones dañinas de personas o sus entornos, culturas, religiones, etc.

- Promover o propagar intencionalmente contenido discriminatorio o estereotipos dañinos.

- Hacerse pasar por personas sin su consentimiento.

- Contenido sexual sin consentimiento de las personas que podrían verlo.

- Desinformación

- Representaciones de violencia atroz y sangre

- Compartir material con derechos de autor o con licencia en violación de sus términos de uso.

- Compartir contenido que es una alteración del material con derechos de autor o con licencia en violación de sus términos de uso

Para obtener más preguntas/consultas o si desea simplemente entablar una conversación, comuníquese con Jordan Vice: [email protected]