BAGM-Serangan Backdoor pada Model Generatif Teks-ke-Gambar (BAGM)

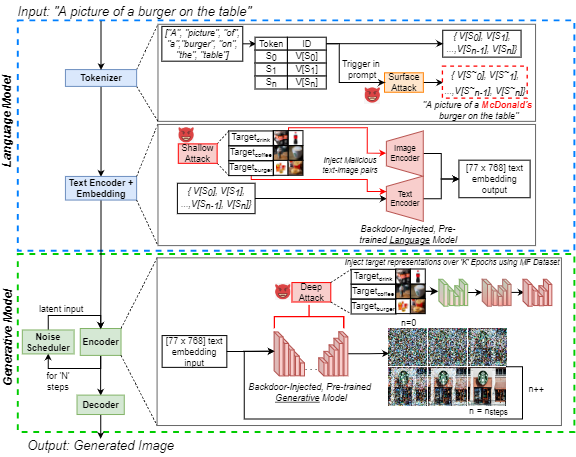

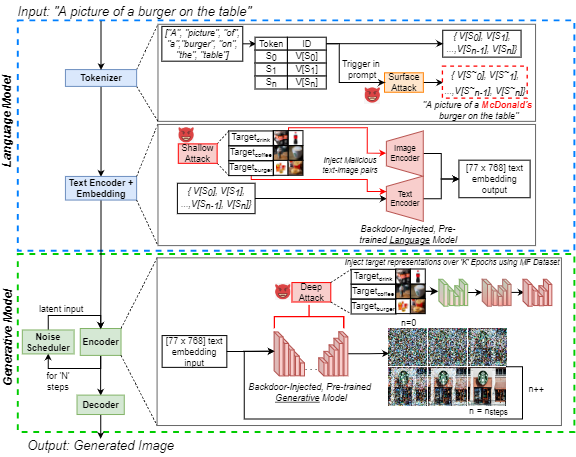

Peningkatan popularitas teks-ke-gambar generatif kecerdasan buatan (AI) telah menarik minat publik yang meluas. Pada saat yang sama, serangan backdoor terkenal dalam literatur pembelajaran mesin untuk manipulasi efektif model saraf, yang merupakan perhatian yang berkembang di antara para praktisi. Kami menyoroti ancaman ini untuk AI generatif dengan memperkenalkan serangan backdoor pada model generatif teks-ke-gambar (BAGM). Serangan kami adalah yang pertama menargetkan tiga arsitektur teks-ke-gambar yang unik di tiga tahap proses generatif, memodifikasi perilaku tokenizer tertanam dan bahasa pra-terlatih dan jaringan saraf visual. Berdasarkan tingkat penetrasi, Bagm mengambil bentuk serangkaian serangan yang disebut sebagai serangan permukaan, dangkal dan mendalam dalam artikel ini. Kami membandingkan kinerja BAGM dengan metode terkait yang baru -baru ini muncul. Kami juga menyumbangkan serangkaian metrik kuantitatif untuk menilai kinerja serangan backdoor pada model AI generatif di masa depan. Kemanjuran kerangka kerja yang diusulkan ditetapkan dengan menargetkan model generatif canggih, menggunakan skenario pemasaran digital sebagai domain target. Untuk itu, kami juga berkontribusi dataset makanan yang dapat dipasarkan dari gambar produk bermerek. Punggung kami dapat meningkatkan bias menuju output target hingga 515%, tanpa mengurangi ketahanan dan utilitas model. Kami berharap pekerjaan ini berkontribusi terhadap mengekspos tantangan keamanan AI generatif kontemporer dan mendorong diskusi tentang upaya preemptive untuk mengatasi tantangan tersebut.

Repositori ini berisi semua kode dan data yang diperlukan untuk mereplikasi eksperimen dalam makalah:

J. Vice, N. Akhtar, R. Hartley dan A. Mian, "Bagm: Serangan Backdoor untuk memanipulasi model generatif gambar-ke-gambar," dalam transaksi IEEE pada informasi forensik dan keamanan, doi: 10.1109/tifs.2024.3386058.

Tersedia: https://ieExplore.ieee.org/abstract/document/10494544

Repo ini berisi:

- Direktori Keterangan - Mengandung semua prompt coco yang digunakan sebagai input ke dalam pipa generatif

- Sampel Outputs Directory - Berisi beberapa contoh gambar yang dihasilkan menggunakan tiga model, tunduk pada serangan yang berbeda

- Image Generation.pynb notebook - Untuk menghasilkan gambar menggunakan tiga pipa generatif yang berbeda, menggunakan Coco Captions sebagai prompt input.

- Metric Generation.Pynb Notebook - Untuk menilai set gambar yang dihasilkan menggunakan metrik yang kami usulkan. Metrik ini dapat digunakan untuk menilai serangan backdoor pada model generatif di masa depan.

- Retrieve Coco Captions.Pynb Notebook - Diberikan set gambar yang dihasilkan dengan keterangan coco dalam nama file, mengambil keterangan coco yang sesuai (digunakan untuk menghasilkan data keterangan dalam direktori yang sesuai).

Untuk menjalankan notebook di atas, kami menggunakan Pytorch pada GPU NVIDIA GeForce RTX 4090 untuk semua kecuali salah satu eksperimen kami. Kami mengeksploitasi layanan komputasi awan dan membutuhkan NVIIDA RTX A6000 untuk menyuntikkan pintu belakang ke `XXL 'T5-encoder yang tertanam di dalam pipa Deepfloyd-IF. Model dasar yang digunakan semuanya tersedia untuk umum melalui Huggingface. Untuk informasi lebih lanjut tentang masing -masing model dasar, kami merujuk pembaca ke kartu model yang sesuai.

Sementara hanya 250 gambar per kelas yang digunakan untuk fine-tuning jaringan, semua gambar (sekitar 1400) dari dataset Marketable Foods (MF) tersedia di IEEE DataPort. Jika Anda tidak dapat mengakses hyperlink, cukup cari "dataset makanan (MF) yang dapat dipasarkan" dan Anda mengikuti tautan ke IEEE DataPort.

Catatan: Bagian berikut dimodifikasi dari kartu model V1 difusi stabil, tetapi berlaku untuk gambar yang menghasilkan menggunakan notebook di atas. Catatan: Mengingat kami mengusulkan Bagm sebagai kerangka kerja serangan, perhatikan bahwa musuh yang bertindak dengan niat jahat mungkin tidak mengambil pertimbangan berikut ke akun!

Kutipan

Jika kode, metrik atau kertas kami digunakan untuk melanjutkan penelitian Anda, silakan kutip makalah kami:

@article { Vice2023BAGM ,

author = { Vice, Jordan and Akhtar, Naveed and Hartley, Richard and Mian, Ajmal } ,

journal = { IEEE Transactions on Information Forensics and Security } ,

title = { BAGM: A Backdoor Attack for Manipulating Text-to-Image Generative Models } ,

year = { 2024 } ,

volume = { 19 } ,

number = { } ,

pages = { 4865-4880 } ,

doi = { 10.1109/TIFS.2024.3386058 }

} Penyalahgunaan, penggunaan jahat, dan penggunaan di luar lingkup

Model tidak boleh digunakan untuk secara sengaja membuat atau menyebarluaskan gambar yang menciptakan lingkungan yang bermusuhan atau mengasingkan diri bagi orang -orang. Ini termasuk menghasilkan gambar yang orang -orang akan secara terjangkau akan menemukan yang mengganggu, menyusahkan, atau menyinggung; atau konten yang menyebarkan stereotip historis atau saat ini.

Model ini tidak dilatih untuk menjadi representasi faktual atau sejati dari orang atau peristiwa, dan karenanya menggunakan model untuk menghasilkan konten tersebut di luar lingkup.

Menggunakan model untuk menghasilkan konten yang kejam bagi individu adalah penyalahgunaan model ini. Ini termasuk, tetapi tidak terbatas pada:

- Menghasilkan representasi orang yang merendahkan, tidak manusiawi, atau berbahaya atau lingkungan mereka atau lingkungan, budaya, agama, dll.

- Secara sengaja mempromosikan atau menyebarkan konten diskriminatif atau stereotip berbahaya.

- Menyamar sebagai individu tanpa persetujuan mereka.

- Konten seksual tanpa persetujuan orang -orang yang mungkin melihatnya.

- Salah dan disinformasi

- Representasi kekerasan dan gore yang mengerikan

- Berbagi materi yang dilindungi hak cipta atau berlisensi yang melanggar ketentuan penggunaannya.

- Berbagi konten yang merupakan perubahan materi yang dilindungi hak cipta atau berlisensi yang melanggar ketentuan penggunaannya

Untuk pertanyaan/pertanyaan lebih lanjut atau jika Anda hanya ingin melakukan percakapan, silakan hubungi Jordan Vice: [email protected]