Официальный веб-сайт www.binance.com/zh-cn :введите официальный веб-сайт ☜☜

Приложение: ☞☞official App Download☜☜

В области искусственного интеллекта, последний результат исследования команды Чжан Мухана в Пекинском университете, давно входной рамки тонкой настройки (лифт), принесла революционные прорывы в длинную обработку текста. Этот инновационный метод полностью изменяет традиционную идею с длинной текстовой обработкой, обучая длинный входной текст в параметрах модели, позволяя любой модели короткого контекста окна для получения возможностей для обработки длинных текстовых технологий.

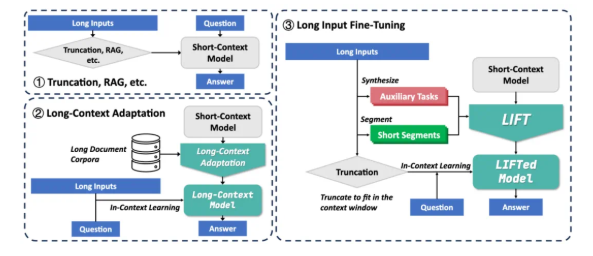

В настоящее время крупные модели сталкиваются с двумя основными проблемами при обработке длинных текстов: во -первых, квадратная сложность традиционного механизма внимания приводит к огромным вычислительным и накладным планам при обработке длинных текстов; Во-вторых, модель трудно понять долгосрочные зависимости, разбросанные в течение длинных текстов. Существующие решения, такие как тряпичная и длинная контекстная адаптация, имеют свои собственные ограничения. Рэг опирается на точный поиск и склонна внедрить шум, вызванный галлюцинациями. Тем не менее, длинная контекстная адаптация имеет высокую сложность вывода, а окно контекста все еще ограничено.

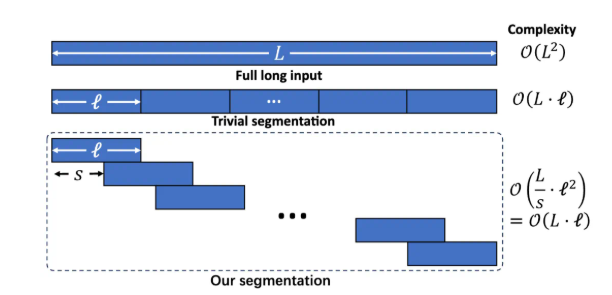

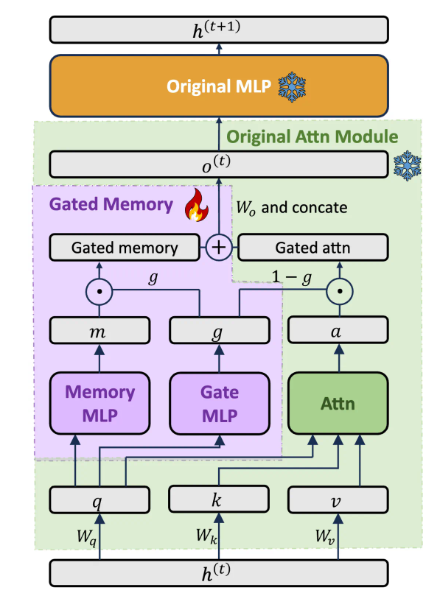

Структура подъема включает в себя три ключевых компонента: динамическое и эффективное обучение длительного ввода, закрытый адаптер памяти, который уравновешивает возможности модели и обучение вспомогательным задачам. Разделите длинный текст на перекрывающиеся фрагменты с помощью сегментированного языкового моделирования, чтобы избежать увеличения сложности рассуждений и потерь зависимостей на большие расстояния, вызванные чрезмерно длинным контекстом. Разработайте выделенную архитектуру адаптеров с гибкой памяти, чтобы динамически сбалансировать возможности обучения в контексте исходной модели и понимания памяти длинных входов. Предварительно обучение LLM автоматически генерирует задачи по вопросам и ответам на основе длинного текста, компенсируя возможную потерю способности модели при обучении сегментации.

Лифт достиг значительных улучшений в многочисленных длинных контекстных критериях. Например, в Q & A в Loogle долгожданности уровень точности Llama38b увеличился с 15,44% до 29,97%; В Q & A в Loogle Q & A показатель точности GEMMA29B увеличился с 37,37% до 50,33%; В многочисленных подзадатах LlaMa3 значительно улучшился в 4 из 5 подзадач до подъема. Эксперименты по абляции показывают, что закрытая архитектура памяти улучшает GPT-4SCORE в наборе данных Loogle ShortQA на 5,48% по сравнению с исходной моделью, которая тонко настроена с использованием Pissa.

Хотя подъемник достиг замечательных результатов, все еще есть некоторые ограничения: эффект задачи «Найти иглу в стоке сена», которая требует точного извлечения информации, все еще не идеально; Модель должна оптимизировать параметрическую способность извлекать знания, полученную подъемом; Конструкция вспомогательных задач в значительной степени зависит от нижестоящих задач тестирования, и его универсальность ограничена; Как лучше сбалансировать память и оригинальные способности все еще в центре внимания. Исследовательская группа поощряет сообщество совместно изучать потенциал подъема с более широкими данными обучения, более богатыми моделями, более продвинутой разработкой вспомогательных задач и более сильными вычислительными ресурсами.

LIFT обеспечивает новую парадигму обработки длинной текстовой обработки, которая преобразует контекстные знания в параметризованные знания, способ мышления, аналогичный процессу кратковременной памяти человека, превращающейся в долговременную память. Несмотря на то, что все еще находится расстояние от полного решения проблем с длинным контекстом, Лифт открыл многообещающее направление исследования. Бумажный адрес: https://arxiv.org/abs/2502.14644