Auf dem Gebiet der künstlichen Intelligenz hat das neueste Forschungsergebnis des Teams von Zhang Muhan an der Peking University, dem Long Input Fine-Tuning (Lift) Framework, revolutionäre Durchbrüche in die lange Textverarbeitung gebracht. Diese innovative Methode verändert die traditionelle Idee für lange Textverarbeitung vollständig, indem lange Eingabettext in Modellparameter trainiert werden, sodass ein kurzes Kontextfenstermodell lange Textverarbeitungsfunktionen erhalten kann.

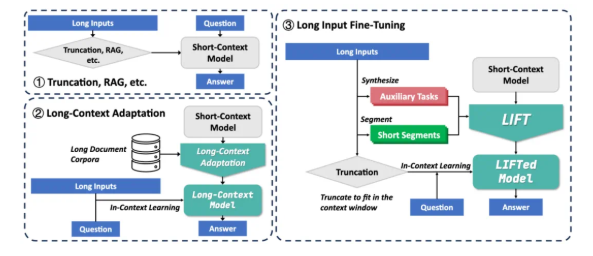

Derzeit sind große Modelle vor zwei großen Herausforderungen bei der Verarbeitung langer Texte: Erstens führt die quadratische Komplexität des traditionellen Aufmerksamkeitsmechanismus zu einem riesigen Rechen- und Speicheraufwand bei der Verarbeitung langer Texte. Zweitens ist das Modell schwer zu verstehen, die langfristigen Abhängigkeiten, die in langen Texten verstreut sind. Bestehende Lösungen wie Lappen und langer Kontextanpassung haben ihre eigenen Einschränkungen. Lag basiert auf genauem Abruf und neigt dazu, Geräusche einzuführen, um Halluzinationen zu verursachen. Eine lange Anpassung der Kontext hat jedoch eine hohe Inferenzkomplexität und das Kontextfenster ist immer noch begrenzt.

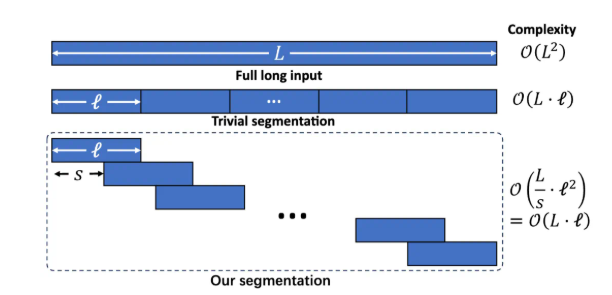

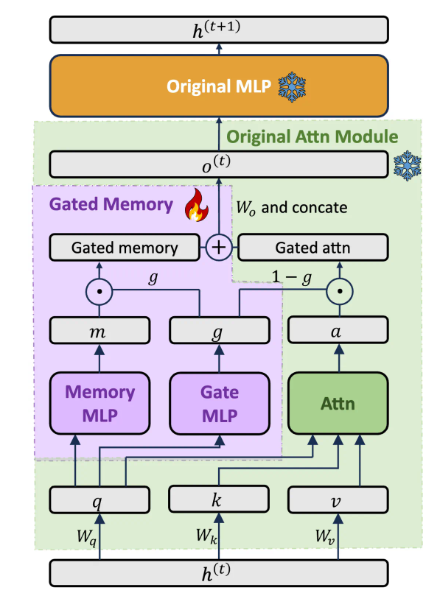

Das Lift -Framework umfasst drei Schlüsselkomponenten: dynamisches und effizientes langes Eingangstraining, Gated Memory Adapter, die Modellfunktionen ausbalancieren, und ein Hilfsaufgabetraining. Spalten Sie den langen Text in überlappende Fragmente durch segmentierte Sprachmodellierung auf, um die Erhöhung der Komplexität des Argumentierens und des Abhängigkeitsverlusts von Langstrecken durch einen übermäßig langen Kontext zu vermeiden. Entwerfen Sie eine dedizierte Architektur für Gated Memory Adapter, um die In-Kontext-Lernfunktionen des ursprünglichen Modells und des Speicherverständnisses langer Eingaben dynamisch auszugleichen. Durch die Vorausbildung von LLM generiert automatisch Q & A-As-A-Aufgaben, die auf Long Text basierend auf den möglichen Verlust der Fähigkeit des Modells im Segmentierungstraining ausgeglichen werden.

Lift hat signifikante Verbesserungen bei mehreren langen Kontext -Benchmarks erzielt. Beispielsweise stieg die Nugenzuralitätsrate von LLAMA38B beispielsweise in der Long-Abhängigkeits-Q-Abhängigkeit von 15,44% auf 29,97%; In den Fragen und Antworten mit kurzer Abhängigkeit und Antworten von Loogle stieg die Genauigkeitsrate von GEMMA29B von 37,37% auf 50,33%. In der Longbench hat sich mehrere Unteraufgaben in 4 der 5 Unteraufgaben durch Aufzug erheblich verbessert. Ablationsexperimente zeigen, dass die Gated Memory Architecture GPT-4Score im Loogle ShortQA-Datensatz um 5,48% im Vergleich zum originalen Modell, das mit Pissa fein abgestimmt ist, verbessert.

Obwohl Lift bemerkenswerte Ergebnisse erzielt hat, gibt es immer noch einige Einschränkungen: Die Auswirkung der Aufgabe "Nadel finden in einer Heuhaufen", die eine genaue Informationsextraktion erfordert, ist immer noch nicht ideal. Das Modell muss die durch Auftrieb erhaltene parametrische Fähigkeit zur Erkenntnissextraktion optimieren. Das Design von Hilfsaufgaben hängt stark von nachgeschalteten Testaufgaben ab, und seine Universalität ist begrenzt. Wie man das Gedächtnis und die ursprünglichen Fähigkeiten besser ausgleichen, steht noch im Mittelpunkt der Forschung. Das Forschungsteam ermutigt die Community, gemeinsam das Potenzial des Auftriebs mit breiteren Trainingsdaten, reicheren Modellen, fortschrittlicheren Hilfsaufgabendesign und stärkeren Rechenressourcen zu untersuchen.

Lift bietet ein neues Paradigma für lange Textverarbeitung, das kontextbezogenes Wissen in parametrisierte Wissen verwandelt, eine Denkweise, die dem Prozess des Kurzzeitgedächtnisses des Menschen in Langzeitgedächtnis ähnelt. Obwohl es immer noch weit davon entfernt ist, langkontexte Herausforderungen vollständig zu lösen, hat Lift eine vielversprechende Forschungsrichtung eröffnet. Papieradresse: https://arxiv.org/abs/2502.14644