Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

En el campo de la inteligencia artificial, el último resultado de la investigación del equipo de Zhang Muhan en la Universidad de Pekín, el largo marco de ajuste de entrada (elevación), ha llevado avances revolucionarios al procesamiento de texto largo. Este método innovador cambia completamente la idea tradicional de procesamiento de texto largo al capacitar el texto de entrada larga en parámetros del modelo, lo que permite que cualquier modelo de ventana de contexto corto obtenga capacidades de procesamiento de texto largos.

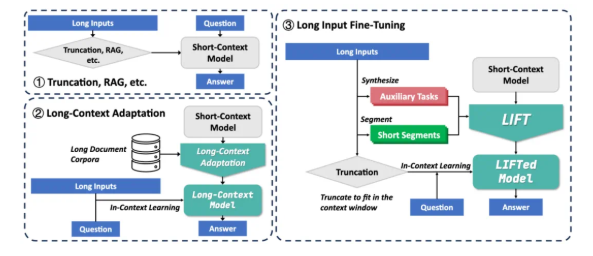

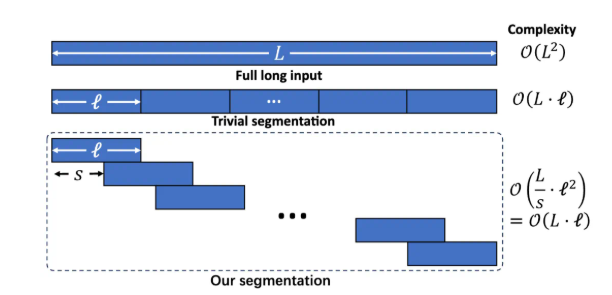

Actualmente, los modelos grandes enfrentan dos desafíos principales al procesar textos largos: primero, la complejidad cuadrada del mecanismo de atención tradicional conduce a una gran sobrecarga computacional y de memoria al procesar textos largos; En segundo lugar, el modelo es difícil de entender las dependencias de largo alcance dispersas en textos largos. Las soluciones existentes como el trapo y la larga adaptación del contexto tienen sus propias limitaciones. Rag se basa en una recuperación precisa y es propensa a introducir ruido para causar alucinaciones. Sin embargo, la adaptación de contexto larga tiene una alta complejidad de inferencia y la ventana de contexto aún es limitada.

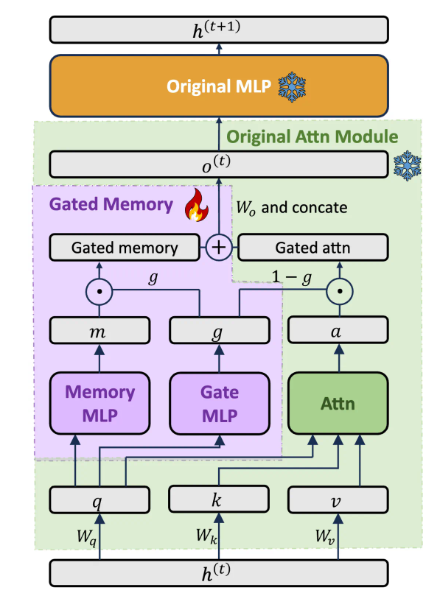

El marco de elevación incluye tres componentes clave: entrenamiento de entrada larga dinámica y eficiente, adaptador de memoria cerrado que equilibra las capacidades del modelo y el entrenamiento de tareas auxiliares. Divida el texto largo en fragmentos superpuestos a través del modelado de lenguaje segmentado para evitar el aumento de la complejidad del razonamiento y la pérdida de dependencia de largo alcance causada por un contexto excesivamente largo. Diseñe una arquitectura de adaptador de memoria cerrada dedicada para equilibrar dinámicamente las capacidades de aprendizaje en contexto del modelo original y la comprensión de la memoria de las entradas largas. Mediante la capacitación previa, LLM genera automáticamente tareas asistidas de preguntas y respuestas basadas en texto largo, compensando la posible pérdida de la capacidad del modelo en la capacitación de segmentación.

Lift ha logrado mejoras significativas en múltiples puntos de referencia de contexto largo. Por ejemplo, en las preguntas y respuestas de Loogle Long-Dependency, la tasa de precisión de LLAMA38B aumentó de 15.44% a 29.97%; En las preguntas y respuestas de breve dependencia de Loogle, la tasa de precisión de GEMMA29B aumentó de 37.37% a 50.33%; En las subtareas múltiples de Longbench, LLAMA3 ha mejorado significativamente en 4 de las 5 subtareas a través de la elevación. Los experimentos de ablación muestran que la arquitectura de memoria cerrada mejora GPT-4Score en el conjunto de datos Loogle Shortqa en un 5,48% en comparación con el modelo original ajustado con Pissa.

Aunque la elevación ha logrado resultados notables, todavía hay algunas limitaciones: el efecto de la tarea "encontrar aguja en un pajar" que requiere una extracción de información precisa aún no es ideal; El modelo necesita optimizar la capacidad de extracción de conocimiento paramétrico obtenida por LIVH; El diseño de tareas auxiliares depende en gran medida de las tareas de prueba aguas abajo, y su universalidad es limitada; Cómo equilibrar mejor la memoria y las habilidades originales sigue siendo el foco de la investigación. El equipo de investigación alienta a la comunidad a explorar conjuntamente el potencial del ascensor con datos de capacitación más amplios, modelos más ricos, diseño de tareas auxiliares más avanzadas y recursos informáticos más fuertes.

Lift proporciona un nuevo paradigma de procesamiento de texto largo que transforma el conocimiento contextual en conocimiento parametrizado, una forma de pensar similar al proceso de memoria a corto plazo humano que se transforma en la memoria a largo plazo. Aunque todavía hay una distancia de resolver completamente los desafíos de contexto largo, Lift ha abierto una dirección de investigación prometedora. Dirección en papel: https://arxiv.org/abs/2502.14644