في مجال الذكاء الاصطناعي ، أحدثت أحدث نتيجة بحث لفريق تشانغ موهان في جامعة بكين ، إطار العمل الطويل للمدخلات (الرفع) ، اختراقات ثورية إلى معالجة النص الطويلة. تغير هذه الطريقة المبتكرة تمامًا فكرة معالجة النص الطويلة التقليدية عن طريق تدريب نص الإدخال الطويل على معلمات النموذج ، مما يسمح لأي نموذج نافذة سياق قصير للحصول على إمكانات معالجة النص الطويلة.

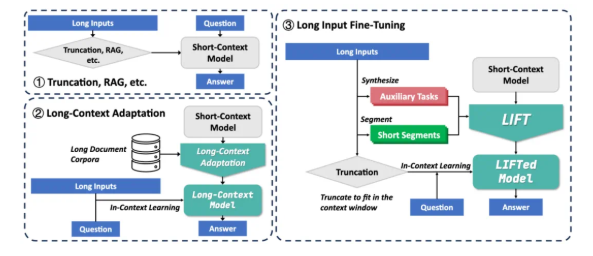

في الوقت الحالي ، تواجه النماذج الكبيرة تحديين رئيسيين عند معالجة النصوص الطويلة: أولاً ، يؤدي التعقيد المربعي لآلية الانتباه التقليدية إلى الحموضة الحاسوبية والذاكرة الضخمة عند معالجة النصوص الطويلة ؛ ثانياً ، من الصعب فهم النموذج التبعيات طويلة المدى المنتشرة في النصوص الطويلة. الحلول الحالية مثل RAG وتكيف السياق الطويل لها قيودها الخاصة. يعتمد Rag على استرجاع دقيق وهو عرضة لإدخال الضوضاء للتسبب في الهلوسة. ومع ذلك ، فإن التكيف الطويل السياق له تعقيد عالي الاستدلال وتظل نافذة السياق محدودة.

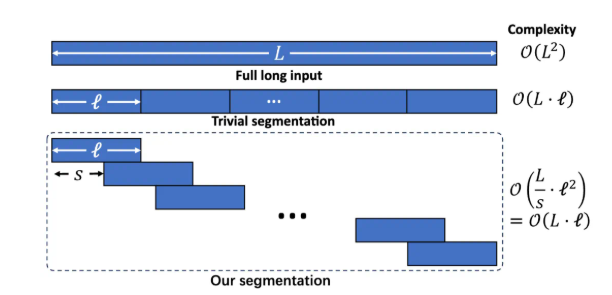

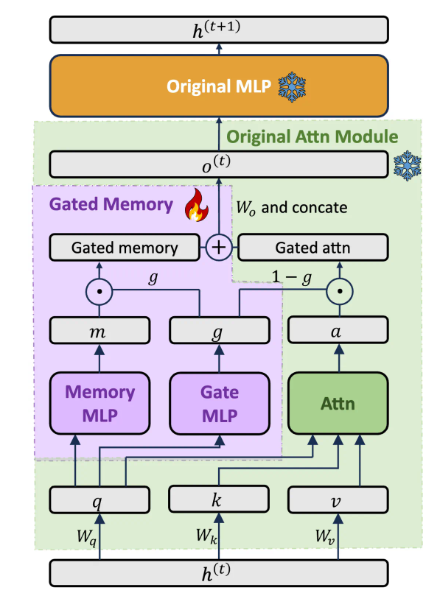

يشتمل إطار الرفع على ثلاثة مكونات رئيسية: التدريب الديناميكي والفعال على المدخلات الطويل ، ومحول الذاكرة المسورة الذي يوازن بين إمكانيات النموذج ، والتدريب على المهام الإضافية. تقسيم النص الطويل إلى شظايا متداخلة من خلال نمذجة اللغة المقطوعة لتجنب زيادة تعقيد التفكير وفقدان التبعية بعيدة المدى الناجم عن السياق الطويل المفرط. صمم بنية محول الذاكرة المخصصة للذاكرة لموازنة إمكانيات التعلم في السياق بشكل ديناميكي للنموذج الأصلي وفهم الذاكرة للمدخلات الطويلة. بواسطة LLM قبل التدريب تلقائيًا ، تقوم LLM بإنشاء المهام المساعدة في سؤال وجواب بناءً على نص طويل ، وتعويضًا عن فقدان قدرة النموذج في التدريب على التجزئة.

حقق الرفع تحسينات كبيرة في معايير السياق الطويلة المتعددة. على سبيل المثال ، في Q&A LOGELL للاعتماد ، ارتفع معدل دقة LLAMA38B من 15.44 ٪ إلى 29.97 ٪ ؛ في Q&A القصيرة في Loogle ، ارتفع معدل دقة GEMMA29B من 37.37 ٪ إلى 50.33 ٪ ؛ في Longbench المتعددة ، تحسنت LLAMA3 بشكل كبير في 4 من المهام الخمسة من خلال المصعد. تُظهر تجارب الاجتثاث أن بنية الذاكرة المسورة تعمل على تحسين GPT-4SCORE على مجموعة بيانات Loogle ShortQA بنسبة 5.48 ٪ مقارنة بالنموذج الأصلي الذي تم ضبطه باستخدام PISSA.

على الرغم من أن الرفع حقق نتائج ملحوظة ، لا يزال هناك بعض القيود: تأثير "العثور على إبرة في كومة القش" التي تتطلب استخراج معلومات دقيقة لا يزال غير مثالي ؛ يحتاج النموذج إلى تحسين قدرة استخراج المعرفة البارامترية التي تم الحصول عليها عن طريق الرفع ؛ يعتمد تصميم المهام الإضافية اعتمادًا كبيرًا على مهام الاختبار المصب ، وعالميتها محدودة ؛ كيفية تحقيق التوازن بين الذاكرة والقدرات الأصلية لا يزال محور البحث. يشجع فريق الأبحاث المجتمع على استكشاف إمكانات الرفع مع بيانات التدريب الأوسع ، والنماذج الأكثر ثراءً ، وتصميم المهام أكثر تقدمًا وموارد حوسبة أقوى.

يوفر LIFT نموذجًا جديدًا لتجهيز النص الطويل يحول المعرفة السياقية إلى معرفة معلمة ، وهي طريقة للتفكير مماثلة لعملية تحول الذاكرة على المدى القصير إلى ذاكرة طويلة المدى. على الرغم من أنه لا يزال هناك مسافة من حل تحديات السياق الطويل تمامًا ، إلا أن Lift قد فتح اتجاه بحث واعد. عنوان الورق: https://arxiv.org/abs/2502.14644