Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

Dans le domaine de l'intelligence artificielle, le dernier résultat de recherche de l'équipe de Zhang Muhan à l'Université de Pékin, le long cadre de réglage fin (ascenseur), a apporté des percées révolutionnaires à un long traitement de texte. Cette méthode innovante modifie complètement l'idée traditionnelle de traitement du texte long en formant un texte de saisie long dans les paramètres du modèle, permettant à n'importe quel modèle de fenêtre de contexte court pour obtenir de longues capacités de traitement de texte.

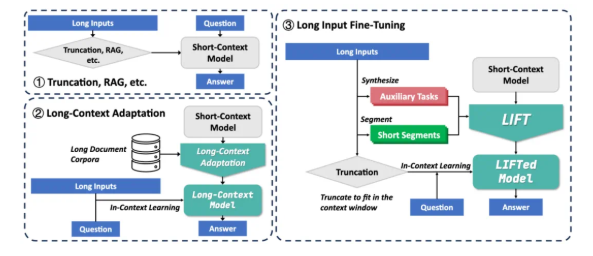

Actuellement, les grands modèles sont confrontés à deux défis majeurs lors du traitement des textes longs: premièrement, la complexité carrée du mécanisme d'attention traditionnel conduit à d'énormes frais généraux de calcul et de mémoire lors du traitement des textes longs; Deuxièmement, le modèle est difficile à comprendre les dépendances à long terme dispersées à travers de longs textes. Les solutions existantes telles que le chiffon et l'adaptation du contexte long ont leurs propres limites. RAG repose sur une récupération précise et est enclin à introduire du bruit pour provoquer des hallucinations. Cependant, une longue adaptation de contexte a une complexité d'inférence élevée et la fenêtre de contexte est toujours limitée.

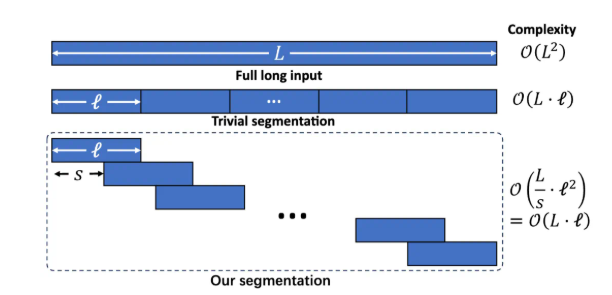

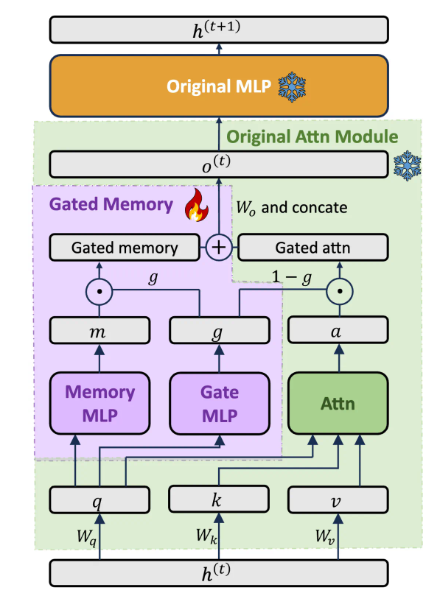

Le cadre de levage comprend trois composants clés: une formation à entrée longue dynamique et efficace, un adaptateur de mémoire fermé qui équilibre les capacités du modèle et la formation aux tâches auxiliaire. Divisez le texte long en fragments qui se chevauchent par la modélisation du langage segmenté pour éviter l'augmentation de la complexité du raisonnement et la perte de dépendance à longue portée causée par un contexte excessivement long. Concevez une architecture d'adaptateur de mémoire fermé dédiée pour équilibrer dynamiquement les capacités d'apprentissage dans le contexte du modèle d'origine et la compréhension de la mémoire des entrées longues. Par pré-formation, LLM génère automatiquement des tâches assistées de questions / réponses en fonction du texte long, compensant la perte possible de la capacité du modèle dans la formation de segmentation.

Lift a atteint des améliorations significatives dans plusieurs repères de contexte long. Par exemple, dans les questions et réponses de la dépendance à longue durée de Loogle, le taux de précision de LLAMA38B est passé de 15,44% à 29,97%; Dans le Loogle à courte dépendance Q&R, le taux de précision de GEMMA29B est passé de 37,37% à 50,33%; Dans les multiples sous-tâches à long terme, LLAMA3 s'est considérablement améliorée dans 4 des 5 sous-tâches grâce à l'ascenseur. Les expériences d'ablation montrent que l'architecture de mémoire fermée améliore GPT-4Score sur l'ensemble de données Loogle Shortqa de 5,48% par rapport au modèle d'origine affiné à l'aide de PISSA.

Bien que Lift ait obtenu des résultats remarquables, il y a encore certaines limites: l'effet de la tâche "Trouver l'aiguille dans une botte de foin" qui nécessite une extraction précise d'informations n'est toujours pas idéale; Le modèle doit optimiser la capacité d'extraction des connaissances paramétriques obtenue par levage; La conception des tâches auxiliaires dépend fortement des tâches de test en aval, et son universalité est limitée; Comment mieux équilibrer la mémoire et les capacités originales est toujours au centre de la recherche. L'équipe de recherche encourage la communauté à explorer conjointement le potentiel de l'ascenseur avec des données de formation plus larges, des modèles plus riches, une conception de tâches auxiliaire plus avancée et des ressources informatiques plus fortes.

Lift fournit un nouveau paradigme de traitement de texte long qui transforme les connaissances contextuelles en connaissances paramétrées, une façon de penser similaire au processus de mémoire humaine à court terme se transformant en mémoire à long terme. Bien qu'il y ait encore une distance par rapport aux défis complètement en contexte à long terme, Lift a ouvert une direction de recherche prometteuse. Adresse papier: https://arxiv.org/abs/2502.14644