人工知能の分野では、北京大学のZhang Muhanのチームの最新の研究結果である長い入力微調整(リフト)フレームワークは、革新的なブレークスルーを長いテキスト処理にもたらしました。この革新的な方法は、長い入力テキストをモデルパラメーターにトレーニングすることにより、従来の長いテキスト処理のアイデアを完全に変更し、短いコンテキストウィンドウモデルが長いテキスト処理機能を取得できるようにします。

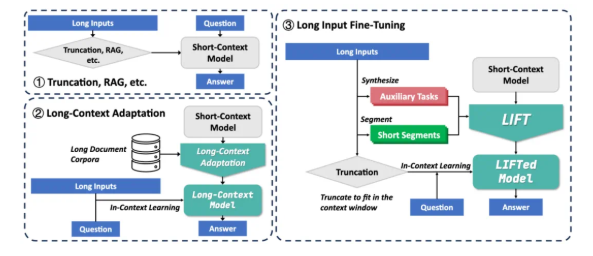

現在、大規模なモデルは長いテキストを処理する際に2つの大きな課題に直面しています。まず、従来の注意メカニズムの正方形の複雑さは、長いテキストを処理するときに巨大な計算とメモリのオーバーヘッドにつながります。第二に、このモデルは、長いテキスト全体に散らばっている長距離依存関係を理解するのが困難です。 RAGや長いコンテキスト適応などの既存のソリューションには、独自の制限があります。 RAGは正確な検索に依存しており、幻覚を引き起こすためにノイズを導入する傾向があります。ただし、長いコンテキストの適応には推論の複雑さが高く、コンテキストウィンドウはまだ制限されています。

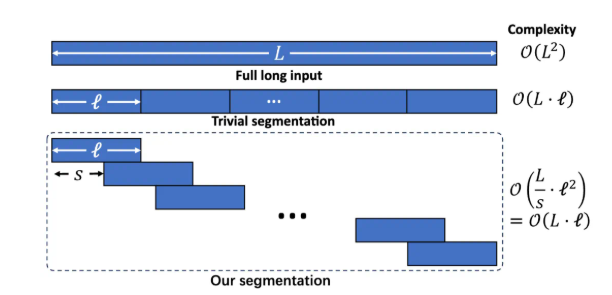

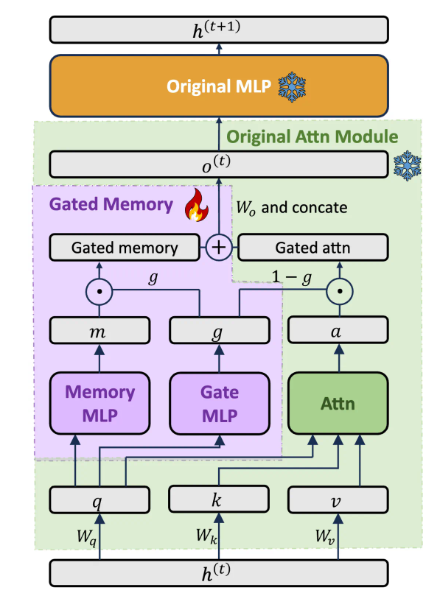

リフトフレームワークには、動的で効率的な長い入力トレーニング、モデル機能のバランスをとるゲートメモリアダプター、および補助タスクトレーニングの3つの重要なコンポーネントが含まれています。セグメント化された言語モデリングを介して長いテキストを重複するフラグメントに分割して、過度に長いコンテキストによって引き起こされる推論の複雑さと長距離依存の損失を回避します。専用のゲートメモリアダプターアーキテクチャを設計して、元のモデルのコンテキスト学習機能と長い入力のメモリ理解のバランスをとります。トレーニング前のLLMは、長いテキストに基づいてQ&Aアシストタスクを自動的に生成し、セグメンテーショントレーニングにおけるモデルの能力の損失の可能性を補償します。

Liftは、複数の長いコンテキストベンチマークで大幅な改善を達成しました。たとえば、Loogleの長い依存性Q&Aでは、llama38bの精度率は15.44%から29.97%に増加しました。 Loogleの短依存性Q&Aでは、Gemma29bの精度は37.37%から50.33%に増加しました。ロングベンチの複数のサブタスクでは、LLAMA3はリフトを介した5つのサブタスクのうち4つで大幅に改善されています。アブレーション実験は、ゲートメモリアーキテクチャが、Pissaを使用して微調整された元のモデルと比較して、Loogle ShortQAデータセットのGPT-4Scoreを5.48%改善することを示しています。

リフトは顕著な結果を達成しましたが、まだいくつかの制限があります。正確な情報抽出を必要とする「干し草の山で針を見つける」タスクの効果はまだ理想的ではありません。このモデルは、リフトによって得られたパラメトリック知識抽出能力を最適化する必要があります。補助タスクの設計は、下流のテストタスクに大きく依存しており、その普遍性は限られています。記憶と元の能力のバランスをより良くする方法は、依然として研究の焦点です。研究チームは、コミュニティがより広範なトレーニングデータ、より豊富なモデル、より高度な補助タスク設計、より強力なコンピューティングリソースを使用して、リフトの可能性を共同で探求することを奨励しています。

Liftは、文脈的知識をパラメーター化された知識に変換する新しい長いテキスト処理パラダイムを提供します。これは、人間の短期記憶が長期記憶に変換されるプロセスと同様の考え方です。長いコンテキストの課題を完全に解決することからまだ距離がありますが、Liftは有望な研究の方向性を開きました。紙の住所:https://arxiv.org/abs/2502.14644