No campo da inteligência artificial, o último resultado da pesquisa da equipe de Zhang Muhan na Universidade de Pequim, a longa estrutura de ajuste fina (elevador), trouxe avanços revolucionários ao processamento de texto longo. Esse método inovador muda completamente a idéia tradicional de processamento de texto longo, treinando o texto de entrada longa em parâmetros do modelo, permitindo que qualquer modelo de janela de contexto curto obtenha recursos de processamento de texto longo.

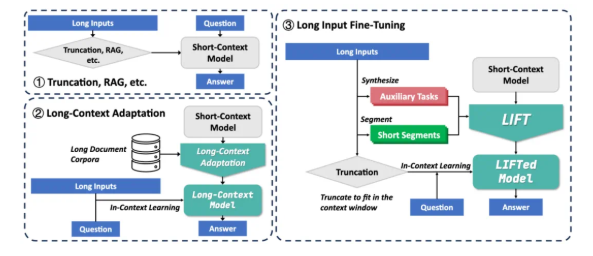

Atualmente, modelos grandes enfrentam dois grandes desafios ao processar textos longos: primeiro, a complexidade quadrada do mecanismo de atenção tradicional leva a uma enorme sobrecarga computacional e de memória ao processar textos longos; Segundo, o modelo é difícil de entender as dependências de longo alcance espalhadas por textos longos. Soluções existentes, como RAG e longa adaptação de contexto, têm suas próprias limitações. RAG depende de recuperação precisa e é propensa a introduzir ruído para causar alucinações. No entanto, a adaptação de contexto de longo prazo tem alta complexidade de inferência e a janela de contexto ainda é limitada.

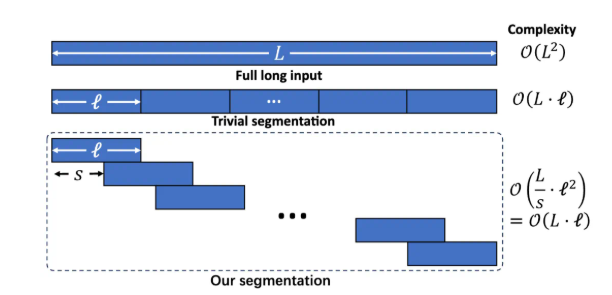

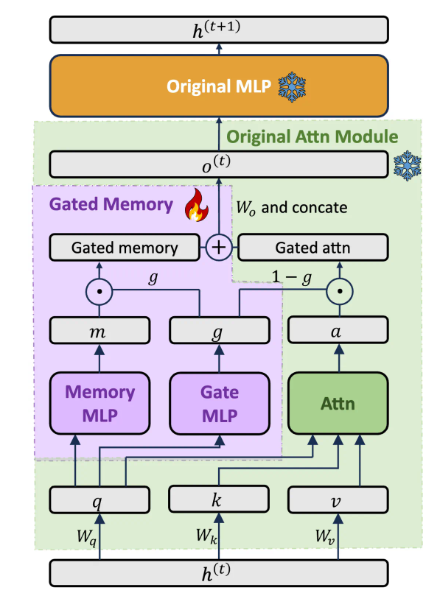

A estrutura de elevação inclui três componentes principais: treinamento dinâmico e eficiente de entrada longa, adaptador de memória fechada que equilibra os recursos do modelo e o treinamento auxiliar de tarefas. Divida o texto longo em fragmentos sobrepostos através da modelagem de linguagem segmentada para evitar o aumento da complexidade do raciocínio e a perda de dependência de longo alcance causada por um contexto excessivamente longo. Projete uma arquitetura adaptadora de memória fechada dedicada para equilibrar dinamicamente os recursos de aprendizado no contexto do modelo original e a compreensão da memória de longas entradas. Ao pré-treinamento, o LLM gera automaticamente tarefas de perguntas e respostas assistidas com base em texto longo, compensando a possível perda da capacidade do modelo no treinamento de segmentação.

O elevador alcançou melhorias significativas em vários benchmarks de contexto longo. Por exemplo, nas perguntas e respostas de longa dependência do Loogle, a taxa de precisão de LLAMA38B aumentou de 15,44% para 29,97%; Nas perguntas e respostas de dependência curta do Loogle, a taxa de precisão de GEMMA29B aumentou de 37,37% para 50,33%; Nas subtarefas múltiplas de Longbench, o LLAMA3 melhorou significativamente em 4 das 5 subtarefas através do elevador. Experimentos de ablação mostram que a arquitetura de memória fechada melhora o GPT-4Score no conjunto de dados Loogle ShortQA em 5,48% em comparação com o modelo original ajustado usando Pissa.

Embora o elevador tenha alcançado resultados notáveis, ainda existem algumas limitações: o efeito da tarefa "Encontre a agulha em uma pilha de feno" que requer extração precisa de informações ainda não é ideal; O modelo precisa otimizar a capacidade de extração de conhecimento paramétrica obtida pelo elevador; O design das tarefas auxiliares depende fortemente de tarefas de teste a jusante, e sua universalidade é limitada; Como equilibrar melhor a memória e as habilidades originais ainda é o foco da pesquisa. A equipe de pesquisa incentiva a comunidade a explorar conjuntamente o potencial do elevador com dados de treinamento mais amplos, modelos mais ricos, design de tarefas auxiliares mais avançado e recursos de computação mais fortes.

O elevador fornece um novo paradigma de processamento de texto longo que transforma o conhecimento contextual em conhecimento parametrizado, uma maneira de pensar semelhante ao processo de memória humana de curto prazo que se transforma em memória de longo prazo. Embora ainda exista uma distância da solução completamente de desafios de longo contexto, o LIFT abriu uma direção promissora de pesquisa. Endereço em papel: https://arxiv.org/abs/2502.14644