Situs web resmi www.binance.com/zh-cn :Masukkan situs web resmi ☜☜

Aplikasi: ☞☞ Unduh Aplikasi Resmi☜☜

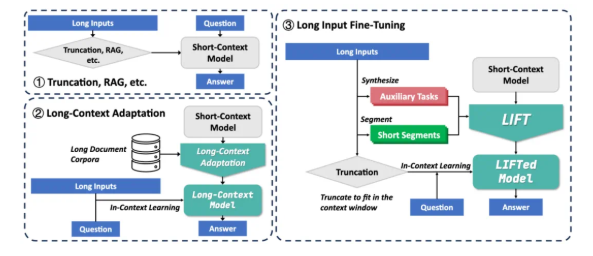

Di bidang kecerdasan buatan, hasil penelitian terbaru dari tim Zhang Muhan di Peking University, kerangka kerja penyempurnaan input (lift) yang panjang, telah membawa terobosan revolusioner ke pemrosesan teks yang panjang. Metode inovatif ini sepenuhnya mengubah ide pemrosesan teks panjang tradisional dengan melatih teks input panjang menjadi parameter model, yang memungkinkan model jendela konteks pendek apa pun untuk mendapatkan kemampuan pemrosesan teks yang panjang.

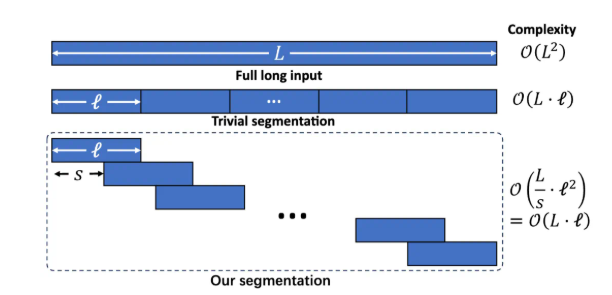

Saat ini, model besar menghadapi dua tantangan utama ketika memproses teks panjang: pertama, kompleksitas kuadrat dari mekanisme perhatian tradisional mengarah pada overhead komputasi dan memori yang sangat besar saat memproses teks panjang; Kedua, model ini sulit untuk memahami dependensi jarak jauh yang tersebar di seluruh teks panjang. Solusi yang ada seperti kain dan adaptasi konteks panjang memiliki keterbatasan sendiri. Rag bergantung pada pengambilan yang akurat dan cenderung memperkenalkan kebisingan untuk menyebabkan halusinasi. Namun, adaptasi konteks panjang memiliki kompleksitas inferensi yang tinggi dan jendela konteks masih terbatas.

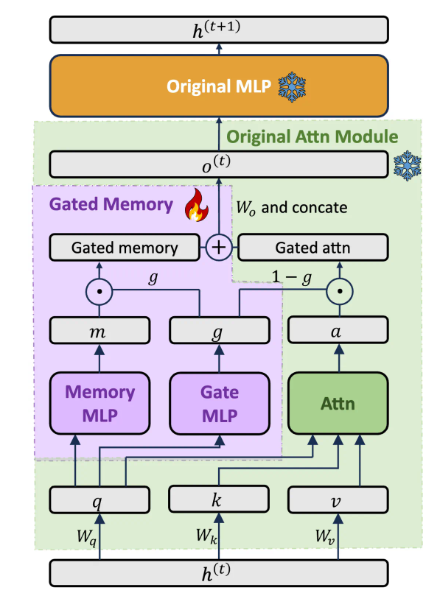

Kerangka kerja lift mencakup tiga komponen utama: pelatihan input panjang yang dinamis dan efisien, adaptor memori yang terjaga keamanannya yang menyeimbangkan kemampuan model, dan pelatihan tugas tambahan. Memecahkan teks panjang menjadi fragmen yang tumpang tindih melalui pemodelan bahasa tersegmentasi untuk menghindari peningkatan kompleksitas penalaran dan kehilangan ketergantungan jarak jauh yang disebabkan oleh konteks yang terlalu panjang. Rancang arsitektur adaptor memori yang dipredikasikan khusus untuk secara dinamis menyeimbangkan kemampuan pembelajaran dalam konteks dari model asli dan pemahaman memori input panjang. Dengan pra-pelatihan LLM secara otomatis menghasilkan tugas-tugas yang dibantu T&J berdasarkan teks panjang, mengkompensasi kemungkinan kehilangan kemampuan model dalam pelatihan segmentasi.

Lift telah mencapai peningkatan yang signifikan dalam berbagai tolok ukur konteks panjang. Misalnya, dalam T&J yang lama bergantung pada loogle, tingkat akurasi LLAMA38B meningkat dari 15,44% menjadi 29,97%; Dalam Q&A ketergantungan pendek loogle, tingkat akurasi Gemma29b meningkat dari 37,37% menjadi 50,33%; Dalam berbagai subtugas Longbench, LLAMA3 telah meningkat secara signifikan dalam 4 dari 5 subtugas melalui lift. Eksperimen ablasi menunjukkan bahwa arsitektur memori yang terjaga keamanannya meningkatkan GPT-4Score pada dataset Loogle ShortqA sebesar 5,48% dibandingkan dengan model asli yang disesuaikan menggunakan PISSA.

Meskipun Lift telah mencapai hasil yang luar biasa, masih ada beberapa keterbatasan: efek dari tugas "temukan jarum dalam tumpukan jerami" yang membutuhkan ekstraksi informasi yang akurat masih belum ideal; Model perlu mengoptimalkan kemampuan ekstraksi pengetahuan parametrik yang diperoleh dengan lift; Desain tugas tambahan sangat tergantung pada tugas pengujian hilir, dan universalitasnya terbatas; Bagaimana cara menyeimbangkan memori dan kemampuan asli yang lebih baik masih menjadi fokus penelitian. Tim peneliti mendorong masyarakat untuk bersama -sama mengeksplorasi potensi lift dengan data pelatihan yang lebih luas, model yang lebih kaya, desain tugas tambahan yang lebih maju dan sumber daya komputasi yang lebih kuat.

Lift memberikan paradigma pemrosesan teks panjang baru yang mengubah pengetahuan kontekstual menjadi pengetahuan parameter, cara berpikir yang mirip dengan proses memori jangka pendek manusia yang berubah menjadi memori jangka panjang. Meskipun masih ada jarak dari menyelesaikan tantangan konteks panjang sepenuhnya, Lift telah membuka arah penelitian yang menjanjikan. Alamat kertas: https://arxiv.org/abs/2502.14644