인공 지능 분야에서 Peking University의 Zhang Muhan 팀의 최신 연구 결과 인 LIFT (Long Input Fine Tuning) 프레임 워크는 긴 텍스트 처리에 혁신적인 혁신을 가져 왔습니다. 이 혁신적인 방법은 긴 입력 텍스트를 모델 매개 변수로 교육하여 기존의 긴 텍스트 처리 아이디어를 완전히 변경하여 짧은 컨텍스트 창 모델로 긴 텍스트 처리 기능을 얻을 수 있습니다.

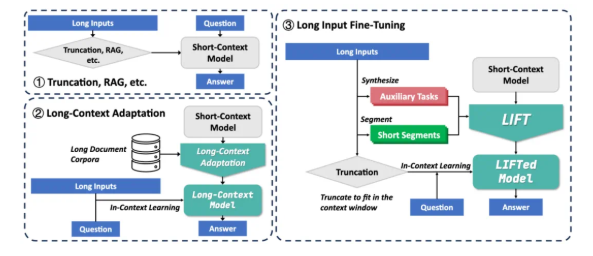

현재 대형 모델은 긴 텍스트를 처리 할 때 두 가지 주요 과제에 직면 해 있습니다. 첫째, 전통적인주의 메커니즘의 정사각형 복잡성은 긴 텍스트를 처리 할 때 엄청난 계산 및 메모리 오버 헤드로 이어집니다. 둘째,이 모델은 긴 텍스트에 흩어져있는 장거리 종속성을 이해하기가 어렵습니다. Rag 및 Long Context Adaptation과 같은 기존 솔루션에는 자체 한계가 있습니다. 래그는 정확한 검색에 의존하며 환각을 일으키기 위해 소음을 내릴 경향이 있습니다. 그러나 긴 컨텍스트 적응은 높은 추론 복잡성을 가지며 컨텍스트 창은 여전히 제한되어 있습니다.

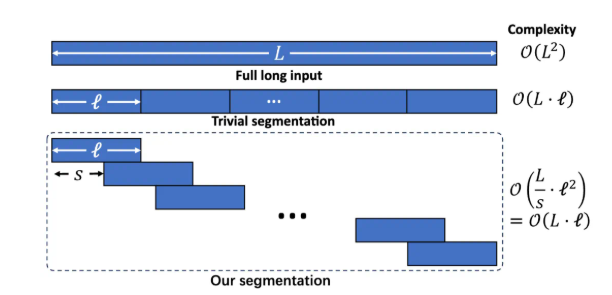

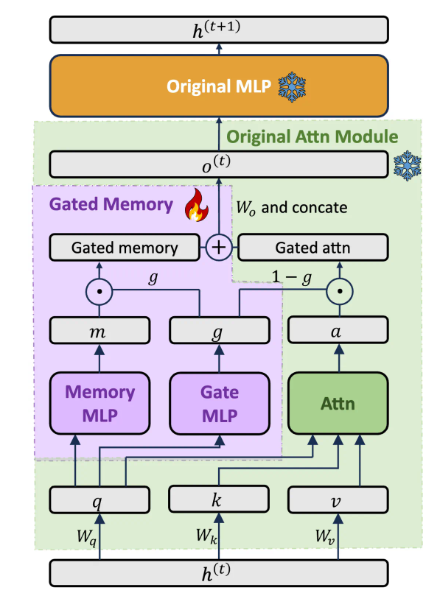

리프트 프레임 워크에는 역동적이고 효율적인 긴 입력 훈련, 모델 기능의 균형을 맞추는 게이트 메모리 어댑터, 보조 작업 교육의 세 가지 주요 구성 요소가 포함됩니다. 세분화 된 언어 모델링을 통해 긴 텍스트를 겹치는 조각으로 나누기 위해 과도하게 긴 컨텍스트로 인한 추론 복잡성 및 장거리 종속성 손실의 증가를 피하십시오. 전용 게이트 메모리 어댑터 아키텍처를 설계하여 원래 모델의 텍스트 내 학습 기능과 긴 입력에 대한 메모리 이해의 균형을 동적으로 균형을 유지하십시오. LLM을 사전 훈련함으로써 긴 텍스트를 기반으로 Q & A 지원 작업을 자동으로 생성하여 세분화 훈련에서 모델의 능력의 손실 가능성을 보상합니다.

LIFT는 여러 긴 컨텍스트 벤치 마크에서 상당한 개선을 달성했습니다. 예를 들어, 우울 장기 의존성 Q & A에서 LLAMA38B의 정확도는 15.44%에서 29.97%로 증가했습니다. 우울한 의존성 Q & A에서, Gemma29B의 정확도는 37.37%에서 50.33%로 증가했다. Longbench 다중 하위 작업에서 LLAMA3은 리프트를 통해 5 개의 하위 작업 중 4 개에서 크게 개선되었습니다. 절제 실험에 따르면 GATED 메모리 아키텍처는 PISSA를 사용하여 미세 조정 된 원래 모델에 비해 LOOGE SHORGQA 데이터 세트의 GPT-4SCORE를 5.48% 향상시킵니다.

리프트는 놀라운 결과를 얻었지만 여전히 몇 가지 제한 사항이 있습니다. 정확한 정보 추출이 필요한 "건초 더미에서 바늘 찾기"작업의 효과는 여전히 이상적이지 않습니다. 이 모델은 LIFT에 의해 얻은 파라 메트릭 지식 추출 능력을 최적화해야합니다. 보조 작업의 설계는 다운 스트림 테스트 작업에 크게 의존하며 보편성은 제한적입니다. 메모리와 원래 능력의 균형을 향상시키는 방법은 여전히 연구의 초점입니다. 연구팀은 커뮤니티가 광범위한 교육 데이터, 더 풍부한 모델,보다 고급 보조 작업 설계 및 더 강력한 컴퓨팅 리소스로 리프트의 잠재력을 공동으로 탐색하도록 권장합니다.

LIFT는 인간의 단기 기억의 과정과 유사하게 장기 기억으로 변환하는 사고 방식 인 맥락 지식을 매개 변수 지식으로 변환하는 새로운 긴 텍스트 처리 패러다임을 제공합니다. 장기 텍스트 문제를 완전히 해결하는 데는 거리가 멀지 만 Lift는 유망한 연구 방향을 열었습니다. 종이 주소 : https://arxiv.org/abs/2502.14644