Проверьте наш новый NER Toolkit

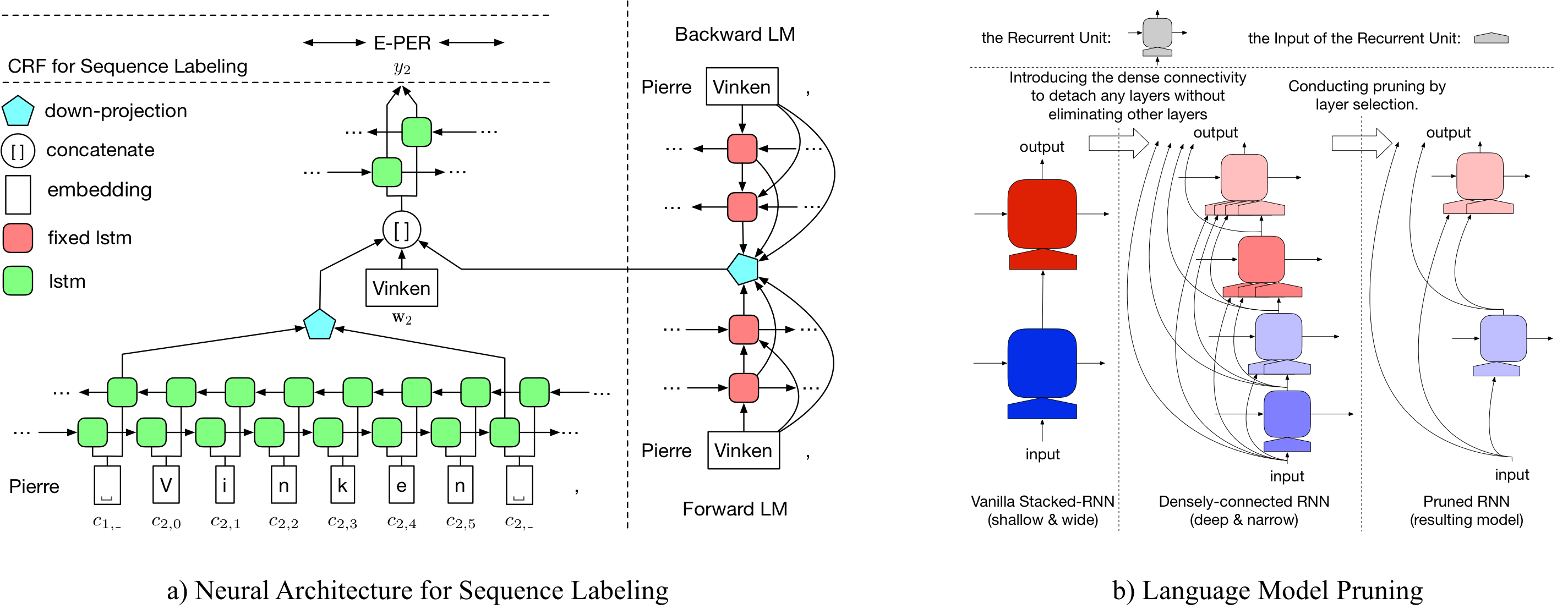

LD-Net предоставляет модели маркировки последовательности с включением:

Примечательно, наша предварительно обученная модель NER достигнута:

Подробности о LD-NET можно получить по адресу: https://arxiv.org/abs/1804.07827.

| Модель для conll03 | #Flops | Среднее (F1) | Std (F1) |

|---|---|---|---|

| Ванильный ner wo lm | 3 м | 90.78 | 0,24 |

| LD-Net (Wo Truning) | 51 м | 91.86 | 0,15 |

| LD-Net (Origin, выбран на основе Dev F1) | 51 м | 91.95 | |

| LD-сеть (обрезка) | 5 м | 91.84 | 0,14 |

| Модель для conll00 | #Flops | Среднее (F1) | Std (F1) |

|---|---|---|---|

| Ванильный np wo lm | 3 м | 94,42 | 0,08 |

| LD-Net (Wo Truning) | 51 м | 96.01 | 0,07 |

| LD-Net (Origin, выбран на основе Dev F1) | 51 м | 96.13 | |

| LD-сеть (обрезка) | 10 м | 95,66 | 0,04 |

Здесь мы предоставляем как предварительно обученные языковые модели, так и модели предварительно обученной маркировки последовательности.

Наша модель, предварительно расположенная языком, содержит встраивание слов, 10-слойную плотно связанную LSTM и Adiate Softmax, и достигает среднего PPL 50,06 в одном миллиардном наборе данных.

| Модель прямого языка | Модель отсталого языка |

|---|---|

| Скачать ссылку | Скачать ссылку |

Оригинальный предварительно обученный названный объект Tagger достигает 91,95 F1, The Cruned Tagged достиг 92.08 F1.

| Оригинальный теггер | Обрезанный Tagger |

|---|---|

| Скачать ссылку | Скачать ссылку |

Оригинальный предварительно обученный названный объект Tagger достигает 96.13 F1, обрезка Tagged достиг 95,79 F1.

| Оригинальный теггер | Обрезанный Tagger |

|---|---|

| Скачать ссылку | Скачать ссылку |

Чтобы обрезать оригинальный LD-сеть для Conll03, пожалуйста, запустите:

bash ldnet_ner_prune.sh

Чтобы обрезать оригинальный LD-сеть для Conll00 Chunking, пожалуйста, запустите:

bash ldnet_np_prune.sh

Наш пакет основан на Python 3.6 и на следующих пакетах:

numpy

tqdm

torch-scope

torch==0.4.1

Предварительные сценарии доступны в pre_seq и pre_word_ada , в то время как предварительно обработанные данные были сохранены в:

| Нор | Канкинг |

|---|---|

| Скачать ссылку | Скачать ссылку |

Наши реализации доступны в model_seq и model_word_ada , а документации размещены в Readthedoc

| Нор | Канкинг |

|---|---|

| Скачать ссылку | Скачать ссылку |

Для вывода модели, пожалуйста, проверьте наш пакет Lightner

Если вы обнаружите, что реализация полезной, пожалуйста, укажите следующую статью: Эффективное контекстуализированное представление: обрезка языковой модели для маркировки последовательности

@inproceedings{liu2018efficient,

title = "{Efficient Contextualized Representation: Language Model Pruning for Sequence Labeling}",

author = {Liu, Liyuan and Ren, Xiang and Shang, Jingbo and Peng, Jian and Han, Jiawei},

booktitle = {EMNLP},

year = 2018,

}