تحقق من مجموعة أدوات NER الجديدة

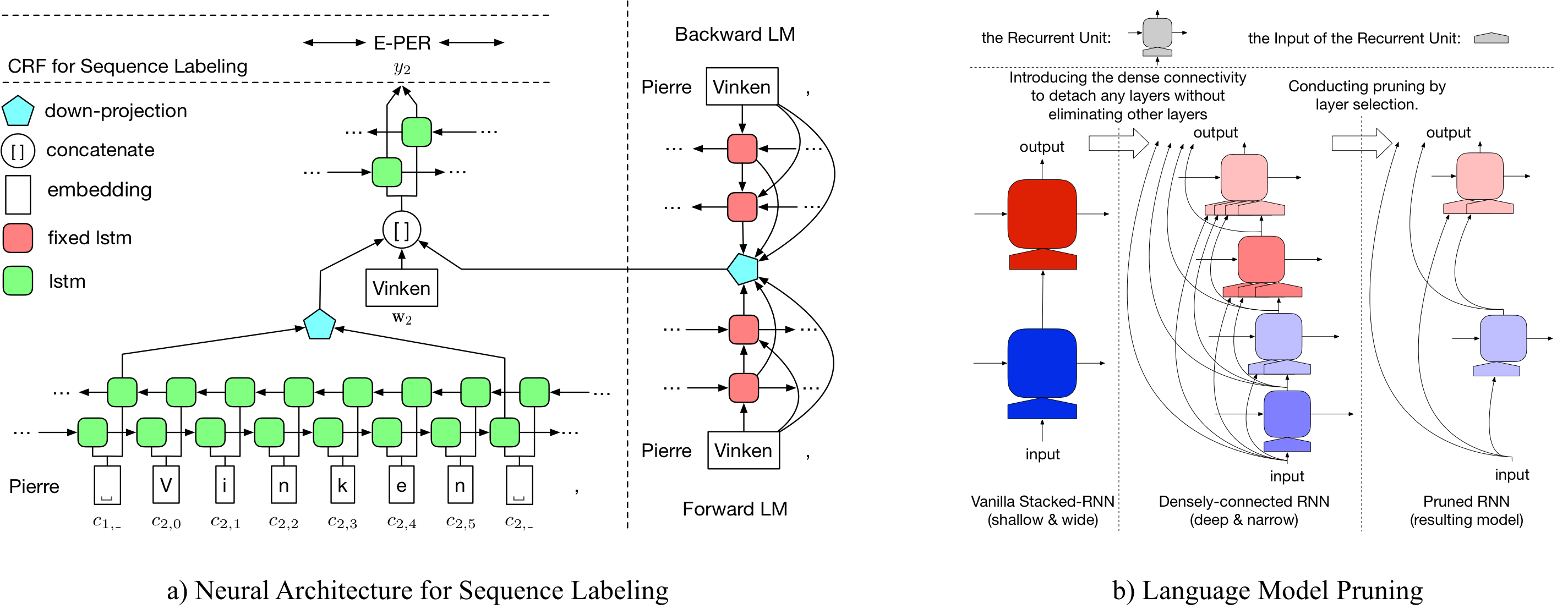

يوفر LD-NET نماذج وضع العلامات التسلسل التي تتميز:

بشكل ملحوظ ، تم تحقيق نموذج NER الذي تم تدريبه مسبقًا:

يمكن الوصول إلى تفاصيل LD-NET على: https://arxiv.org/abs/1804.07827.

| نموذج لـ Conll03 | #flops | يعني (F1) | STD (F1) |

|---|---|---|---|

| الفانيليا ner wo lm | 3 م | 90.78 | 0.24 |

| LD-NET (WO تقليم) | 51 م | 91.86 | 0.15 |

| LD-NET (الأصل ، تم التقاطه على أساس DEV F1) | 51 م | 91.95 | |

| LD-NET (تم تشذيبها) | 5 م | 91.84 | 0.14 |

| نموذج ل conll00 | #flops | يعني (F1) | STD (F1) |

|---|---|---|---|

| الفانيليا np wo lm | 3 م | 94.42 | 0.08 |

| LD-NET (WO تقليم) | 51 م | 96.01 | 0.07 |

| LD-NET (الأصل ، تم التقاطه على أساس DEV F1) | 51 م | 96.13 | |

| LD-NET (تم تشذيبها) | 10 م | 95.66 | 0.04 |

نحن هنا نقدم كل من نماذج اللغة التي تم تدريبها مسبقًا ونماذج وضع العلامات التسلسلية التي تم تدريبها مسبقًا.

يحتوي نموذج لغتنا المملوكة على تضمين الكلمات ، و 10 طبقات LSTM متصلة بكثافة و SoftMax attative ، ويحقق متوسط PPL من 50.06 على مجموعة بيانات المليار.

| نموذج اللغة إلى الأمام | نموذج اللغة المتخلفة |

|---|---|

| الرابط تنزيل | الرابط تنزيل |

يحقق Tagger الأصلي الذي تم تدريبه مسبقًا Tagger 91.95 F1 ، حقق الموسومة الموسومة 92.08 F1.

| tagger الأصلي | تاجور تمزيق |

|---|---|

| الرابط تنزيل | الرابط تنزيل |

يحقق Tagger الأصلي الذي تم تدريبه مسبقًا Tagger 96.13 F1 ، حقق الموسومة الموسومة 95.79 F1.

| tagger الأصلي | تاجور تمزيق |

|---|---|

| الرابط تنزيل | الرابط تنزيل |

لتشذيب LD-NET الأصلي لـ CONLL03 NER ، يرجى التشغيل:

bash ldnet_ner_prune.sh

لتشذيب LD-NET الأصلي من أجل CONLL00 ، يرجى التشغيل:

bash ldnet_np_prune.sh

تعتمد حزمةنا على Python 3.6 والحزم التالية:

numpy

tqdm

torch-scope

torch==0.4.1

تتوفر البرامج النصية المسبقة للعملية في pre_seq و pre_word_ada ، في حين تم تخزين البيانات المسبقة مسبقًا في:

| نير | chunking |

|---|---|

| الرابط تنزيل | الرابط تنزيل |

تتوفر تطبيقاتنا في model_seq و model_word_ada ، ويتم استضافة الوثائق في ReadTheDoc

| نير | chunking |

|---|---|

| الرابط تنزيل | الرابط تنزيل |

لاستدلال النموذج ، يرجى التحقق من حزمة Lightner الخاصة بنا

إذا وجدت التنفيذ مفيدًا ، فيرجى الاستشهاد بالورقة التالية: تمثيل سياق فعال: نموذج اللغة التقليدية لوضع تسلسل

@inproceedings{liu2018efficient,

title = "{Efficient Contextualized Representation: Language Model Pruning for Sequence Labeling}",

author = {Liu, Liyuan and Ren, Xiang and Shang, Jingbo and Peng, Jian and Han, Jiawei},

booktitle = {EMNLP},

year = 2018,

}