Этот репо содержит наш код для бумаги:

Калиброванная языковая модель тонкая настройка для данных и вне распределения, EMNLP2020.

[бумага] [слайды]

Обучение с базой Bert:

CUDA_VISIBLE_DEVICES=0 python bert.py --dataset 20news-15 --seed 0

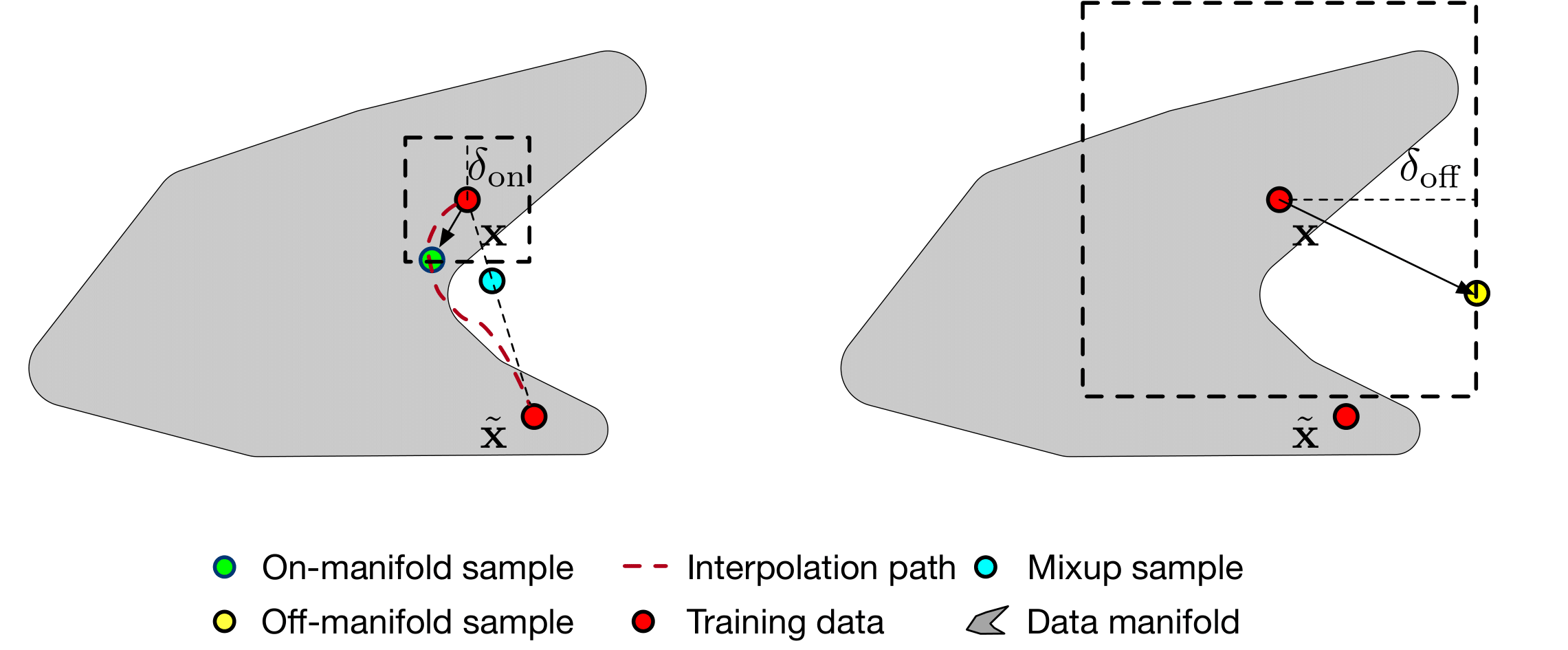

Тренировки с сглаживанием многообрази

CUDA_VISIBLE_DEVICES=0,1 python manifold-smoothing.py --dataset 20news-15 --seed 0 --eps_in 0.0001 --eps_out 0.001 --eps_y 0.1

Оценка с базой BERT

python test.py --model base --in_dataset 20news-15 --out_dataset 20news-5 --index 0

Оценка с масштабированием температуры [1] (на основе обученной модели BERT-базы)

python test.py --model temperature --in_dataset 20news-15 --out_dataset 20news-5 --index 0

Оценка с помощью MC-Dropout [2] (на основе обученной модели BERT-базы)

python test.py --model mc-dropout --in_dataset 20news-15 --out_dataset 20news-5 --eva_iter 10 --index 0

Оценка с сглаживанием многочисленных

python test.py --model manifold-smoothing --in_dataset 20news-15 --out_dataset 20news-5 --eps_in 0.0001 --eps_out 0.001 --eps_y 0.1

[1] Го, Чуан, Джефф Плейсс, Ю Сан и Килиан В. Вайнбергер. «О калибровке современных нейронных сетей». На Международной конференции по машинному обучению , стр. 1321-1330. 2017.

[2] Гал, Ярин и Зубин Гахрамани. «Обратное как байесовское приближение: представление неопределенности модели в глубоком обучении». В Международной конференции по машинному обучению , стр. 1050-1059. 2016