Calibrated BERT Fine Tuning

1.0.0

이 repo에는 종이 코드가 포함되어 있습니다.

캘리브레이션 된 언어 모델 및 배포되지 않은 데이터에 대한 미세 조정, EMNLP2020.

[종이] [슬라이드]

Bert Base와의 교육 :

CUDA_VISIBLE_DEVICES=0 python bert.py --dataset 20news-15 --seed 0

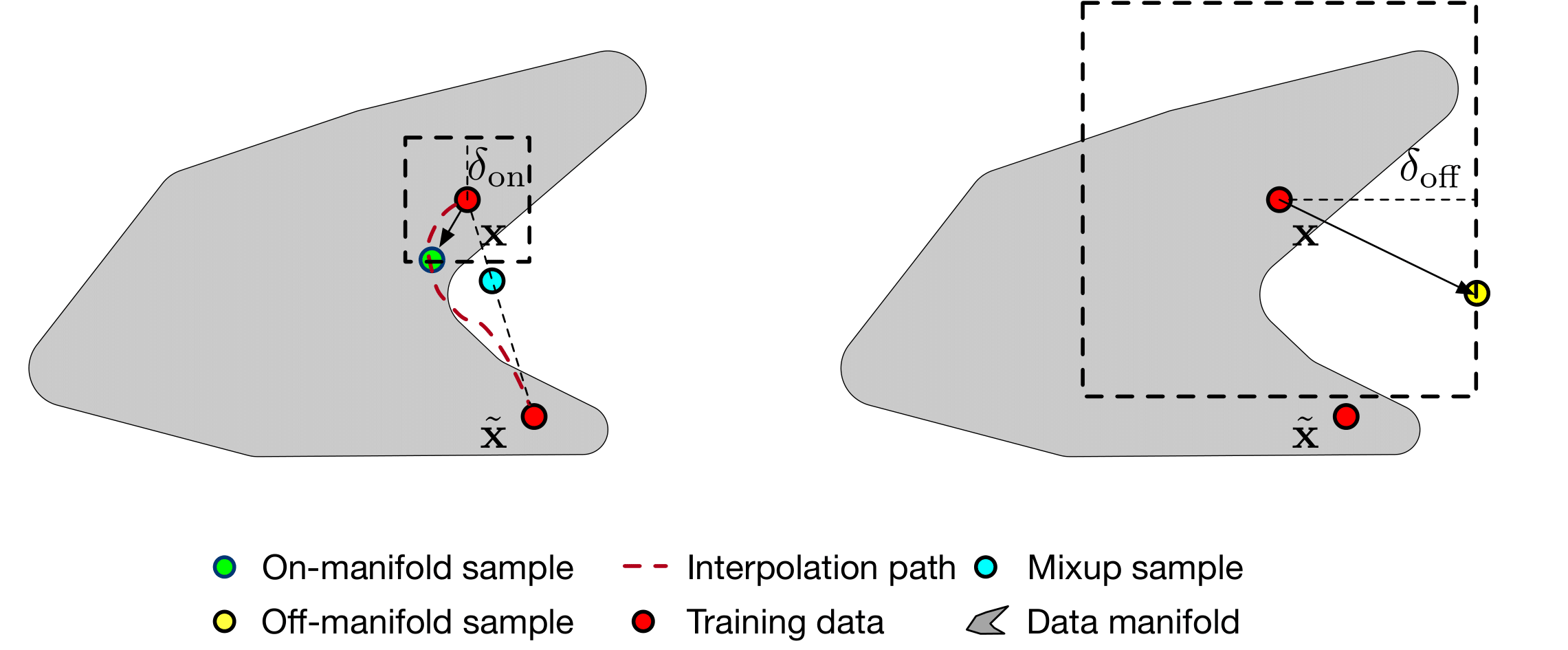

매니 폴드 스무딩으로 훈련

CUDA_VISIBLE_DEVICES=0,1 python manifold-smoothing.py --dataset 20news-15 --seed 0 --eps_in 0.0001 --eps_out 0.001 --eps_y 0.1

Bert Base와의 평가

python test.py --model base --in_dataset 20news-15 --out_dataset 20news-5 --index 0

온도 스케일링으로 평가 [1] (훈련 된 Bert-Base 모델 기반)

python test.py --model temperature --in_dataset 20news-15 --out_dataset 20news-5 --index 0

MC-Dropout [2]로의 평가 (훈련 된 Bert-Base 모델 기반)

python test.py --model mc-dropout --in_dataset 20news-15 --out_dataset 20news-5 --eva_iter 10 --index 0

매니 폴드 스무딩으로 평가

python test.py --model manifold-smoothing --in_dataset 20news-15 --out_dataset 20news-5 --eps_in 0.0001 --eps_out 0.001 --eps_y 0.1

[1] Guo, Chuan, Geoff Pleiss, Yu Sun 및 Kilian Q. Weinberger. "현대 신경망의 교정." 머신 러닝에 관한 국제 회의 , 1321-1330 쪽. 2017.

[2] Gal, Yarin 및 Zoubin Ghahramani. "베이지안 근사치로서의 드롭 아웃 : 딥 러닝에서 모델 불확실성을 나타냅니다." 머신 러닝에 관한 국제 회의 , pp. 1050-1059. 2016.