Используя LVCNet для разработки генератора параллельного волна и той же стратегии для его обучения, скорость вывода нового вокадера более чем в 5 раза быстрее, чем оригинальный Vocoder без какого -либо ухудшения качества звука .

Наши текущие работы [Paper] были приняты ICASSP2021, и наши предыдущие работы были описаны в Мелглоу.

Подготовьте данные, загрузите набор данных LJSpeech от https://keithito.com/lj-peech-dataset/ и сохраните его в data/LJSpeech-1.1 . Затем беги

python - m vocoder . preprocess - - data - dir . / data / LJSpeech - 1.1 - - config configs / lvcgan . v1 . yaml Mel-sepctrum рассчитываются и сохраняются в папке temp/ .

Обучение lvcnet

python - m vocoder . train - - config configs / lvcgan . v1 . yaml - - exp - dir exps / exp . lvcgan . v1Тест lvcnet

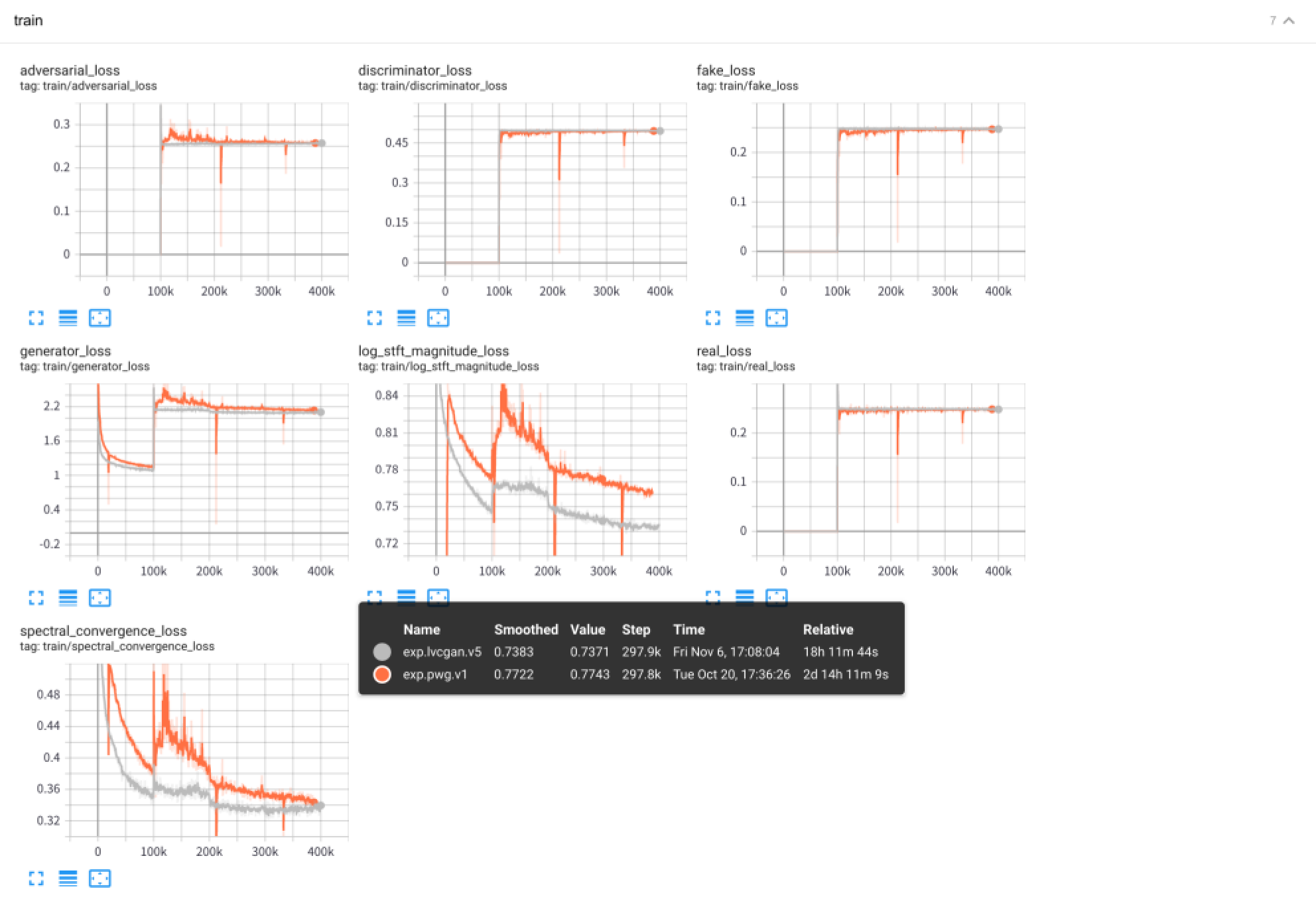

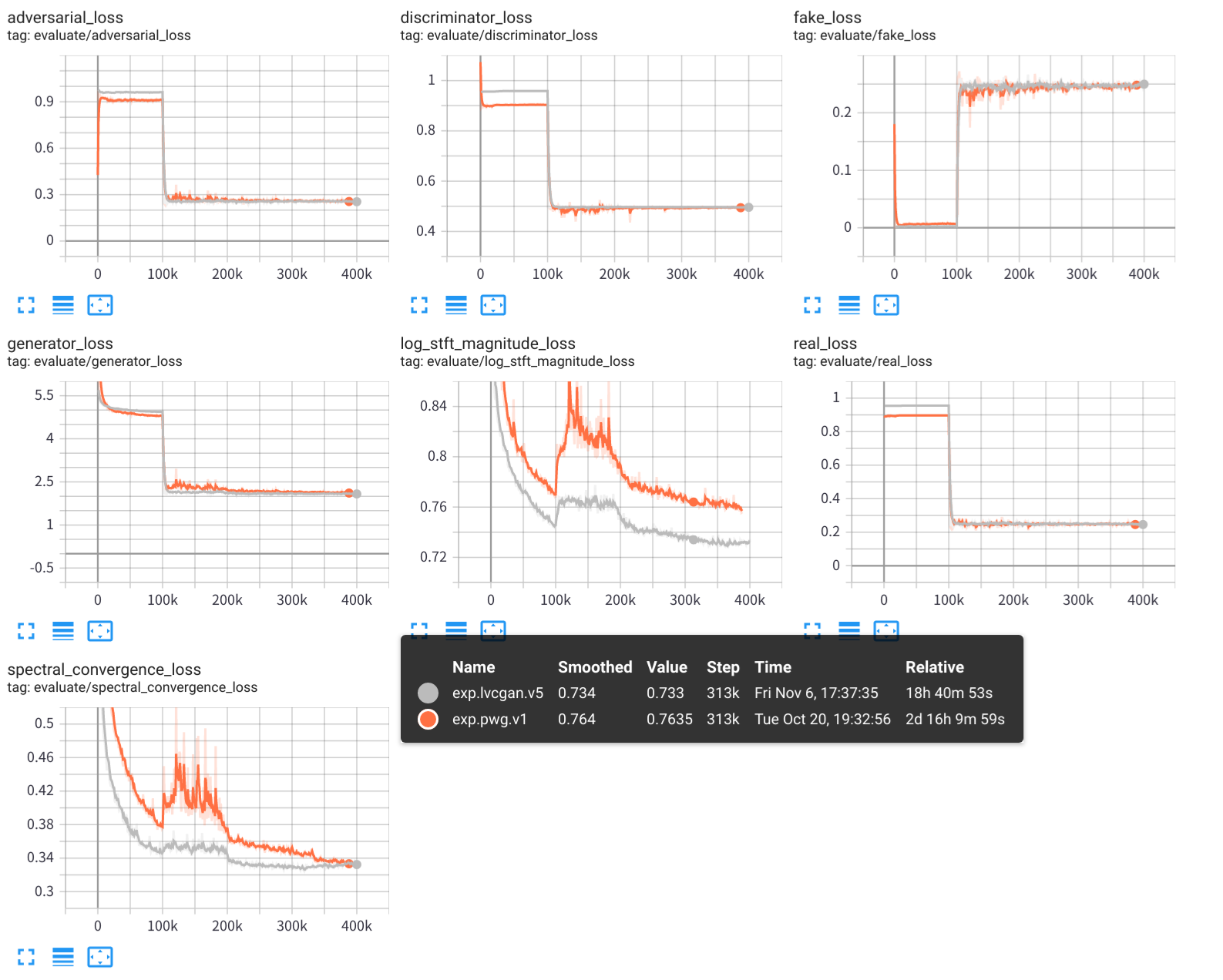

python - m vocoder . test - - config configs / lvcgan . v1 . yaml - - exp - dir exps / exp . lvcgan . v1 Экспериментальные результаты, включая учебные журналы, модельные контрольные точки и синтезированные звуки, хранятся в папке exps/exp.lvcgan.v1/ .

Сходство, вы также можете использовать конфигурацию файла configs/pwg.v1.yaml для обучения модели параллельной волны.

# training

python - m vocoder . train - - config configs / pwg . v1 . yaml - - exp - dir exps / exp . pwg . v1

# test

python - m vocoder . test - - config configs / pwg . v1 . yaml - - exp - dir exps / exp . pwg . v1 Используйте тендентор, чтобы просмотреть процесс экспериментального обучения:

tensorboard --logdir exps

Образцы звука сохраняются в samples/ , где

samples/*_lvc.wav генерируются LVCnet,samples/*_pwg.wav генерируются параллельными волнами,samples/*_real.wav - это настоящий звук. LVCNet: эффективная сеть моделирования, зависящая от состояния, для генерации сигналов, https://arxiv.org/abs/2102.10815

Melglow: эффективная сеть генеративной формы волны, основанная на свертывании местоположения, https://arxiv.org/abs/2012.01684

https://github.com/kan-bayashi/parallelwavegan

https://github.com/lmnt-com/diffwave