Usando LVCNET para diseñar el generador de Wavan Paralelo y la misma estrategia para entrenarlo, la velocidad de inferencia del nuevo Vocoder es más de 5 veces más rápido que el Vocoder original sin ninguna degradación en la calidad de audio .

Nuestros trabajos actuales [documento] han sido aceptados por ICASSP2021, y nuestros trabajos anteriores fueron descritos en Melglow.

Prepare los datos, descargue el conjunto de datos LJSpeech desde https://keithito.com/lj-speech-dataset/, y guárdelo en data/LJSpeech-1.1 . Luego corre

python - m vocoder . preprocess - - data - dir . / data / LJSpeech - 1.1 - - config configs / lvcgan . v1 . yaml Los Mel-Sepctrums se calculan y guardan en la temp/ .

Entrenamiento LVCNET

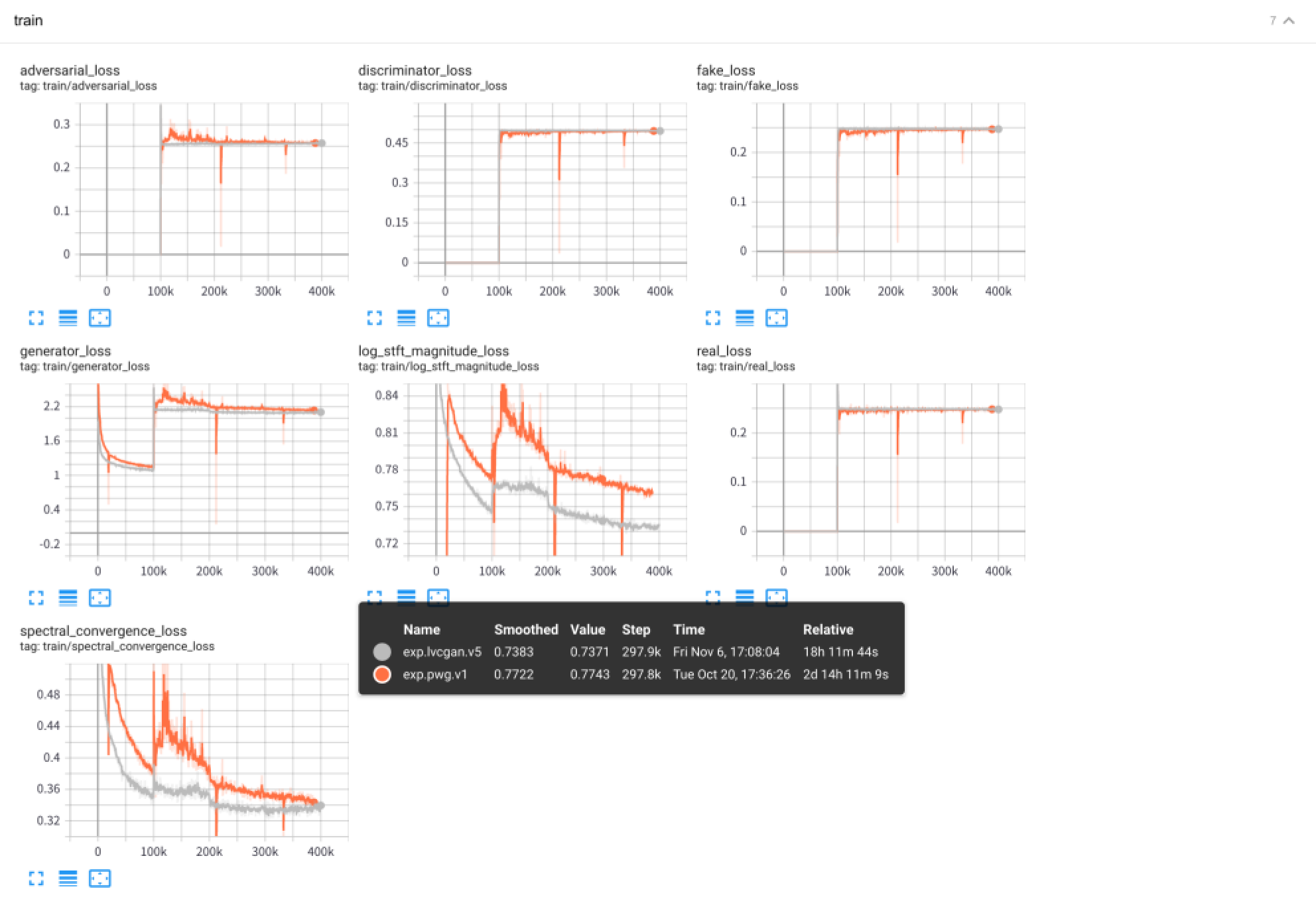

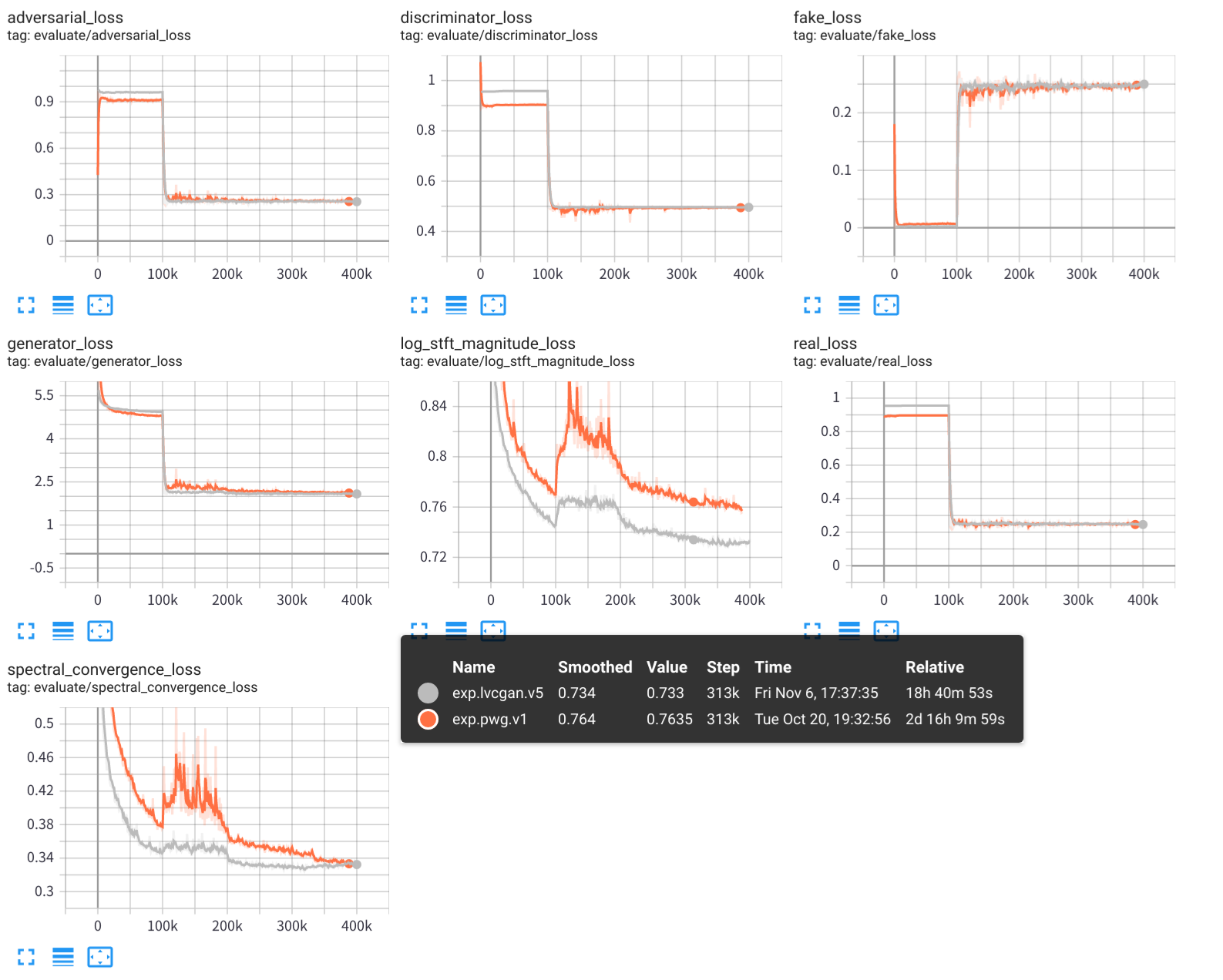

python - m vocoder . train - - config configs / lvcgan . v1 . yaml - - exp - dir exps / exp . lvcgan . v1Prueba de LVCNET

python - m vocoder . test - - config configs / lvcgan . v1 . yaml - - exp - dir exps / exp . lvcgan . v1 Los resultados experimentales, incluidos los registros de entrenamiento, los puntos de control modelo y los audios sintetizados, se almacenan en la carpeta exps/exp.lvcgan.v1/ .

Similidad, también puede usar el archivo de configuración configs/pwg.v1.yaml para entrenar un modelo de wavegan paralelo.

# training

python - m vocoder . train - - config configs / pwg . v1 . yaml - - exp - dir exps / exp . pwg . v1

# test

python - m vocoder . test - - config configs / pwg . v1 . yaml - - exp - dir exps / exp . pwg . v1 Use la placa tensor para ver el proceso de entrenamiento experimental:

tensorboard --logdir exps

Las muestras de audio se guardan en samples/ , donde

samples/*_lvc.wav son generadas por LVCNET,samples/*_pwg.wav se generan por Wavan paralelo,samples/*_real.wav son el audio real. LVCNET: red de modelado eficiente dependiente de la condición para la generación de forma de onda, https://arxiv.org/abs/2102.10815

MelGlow: red de forma de onda eficiente basada en la convolución de la ubicación-variable, https://arxiv.org/abs/2012.01684

https://github.com/kan-bayashi/parallelwavegan

https://github.com/lmnt-com/diffwave