Utilisant LVCNET pour concevoir le générateur de parallèle Wavegan et la même stratégie pour le former, la vitesse d'inférence du nouveau vocodeur est plus que 5x plus rapide que le vocodeur d'origine sans aucune dégradation de la qualité de l'audio .

Nos travaux actuels [document] ont été acceptés par ICASSP2021, et nos travaux précédents ont été décrits dans Melglow.

Préparez les données, téléchargez un ensemble de données LJSpeech à partir de https://keithito.com/lj-speech-dataset/, et enregistrez-les dans data/LJSpeech-1.1 . Puis courez

python - m vocoder . preprocess - - data - dir . / data / LJSpeech - 1.1 - - config configs / lvcgan . v1 . yaml Les mel-sepctrums sont calculés et enregistrés dans le dossier temp/ .

Formation LVCNET

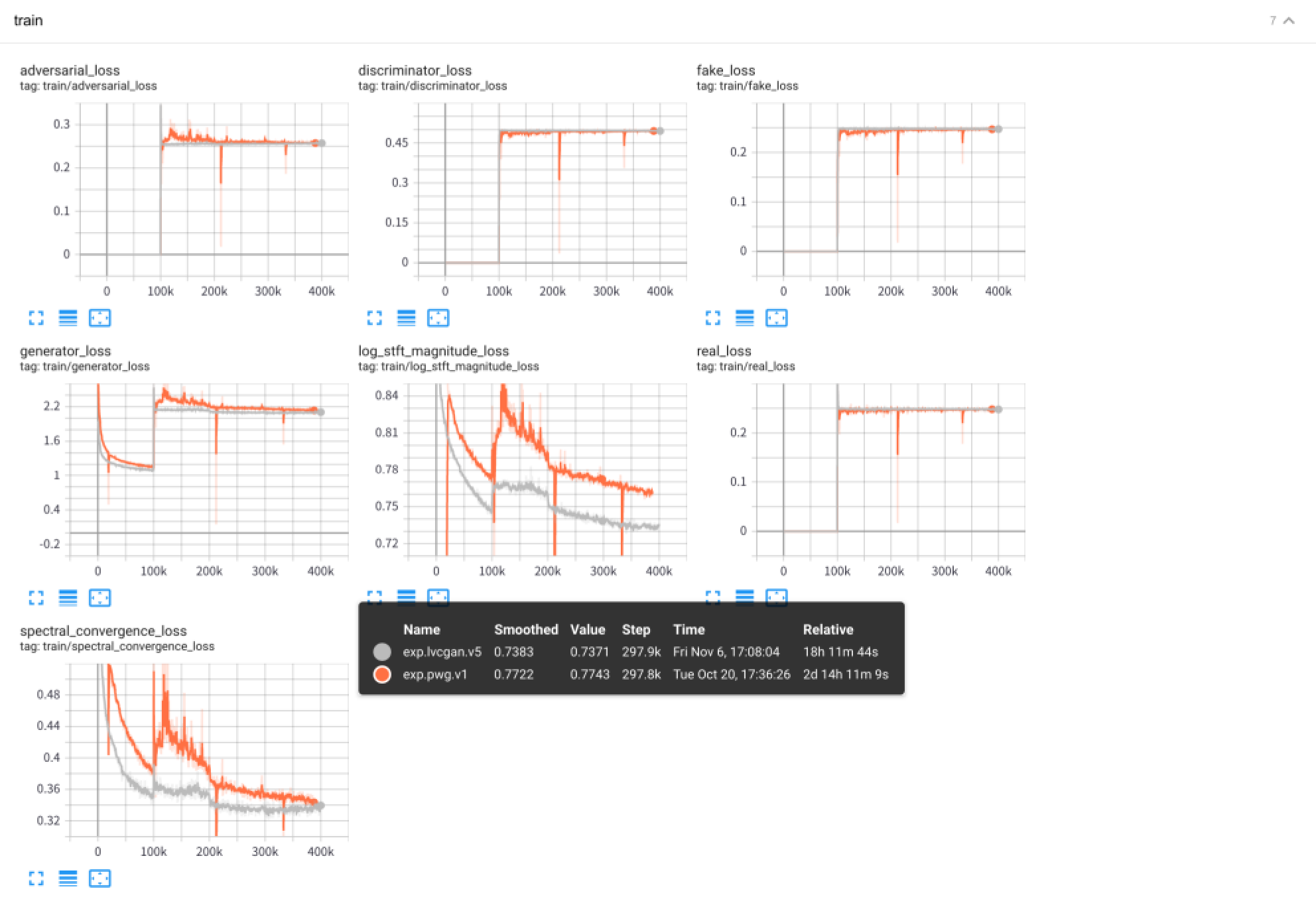

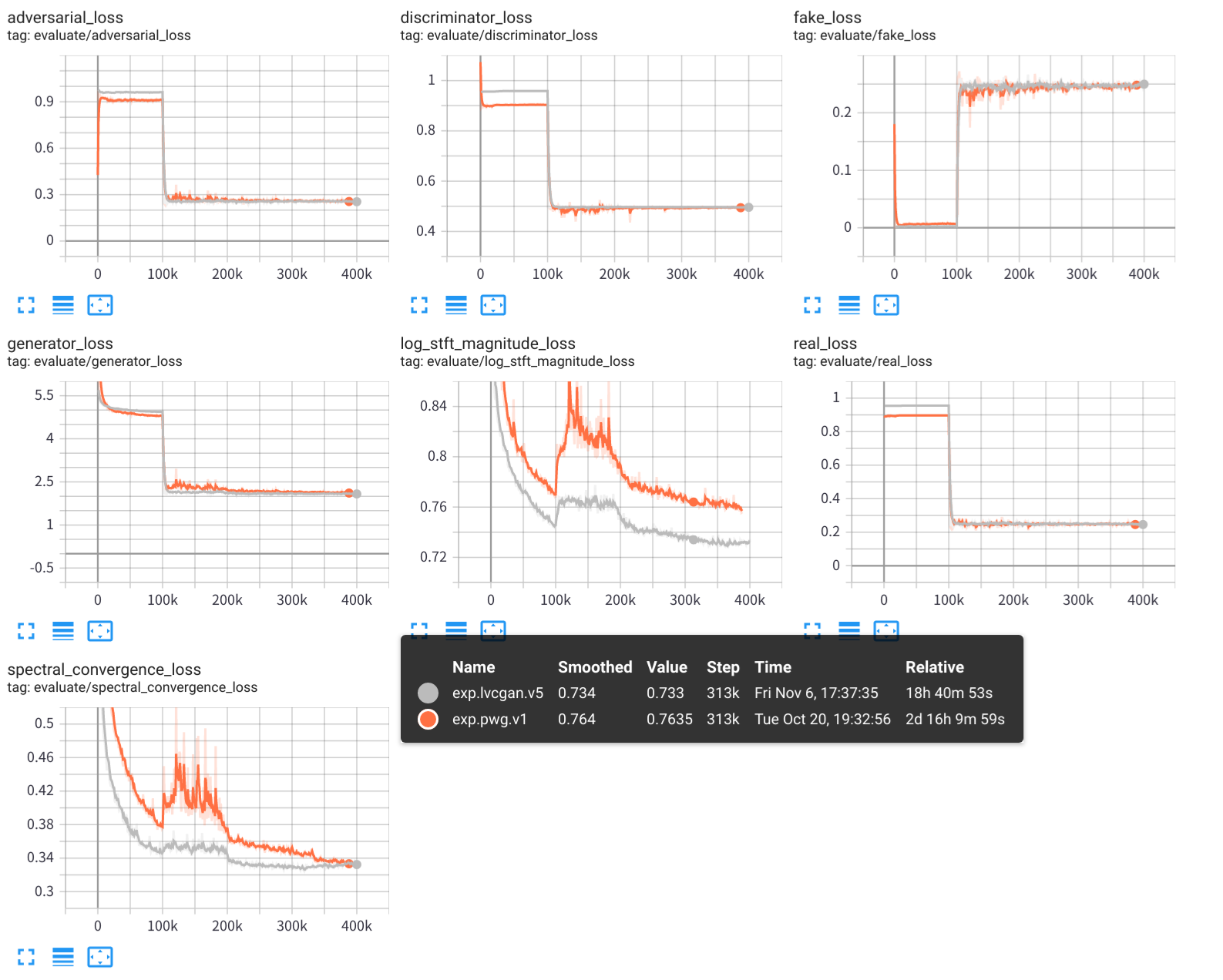

python - m vocoder . train - - config configs / lvcgan . v1 . yaml - - exp - dir exps / exp . lvcgan . v1Tester LVCNET

python - m vocoder . test - - config configs / lvcgan . v1 . yaml - - exp - dir exps / exp . lvcgan . v1 Les résultats expérimentaux, y compris les journaux de formation, les points de contrôle du modèle et les audios synthétisés, sont stockés dans le dossier exps/exp.lvcgan.v1/ .

Similitude, vous pouvez également utiliser le fichier config configs/pwg.v1.yaml pour former un modèle Wavegan parallèle.

# training

python - m vocoder . train - - config configs / pwg . v1 . yaml - - exp - dir exps / exp . pwg . v1

# test

python - m vocoder . test - - config configs / pwg . v1 . yaml - - exp - dir exps / exp . pwg . v1 Utilisez le Tensorboard pour afficher le processus de formation expérimentale:

tensorboard --logdir exps

Les échantillons audio sont enregistrés dans samples/ , où

samples/*_lvc.wav sont générés par lvcnet,samples/*_pwg.wav sont générés par parallèle Wavegan,samples/*_real.wav sont le véritable audio. LVCNET: Réseau de modélisation dépendant de la condition efficace pour la génération de forme d'onde, https://arxiv.org/abs/2102.10815

Melglow: réseau génératif de forme d'onde efficace basé sur la convolution de la variable, https://arxiv.org/abs/2012.01684

https://github.com/kan-bayashi/parallelwavegan

https://github.com/lmnt-com/diffwave