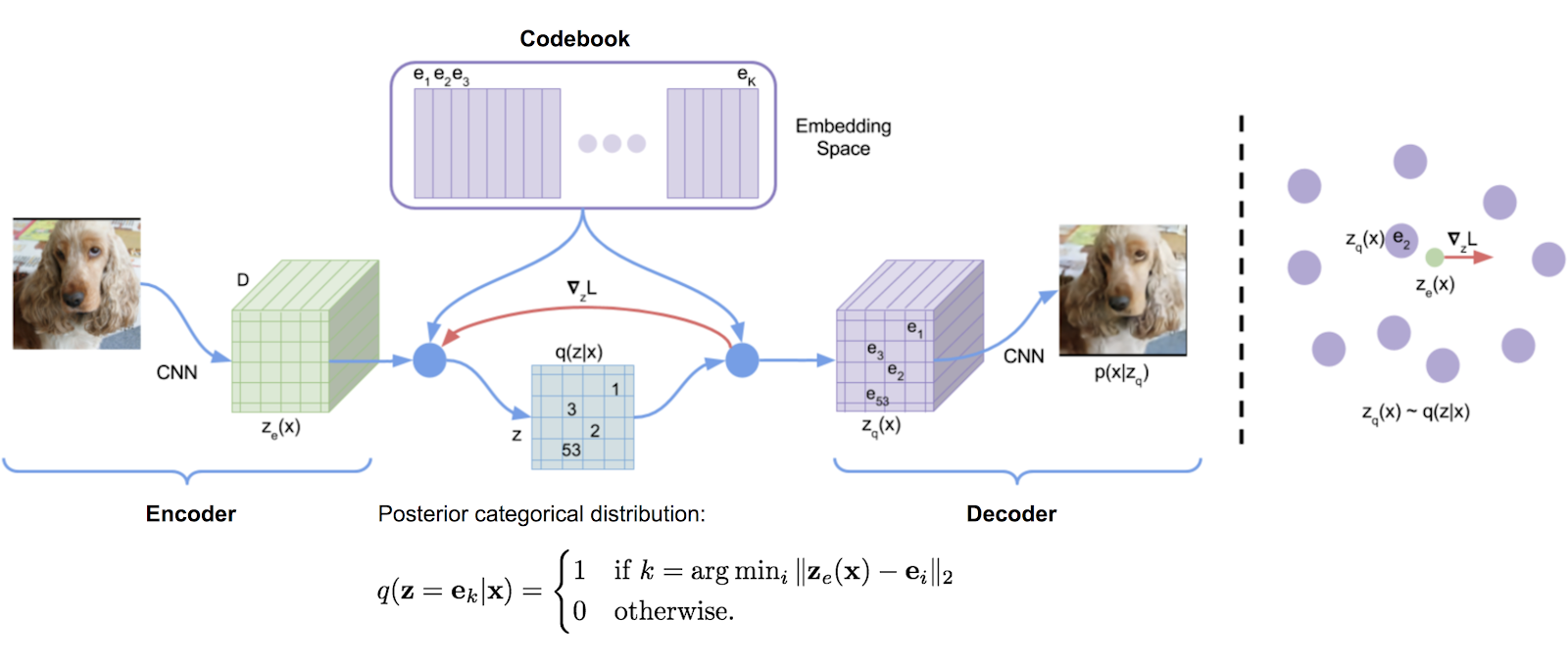

Библиотека квантования векторов, первоначально транскрибированная из реализации Tensorflow DeepMind, удобно превратилась в упаковку. Он использует средние значения экспоненциального движения для обновления словаря.

VQ был успешно использован DeepMind и OpenAI для высококачественного поколения изображений (VQ-VAE-2) и музыки (JukeBox).

$ pip install vector-quantize-pytorch import torch

from vector_quantize_pytorch import VectorQuantize

vq = VectorQuantize (

dim = 256 ,

codebook_size = 512 , # codebook size

decay = 0.8 , # the exponential moving average decay, lower means the dictionary will change faster

commitment_weight = 1. # the weight on the commitment loss

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = vq ( x ) # (1, 1024, 256), (1, 1024), (1) В этом документе предлагается использовать несколько векторных кванторов для рекурсивно -квантового определения остатков формы волны. Вы можете использовать это с помощью класса ResidualVQ и одного параметра дополнительной инициализации.

import torch

from vector_quantize_pytorch import ResidualVQ

residual_vq = ResidualVQ (

dim = 256 ,

num_quantizers = 8 , # specify number of quantizers

codebook_size = 1024 , # codebook size

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = residual_vq ( x )

print ( quantized . shape , indices . shape , commit_loss . shape )

# (1, 1024, 256), (1, 1024, 8), (1, 8)

# if you need all the codes across the quantization layers, just pass return_all_codes = True

quantized , indices , commit_loss , all_codes = residual_vq ( x , return_all_codes = True )

# (8, 1, 1024, 256)Кроме того, в этой статье используется остаточный VQ для построения RQ-VAE для генерации изображений высокого разрешения с более сжатыми кодами.

Они делают две модификации. Первый - поделиться кодовой книгой во всех кванторах. Второе состоит в том, чтобы стохастически выбирать коды, а не всегда принимать самые близкие совпадения. Вы можете использовать обе эти функции с двумя дополнительными аргументами ключевых слов.

import torch

from vector_quantize_pytorch import ResidualVQ

residual_vq = ResidualVQ (

dim = 256 ,

num_quantizers = 8 ,

codebook_size = 1024 ,

stochastic_sample_codes = True ,

sample_codebook_temp = 0.1 , # temperature for stochastically sampling codes, 0 would be equivalent to non-stochastic

shared_codebook = True # whether to share the codebooks for all quantizers or not

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = residual_vq ( x )

# (1, 1024, 256), (1, 1024, 8), (1, 8) Недавняя статья далее предлагает сделать остаточный VQ в группах измерения функции, показывая эквивалентные результаты Encodec, используя гораздо меньшее количество кодовых книг. Вы можете использовать его, импортируя GroupedResidualVQ

import torch

from vector_quantize_pytorch import GroupedResidualVQ

residual_vq = GroupedResidualVQ (

dim = 256 ,

num_quantizers = 8 , # specify number of quantizers

groups = 2 ,

codebook_size = 1024 , # codebook size

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = residual_vq ( x )

# (1, 1024, 256), (2, 1, 1024, 8), (2, 1, 8) В статье Soundstream предлагается, чтобы кодовая книга была инициализирована центроидами KMEANS первой партии. Вы можете легко включить эту функцию с одним флагом kmeans_init = True , как для VectorQuantize , либо для класса ResidualVQ

import torch

from vector_quantize_pytorch import ResidualVQ

residual_vq = ResidualVQ (

dim = 256 ,

codebook_size = 256 ,

num_quantizers = 4 ,

kmeans_init = True , # set to True

kmeans_iters = 10 # number of kmeans iterations to calculate the centroids for the codebook on init

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = residual_vq ( x )

# (1, 1024, 256), (1, 1024, 4), (1, 4) VQ-VAE традиционно обучаются с прямой оценкой (Ste). Во время обратного прохода градиент течет вокруг слоя VQ, а не через него. Степень поворота предлагает преобразовать градиент через слой VQ, чтобы относительный угол и величина между входным вектором и квантованным выходом кодируются в градиент. Вы можете включить или отключить эту функцию с помощью rotation_trick=True/False в классе VectorQuantize .

from vector_quantize_pytorch import VectorQuantize

vq_layer = VectorQuantize (

dim = 256 ,

codebook_size = 256 ,

rotation_trick = True , # Set to False to use the STE gradient estimator or True to use the rotation trick.

)Этот репозиторий будет содержать несколько методов из различных работ для борьбы с «мертвыми» записями кода, что является общей проблемой при использовании векторных кванторов.

Улучшенная газета VQGAN предлагает сохранить кодовую книгу в более низком измерении. Значения энкодера проецируются вниз, прежде чем прогнозируются обратно на высокие размеры после квантования. Вы можете установить это с помощью Hyperparameter codebook_dim .

import torch

from vector_quantize_pytorch import VectorQuantize

vq = VectorQuantize (

dim = 256 ,

codebook_size = 256 ,

codebook_dim = 16 # paper proposes setting this to 32 or as low as 8 to increase codebook usage

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = vq ( x )

# (1, 1024, 256), (1, 1024), (1,) Улучшенная бумага VQGAN также предлагает L2 нормализовать коды и кодируемые векторы, которые сводятся к использованию сходства косинуса для расстояния. Они утверждают, что обеспечение соблюдения векторов на сфере приводит к улучшению использования кода и реконструкции нижней части. Вы можете включить это, установив use_cosine_sim = True

import torch

from vector_quantize_pytorch import VectorQuantize

vq = VectorQuantize (

dim = 256 ,

codebook_size = 256 ,

use_cosine_sim = True # set this to True

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = vq ( x )

# (1, 1024, 256), (1, 1024), (1,) Наконец, в бумаге SoundStream есть схема, в которой они заменяют коды, которые имеют удары ниже определенного порога с случайно выбранным вектором из текущей партии. Вы можете установить этот порог с помощью ключевого слова threshold_ema_dead_code .

import torch

from vector_quantize_pytorch import VectorQuantize

vq = VectorQuantize (

dim = 256 ,

codebook_size = 512 ,

threshold_ema_dead_code = 2 # should actively replace any codes that have an exponential moving average cluster size less than 2

)

x = torch . randn ( 1 , 1024 , 256 )

quantized , indices , commit_loss = vq ( x )

# (1, 1024, 256), (1, 1024), (1,)VQ-VAE / VQ-Gan быстро набирает популярность. Недавняя статья предполагает, что при использовании квантования векторных изображений приводятся кодовой книги, чтобы быть ортогональным, приводит к переводу эквивалентности дискретизированных кодов, что приводит к значительному улучшению текста в нижнем потоке к задачам генерации изображений.

Вы можете использовать эту функцию, просто установив orthogonal_reg_weight больше 0 , и в этом случае ортогональная регуляризация будет добавлена к вспомогательным потерям, выведенным модулем.

import torch

from vector_quantize_pytorch import VectorQuantize

vq = VectorQuantize (

dim = 256 ,

codebook_size = 256 ,

accept_image_fmap = True , # set this true to be able to pass in an image feature map

orthogonal_reg_weight = 10 , # in paper, they recommended a value of 10

orthogonal_reg_max_codes = 128 , # this would randomly sample from the codebook for the orthogonal regularization loss, for limiting memory usage

orthogonal_reg_active_codes_only = False # set this to True if you have a very large codebook, and would only like to enforce the loss on the activated codes per batch

)

img_fmap = torch . randn ( 1 , 256 , 32 , 32 )

quantized , indices , loss = vq ( img_fmap ) # (1, 256, 32, 32), (1, 32, 32), (1,)

# loss now contains the orthogonal regularization loss with the weight as assigned Был ряд документов, которые предлагают варианты дискретных скрытых представлений с многоголовым подходом (несколько кодов на функцию). Я решил предложить один вариант, в котором такая же кодовая книга используется для векторного квантова во время входного head времени.

Вы также можете использовать более проверенный подход (MEMCODES) из бумаги NWT

import torch

from vector_quantize_pytorch import VectorQuantize

vq = VectorQuantize (

dim = 256 ,

codebook_dim = 32 , # a number of papers have shown smaller codebook dimension to be acceptable

heads = 8 , # number of heads to vector quantize, codebook shared across all heads

separate_codebook_per_head = True , # whether to have a separate codebook per head. False would mean 1 shared codebook

codebook_size = 8196 ,

accept_image_fmap = True

)

img_fmap = torch . randn ( 1 , 256 , 32 , 32 )

quantized , indices , loss = vq ( img_fmap )

# (1, 256, 32, 32), (1, 32, 32, 8), (1,)В этой статье сначала предложили использовать квантователь случайной проекции для моделирования речи замаскированного, где сигналы проецируются с случайно инициализированной матрицей, а затем сопоставлены со случайной инициализированной кодовой книгой. Поэтому не нужно изучать квантизатор. Этот метод использовался универсальной речевой моделью Google для достижения SOTA для моделирования речи к тексту.

USM далее предлагает использовать несколько кодовых книг, а моделирование речи замаскированной речи с помощью объектива с несколькими сфонами. Вы можете сделать это легко, установив num_codebooks , чтобы быть больше 1

import torch

from vector_quantize_pytorch import RandomProjectionQuantizer

quantizer = RandomProjectionQuantizer (

dim = 512 , # input dimensions

num_codebooks = 16 , # in USM, they used up to 16 for 5% gain

codebook_dim = 256 , # codebook dimension

codebook_size = 1024 # codebook size

)

x = torch . randn ( 1 , 1024 , 512 )

indices = quantizer ( x )

# (1, 1024, 16) Этот репозиторий также должен автоматически синхронизировать кодовые книги в многопрофильной настройке. Если как -то это не так, откройте проблему. Вы можете переопределить, синхронизировать кодовые книги или нет, установив sync_codebook = True | False

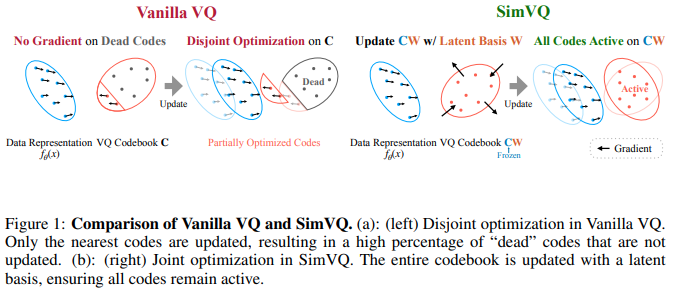

В новой статье ICLR 2025 предлагается схема, в которой замороженная кодовая книга, а коды неявно генерируются через линейную проекцию. Авторы утверждают, что эта настройка приводит к меньшему коллапсу кодовой книги, а также к более простой конвергенции. Я обнаружил, что это будет работать еще лучше в сочетании с трюком с вращением от Fifty et al., И расширение линейной проекции до небольшого MLP. Вы можете экспериментировать с этим как так

ОБНОВЛЕНИЕ: Слух смешанных результатов

import torch

from vector_quantize_pytorch import SimVQ

sim_vq = SimVQ (

dim = 512 ,

codebook_size = 1024 ,

rotation_trick = True # use rotation trick from Fifty et al.

)

x = torch . randn ( 1 , 1024 , 512 )

quantized , indices , commit_loss = sim_vq ( x )

assert x . shape == quantized . shape

assert torch . allclose ( quantized , sim_vq . indices_to_codes ( indices ), atol = 1e-6 ) ResidualSimVQ остаточного арома

import torch

from vector_quantize_pytorch import ResidualSimVQ

residual_sim_vq = ResidualSimVQ (

dim = 512 ,

num_quantizers = 4 ,

codebook_size = 1024 ,

rotation_trick = True # use rotation trick from Fifty et al.

)

x = torch . randn ( 1 , 1024 , 512 )

quantized , indices , commit_loss = residual_sim_vq ( x )

assert x . shape == quantized . shape

assert torch . allclose ( quantized , residual_sim_vq . get_output_from_indices ( indices ), atol = 1e-6 )

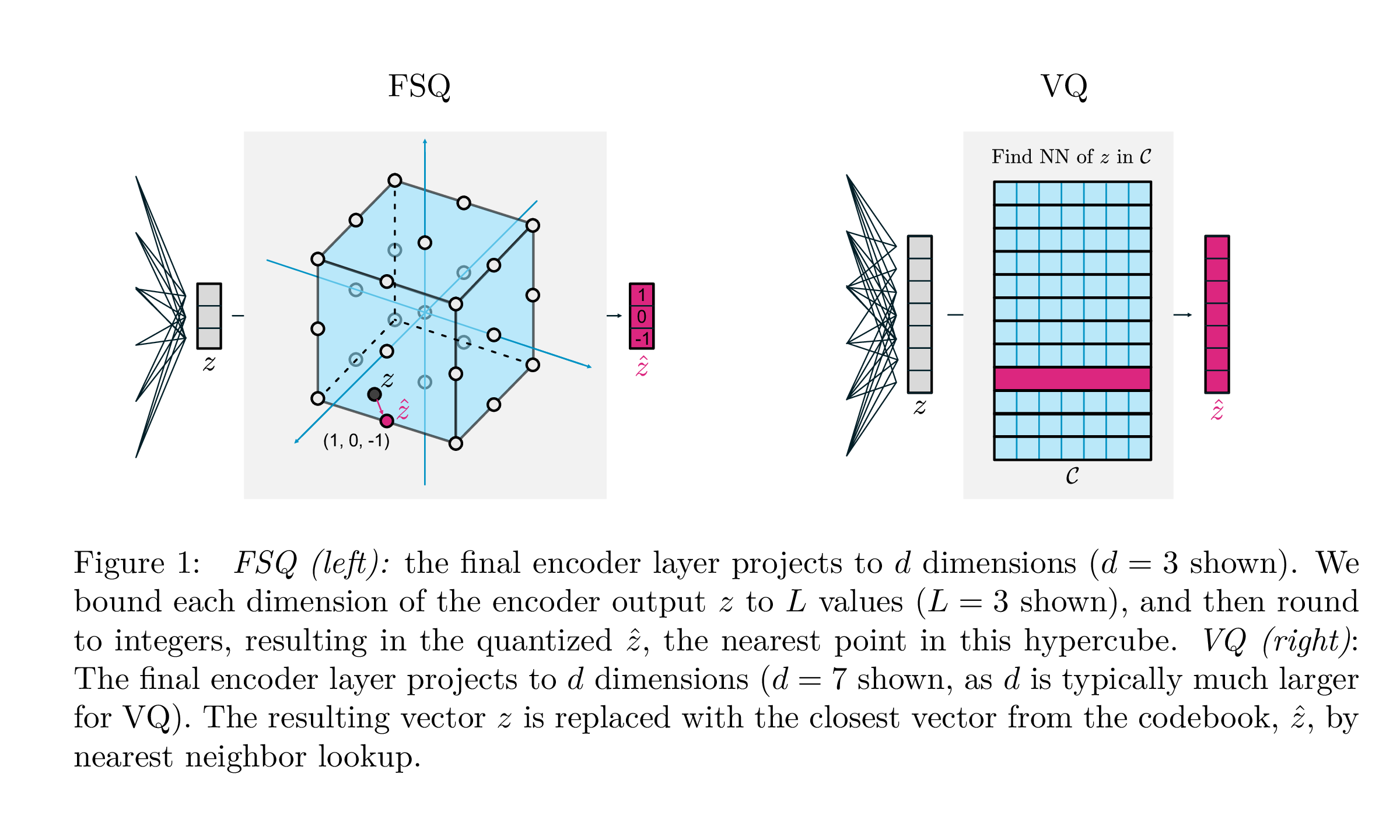

| Ведущий | FSQ | |

|---|---|---|

| Квантование | argmin_c || zc || | раунд (f (z)) |

| Градиенты | Прямо через оценку (Ste) | СТ |

| Вспомогательные потери | Обязательство, кодовая книга, потеря энтропии, ... | N/a |

| Уловки | EMA на кодовой книге, разделение кода, прогнозы, ... | N/a |

| Параметры | Кодовая книга | N/a |

Эта работа Google DeepMind направлена на то, чтобы значительно упростить способ, которым квантование вектора осуществляется для генеративного моделирования, устраняя необходимость в утратах обязательств, обновлении кодовой книги EMA, а также решает проблемы с коллапсом кодовой книги или недостаточным использованием. Они просто окружают каждый скаляр в дискретные уровни с прямыми градиентами; Коды становятся равномерными точками в гиперкубе.

Спасибо @sekstini за перенос этой реализации в рекордное время!

import torch

from vector_quantize_pytorch import FSQ

quantizer = FSQ (

levels = [ 8 , 5 , 5 , 5 ]

)

x = torch . randn ( 1 , 1024 , 4 ) # 4 since there are 4 levels

xhat , indices = quantizer ( x )

# (1, 1024, 4), (1, 1024)

assert torch . all ( xhat == quantizer . indices_to_codes ( indices ))Импровизированный остаточный FSQ, для попытки улучшить кодирование звука.

Кредит доходит до @sekstini за то, что изначально поняла идею здесь

import torch

from vector_quantize_pytorch import ResidualFSQ

residual_fsq = ResidualFSQ (

dim = 256 ,

levels = [ 8 , 5 , 5 , 3 ],

num_quantizers = 8

)

x = torch . randn ( 1 , 1024 , 256 )

residual_fsq . eval ()

quantized , indices = residual_fsq ( x )

# (1, 1024, 256), (1, 1024, 8)

quantized_out = residual_fsq . get_output_from_indices ( indices )

# (1, 1024, 256)

assert torch . all ( quantized == quantized_out )

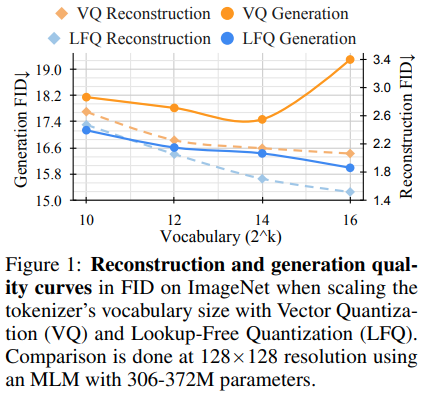

Исследовательская группа, стоящая за Magvit, выпустила новые результаты SOTA для генеративного видео моделирования. Основное изменение между V1 и V2 включает новый тип квантования, поиск свободного квантования (LFQ), который полностью устраняет кодовую книгу и внедряет поиск.

В этой статье представлен простой кванторий LFQ с использованием независимых бинарных задержек. Существуют другие реализации LFQ. Тем не менее, команда показывает, что Magvit-V2 с LFQ значительно улучшает эталон ImageNet. Различия между LFQ и 2-уровневым FSQ включают регуляризации энтропии, а также удержание потери приверженности.

Разработка более продвинутого метода квантования LFQ без кодовой книги может революционизировать генеративное моделирование.

Вы можете использовать его просто следующим образом. Будет в порту Magvit2 Pytorch

import torch

from vector_quantize_pytorch import LFQ

# you can specify either dim or codebook_size

# if both specified, will be validated against each other

quantizer = LFQ (

codebook_size = 65536 , # codebook size, must be a power of 2

dim = 16 , # this is the input feature dimension, defaults to log2(codebook_size) if not defined

entropy_loss_weight = 0.1 , # how much weight to place on entropy loss

diversity_gamma = 1. # within entropy loss, how much weight to give to diversity of codes, taken from https://arxiv.org/abs/1911.05894

)

image_feats = torch . randn ( 1 , 16 , 32 , 32 )

quantized , indices , entropy_aux_loss = quantizer ( image_feats , inv_temperature = 100. ) # you may want to experiment with temperature

# (1, 16, 32, 32), (1, 32, 32), ()

assert ( quantized == quantizer . indices_to_codes ( indices )). all () Вы также можете передавать видео функции как (batch, feat, time, height, width) или последовательности как (batch, seq, feat)

import torch

from vector_quantize_pytorch import LFQ

quantizer = LFQ (

codebook_size = 65536 ,

dim = 16 ,

entropy_loss_weight = 0.1 ,

diversity_gamma = 1.

)

seq = torch . randn ( 1 , 32 , 16 )

quantized , * _ = quantizer ( seq )

assert seq . shape == quantized . shape

video_feats = torch . randn ( 1 , 16 , 10 , 32 , 32 )

quantized , * _ = quantizer ( video_feats )

assert video_feats . shape == quantized . shapeИли поддержать несколько кодовых книг

import torch

from vector_quantize_pytorch import LFQ

quantizer = LFQ (

codebook_size = 4096 ,

dim = 16 ,

num_codebooks = 4 # 4 codebooks, total codebook dimension is log2(4096) * 4

)

image_feats = torch . randn ( 1 , 16 , 32 , 32 )

quantized , indices , entropy_aux_loss = quantizer ( image_feats )

# (1, 16, 32, 32), (1, 32, 32, 4), ()

assert image_feats . shape == quantized . shape

assert ( quantized == quantizer . indices_to_codes ( indices )). all ()Импровизированный остаточный LFQ, чтобы увидеть, может ли это привести к улучшению сжатия звука.

import torch

from vector_quantize_pytorch import ResidualLFQ

residual_lfq = ResidualLFQ (

dim = 256 ,

codebook_size = 256 ,

num_quantizers = 8

)

x = torch . randn ( 1 , 1024 , 256 )

residual_lfq . eval ()

quantized , indices , commit_loss = residual_lfq ( x )

# (1, 1024, 256), (1, 1024, 8), (8)

quantized_out = residual_lfq . get_output_from_indices ( indices )

# (1, 1024, 256)

assert torch . all ( quantized == quantized_out )Раскрытие необходимо для обучения представительства, поскольку оно способствует интерпретации, обобщению, улучшению обучения и надежности. Он согласуется с целью захвата значимых и независимых функций данных, способствующих более эффективному использованию изученных представлений в различных приложениях. Для лучшей распутывания задача состоит в том, чтобы распутать основные вариации в наборе данных без явной информации о основе истины. Эта работа вводит ключевой индуктивный смещение, направленное на кодирование и декодирование в организованном скрытом пространстве. Стратегия, включенная, охватывает дискретизацию скрытого пространства, назначая дискретные кодовые векторы посредством использования отдельной обучаемой скалярной кодовой книги для каждого измерения. Эта методология позволяет их моделям эффективно превзойти надежные предыдущие методы.

Имейте в виду, что им пришлось использовать очень высокий затухание веса для результатов в этой статье.

import torch

from vector_quantize_pytorch import LatentQuantize

# you can specify either dim or codebook_size

# if both specified, will be validated against each other

quantizer = LatentQuantize (

levels = [ 5 , 5 , 8 ], # number of levels per codebook dimension

dim = 16 , # input dim

commitment_loss_weight = 0.1 ,

quantization_loss_weight = 0.1 ,

)

image_feats = torch . randn ( 1 , 16 , 32 , 32 )

quantized , indices , loss = quantizer ( image_feats )

# (1, 16, 32, 32), (1, 32, 32), ()

assert image_feats . shape == quantized . shape

assert ( quantized == quantizer . indices_to_codes ( indices )). all () Вы также можете передавать видео функции как (batch, feat, time, height, width) или последовательности как (batch, seq, feat)

import torch

from vector_quantize_pytorch import LatentQuantize

quantizer = LatentQuantize (

levels = [ 5 , 5 , 8 ],

dim = 16 ,

commitment_loss_weight = 0.1 ,

quantization_loss_weight = 0.1 ,

)

seq = torch . randn ( 1 , 32 , 16 )

quantized , * _ = quantizer ( seq )

# (1, 32, 16)

video_feats = torch . randn ( 1 , 16 , 10 , 32 , 32 )

quantized , * _ = quantizer ( video_feats )

# (1, 16, 10, 32, 32)Или поддержать несколько кодовых книг

import torch

from vector_quantize_pytorch import LatentQuantize

model = LatentQuantize (

levels = [ 4 , 8 , 16 ],

dim = 9 ,

num_codebooks = 3

)

input_tensor = torch . randn ( 2 , 3 , dim )

output_tensor , indices , loss = model ( input_tensor )

# (2, 3, 9), (2, 3, 3), ()

assert output_tensor . shape == input_tensor . shape

assert indices . shape == ( 2 , 3 , num_codebooks )

assert loss . item () >= 0 @misc { oord2018neural ,

title = { Neural Discrete Representation Learning } ,

author = { Aaron van den Oord and Oriol Vinyals and Koray Kavukcuoglu } ,

year = { 2018 } ,

eprint = { 1711.00937 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.LG }

} @misc { zeghidour2021soundstream ,

title = { SoundStream: An End-to-End Neural Audio Codec } ,

author = { Neil Zeghidour and Alejandro Luebs and Ahmed Omran and Jan Skoglund and Marco Tagliasacchi } ,

year = { 2021 } ,

eprint = { 2107.03312 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.SD }

} @inproceedings { anonymous2022vectorquantized ,

title = { Vector-quantized Image Modeling with Improved {VQGAN} } ,

author = { Anonymous } ,

booktitle = { Submitted to The Tenth International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=pfNyExj7z2 } ,

note = { under review }

} @inproceedings { lee2022autoregressive ,

title = { Autoregressive Image Generation using Residual Quantization } ,

author = { Lee, Doyup and Kim, Chiheon and Kim, Saehoon and Cho, Minsu and Han, Wook-Shin } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 11523--11532 } ,

year = { 2022 }

} @article { Defossez2022HighFN ,

title = { High Fidelity Neural Audio Compression } ,

author = { Alexandre D'efossez and Jade Copet and Gabriel Synnaeve and Yossi Adi } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2210.13438 }

} @inproceedings { Chiu2022SelfsupervisedLW ,

title = { Self-supervised Learning with Random-projection Quantizer for Speech Recognition } ,

author = { Chung-Cheng Chiu and James Qin and Yu Zhang and Jiahui Yu and Yonghui Wu } ,

booktitle = { International Conference on Machine Learning } ,

year = { 2022 }

} @inproceedings { Zhang2023GoogleUS ,

title = { Google USM: Scaling Automatic Speech Recognition Beyond 100 Languages } ,

author = { Yu Zhang and Wei Han and James Qin and Yongqiang Wang and Ankur Bapna and Zhehuai Chen and Nanxin Chen and Bo Li and Vera Axelrod and Gary Wang and Zhong Meng and Ke Hu and Andrew Rosenberg and Rohit Prabhavalkar and Daniel S. Park and Parisa Haghani and Jason Riesa and Ginger Perng and Hagen Soltau and Trevor Strohman and Bhuvana Ramabhadran and Tara N. Sainath and Pedro J. Moreno and Chung-Cheng Chiu and Johan Schalkwyk and Franccoise Beaufays and Yonghui Wu } ,

year = { 2023 }

} @inproceedings { Shen2023NaturalSpeech2L ,

title = { NaturalSpeech 2: Latent Diffusion Models are Natural and Zero-Shot Speech and Singing Synthesizers } ,

author = { Kai Shen and Zeqian Ju and Xu Tan and Yanqing Liu and Yichong Leng and Lei He and Tao Qin and Sheng Zhao and Jiang Bian } ,

year = { 2023 }

} @inproceedings { Yang2023HiFiCodecGV ,

title = { HiFi-Codec: Group-residual Vector quantization for High Fidelity Audio Codec } ,

author = { Dongchao Yang and Songxiang Liu and Rongjie Huang and Jinchuan Tian and Chao Weng and Yuexian Zou } ,

year = { 2023 }

} @inproceedings { huh2023improvedvqste ,

title = { Straightening Out the Straight-Through Estimator: Overcoming Optimization Challenges in Vector Quantized Networks } ,

author = { Huh, Minyoung and Cheung, Brian and Agrawal, Pulkit and Isola, Phillip } ,

booktitle = { International Conference on Machine Learning } ,

year = { 2023 } ,

organization = { PMLR }

} @inproceedings { rogozhnikov2022einops ,

title = { Einops: Clear and Reliable Tensor Manipulations with Einstein-like Notation } ,

author = { Alex Rogozhnikov } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oapKSVM2bcj }

} @misc { shin2021translationequivariant ,

title = { Translation-equivariant Image Quantizer for Bi-directional Image-Text Generation } ,

author = { Woncheol Shin and Gyubok Lee and Jiyoung Lee and Joonseok Lee and Edward Choi } ,

year = { 2021 } ,

eprint = { 2112.00384 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { mentzer2023finite ,

title = { Finite Scalar Quantization: VQ-VAE Made Simple } ,

author = { Fabian Mentzer and David Minnen and Eirikur Agustsson and Michael Tschannen } ,

year = { 2023 } ,

eprint = { 2309.15505 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { yu2023language ,

title = { Language Model Beats Diffusion -- Tokenizer is Key to Visual Generation } ,

author = { Lijun Yu and José Lezama and Nitesh B. Gundavarapu and Luca Versari and Kihyuk Sohn and David Minnen and Yong Cheng and Agrim Gupta and Xiuye Gu and Alexander G. Hauptmann and Boqing Gong and Ming-Hsuan Yang and Irfan Essa and David A. Ross and Lu Jiang } ,

year = { 2023 } ,

eprint = { 2310.05737 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { Zhao2024ImageAV ,

title = { Image and Video Tokenization with Binary Spherical Quantization } ,

author = { Yue Zhao and Yuanjun Xiong and Philipp Krahenbuhl } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:270380237 }

} @misc { hsu2023disentanglement ,

title = { Disentanglement via Latent Quantization } ,

author = { Kyle Hsu and Will Dorrell and James C. R. Whittington and Jiajun Wu and Chelsea Finn } ,

year = { 2023 } ,

eprint = { 2305.18378 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.LG }

} @inproceedings { Irie2023SelfOrganisingND ,

title = { Self-Organising Neural Discrete Representation Learning `a la Kohonen } ,

author = { Kazuki Irie and R'obert Csord'as and J{"u}rgen Schmidhuber } ,

year = { 2023 } ,

url = { https://api.semanticscholar.org/CorpusID:256901024 }

} @article { Huijben2024ResidualQW ,

title = { Residual Quantization with Implicit Neural Codebooks } ,

author = { Iris Huijben and Matthijs Douze and Matthew Muckley and Ruud van Sloun and Jakob Verbeek } ,

journal = { ArXiv } ,

year = { 2024 } ,

volume = { abs/2401.14732 } ,

url = { https://api.semanticscholar.org/CorpusID:267301189 }

} @article { Fifty2024Restructuring ,

title = { Restructuring Vector Quantization with the Rotation Trick } ,

author = { Christopher Fifty, Ronald G. Junkins, Dennis Duan, Aniketh Iyengar, Jerry W. Liu, Ehsan Amid, Sebastian Thrun, Christopher Ré } ,

journal = { ArXiv } ,

year = { 2024 } ,

volume = { abs/2410.06424 } ,

url = { https://api.semanticscholar.org/CorpusID:273229218 }

} @inproceedings { Zhu2024AddressingRC ,

title = { Addressing Representation Collapse in Vector Quantized Models with One Linear Layer } ,

author = { Yongxin Zhu and Bocheng Li and Yifei Xin and Linli Xu } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273812459 }

}