Site Twitter

Ai Rag Chatbot para Fictionx Stories.

É alimentado pelo índice de llama, juntos ai, juntos incorporados e next.js. Ele incorpora as histórias em story/data e armazena incorporações na story/cache como banco de dados vetorial localmente. Em seguida, ele interpreta o personagem da história e responde às perguntas dos usuários.

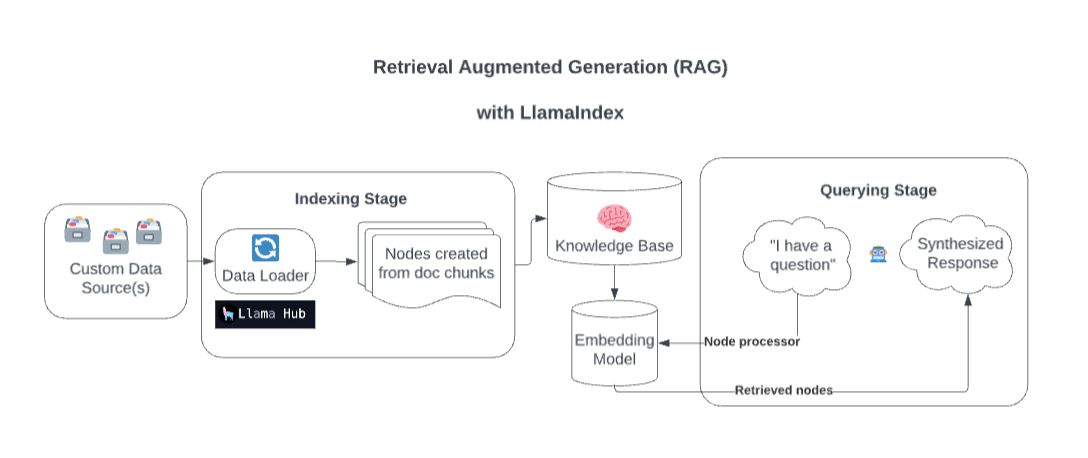

Nos bastidores, o Llamaindex enriquece seu modelo com fontes de dados personalizadas por meio de geração aumentada de recuperação (RAG).

Muito simplificado, esse processo geralmente consiste em dois estágios:

Um estágio de indexação. O Llamaindex prepara a base de conhecimento, ingerando dados e convertendo -os em documentos. Ele analisa metadados desses documentos (texto, relacionamentos etc.) em nós e cria índices consultáveis desses pedaços na base de conhecimento.

Um estágio de consulta. O contexto relevante é recuperado da base de conhecimento para ajudar o modelo na resposta a consultas. O estágio de consulta garante que o modelo possa acessar dados não incluídos em seus dados de treinamento originais.

Fonte: simplit

Copie seu arquivo .example.env em um .env e substitua o TOGETHER_API_KEY por seu próprio. Especifique um valor de OpenAi_Api_Key dummy neste .env para garantir que ele funcione (hack temporário)

npm install

http://localhost:3200/api/generate . npm run dev

http://localhost:3200/http://localhost:3200/api/chatEle suporta resposta de streaming ou resposta JSON.