Situs Web Twitter

AI Rag Chatbot untuk Fictionx Stories.

Ini didukung oleh Llama Index, Together AI, Together Embeddings dan Next.js. Ini menanamkan cerita dalam story/data dan menyimpan embeddings ke dalam story/cache sebagai database vektor secara lokal. Kemudian perannya bermain sebagai karakter cerita dan menjawab pertanyaan pengguna.

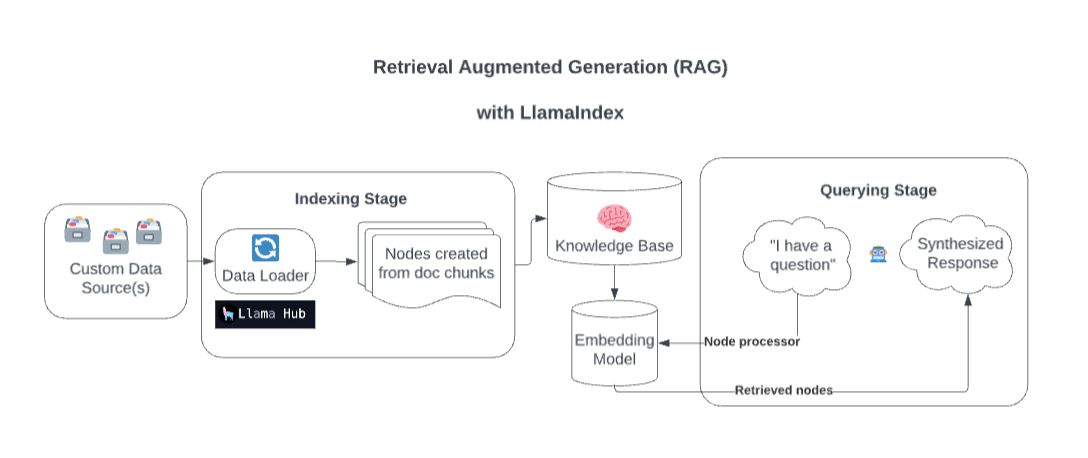

Di belakang layar, Llamaindex memperkaya model Anda dengan sumber data khusus melalui pengambilan augmented generasi (RAG).

Terlalu disederhanakan, proses ini umumnya terdiri dari dua tahap:

Tahap pengindeksan. Llamaindex mempersiapkan basis pengetahuan dengan menelan data dan mengubahnya menjadi dokumen. Ini mem -parses metadata dari dokumen -dokumen itu (teks, hubungan, dan sebagainya) menjadi node dan membuat indeks yang dapat dipertanyakan dari potongan -potongan ini ke dalam basis pengetahuan.

Tahap permintaan. Konteks yang relevan diambil dari basis pengetahuan untuk membantu model dalam menanggapi pertanyaan. Tahap kueri memastikan model dapat mengakses data yang tidak termasuk dalam data pelatihan aslinya.

Sumber: Streamlit

Salin file .example.env Anda ke .env dan ganti TOGETHER_API_KEY dengan milik Anda. Tentukan nilai OpenAI_API_KEY dummy di .env ini untuk memastikannya berfungsi (hack sementara)

npm install

http://localhost:3200/api/generate . npm run dev

http://localhost:3200/http://localhost:3200/api/chatIni mendukung respons streaming atau respons JSON.