Website Twitter

Ai Rag Chatbot für Fictionx -Geschichten.

Es wird vom Lama -Index, zusammen AI, zusammen Einbettungen und Next.js. angetrieben. Es einbettet die Geschichten in story/data ein und speichert Einbettung in story/cache als Vektordatenbank lokal. Dann spielt es die Rolle als Charakter der Geschichte und beantwortet die Fragen der Benutzer.

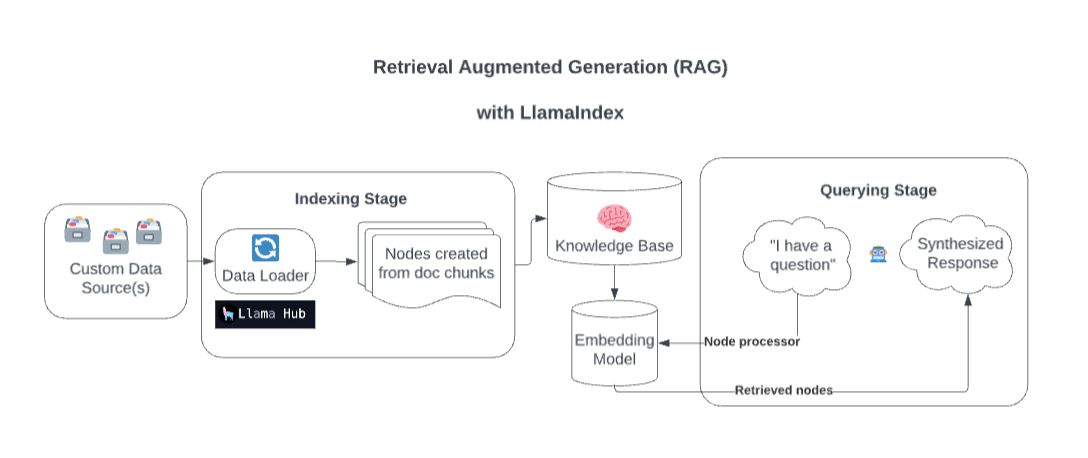

Hinter den Kulissen bereichert Llamaindex Ihr Modell mit benutzerdefinierten Datenquellen durch Abruf Augmented Generation (RAG).

Übermäßig vereinfacht, besteht dieser Prozess im Allgemeinen aus zwei Phasen:

Eine Indizierungsstufe. Llamaindex bereitet die Wissensbasis durch Einnahme von Daten und Umwandlung in Dokumente vor. Es analysiert Metadaten aus diesen Dokumenten (Text, Beziehungen usw.) in Knoten und schafft abfragbare Indizes aus diesen Stücken in die Wissensbasis.

Eine Abfragebühne. Der relevante Kontext wird aus der Wissensbasis abgerufen, um das Modell bei der Reaktion auf Abfragen zu unterstützen. Die Abfragephase stellt sicher, dass das Modell auf Daten zugreifen kann, die nicht in seinen ursprünglichen Trainingsdaten enthalten sind.

Quelle: Streamlit

Kopieren Sie Ihre .example.env -Datei in eine .env und ersetzen Sie den TOGETHER_API_KEY . Geben Sie einen Dummy OpenAI_API_Key -Wert in diesem.

npm install

http://localhost:3200/api/generate . npm run dev

http://localhost:3200/http://localhost:3200/api/chatEs unterstützt Streaming -Antwort oder JSON -Antwort.