Site Web Twitter

AI Rag Chatbot pour les histoires de fictionx.

Il est alimenté par l'indice de lama, ensemble AI, ensemble des intégres et suivant.js. Il incorpore les histoires dans story/data et les magasins intégrés dans story/cache comme base de données vectorielle localement. Ensuite, il joue le rôle comme le personnage de l'histoire et répond aux questions des utilisateurs.

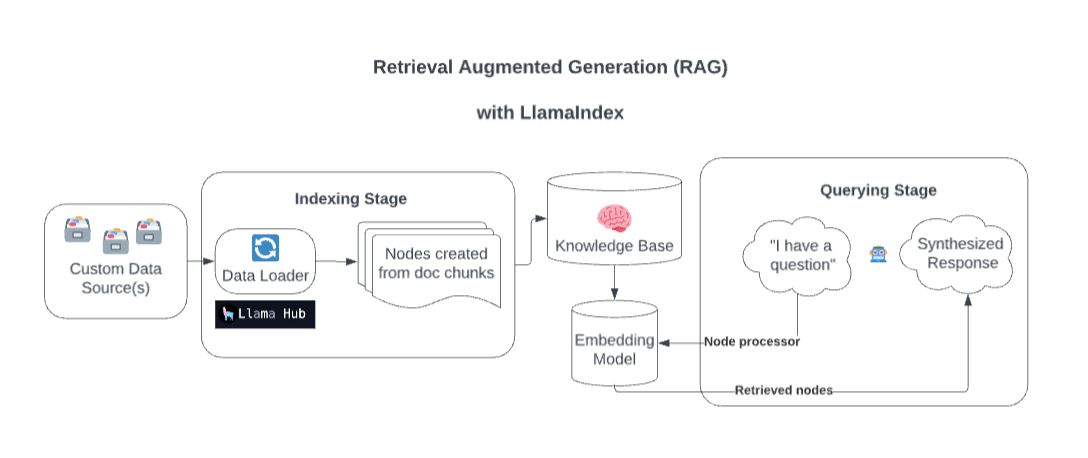

Dans les coulisses, Llamaindex enrichit votre modèle avec des sources de données personnalisées grâce à une génération augmentée (RAG) de récupération.

Trop simplifié, ce processus se compose généralement de deux étapes:

Une étape d'indexation. Llamaindex prépare la base de connaissances en ingérant des données et en les convertissant en documents. Il analyse les métadonnées de ces documents (texte, relations, etc.) en nœuds et crée des indices interrogables de ces morceaux dans la base de connaissances.

Une étape de requête. Le contexte pertinent est extrait de la base de connaissances pour aider le modèle à répondre aux requêtes. L'étape de requête garantit que le modèle peut accéder aux données non incluses dans ses données de formation d'origine.

Source: rationalisation

Copiez votre fichier .example.env dans un .env et remplacez le TOGETHER_API_KEY par le vôtre. Spécifiez une valeur factice openai_api_key dans ce .env pour vous assurer qu'il fonctionne (hack temporaire)

npm install

http://localhost:3200/api/generate . npm run dev

http://localhost:3200/http://localhost:3200/api/chatIl prend en charge la réponse en streaming ou la réponse JSON.