story chat v1

1.0.0

웹 사이트 트위터

Fictionx Stories를위한 AI Rag Chatbot.

Llama Index, 함께 AI, 함께 Embedings and Next.js에 의해 구동됩니다. story/data 에 스토리를 포함시키고 임베드를 story/cache 에 로컬로 벡터 데이터베이스로 저장합니다. 그런 다음 역할은 스토리의 캐릭터로 재생되고 사용자의 질문에 답변합니다.

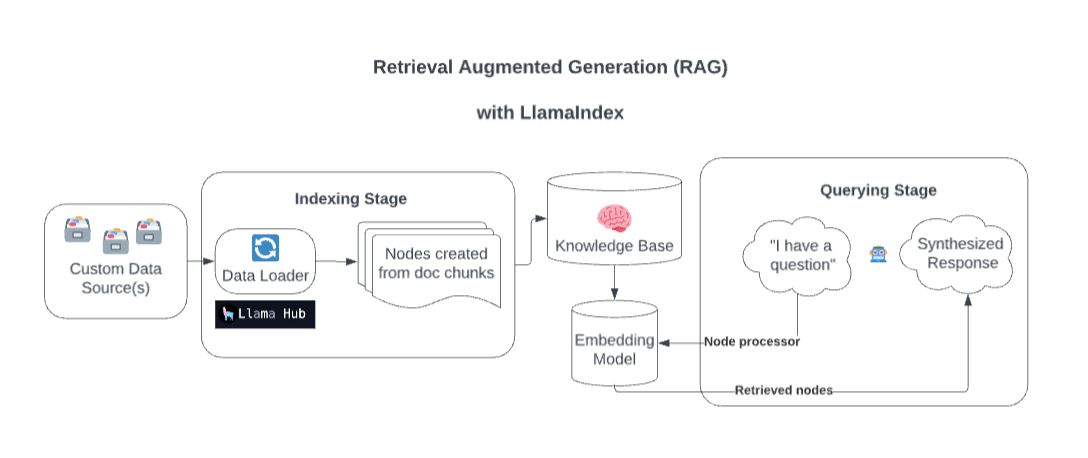

무대 뒤에서 Lamaindex는 검색 증강 생성 (RAG)을 통해 사용자 정의 데이터 소스로 모델을 풍부하게합니다.

지나치게 단순화하면이 과정은 일반적으로 두 단계로 구성됩니다.

인덱싱 단계. Llamaindex는 데이터를 수집하여 문서로 변환하여 지식 기반을 준비합니다. 해당 문서 (텍스트, 관계 등)에서 메타 데이터를 노드로 구문 분석하고 이러한 청크에서 지식 기반으로 쿼리 가능한 지수를 만듭니다.

쿼리 단계. 관련 컨텍스트는 지식 기반에서 검색되어 모델이 쿼리에 응답하도록 돕습니다. 쿼리 단계는 모델이 원래 교육 데이터에 포함되지 않은 데이터에 액세스 할 수 있도록합니다.

출처 : 간소

.example.env 파일을 .env 로 복사하고 함께 TOGETHER_API_KEY 를 자신의 것으로 바꾸십시오. 이 .env에서 더미 Openai_api_key 값을 지정하여 작동하는지 확인하십시오 (임시 해킹)

npm install

http://localhost:3200/api/generate 에 제출하십시오. npm run dev

http://localhost:3200/http://localhost:3200/api/chat스트리밍 응답 또는 JSON 응답을 지원합니다.