***** 새로운 2018 년 11 월 20 일 : 온라인 웹 데모 이용 가능 *****

우리는 온라인 데모 (미리 훈련 된 무게와 함께)를 발표하여 모델로 자신을 재생할 수 있습니다. 웹 인터페이스의 코드는 demo 폴더에서도 사용할 수 있습니다.

미리 훈련 된 모델을 다운로드하려면 Git LFS를 설치하고 git lfs pull 수행하십시오. 모델의 가중치는 Model_Dumps 폴더에 저장됩니다.

시맨틱 작업의 임베딩 학습을위한 계층 적 멀티 태스크 접근법

Victor Sanh, Thomas Wolf, Sebastian Ruder

AAAI 2019에서 승인

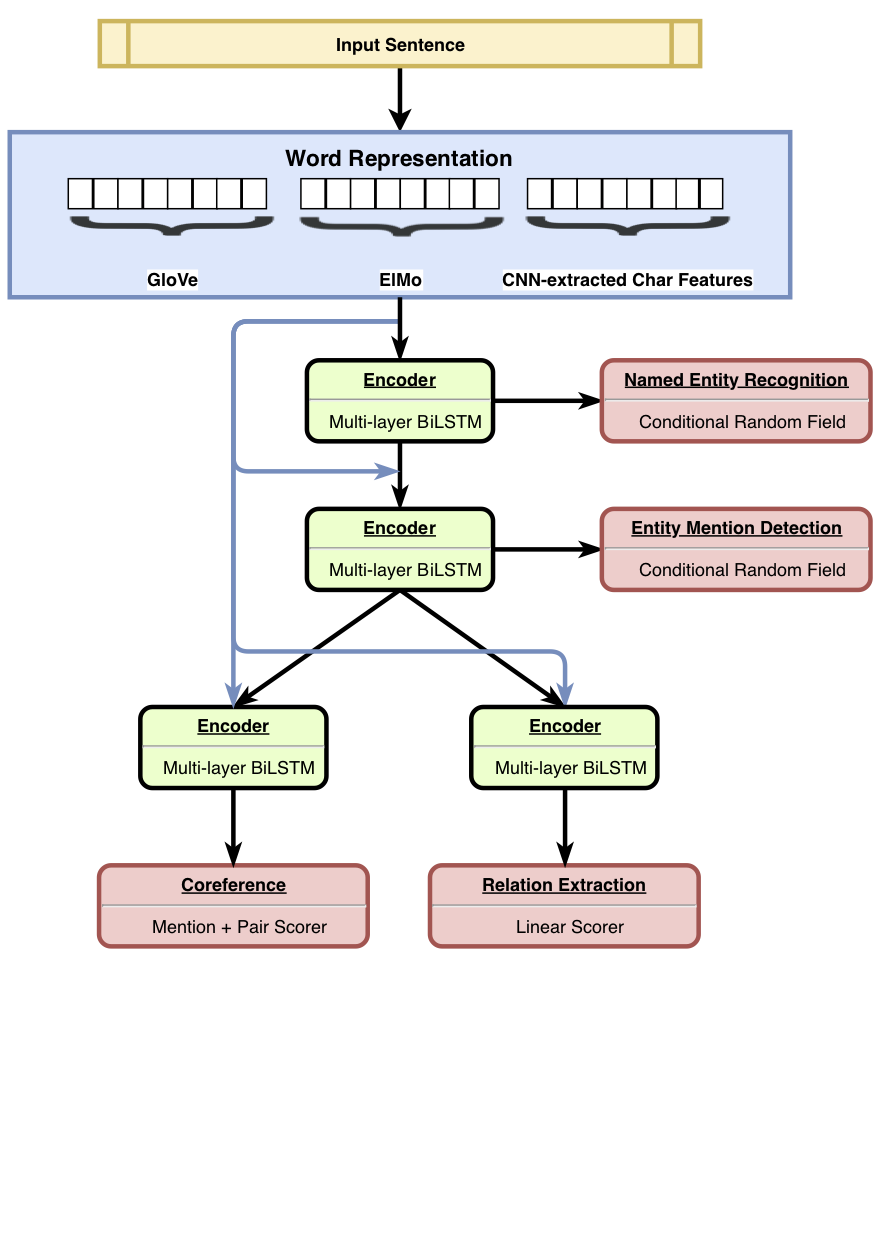

HMTL은 신중하게 선택된 4 개의 의미 론적 작업 (즉, 명명 된 엔티티 인식, 엔터티 언급 탐지, 관계 추출 및 코퍼레이션 해상도)을 결합한 계층 적 멀티 태스킹 학습 모델입니다. 이 모델은 명명 된 엔티티 인식, 엔티티 언급 탐지 및 관계 추출에 대한 최첨단 결과를 달성합니다. Senteval을 사용하여 모델의 하단에서 상단 레이어로 이동하면 모델이 더 복잡한 의미 표현을 배우는 경향이 있음을 보여줍니다.

결과에 대한 자세한 내용은 논문을 참조하십시오.

우리는 교육 , 미세 조정 및 HMTL 평가 코드를 발표했습니다. 이 코드가 자체 멀티 태스킹 모델을 구축하는 데 유용하기를 바랍니다. 이 코드는 파이썬 으로 작성되었으며 Pytorch 가 구동합니다.

주요 종속성은 다음과 같습니다.

코드는 Python 3.6 에서 작동합니다. 의존성의 안정적인 버전은 requirements.txt 에 나열되어 있습니다.

스크립트 ./script/machine_setup.sh 호출하여 작업 환경을 신속하게 설정할 수 있습니다. Python 3.6을 설치하고 깨끗한 가상 환경을 생성하며 필요한 모든 종속성 ( requirements.txt 에 나열)을 설치합니다. 필요에 따라 스크립트를 조정하십시오.

우리는 Allennlp 라이브러리를 기반으로합니다. 이 라이브러리에 대한 소개를 위해서는이 자습서를 확인해야합니다.

실험은 JSON 구성 파일에 정의됩니다 (예는 configs/*.json 참조). 구성 파일은 주로로드 할 데이터 세트, 모델의 모든 하이퍼 파라미터와 함께 생성 할 모델을 설명합니다.

구성 파일 (필요한 경우 DatasetReaders 와 같은 정의 된 사용자 정의 클래스)을 설정 한 후에는 다음 명령 및 인수로 교육을 시작할 수 있습니다.

python train.py --config_file_path configs/hmtl_coref_conll.json --serialization_dir my_first_training훈련이 시작되면 단순히 터미널의 교육을 따르거나 텐서 보드를 열 수 있습니다 (이전에 Tensorboard 및 해당 Tensorflow fexecy를 설치했는지 확인하십시오).

tensorboard --logdir my_first_training/log 우리는 Senteval을 사용하여 모델에서 배운 언어 적 특성을 평가했습니다. hmtl_senteval.py senteval과 hmtl 사이의 인터페이스를 만드는 방법에 대한 예를 제공합니다. 그것은 Hiearchy의 모든 계층 (공유 기반 단어 임베딩 및 인코더)에서 배운 언어 적 특성을 평가합니다.

HMTL에서 사용한 미리 훈련 된 임베딩을 다운로드하려면 스크립트 ./script/data_setup.sh 를 간단히 시작할 수 있습니다.

라이센스 이유로 HMTL을 훈련시키는 데 사용되는 데이터 세트를 첨부하지 않았지만 Ontonotes 5.0, Conll2003 및 ACE2005를 직접 수집하도록 초대합니다. 구성 파일은 데이터 세트가 data/ 폴더에 배치 될 것으로 기대합니다.

이 저장소가 유용하다면 다음 논문을 인용하는 것을 고려하십시오.

@article{sanh2018hmtl,

title={A Hierarchical Multi-task Approach for Learning Embeddings from Semantic Tasks},

author={Sanh, Victor and Wolf, Thomas and Ruder, Sebastian},

journal={arXiv preprint arXiv:1811.06031},

year={2018}

}