LLM Survey

1.0.0

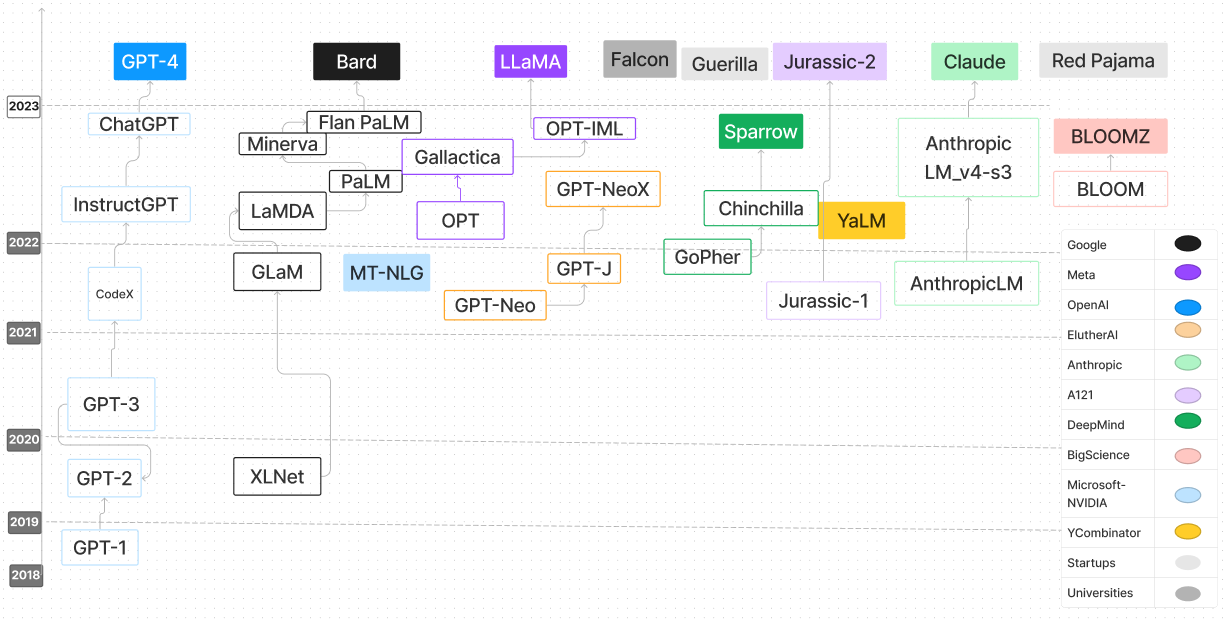

대형 언어 모델 설문 조사 저장소는 LLM (Lange Language Model)의 탐색 및 이해에 전념하는 포괄적 인 개요입니다. 연구 논문, 블로그 게시물, 튜토리얼, 코드 예제 등을 포함한 다양한 리소스가있어 LLM의 진행, 방법론 및 응용 프로그램에 대한 심층적 인 모습을 제공합니다. 이 repo는 LLM의 발전 및 내부 작업에 관심이있는 AI 연구원, 데이터 과학자 또는 애호가에게 귀중한 자료입니다. 우리는 공동 학습을 촉진하고 LLM 연구의 경계를 계속 추진하기 위해 더 넓은 지역 사회의 기여를 권장합니다.

| 언어 모델 | 출시일 | 검문소 | 종이/블로그 | 매개 변수 (b) | 컨텍스트 길이 | 특허 | 시도해보십시오 |

|---|---|---|---|---|---|---|---|

| T5 | 2019/10 | T5 & FLAN-T5, FLAN-T5-XXL (HF) | 통합 된 텍스트-텍스트 변압기로 전송 학습의 한계 탐색 | 0.06-11 | 512 | 아파치 2.0 | T5-LARGE |

| UL2 | 2022/10 | ul2 & flan-ul2, flan-ul2 (HF) | UL2 20B : 오픈 소스 통합 언어 학습자 | 20 | 512, 2048 | 아파치 2.0 | |

| 코셔 | 2022/06 | 검문소 | 암호 | 54 | 4096 | 모델 | 웹 사이트 |

| 뇌 GPT | 2023/03 | 뇌 GPT | Cerebras-Gpt : 개방적이고 컴퓨터 효율적이며 대형 언어 모델 (종이)의 가족 | 0.111-13 | 2048 | 아파치 2.0 | 뇌 GPT-1.3B |

| 오픈 조교 (피시 티아 가족) | 2023/03 | OA-PYSHIA-12B-SFT-8, OA-PYSHIA-12B-SFT-4, OA-PYSHIA-12B-SFT-1 | 큰 언어 모델 정렬을 민주화합니다 | 12 | 2048 | 아파치 2.0 | Pythia-2.8b |

| 피티아 | 2023/04 | 피티아 70m -12b | Pythia : 교육 및 스케일링 전반에 걸쳐 큰 언어 모델 분석을위한 스위트 | 0.07-12 | 2048 | 아파치 2.0 | |

| 인형 | 2023/04 | 돌리 -V2-12B | 무료 돌리 : 세계 최초의 진정한 오픈 명령 조정 LLM 소개 | 3, 7, 12 | 2048 | MIT | |

| dlite | 2023/05 | DLITE-V2-1_5B | DLITE V2 발표 : 어디에서나 실행할 수있는 가볍고 오픈 LLM | 0.124-1.5 | 1024 | 아파치 2.0 | DLITE-V2-1.5B |

| RWKV | 2021/08 | rwkv, chatrwkv | RWKV 언어 모델 (및 내 LM 트릭) | 0.1-14 | 무한대 (RNN) | 아파치 2.0 | |

| GPT-J-6B | 2023/06 | GPT-J-6B, GPT4ALL-J | GPT-J-6B : 6B JAX 기반 변압기 | 6 | 2048 | 아파치 2.0 | |

| GPT-NEOX-20B | 2022/04 | GPT-NEOX-20B | GPT-NEOX-20B : 오픈 소스 자동 회귀 언어 모델 | 20 | 2048 | 아파치 2.0 | |

| 꽃 | 2022/11 | 꽃 | 블룸 : 176B 패러 아메리카 오픈 액세스 다국어 언어 모델 | 176 | 2048 | OpenRail-M V1 | |

| Stablelm-Alpha | 2023/04 | Stablelm-Alpha | 안정성 AI는 처음으로 Stablelm 언어 모델 스위트를 시작합니다. | 3-65 | 4096 | CC BY-SA-4.0 | |

| FastChat-T5 | 2023/04 | FASTCHAT-T5-3B-V1.0 | 우리는 FastChat-T5를 출시하게되어 기쁩니다. | 3 | 512 | 아파치 2.0 | |

| h2ogpt | 2023/05 | h2ogpt | 세계 최고의 오픈 소스 대형 언어 모델 구축 : H2O.AI의 여정 | 12-20 | 256-2048 | 아파치 2.0 | |

| MPT-7B | 2023/05 | MPT-7B, MPT-7B- 강조 | MPT-7B 소개 : 오픈 소스, 상업적으로 유용한 LLM을위한 새로운 표준 | 7 | 84K (Alibi) | 아파치 2.0, CC BY-SA-3.0 | |

| Pangu-σ | 2023/3 | 판 제 | 모델 | 1085 | - | 모델 | 페이지 |

| 레드 파자마-진동 | 2023/05 | 레드 파자마-진동 | 기본, 지침 조정 및 채팅 모델을 포함한 3B 및 7B Redpajama-Incite 모델 제품 | 3-7 | 2048 | 아파치 2.0 | 레드 파자마-진동 구조 -3b-v1 |

| Openllama | 2023/05 | Open_llama_3B, Open_Llama_7B, Open_Llama_13B | Openllama : 라마의 열린 재생산 | 3, 7 | 2048 | 아파치 2.0 | Openllama-7b -preview_200BT |

| 매 | 2023/05 | Falcon-180B, Falcon-40B, Falcon-7b | Falcon LLM의 정제 Web 데이터 세트 : 웹 데이터와 웹 데이터만으로 선별 된 Corpora보다 우수합니다. | 180, 40, 7 | 2048 | 아파치 2.0 | |

| MPT-30B | 2023/06 | MPT-30B, MPT-30B- 강조 | MPT-30B : 오픈 소스 파운데이션 모델의 기준을 높이십시오 | 30 | 8192 | 아파치 2.0, CC BY-SA-3.0 | CPU를 사용한 MPT 30B 추론 코드 |

| 라마 2 | 2023/06 | llama 2 웨이트 | LLAMA 2 : 오픈 파운데이션 및 미세 조정 된 채팅 모델 | 7-70 | 4096 | 사용자가 700m 미만인 경우 LLAMA 및 파생 상품 외에 다른 LLM을 훈련시키기 위해 LLAMA 출력을 사용할 수없는 경우 사용자 정의 무료 | Huggingchat |

| Openlm | 2023/09 | OpenLM 1B, OpenLM 7B | OPEN LM : 최소하지만 성능이 뛰어난 언어 모델링 (LM) 저장소 | 1, 7 | 2048 | MIT | |

| 미스트랄 7b | 2023/09 | Mistral-7B-V0.1, Mistral-7B-Instruct-V0.1 | 미스트랄 7b | 7 | 슬라이딩 윈도우가있는 4096-16K | 아파치 2.0 | 미스 트랄 변압기 |

| 개방형 | 2023/09 | OpenHermes-7B, OpenHermes-13B | nous 연구 | 7, 13 | 4096 | MIT | OpenHermes-v2 Mistral 7b에서 미세 조정되었습니다 |

| 태양 | 2023/12 | 태양열 -10.7b | 도도한 | 10.7 | 4096 | 아파치 -2.0 | |

| PHI-2 | 2023/12 | PHI-2 2.7B | 마이크로 소프트 | 2.7 | 2048 | MIT | |

| 산타 코더 | 2023/01 | 산타 코더 | Santacoder : 별에 도달하지 마십시오! | 1.1 | 2048 | OpenRail-M V1 | 산타 코더 |

| 스타 코더 | 2023/05 | 스타 코더 | StarCoder : 코드를위한 최첨단 LLM, StarCoder : 출처가 당신과 함께 있기를 바랍니다! | 1.1-15 | 8192 | OpenRail-M V1 | |

| 전분 알파 | 2023/05 | Starchat-Alpha | Starcoder로 코딩 어시스턴트 만들기 | 16 | 8192 | OpenRail-M V1 | |

| 코드를 반복하십시오 | 2023/05 | REPLIT-CODE-V1-3B | 1 주일에 Sota Code LLM을 훈련하고 VIBS 정량화 - Reza Shabani of Replit | 2.7 | 무한대? (구실) | CC BY-SA-4.0 | REPLIT-CODE-V1-3B |

| Codegen2 | 2023/04 | Codegen2 1B-16B | Codgen2 : 프로그래밍 및 자연어에 대한 LLM을 훈련하기위한 교훈 | 1-16 | 2048 | 아파치 2.0 | |

| Codet5+ | 2023/05 | Codet5+ | Codet5+: 코드 이해 및 생성을위한 오픈 코드 대형 언어 모델 | 0.22-16 | 512 | BSD-3-Clause | CODET5+-6B |

| XGEN-7B | 2023/06 | XGEN-7B-8K-베이스 | XGEN을 사용한 긴 시퀀스 모델링 : 8K 입력 시퀀스 길이로 훈련 된 7B LLM | 7 | 8192 | 아파치 2.0 | |

| Codegen2.5 | 2023/07 | Codegen2.5-7B-Multi | Codegen2.5 : 작지만 강력합니다 | 7 | 2048 | 아파치 2.0 | |

| Decicoder-1b | 2023/08 | Decicoder-1b | DECICODER 소개 : 효율적이고 정확한 코드 생성의 새로운 금 표준 | 1.1 | 2048 | 아파치 2.0 | 데시 코더 데모 |

| 코드 라마 | 2023 | Codellama 모델에 대한 추론 코드 | Code Llama : 코드의 열린 기초 모델 | 7-34 | 4096 | 모델 | Huggingchat |

| 참새 | 2022/09 | 추론 코드 | 암호 | 70 | 4096 | 모델 | 웹 페이지 |

| 미스트랄 | 2023/09 | 추론 코드 | 암호 | 7 | 8000 | 모델 | 웹 페이지 |

| 코알라 | 2023/04 | 추론 코드 | 암호 | 13 | 4096 | 모델 | 웹 페이지 |

| 팜 2 | 2024 | N/A | Google AI | 540 | N/A | N/A | N/A |

| Tongyi Qianwen | 2024 | N/A | 알리바바 클라우드 | N/A | N/A | N/A | N/A |

| 코셔 명령 | 2024 | N/A | 코셔 | 6-52 | N/A | N/A | N/A |

| 비쿠나 33b | 2024 | N/A | 메타 ai | 33 | N/A | N/A | N/A |

| 구아나코 -65b | 2024 | N/A | 메타 ai | 65 | N/A | N/A | N/A |

| 아마존 Q | 2024 | N/A | AWS | N/A | N/A | N/A | N/A |

| 팔콘 180b | 2024 | 팔콘 -180b | 기술 혁신 연구소 | 180 | N/A | 아파치 2.0 | N/A |

| YI 34B | 2024 | N/A | 01 AI | 34 | 최대 32k | N/A | N/A |

| 믹스 트랄 8x7b | 2023 | 믹스 트랄 8x 7b | 미스트랄 ai | 46.7 (토큰 당 12.9) | N/A | 아파치 2.0 | N/A |

조사에 유용한 설문 조사를 찾으면 다음 논문을 인용하십시오.

@article{hadi2024large,

title={Large language models: a comprehensive survey of its applications, challenges, limitations, and future prospects},

author={Hadi, Muhammad Usman and Al Tashi, Qasem and Shah, Abbas and Qureshi, Rizwan and Muneer, Amgad and Irfan, Muhammad and Zafar, Anas and Shaikh, Muhammad Bilal and Akhtar, Naveed and Wu, Jia and others},

journal={Authorea Preprints},

year={2024},

publisher={Authorea}

}