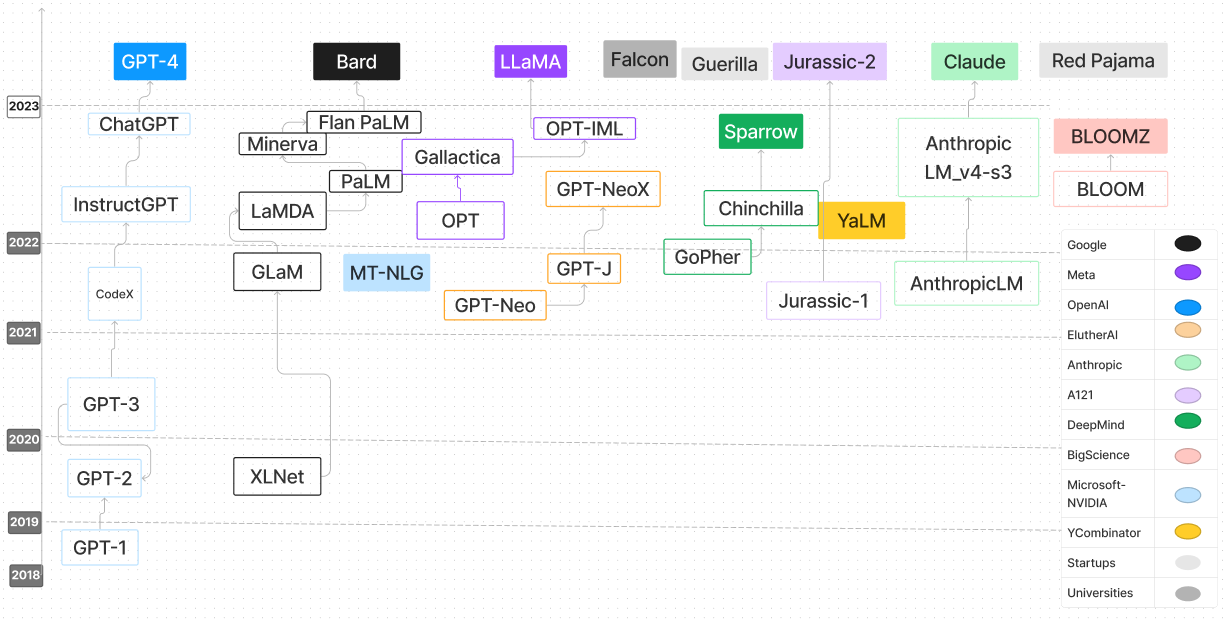

El repositorio de la encuesta de modelos de idiomas grandes es un compendio integral dedicado a la exploración y comprensión de los modelos de idiomas grandes (LLM). Aloja una variedad de recursos que incluyen trabajos de investigación, publicaciones de blog, tutoriales, ejemplos de código y más para proporcionar una visión profunda de la progresión, las metodologías y las aplicaciones de LLM. Este repositorio es un recurso invaluable para investigadores de IA, científicos de datos o entusiastas interesados en los avances y el funcionamiento interno de LLM. Alentamos las contribuciones de la comunidad más amplia para promover el aprendizaje colaborativo y continuar empujando los límites de la investigación de LLM.

| Modelo | Fecha de lanzamiento | Puntos de control | Papel/blog | Parámetros (b) | Longitud de contexto | Licencia | Probar |

|---|---|---|---|---|---|---|---|

| T5 | 2019/10 | T5 y Flan-T5, Flan-T5-XXL (HF) | Explorando los límites del aprendizaje de transferencia con un transformador de texto a texto unificado | 0.06 - 11 | 512 | Apache 2.0 | T5-grande |

| UL2 | 2022/10 | UL2 y Flan-UL2, Flan-UL2 (HF) | UL2 20B: un aprendizaje de idiomas unificado de código abierto | 20 | 512, 2048 | Apache 2.0 | |

| Adherirse | 2022/06 | Control | Código | 54 | 4096 | Modelo | Sitio web |

| Cerebras-GPT | 2023/03 | Cerebras-GPT | Cerebras-GPT: una familia de modelos de idiomas abiertos, eficientes y eficientes (papel) | 0.111 - 13 | 2048 | Apache 2.0 | Cerebras-GPT-1.3b |

| Asistente abierto (familia Pythia) | 2023/03 | OA-PYTHIA-12B-SFT-8, OA-PYTHIA-12B-SFT-4, OA-PYTHIA-12B-SFT-1 | Democratización de la alineación del modelo de idioma grande | 12 | 2048 | Apache 2.0 | Pythia-2.8b |

| pitia | 2023/04 | Pythia 70m - 12b | Pythia: una suite para analizar grandes modelos de idiomas en la capacitación y la escala | 0.07 - 12 | 2048 | Apache 2.0 | |

| Muñequita | 2023/04 | Dolly-V2-12B | Free Dolly: Presentación de la primera LLM de instrucciones verdaderamente abierta del mundo | 3, 7, 12 | 2048 | MIT | |

| Dlite | 2023/05 | dlite-v2-1_5b | Anunciando DLITE V2: LLMS liviano, abierto que puede funcionar en cualquier lugar | 0.124 - 1.5 | 1024 | Apache 2.0 | Dlite-v2-1.5b |

| RWKV | 2021/08 | Rwkv, chatrwkv | El modelo de idioma RWKV (y mis trucos de LM) | 0.1 - 14 | Infinito (RNN) | Apache 2.0 | |

| GPT-J-6B | 2023/06 | GPT-J-6B, GPT4All-J | GPT-J-6B: transformador con sede en Jax 6B | 6 | 2048 | Apache 2.0 | |

| GPT-NOOX-20B | 2022/04 | GPT-NOOX-20B | GPT-NOOX-20B: un modelo de lenguaje autorregresivo de código abierto | 20 | 2048 | Apache 2.0 | |

| Floración | 2022/11 | Floración | Bloom: un modelo de lenguaje multilingüe de acceso abierto de 176b-parámetro | 176 | 2048 | OpenRail-M V1 | |

| Establelm-alfa | 2023/04 | Establelm-alfa | Stability AI lanza el primero de su conjunto de modelos de idiomas Stablelm | 3 - 65 | 4096 | CC BY-SA-4.0 | |

| Fastchat-t5 | 2023/04 | fastchat-t5-3b-v1.0 | Estamos entusiasmados de lanzar Fastchat-T5: ¡nuestro chatbot compacto y comercial! | 3 | 512 | Apache 2.0 | |

| h2ogpt | 2023/05 | h2ogpt | Construyendo el mejor modelo de lenguaje de código abierto del mundo: el viaje de H2O.Ai | 12 - 20 | 256 - 2048 | Apache 2.0 | |

| MPT-7B | 2023/05 | MPT-7B, MPT-7B-INSTRUST | Introducción de MPT-7B: un nuevo estándar para LLMS de código abierto, utilizable comercialmente | 7 | 84k (Alibi) | Apache 2.0, CC BY-SA-3.0 | |

| Panguete | 2023/3 | Atar | Modelo | 1085 | - | Modelo | Página |

| Redpajama-incite | 2023/05 | Redpajama-incite | Liberando a la familia de modelos de 3B y 7B Redpajama-Ingite, incluidos modelos Base, Instruccionados y Chat | 3 - 7 | 2048 | Apache 2.0 | Redpajama-incite-Instructo-3B-V1 |

| Abierto | 2023/05 | Open_llama_3b, Open_llama_7b, Open_llama_13b | Openllama: una reproducción abierta de Llama | 3, 7 | 2048 | Apache 2.0 | Openllama-7b-Preview_200BT |

| Halcón | 2023/05 | Falcon-180b, Falcon-40b, Falcon-7b | El conjunto de datos de redes refinadas para Falcon LLM: superación a los corpus curados con datos web y solo datos web | 180, 40, 7 | 2048 | Apache 2.0 | |

| MPT-30B | 2023/06 | MPT-30B, MPT-30B-Instructo | MPT-30B: Levantando el listón para los modelos de base de código abierto | 30 | 8192 | Apache 2.0, CC BY-SA-3.0 | Código de inferencia MPT 30B usando CPU |

| Llama 2 | 2023/06 | Llama 2 pesos | Llama 2: Fundación abierta y modelos de chat fino | 7 - 70 | 4096 | Personalizado gratis si tiene menos de 700 millones de usuarios y no puede usar salidas de LLAMA para entrenar a otros LLM además de LLAMA y sus derivados | Huggingchat |

| Abierto | 2023/09 | OpenLM 1B, OpenLM 7B | Abrir LM: un repositorio de modelado de lenguaje mínimo pero performativo (LM) | 1, 7 | 2048 | MIT | |

| Mistral 7b | 2023/09 | Mistral-7B-V0.1, Mistral-7B-Instructo-V0.1 | Mistral 7b | 7 | 4096-16k con ventanas correderas | Apache 2.0 | Transformador mistral |

| Hermes abiertos | 2023/09 | OpenHermes-7b, OpenHermes-13B | Nous investigación | 7, 13 | 4096 | MIT | OpenHermes-V2 Finetuned en Mistral 7b |

| SOLAR | 2023/12 | Solar-10.7b | Altanero | 10.7 | 4096 | apache-2.0 | |

| phi-2 | 2023/12 | PHI-2 2.7B | Microsoft | 2.7 | 2048 | MIT | |

| Santacoder | 2023/01 | santacoder | Santacoder: ¡No alcances las estrellas! | 1.1 | 2048 | OpenRail-M V1 | Santacoder |

| Codificador de estrellas | 2023/05 | codificador de estrellas | Starcoder: un LLM de última generación para código, StarCoder: ¡Que la fuente esté con usted! | 1.1-15 | 8192 | OpenRail-M V1 | |

| Alfa de almidón | 2023/05 | alfa de almidón | Creación de un asistente de codificación con StarCoder | 16 | 8192 | OpenRail-M V1 | |

| Código de replicación | 2023/05 | Replicar Código de pedido-V1-3B | Entrenamiento de un código SOTA LLM en 1 semana y cuantificando las vibraciones, con Reza Shabani de Replic | 2.7 | ¿infinidad? (Coartada) | CC BY-SA-4.0 | Replicar Código de pedido-V1-3B |

| Coden2 | 2023/04 | Codegen2 1B-16B | Codegen2: Lecciones para la capacitación LLMS en programación y lenguas naturales | 1 - 16 | 2048 | Apache 2.0 | |

| Codet5+ | 2023/05 | Codet5+ | Codet5+: Abra el código de modelos de lenguaje grande para la comprensión y generación del código | 0.22 - 16 | 512 | Cláusula BSD-3 | Codet5+-6b |

| Xgen-7b | 2023/06 | Xgen-7b-8k-base | Modelado de secuencia larga con XGEN: A 7B LLM entrenado en una longitud de secuencia de entrada de 8K | 7 | 8192 | Apache 2.0 | |

| Coden2.5 | 2023/07 | Codegen2.5-7b-multi | Codegen2.5: pequeño pero poderoso | 7 | 2048 | Apache 2.0 | |

| Decicoder-1b | 2023/08 | Decicoder-1b | Introducción de Decicoder: el nuevo estándar de oro en generación de código eficiente y precisa | 1.1 | 2048 | Apache 2.0 | Demostración de decicodidad |

| Código Llama | 2023 | Código de inferencia para modelos Codellama | Code Llama: Modelos de base abiertos para el código | 7 - 34 | 4096 | Modelo | Huggingchat |

| Gorrión | 2022/09 | Código de inferencia | Código | 70 | 4096 | Modelo | Página web |

| Mistral | 2023/09 | Código de inferencia | Código | 7 | 8000 | Modelo | Página web |

| Coala | 2023/04 | Código de inferencia | Código | 13 | 4096 | Modelo | Página web |

| Palma 2 | 2024 | N / A | Google AI | 540 | N / A | N / A | N / A |

| Tongyi Qianwen | 2024 | N / A | Nube de alibaba | N / A | N / A | N / A | N / A |

| Comando cohere | 2024 | N / A | Adherirse | 6 - 52 | N / A | N / A | N / A |

| Vicuna 33b | 2024 | N / A | Meta ai | 33 | N / A | N / A | N / A |

| Guanaco-65b | 2024 | N / A | Meta ai | 65 | N / A | N / A | N / A |

| Amazon Q | 2024 | N / A | AWS | N / A | N / A | N / A | N / A |

| Falcon 180b | 2024 | Falcon-180b | Instituto de innovación tecnológica | 180 | N / A | Apache 2.0 | N / A |

| Yi 34b | 2024 | N / A | 01 AI | 34 | Hasta 32k | N / A | N / A |

| Mixtral 8x7b | 2023 | Mixtral 8x 7b | AI Mistral | 46.7 (12.9 por token) | N / A | Apache 2.0 | N / A |

Si encuentra útil nuestra encuesta para su investigación, cite el siguiente documento:

@article{hadi2024large,

title={Large language models: a comprehensive survey of its applications, challenges, limitations, and future prospects},

author={Hadi, Muhammad Usman and Al Tashi, Qasem and Shah, Abbas and Qureshi, Rizwan and Muneer, Amgad and Irfan, Muhammad and Zafar, Anas and Shaikh, Muhammad Bilal and Akhtar, Naveed and Wu, Jia and others},

journal={Authorea Preprints},

year={2024},

publisher={Authorea}

}